Compute

Azure Databricks-Compute bezieht sich auf die Auswahl an Computingressourcen, die im Azure Databricks-Arbeitsbereich verfügbar sind. Benutzende benötigen Zugriff auf Compute, um Data Engineering-, Data Science- und Datenanalyse-Workloads auszuführen, z. B. ETL-Pipelines, Streaming-Analysen, Ad-hoc-Analysen und maschinelles Lernen.

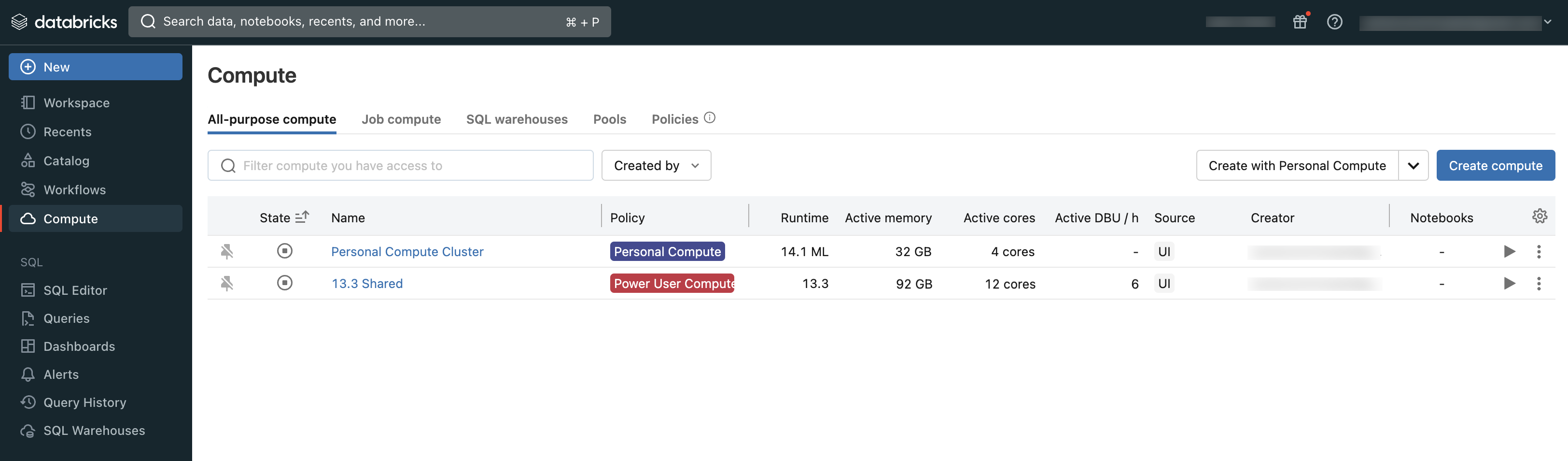

Benutzende können entweder eine Verbindung mit vorhandenem Compute herstellen oder ein neues Compute erstellen, wenn sie über die entsprechenden Berechtigungen verfügen.

Sie können das Compute anzeigen, auf das Sie Zugriff haben, indem Sie den Abschnitt Compute des Arbeitsbereichs verwenden:

Computetypen

Dies sind die In Azure Databricks verfügbaren Computetypen:

Serverlose Berechnung für Notebook: On-demand, skalierbarer Compute, der zum Ausführen von SQL- und Python-Code in Notebooks verwendet wird.

Serverloses Computing für Aufträge: Skalierbares On-Demand-Computing zum Ausführen Ihrer Databricks-Aufträge, ohne Infrastruktur zu konfigurieren und bereitzustellen

All-Purpose Compute: Bereitgestellter Compute, der zum Analysieren von Daten in Notebooks verwendet wird. Sie können diese Computeressource mithilfe der Benutzeroberfläche, der CLI oder der REST-API erstellen, beenden und neu starten.

Jobs Compute: Bereitgestellter Compute, der zum Ausführen automatisierter Aufträge verwendet wird. Der Azure Databricks-Auftragsplaner erstellt automatisch eine Auftragsberechnung, wenn ein Auftrag für die Ausführung auf einer neuen Berechnung konfiguriert ist. Die Computeressource wird beendet, wenn der Auftrag abgeschlossen ist. Sie können eine Auftragsberechnung nicht neu starten. Weitere Informationen finden Sie unter Konfigurieren von Compute für Aufträge.

Instanzpools: Computeressource mit einsatzbereiten Instanzen im Leerlauf, die verwendet werden, um die Start- und Autoskalierungsdauer zu reduzieren. Sie können diese Computeressource mithilfe der Benutzeroberfläche, der CLI oder der REST-API erstellen.

Serverlose SQL-Warehouses: Elastische Rechenleistung auf Abruf zur Ausführung von SQL-Befehlen für Datenobjekte im SQL-Editor oder in interaktiven Notebooks. Sie können SQL-Warehouses mithilfe der Benutzeroberfläche, der CLI oder der REST-API erstellen.

Klassische SQL-Warehouses: Zum Ausführen von SQL-Befehlen für Datenobjekte im SQL-Editor oder in interaktiven Notebooks verwendet Sie können SQL-Warehouses mithilfe der Benutzeroberfläche, der CLI oder der REST-API erstellen.

In den Artikeln in diesem Abschnitt wird beschrieben, wie Sie mit Computeressourcen auf der Azure Databricks-Benutzeroberfläche arbeiten. Weitere Methoden finden Sie unter Welche ist die Databricks-Befehlszeilenschnittstelle? sowie unter Databricks REST-API-Referenz.

Databricks Runtime

Bei Databricks Runtime handelt es sich um die Gruppe von Kernkomponenten, die in Ihren Computeressourcen ausgeführt werden. Die Databricks-Runtime ist eine konfigurierbare Einstellung in allen Funktionen, die in SQL-Warehouses berechnet, aber automatisch ausgewählt werden.

Jede Databricks Runtime-Version enthält Updates zur Verbesserung der Benutzerfreundlichkeit, Leistung und Sicherheit von Big Data-Analysen. Databricks Runtime in Ihrer Computeressource fügt viele Features hinzu, u. a.:

- Delta Lake, eine Speicherebene der nächsten Generation, die auf Apache Spark aufbaut und ACID-Transaktionen, optimierte Layouts und Indizes sowie Verbesserungen der Ausführungsengine zum Erstellen von Datenpipelines bietet. Siehe Was ist Delta Lake?.

- Installierte Java-, Scala-, Python- und R-Bibliotheken

- Ubuntu und die zugehörigen Systembibliotheken

- GPU-Bibliotheken für GPU-fähige Cluster

- Azure Databricks-Dienste, die sich in andere Komponenten der Plattform integrieren lassen, z. B. Notebooks, Aufträge und Clusterverwaltung

Informationen zum Inhalt der einzelnen Runtimeversionen finden Sie in den Versionshinweisen.

Laufzeitversionsverwaltung

Databricks Runtime-Versionen werden regelmäßig veröffentlicht:

- Long Term Support-Versionen werden durch einen LTS-Qualifizierer dargestellt (z. B. 3.5 LTS). Für jede Hauptversion deklarieren wir eine „kanonische“ Featureversion, für die wir drei volle Jahre Support bieten. Weitere Informationen finden Sie unter Databricks-Supportlebenszyklus.

- Hauptversionen werden durch eine Erhöhung der Versionsnummer vor dem Dezimalpunkt dargestellt (z. B. der Sprung von 3.5 auf 4.0). Sie werden veröffentlicht, wenn es größere Änderungen gibt, von denen einige möglicherweise nicht abwärtskompatibel sind.

- Featureversionen werden durch eine Erhöhung der Versionsnummer nach dem Dezimalpunkt dargestellt (z. B. der Sprung von 3.4 auf 3.5). Jede Hauptversion enthält mehrere Featurereleases. Featurereleases sind immer abwärtskompatibel mit früheren Releases innerhalb ihrer Hauptversion.