Notebook-Computeressourcen

In diesem Artikel werden die Optionen für Notebook-Computeressourcen behandelt. Sie können ein Notebook in einem Databricks-Cluster oder mit serverlosem Computing ausführen. Für SQL-Befehle können Sie ein SQL-Warehouse verwenden, eine Art von für SQL-Analysen optimiertem Compute.

Serverloses Computing für Notebooks

Serverloses Computing ermöglicht es Ihnen, Ihr Notebook schnell mit On-Demand-Computing-Ressourcen zu verbinden.

Zum Anfügen an die serverlose Berechnung klicken Sie im Notizbuch auf das Dropdownmenü "Verbinden", und wählen Sie "Serverless" aus.

Weitere Informationen finden Sie unter Serverloses Computing für Notebooks.

Anfügen eines Notebooks an einen Cluster

Zum Anfügen eines Notebooks an einen Cluster benötigen Sie die KANN ANFÜGEN-Berechtigung auf Clusterebene.

Wichtig

Solange ein Notebook an ein Cluster angefügt ist, ist jeder Benutzer mit der KANN AUSFÜHREN-Berechtigung auf dem Notebook implizit dazu berechtigt, auf das Cluster zuzugreifen.

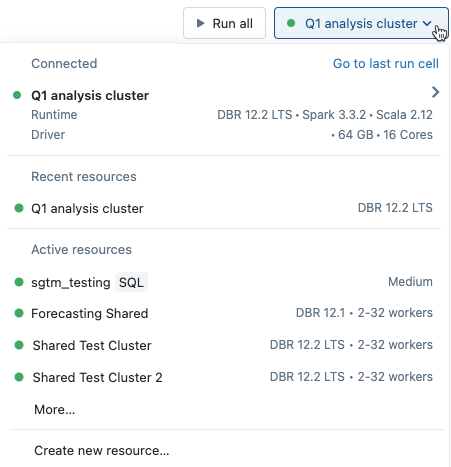

Um ein Notebook an einen Cluster anzufügen, klicken Sie auf die Computeauswahl in der Notebook-Symbolleiste, und wählen Sie im Dropdownmenü einen Cluster aus.

Das Menü zeigt eine Auswahl von Clustern an, die Sie kürzlich verwendet haben oder derzeit ausgeführt werden.

Klicken Sie auf Mehr..., um aus allen verfügbaren Clustern auszuwählen. Klicken Sie auf den Clusternamen, um ein Dropdownmenü anzuzeigen, und wählen Sie einen vorhandenen Cluster aus.

Sie können auch einen neuen Cluster erstellen, indem Sie im Dropdownmenü Neue Ressource erstellen... auswählen.

Wichtig

Für ein angefügtes Notebook sind die folgenden Apache Spark-Variablen definiert.

| Klasse | Variablenname |

|---|---|

SparkContext |

sc |

SQLContext/HiveContext |

sqlContext |

SparkSession (Spark 2.x) |

spark |

SparkSession, SparkContext und SQLContext sollten nicht erstellt werden. Dies würde zu inkonsistentem Verhalten führen.

Verwenden eines Notebooks mit einem SQL-Warehouse

Wenn ein Notebook an ein SQL-Warehouse angefügt ist, können Sie SQL- und Markdown-Zellen ausführen. Das Ausführen einer Zelle in einer anderen Sprache (z. B. Python oder R) löst einen Fehler aus. SQL-Zellen, die in einem SQL-Warehouse ausgeführt werden, werden im Abfrageverlauf des SQL-Warehouses angezeigt. Die Benutzer*innen, die eine Abfrage ausgeführt haben, können das Abfrageprofil vom Notebook aus anzeigen, indem sie auf die verstrichene Zeit am unteren Rand der Ausgabe klicken.

Die Ausführung eines Notebooks erfordert ein Pro- oder serverloses SQL-Warehouse. Sie benötigen Zugriff auf den Arbeitsbereich und das SQL-Warehouse.

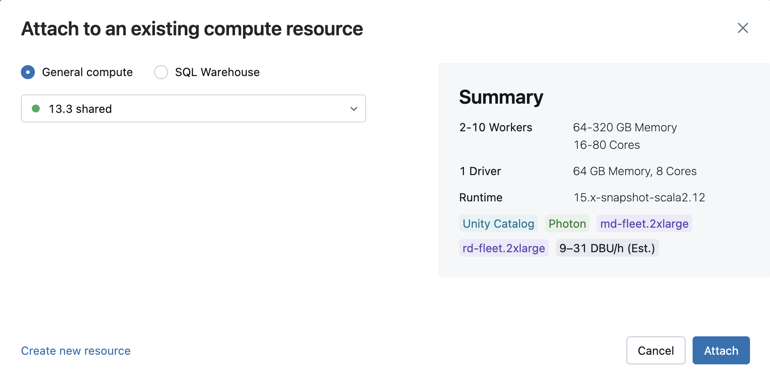

Gehen Sie wie folgt vor, um ein Notebook an ein SQL-Warehouse anzufügen:

Klicken Sie in der Notebooksymbolleiste auf die Computeauswahl. Im Dropdownmenü werden Computeressourcen angezeigt, die derzeit ausgeführt werden oder die Sie kürzlich verwendet haben. SQL-Warehouses sind mit der

gekennzeichnet.

gekennzeichnet.Wählen Sie im Menü ein SQL-Warehouse aus.

Um alle verfügbaren SQL-Warehouses anzuzeigen, wählen Sie im Dropdownmenü Mehr... aus. Ein Dialogfeld mit den für das Notebook verfügbaren Computeressourcen wird angezeigt. Wählen Sie SQL Warehouse aus, wählen Sie das gewünschte Warehouse aus, und klicken Sie auf Anfügen.

Sie können auch ein SQL Warehouse als Computeressource für ein SQL-Notebook auswählen, wenn Sie einen Workflow oder einen geplanten Auftrag erstellen.

Einschränkungen von SQL-Warehouses

Weitere Informationen finden Sie unter Bekannte Einschränkungen von Databricks-Notebooks.

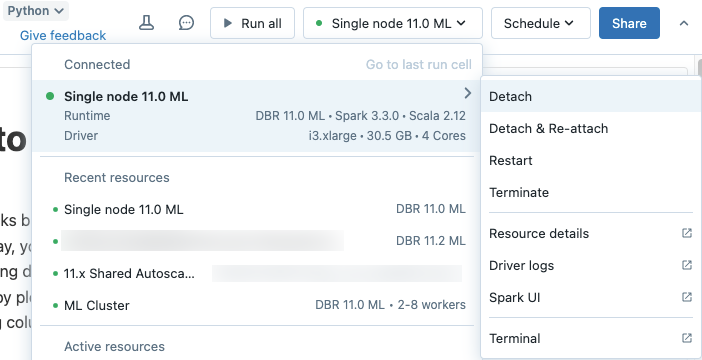

Trennen eines Notebooks

Um ein Notebook von einer Computeressource zu trennen, klicken Sie in der Notebook-Symbolleiste auf die Computeauswahl, und zeigen Sie in der Liste auf den angefügten Cluster oder das SQL-Warehouse, um ein seitliches Menü anzuzeigen. Wählen Sie im seitlichen Menü Trennen aus.

Sie können Notebooks auch über die Registerkarte Notebooks auf der Seite mit den Clusterdetails von einem Cluster trennen.

Tipp

Azure Databricks empfiehlt, nicht verwendete Notebooks von Clustern zu trennen. Dadurch wird Arbeitsspeicher auf dem Treiber freigegeben.