Vorbereiten des Verwendens von Apache Spark

Apache Spark ist ein Framework für verteilte Datenverarbeitung, das groß angelegte Datenanalysen ermöglicht, indem es die Verarbeitung auf mehreren Knoten eines Clusters koordiniert. Vereinfacht ausgedrückt, wird bei Spark das Teile-und-herrsche-Verfahren verwendet, um große Datenmengen schnell zu verarbeiten, indem die Arbeit auf mehrere Computer verteilt wird. Der Prozess zum Verteilen von Aufgaben und zum Sortieren von Ergebnissen wird für Sie von Spark durchgeführt. Sie übermitteln einen Datenverarbeitungsauftrag in Form von Code, der ein Treiberprogramm initiiert, das ein Clusterverwaltungsobjekt namens SparkContext verwendet, um die Prozessverteilung im Spark-Cluster zu verwalten. In den meisten Fällen sind diese Details abstrahiert. Sie müssen lediglich den Code schreiben, der zum Ausführen der benötigten Datenvorgänge erforderlich ist.

Spark kann Code ausführen, der in einer Vielzahl von Sprachen geschrieben wurde. Dazu gehören Java, Scala (eine Java-basierte Skriptsprache), Spark R, Spark SQL und PySpark (eine Spark-spezifische Variante von Python). Die meisten Datentechnik- und Analyseworkloads werden mit einer Kombination aus PySpark und Spark SQL durchgeführt.

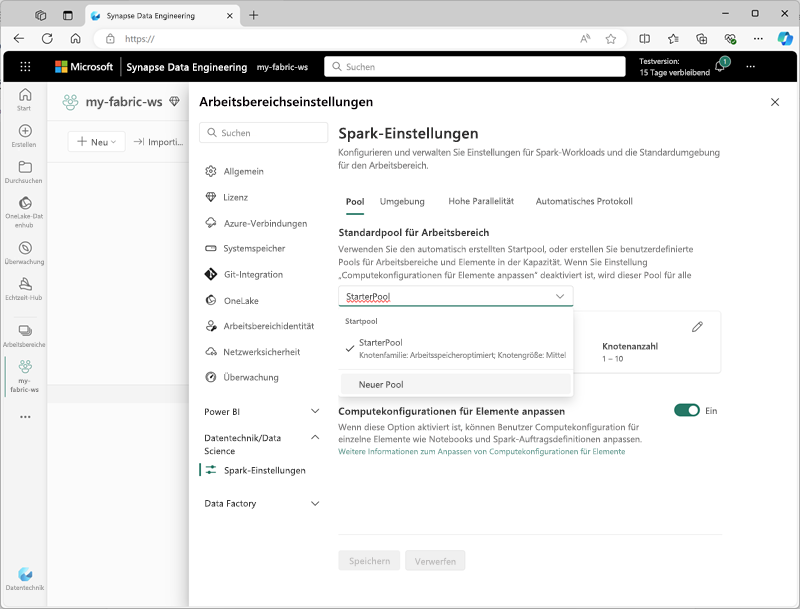

Spark-Einstellungen

In Microsoft Fabric wird jedem Arbeitsbereich ein Spark-Cluster zugewiesen. Administrator*innen können Einstellungen für den Spark-Cluster im Abschnitt Datentechnik/Data Science der Arbeitsbereichseinstellungen verwalten.

Zu den spezifischen Einstellungen gehören unter anderem folgende:

- Knotenfamilie: Der Typ der virtuellen Computer, die für die Spark-Clusterknoten verwendet werden. In den meisten Fällen bieten arbeitsspeicheroptimierte Knoten eine optimale Leistung.

- Laufzeitversion: Die Version von Spark und abhängigen Unterkomponenten, die im Cluster ausgeführt werden sollen

- Spark-Eigenschaften: Spark-spezifische Einstellungen, die Sie in Ihrem Cluster aktivieren oder außer Kraft setzen möchten. Eine Liste der Eigenschaften finden Sie in der Apache Spark-Dokumentation.

Hinweis

In den meisten Szenarios bieten die Standardeinstellungen eine optimale Konfiguration für Spark in Microsoft Fabric.

Bibliotheken

Das Open-Source-Ökosystem von Spark umfasst eine große Auswahl an Codebibliotheken für allgemeine und manchmal sehr spezialisierte Aufgaben. Da ein großer Teil der Spark-Verarbeitung mit PySpark ausgeführt wird, wird mit der großen Auswahl an Python-Bibliotheken sicher, dass für jede auszuführende Aufgabe wahrscheinlich eine Bibliothek zur Verfügung steht.

Standardmäßig enthalten Spark-Cluster in Microsoft Fabric viele der am häufigsten verwendeten Bibliotheken. Um zusätzliche Standardbibliotheken festzulegen oder Bibliotheksspezifikationen für Codeelemente beizubehalten, benötigen Sie Administratorberechtigungen für den Arbeitsbereich, um eine Umgebung zu erstellen und die Standardumgebung für den Arbeitsbereich festzulegen.

Tipp

Weitere Informationen zur Bibliotheksverwaltung finden Sie unter Verwalten von Apache Spark-Bibliotheken in Microsoft Fabric in der Microsoft Fabric-Dokumentation.