Enrutamiento de flujos de datos basados en contenido en flujos de eventos de Fabric (versión preliminar)

En este artículo se muestra cómo enrutar eventos en función del contenido de los flujos de eventos de Microsoft Fabric.

Ahora puede usar el editor sin código en el lienzo principal de flujos de eventos de Fabric para crear lógica de procesamiento de flujos compleja sin escribir ningún código. Esta característica le permite personalizar, transformar y administrar los flujos de datos con mayor facilidad. Después de establecer las operaciones de procesamiento de flujos, puede enviar sin problemas los flujos de datos a diferentes destinos según el esquema y los datos de flujo específicos.

Importante

Las funcionalidades mejoradas de flujos de eventos de Fabric se encuentran actualmente en versión preliminar.

Operaciones admitidas

Esta es la lista de operaciones admitidas para el procesamiento de datos en tiempo real:

Agregar: admite funciones SUM, AVG, MIN y MAX que realizan cálculos en una columna de valores y devuelven un único resultado.

Expandir: expanda la matriz y cree una nueva fila por cada valor dentro de una matriz.

Filtrar: seleccione o filtre filas específicas del flujo de datos en función de una condición.

Agrupar por: agregue todos los datos de eventos dentro de un período de tiempo determinado, con la opción de agrupar una o varias columnas.

Administrar campos: agregue, quite o cambie el tipo de datos de un campo o columna de los flujos de datos.

Unir: conectar dos o más flujos de datos con campos compartidos del mismo nombre y tipo de datos en un flujo de datos. Los campos que no coinciden se quitan.

Combinación: combine datos de dos flujos en función de una condición coincidente entre ellas.

Destinos admitidos

Los destinos admitidos son:

Lago de datos: este destino le proporciona la capacidad de transformar los eventos en tiempo real antes de la ingesta en el lago de datos. Los eventos en tiempo real se convierten en formato Delta Lake y, a continuación, se almacenan en las tablas del almacén de lago designadas. Este destino ayuda con escenarios de almacenamiento de datos.

Base de datos KQL: Este destino le permite ingerir los datos de eventos en tiempo real en una base de datos KQL, donde puede usar el eficaz lenguaje de consulta Kusto (KQL) para consultar y analizar los datos. Con los datos de la base de datos de KQL, puede obtener información más detallada sobre los datos del evento y crear informes y paneles completos.

Reflex: Este destino le permite conectar directamente sus datos de eventos en tiempo real a un Reflex. Reflex es un tipo de agente inteligente que contiene toda la información necesaria para conectarse a los datos, vigilar condiciones y actuar. Cuando los datos alcanzan determinados umbrales o coinciden con otros patrones, Reflex adopta automáticamente las medidas oportunas, como alertar a los usuarios o poner en marcha los flujos de trabajo de Power Automate.

Punto de conexión personalizado (anteriormente aplicación personalizada): con este destino, puede enrutar fácilmente los eventos en tiempo real a una aplicación personalizada. Este destino le permite conectar sus propias aplicaciones a eventstream y consumir los datos del evento en tiempo real. Resulta útil cuando quiere enviar datos en tiempo real a un sistema externo fuera de Microsoft Fabric.

Secuencia: este destino representa la secuencia de eventos sin procesar predeterminada transformada por una serie de operaciones, también denominada secuencia derivada. Una vez creada, puede ver la secuencia desde el centro en tiempo real.

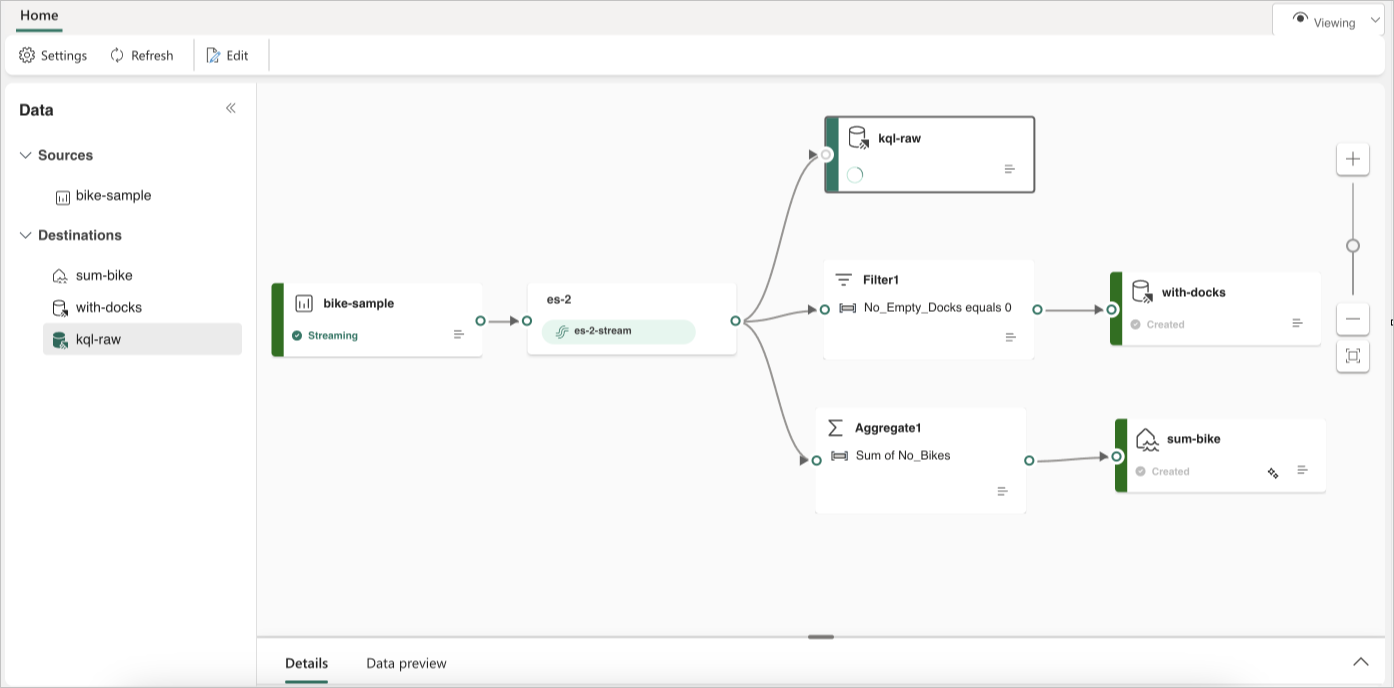

En el ejemplo siguiente se muestra cómo tres destinos de eventstream de Fabric distintos pueden servir funciones independientes para un único origen de flujo de datos. Una base de datos KQL se designa para almacenar datos sin procesar, una segunda base de datos KQL es para conservar flujos de datos filtrados y el lago de datos se usa para almacenar valores agregados.

Para transformar y enrutar el flujo de datos en función del contenido, siga los pasos descritos en Editar y publicar una secuencia de eventos y empiece a diseñar lógicas de procesamiento de flujos para el flujo de datos.