Ejercicio: Integración y uso del reconocimiento y la transcripción de voz

En este módulo, crearemos una aplicación de Mixed Reality que explora el uso de los servicios de voz de Azure con HoloLens 2. Cuando complete esta serie, podrá usar el micrófono del dispositivo para transcribir la conversión de voz en texto en tiempo real, traducir su discurso a otros idiomas y usar la característica reconocimiento de intenciones para comprender los comandos de voz mediante inteligencia artificial.

Creación y preparación del proyecto de Unity

En esta sección, creará un nuevo proyecto de Unity y lo preparará para el desarrollo de MRTK.

Como requisito previo, asegúrese de haber completado los pasos siguientes para inicializar el proyecto y la aplicación:

- Crear el proyecto de Unity y asignarle un nombre adecuado; por ejemplo, MRTK Tutorials

- Cambio de la plataforma de compilación

- Importación de los recursos esenciales de TextMeshPro

- Importación de Mixed Reality Toolkit

- Configuración del proyecto de Unity

- Crear y configurar la escena, y asignarle un nombre adecuado; por ejemplo, AzureSpeechServices

Nota:

Puede aprender a configurar el proyecto de realidad mixta en el módulo Introducción al kit de herramientas de Mixed Reality.

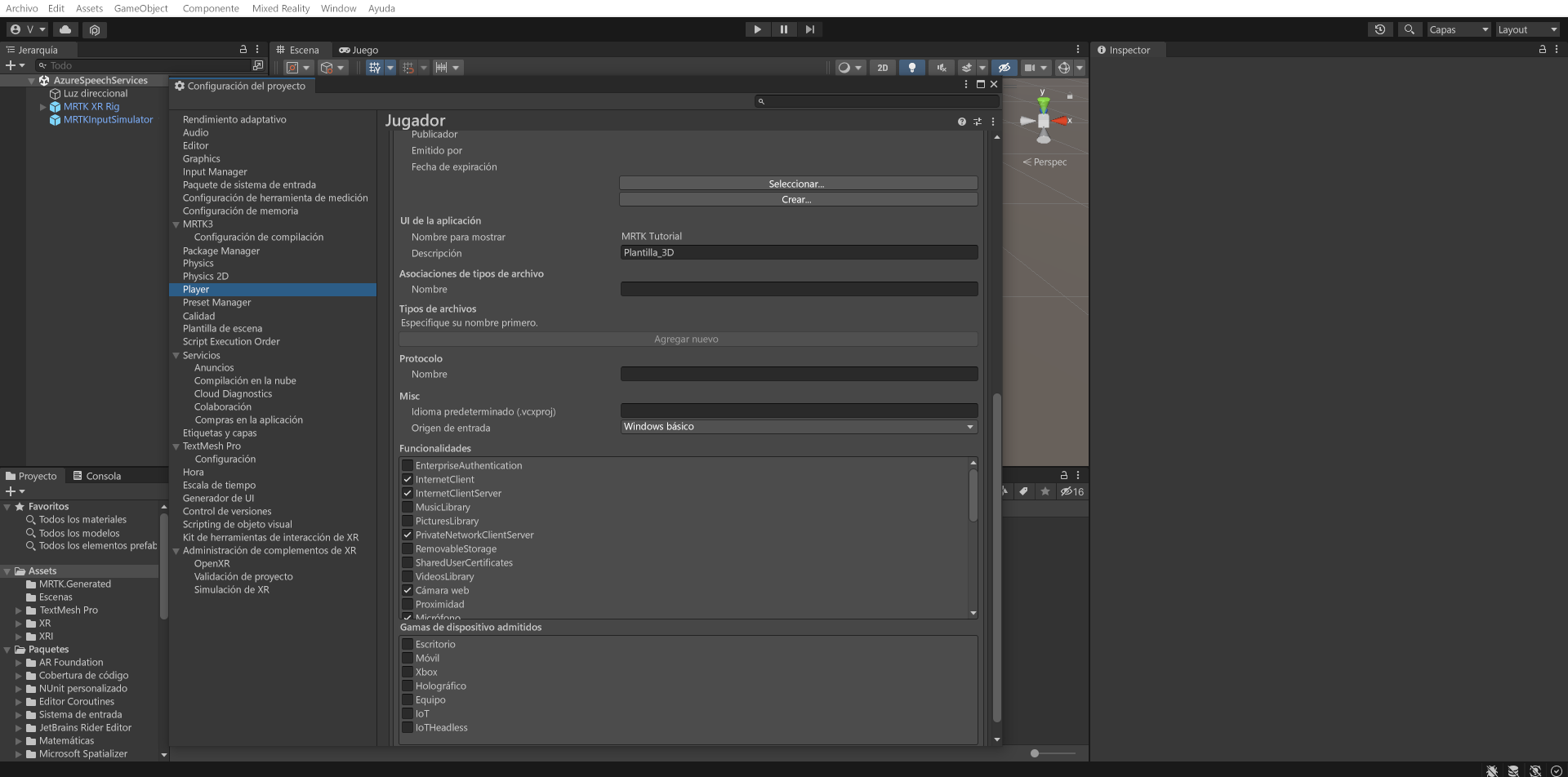

Configuración de las funcionalidades

En el menú de Unity, selecciona Edit>Project Settings... (Editar > Configuración del proyecto...) para abrir la ventana Player Settings (Configuración del jugador). A continuación, busca la sección Player>Publishing Settings (Jugador > Configuración de publicación):

En la sección Configuración de publicación, desplácese hacia abajo hasta la sección Funcionalidades y compruebe que las funcionalidades InternetClient, Microphone y SpatialPerception (que ha habilitado al crear el proyecto al principio del tutorial) siguen habilitadas. Luego, habilite las funcionalidades InternetClientServer y PrivateNetworkClientServer.

Importación de los recursos del tutorial

Descargue e importe los siguientes paquetes personalizados de Unity en el orden en que aparecen:

Una vez que importe los recursos del tutorial, la ventana del proyecto debe tener el aspecto siguiente:

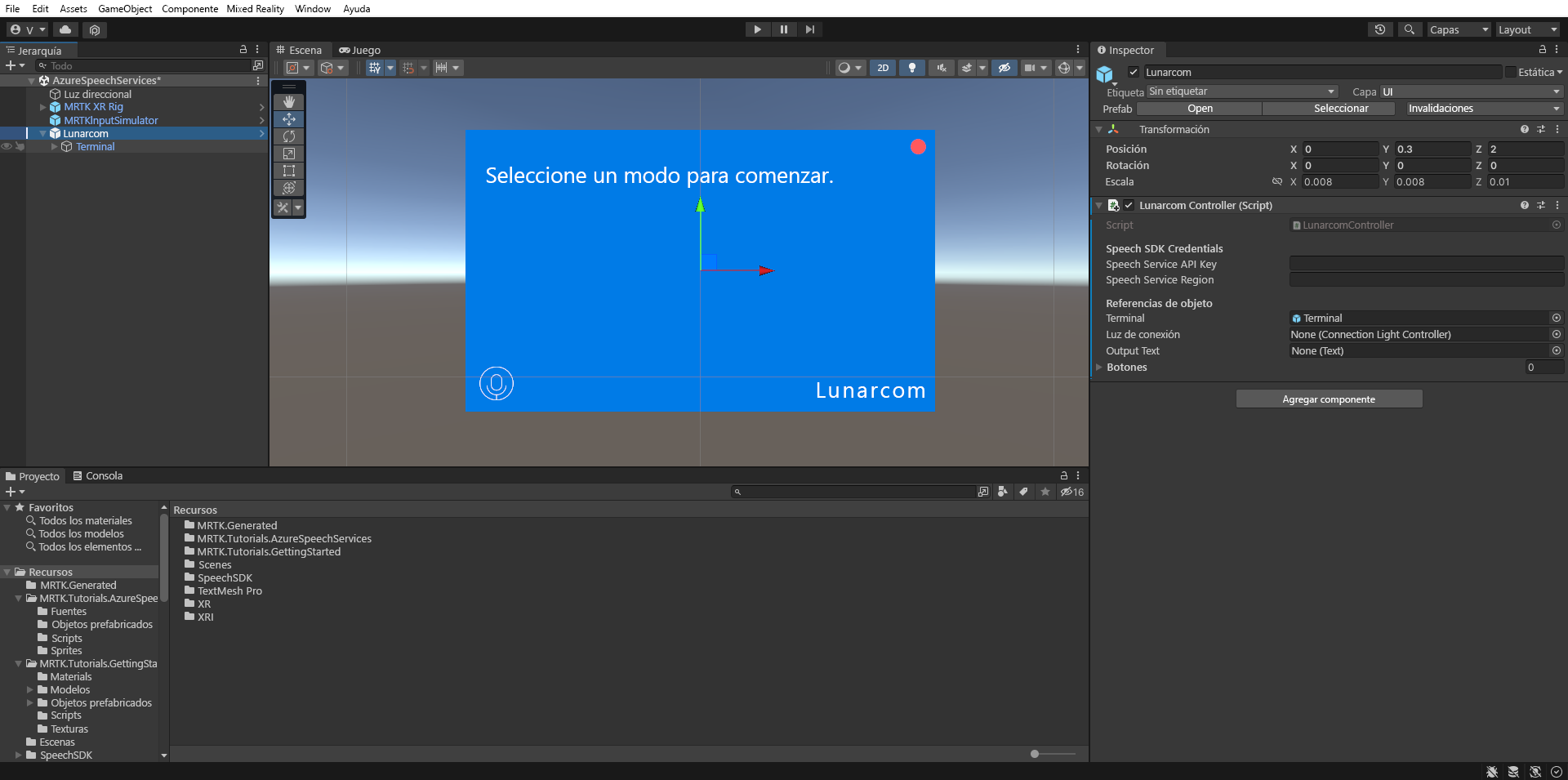

Preparación de la escena

En esta sección, preparará la escena al agregar el objeto prefabricado del tutorial y configurará el componente Lunarcom Controller (Script) para controlar la escena.

En la ventana del proyecto, vaya a la carpeta Recursos>MRTK.Tutorials.AzureSpeechServices>Objetos prefabricados y arrastre el objeto prefabricado Lunarcom a la ventana de jerarquía para agregarlo a la escena.

Con el objeto Lunarcom aún seleccionado en la ventana Jerarquía, en la ventana Inspector, use el botón Agregar componente para agregar el componente Luncarcom Controller (script) al objeto Lunarcom.

Con el objeto Lunarcom aún seleccionado, expándalo para mostrar sus objetos secundarios y, después, arrastre el objeto Terminal al campo Terminal del componente Lunarcom Controller (script).

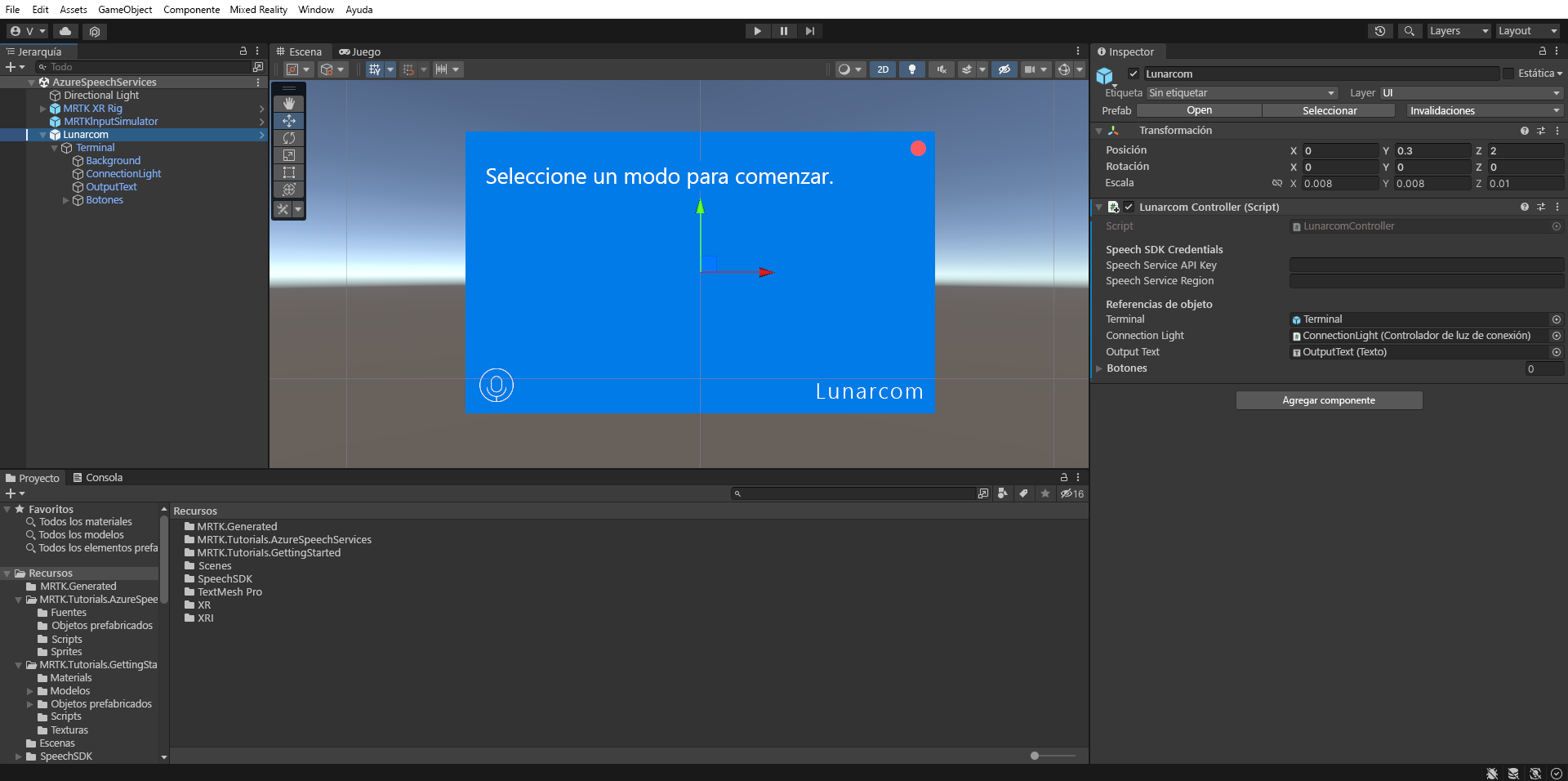

Con el objeto Lunarcom aún seleccionado, expanda el objeto Terminal para mostrar sus objetos secundarios y, después, arrastre el objeto ConnectionLight al campo Luz de conexión entre componentes del componente Lunarcom Controller (script) y el objeto OutputText al campo Texto de salida.

Con el objeto Lunarcom aún seleccionado, expanda el objeto Botones para mostrar sus objetos secundarios y, después, en la ventana Inspector, expanda la lista Botones, establezca el campo Botones en 3 y arrastre los objetos MicButton, SatelliteButton y RocketButton a los campos de elemento 0, 1 y 2 respectivamente.

Conexión del proyecto de Unity al recurso de Azure

Para usar los servicios de voz de Azure, debes crear un recurso de Azure y obtener una clave de API para el servicio de voz. Siga las instrucciones de inicio rápido y tome nota de la región de servicio (también conocida como Ubicación) y la clave de API (también conocida como Key1 o Key2).

En la ventana Hierarchy (Jerarquía), selecciona el objeto Lunarcom y, a continuación, en la ventana Inspector, busca la sección Speech SDK Credentials (Credenciales del SDK de voz) de Lunarcom Controller (Script) (Controlador de Lunarcom [script]) y configúrala como se indica a continuación:

- En el campo Clave de Speech Service API, escriba la clave de API (Key1 o Key2).

- En el campo Región de Speech Service, escriba la región de servicio (Ubicación) con letras minúsculas y sin espacios.

Uso del reconocimiento de voz para transcribir texto

En la ventana Jerarquía, seleccione el objeto Lunarcom y, a continuación, en la ventana Inspector, use el botón Agregar componente para agregar el componente Lunarcom Speech Recognizer (script) al objeto Lunarcom.

Si ahora entra en modo juego y selecciona el botón Reproducir, puede probar el reconocimiento de voz al presionar primero el botón micrófono:

A continuación, suponiendo que el equipo tiene un micrófono, cuando digas algo, la voz se transcribirá en el panel del terminal:

Precaución

La aplicación necesita conectarse a Azure, por lo que debes asegurarte de que el equipo o dispositivo está conectado a Internet.