Transformer des données à l’aide d’une activité Hadoop Hive dans Azure Data Factory ou Synapse Analytics | Microsoft Docs

S’APPLIQUE À : Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

L’activité Hive HDInsight d’un pipeline Azure Data Factory ou Synapse Analytics exécute des requêtes Hive sur votre propre cluster HDInsight ou sur un cluster HDInsight à la demande. Cet article s'appuie sur l'article Activités de transformation des données qui présente une vue d'ensemble de la transformation des données et les activités de transformation prises en charge.

Si vous découvrez Azure Data Factory et Synapse Analytics, lisez la présentation d’Azure Data Factory ou Synapse Analytics et suivez le Didacticiel : Transformer des données avant de lire cet article.

Ajouter une activité HDInsight Hive à un pipeline avec une IU

Pour utiliser une activité HDInsight Hive pour Azure Data Lake Analytics dans un pipeline, procédez comme suit :

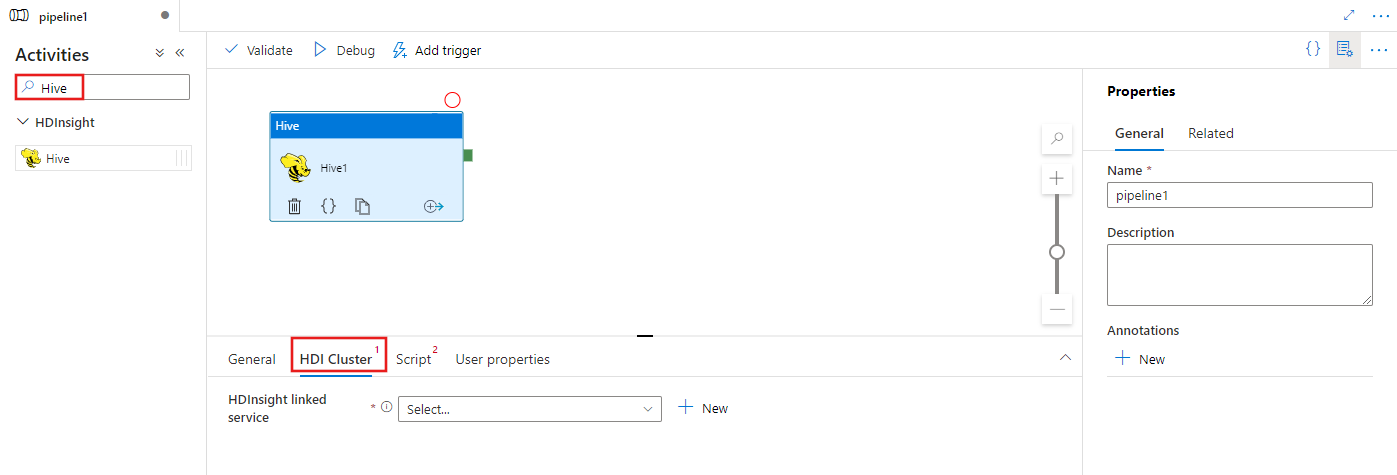

Recherchez Hive dans le volet Activités du pipeline, puis faites glisser une activité Hive vers le canevas du pipeline.

Sélectionnez l’activité Hive sur le canevas si elle n’est pas déjà sélectionnée.

Sélectionnez l’onglet cluster HDI pour sélectionner ou créer un nouveau service lié à un cluster HDInsight qui sera utilisé pour exécuter l’activité Hive.

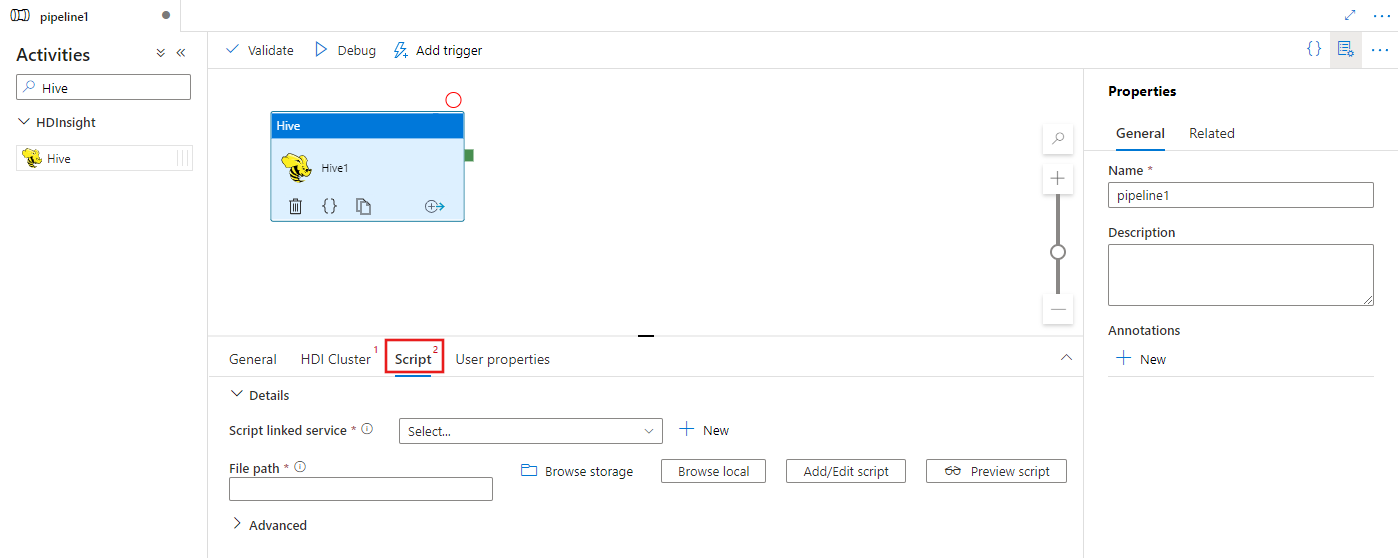

Sélectionnez l’onglet Script pour sélectionner ou créer un service lié de stockage, ainsi qu’un chemin d’accès dans l’emplacement de stockage, qui hébergera le script.

Syntaxe

{

"name": "Hive Activity",

"description": "description",

"type": "HDInsightHive",

"linkedServiceName": {

"referenceName": "MyHDInsightLinkedService",

"type": "LinkedServiceReference"

},

"typeProperties": {

"scriptLinkedService": {

"referenceName": "MyAzureStorageLinkedService",

"type": "LinkedServiceReference"

},

"scriptPath": "MyAzureStorage\\HiveScripts\\MyHiveSript.hql",

"getDebugInfo": "Failure",

"arguments": [

"SampleHadoopJobArgument1"

],

"defines": {

"param1": "param1Value"

}

}

}

Détails de la syntaxe

| Propriété | Description | Obligatoire |

|---|---|---|

| name | Nom de l’activité | Oui |

| description | Texte décrivant la raison motivant l’activité. | Non |

| type | Pour l’activité Hive, le type d’activité est HDinsightHive. | Oui |

| linkedServiceName | Référence au cluster HDInsight enregistré en tant que service lié. Pour en savoir plus sur ce service lié, consultez l’article Services liés de calcul. | Oui |

| scriptLinkedService | Référence à un service lié de stockage Azure utilisé pour stocker le script Hive à exécuter. Seuls les services liés Stockage Blob Azure et ADLS Gen2 sont pris en charge ici. Si vous ne spécifiez pas ce service lié, le service lié Stockage Azure défini dans le service lié HDInsight est utilisé. | Non |

| scriptPath | Indiquez le chemin du fichier de script stocké dans le stockage Azure référencé par scriptLinkedService. Le nom de fichier respecte la casse. | Oui |

| getDebugInfo | Spécifie quand les fichiers journaux sont copiés vers le stockage Azure utilisé par le cluster HDInsight (ou) spécifié par scriptLinkedService. Valeurs autorisées : None, Always ou Failure. Valeur par défaut : Aucun. | Non |

| arguments | Spécifie un tableau d’arguments pour un travail Hadoop. Les arguments sont passés sous la forme d’arguments de ligne de commande à chaque tâche. | Non |

| defines | Spécifier les paramètres sous forme de paires clé/valeur pour le référencement au sein du script Hive. | Non |

| queryTimeout | Valeur du délai d'expiration de la requête (en minutes). Applicable lorsque le cluster HDInsight est activé avec le Pack Sécurité Entreprise. | Non |

Notes

La valeur par défaut de queryTimeout est 120 minutes.

Contenu connexe

Consultez les articles suivants qui expliquent comment transformer des données par d’autres moyens :