Configurer le trafic réseau entrant et sortant

Azure Machine Learning nécessite l’accès à des serveurs et services sur l’Internet public. Lorsque vous implémentez l’isolation réseau, vous devez comprendre quel accès est requis et comment l’activer.

Remarque

Les informations de cet article s’appliquent à l’espace de travail Azure Machine Learning configuré pour utiliser un réseau virtuel Azure. Lors de l’utilisation d’un réseau virtuel managé, la configuration entrante et sortante requise pour l’espace de travail est automatiquement appliquée. Pour plus d’informations, consultez Réseau virtuel managé Azure Machine Learning.

Termes courants et informations

Les informations et termes importants suivants sont utilisés tout au long de cet article :

Étiquettes de service Azure : une étiquette de service est un moyen simple de spécifier les plages d’adresses IP utilisées par un service Azure. Par exemple, l’étiquette

AzureMachineLearningreprésente les adresses IP utilisées par le service Azure Machine Learning.Important

Les étiquettes de service Azure sont uniquement prises en charge par certains services Azure. Pour obtenir la liste des étiquettes de service prises en charge avec les groupes de sécurité réseau et le Pare-feu Azure, consultez l’article Balises de service du réseau virtuel.

Si vous utilisez une solution non Azure, comme un pare-feu tiers, téléchargez une liste de plages d’adresses IP et d’étiquettes de service Azure. Extrayez le fichier et recherchez l’étiquette de service dans le fichier. Les adresses IP peuvent périodiquement changer.

Région : certaines étiquettes de service vous permettent de spécifier une région Azure. Cela limite l’accès aux adresses IP de service à une région spécifique, généralement celle dans laquelle se trouve votre service. Dans cet article, lorsque vous voyez

<region>, remplacez votre région Azure. Par exemple,BatchNodeManagement.<region>seraitBatchNodeManagement.uswestsi votre espace de travail Azure Machine Learning se trouvait dans la région USA Ouest.Azure Batch : les clusters de calcul et les instances de calcul Azure Machine Learning s’appuient sur une instance Azure Batch back-end. Ce service back-end est hébergé dans un abonnement Microsoft.

Ports : les ports suivants sont utilisés dans cet article. Si une plage de ports n’est pas répertoriée dans ce tableau, cela signifie qu’elle est spécifique au service et que les informations sur son utilisation ne sont peut-être pas publiées :

Port Description 80 Trafic web non sécurisé (HTTP) 443 Trafic web sécurisé (HTTPS) 445 Trafic SMB utilisé pour accéder aux partages de fichiers dans le stockage de fichiers Azure 8787 Utilisé lors de la connexion à RStudio sur une instance de calcul 18881 Utilisé pour se connecter au serveur de langage afin d’activer IntelliSense pour les notebooks sur une instance de calcul. Protocole : sauf indication contraire, tout le trafic réseau mentionné dans cet article utilise TCP.

Configuration de base

Cette configuration repose sur les hypothèses suivantes :

- Vous utilisez des images Docker fournies par un registre de conteneurs que vous fournissez, et n’utiliserez pas d’images fournies par Microsoft.

- Vous utilisez un référentiel de packages Python privé et n’accédez pas à des référentiels de packages publics, comme

pypi.org,*.anaconda.comou*.anaconda.org. - Les points de terminaison privés peuvent communiquer directement entre eux au sein du réseau virtuel. Par exemple, tous les services ont un point de terminaison privé dans le même réseau virtuel :

- Espace de travail Azure Machine Learning

- Compte de stockage Azure (blob, fichier, table, file d’attente)

Trafic entrant

| Source | Source ports |

Destination | Ports dedestination | Objectif |

|---|---|---|---|---|

AzureMachineLearning |

Quelconque | VirtualNetwork |

44224 | Entrant vers l’instance/le cluster de calcul. Nécessaire uniquement si l’instance/le cluster est configuré pour utiliser une adresse IP publique. |

Conseil

Un groupe de sécurité réseau (NSG) est créé par défaut pour ce trafic. Pour plus d’informations, consultez Règles de sécurité par défaut.

Trafic sortant

| Étiquette(s) du service | Ports | Objectif |

|---|---|---|

AzureActiveDirectory |

80, 443 | Authentification à l’aide de Microsoft Entra ID. |

AzureMachineLearning |

443, 8787, 18881 UDP : 5831 |

Utilisation d’Azure Machine Learning Services. |

BatchNodeManagement.<region> |

443 | Azure Batch de communication. |

AzureResourceManager |

443 | Création de ressources Azure avec Azure Machine Learning. |

Storage.<region> |

443 | Accédez aux données stockées dans le compte Stockage Azure pour le cluster et l’instance de calcul. Ce trafic sortant peut être utilisé pour exfiltrer des données. Pour plus d’informations, consultez Protection contre l’exfiltration de données. |

AzureFrontDoor.FrontEnd* Non nécessaire dans Microsoft Azure géré par 21Vianet. |

443 | Point d’entrée global pour Azure Machine Learning studio. Stockez des images et des environnements pour AutoML. |

MicrosoftContainerRegistry |

443 | Accès aux images Docker fournies par Microsoft. |

Frontdoor.FirstParty |

443 | Accès aux images Docker fournies par Microsoft. |

AzureMonitor |

443 | Utilisé pour journaliser la surveillance et les métriques dans Azure Monitor. Nécessaire uniquement si vous n’avez pas sécurisé Azure Monitor pour l’espace de travail. * Ce trafic sortant est également utilisé pour journaliser les informations relatives aux incidents de support. |

VirtualNetwork |

443 | Obligatoire lorsque des points de terminaison privés sont présents dans le réseau virtuel ou les réseaux virtuels appairés. |

Important

Si une instance de calcul ou un cluster de calcul n’est configuré pour aucune adresse IP publique, il ne peut pas accéder à Internet par défaut. S’il peut toujours envoyer le trafic sortant à Internet, c’est en raison de l’accès sortant par défaut d’Azure et parce que vous avez un groupe de sécurité réseau qui autorise le trafic sortant vers Internet. Nous ne recommandons pas d’utiliser l’accès sortant par défaut. Si vous avez besoin d’un accès sortant vers Internet, nous vous recommandons d’utiliser l’une des options suivantes au lieu de l’accès sortant par défaut :

- NAT de réseau virtuel Azure une adresse IP publique : pour plus d’informations sur l’utilisation du NAT de réseau virtuel, consultez la documentation Service NAT de Réseau virtuel.

- Itinéraire et pare-feu définis par l’utilisateur : créez un itinéraire défini par l’utilisateur dans le sous-réseau qui contient le calcul. Le Tronçon suivant de l’itinéraire doit référencer l’adresse IP privée du pare-feu, avec le préfixe d’adresse 0.0.0.0/0.

Pour plus d’informations, consultez l’article Accès sortant par défaut dans Azure.

Configuration recommandée pour l’entraînement et le déploiement de modèles

Trafic sortant

| Étiquette(s) du service | Ports | Objectif |

|---|---|---|

MicrosoftContainerRegistry et AzureFrontDoor.FirstParty |

443 | Autorise l’utilisation d’images Docker que Microsoft fournit pour l’entraînement et l’inférence. Cela configure également le routeur Azure Machine Learning pour Azure Kubernetes Service. |

Pour autoriser l’installation de packages Python pour l’entraînement et le déploiement, autorisez le trafic sortant vers les noms d’hôte suivants :

Notes

Il ne s’agit pas d’une liste complète des ordinateurs hôtes requis pour toutes les ressources Python sur Internet, uniquement celles les plus couramment utilisées. Par exemple, si vous avez besoin d’accéder à un référentiel GitHub ou à un autre hôte, vous devez identifier et ajouter les ordinateurs hôtes requis pour ce scénario.

| Nom d’hôte | Objectif |

|---|---|

anaconda.com*.anaconda.com |

Utilisé pour installer les packages par défaut. |

*.anaconda.org |

Utilisé pour récupérer les données des dépôts. |

pypi.org |

Utilisé pour lister les dépendances de l’index par défaut, le cas échéant, et si l’index n’a pas été remplacé par les paramètres utilisateur. Si l’index a été remplacé, vous devez également autoriser *.pythonhosted.org. |

pytorch.org*.pytorch.org |

Utilisé par certains exemples basés sur PyTorch. |

*.tensorflow.org |

Utilisé par certains exemples basés sur Tensorflow. |

Scénario : Installer RStudio sur une instance de calcul

Pour permettre l’installation de RStudio sur une instance de calcul, le pare-feu doit autoriser l’accès sortant aux sites à partir duquel extraire l’image Docker. Ajoutez la règle d’application suivante à votre stratégie de Pare-feu Azure :

- Nom : AllowRStudioInstall

- Type de source : Adresse IP

- Adresses IP sources : plage d’adresses IP du sous-réseau où vous allez créer l’instance de calcul. Par exemple :

172.16.0.0/24. - Type de destination : FQDN

- Nom de domaine complet cible :

ghcr.io,pkg-containers.githubusercontent.com - Protocol :

Https:443

Pour autoriser l’installation de packages R, autorisez le trafic sortant vers cloud.r-project.org. Cet hôte est utilisé pour installer les packages CRAN.

Notes

Si vous avez besoin d’accéder à un référentiel GitHub ou à un autre hôte, vous devez identifier et ajouter les ordinateurs hôtes requis pour ce scénario.

Scénario : Utilisation d’un cluster de calcul ou d’une instance de calcul avec une adresse IP publique

Important

Une instance de calcul ou un cluster de calcul sans adresse IP publique n’a pas besoin de trafic entrant à partir de la gestion Azure Batch et des services Azure Machine Learning. Toutefois, si vous avez plusieurs calculs et que certains d’entre eux utilisent une adresse IP publique, vous devez autoriser ce trafic.

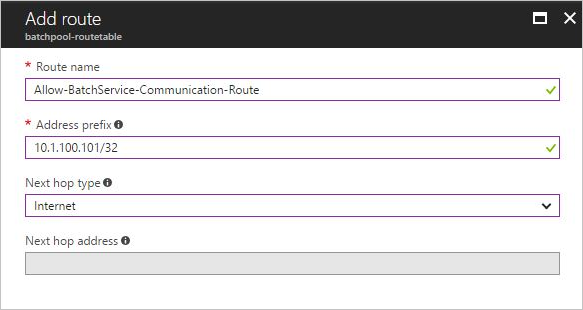

Lors de l’utilisation de l’instance de calcul ou du cluster de calcul (avec une adresse IP publique) d’Azure Machine Learning, autorisez le trafic entrant à partir du service Azure Machine Learning. Une instance de calcul sans adresse IP publique (préversion) ne nécessite pas cette communication entrante. Un groupe de sécurité réseau qui autorise ce trafic est créé dynamiquement pour vous, mais vous devrez peut-être également créer des itinéraires définis par l’utilisateur (UDR) si vous avez un pare-feu. Lors de la création d’un UDR pour ce trafic, vous pouvez utiliser des adresses IP ou des étiquettes de service pour router ce trafic.

Pour le service Azure Machine Learning, vous devez ajouter l’adresse IP pour les régions Azure primaire et secondaire. Pour trouver la région secondaire, consultez Réplication entre les régions dans Azure. Par exemple, si votre service Azure Machine Learning se trouve dans la région USA Est 2, la région secondaire correspond à USA Centre.

Pour obtenir la liste des adresses IP d’Azure Machine Learning, téléchargez les plages d’adresses IP Azure et les balises de service, et recherchez AzureMachineLearning.<region> dans le fichier, où <region> est votre région Azure.

Important

Les adresses IP peuvent changer au fil du temps.

Lors de la création de l’UDR, définissez le Type de tronçon suivant sur Internet. Cela signifie que la communication entrante d’Azure ignore votre pare-feu pour accéder aux équilibreurs de charge avec des adresses IP publiques d’instance de calcul et de cluster de calcul. Le routage défini par l’utilisateur (UDR) est requis, car l’instance de calcul et le cluster de calcul obtiennent des adresses IP publiques aléatoires lors de leur création, et vous ne pouvez pas connaître les adresses IP publiques avant la création pour les inscrire sur votre pare-feu afin d’autoriser le trafic entrant d’Azure vers des adresses IP spécifiques pour l’instance de calcul et le cluster de calcul. L’illustration suivante propose un exemple de cette adresse IP basée sur l’UDR dans le portail Azure :

Pour plus d’informations sur la configuration de l’UDR, consultez Définir l’itinéraire du trafic réseau à l’aide d’une table de routage.

Scénario : Pare-feu entre les points de terminaison Azure Machine Learning et Stockage Azure

Vous devez également autoriser l’accès sortant à Storage.<region> sur le port 445.

Scénario : Espace de travail créé avec l’indicateur hbi_workspace activé

Vous devez également autoriser l’accès sortant à Keyvault.<region>. Ce trafic sortant est utilisé pour accéder à l’instance de coffre de clés pour le service Azure Batch principal.

Pour plus d’informations sur l’indicateur hbi_workspace, consultez l’article Chiffrement des données.

Scénario : Utiliser le calcul Kubernetes

Les clusters Kubernetes qui s’exécutent derrière un serveur proxy ou un pare-feu sortant ont besoin d’une configuration réseau de sortie supplémentaire.

- Pour Kubernetes avec connexion Azure Arc, configurez les exigences réseau Azure Arc requises par les agents Azure Arc.

- Pour le cluster AKS sans connexion Azure Arc, configurez les exigences du réseau d’extension AKS.

Outre les exigences susmentionnées, les URL sortantes suivantes sont également requises pour Azure Machine Learning,

| Point de terminaison sortant | Port | Description | Entrainement | Inférence |

|---|---|---|---|---|

*.kusto.windows.net*.table.core.windows.net*.queue.core.windows.net |

443 | Requis pour charger les journaux système dans Kusto. | ✓ | ✓ |

<your ACR name>.azurecr.io<your ACR name>.<region>.data.azurecr.io |

443 | Registre de conteneurs Azure, requis pour extraire les images Docker utilisées pour les charges de travail de Machine Learning. | ✓ | ✓ |

<your storage account name>.blob.core.windows.net |

443 | Stockage Blob Azure, requis pour récupérer des scripts, des données ou des modèles de projets Machine Learning et charger des journaux/sorties de travaux. | ✓ | ✓ |

<your workspace ID>.workspace.<region>.api.azureml.ms<region>.experiments.azureml.net<region>.api.azureml.ms |

443 | API du service Azure Machine Learning. | ✓ | ✓ |

pypi.org |

443 | Index des packages Python, pour installer les packages PIP utilisés pour l’initialisation de l’environnement de travail de la formation. | ✓ | N/A |

archive.ubuntu.comsecurity.ubuntu.comppa.launchpad.net |

80 | Requis pour télécharger les correctifs de sécurité nécessaires. | ✓ | N/A |

Notes

- Remplacez

<your workspace workspace ID>par l’ID de votre espace de travail. L’ID se trouve sur le portail Azure - votre page de ressources Machine Learning - Propriétés - ID de l’espace de travail. - Remplacez

<your storage account>par le nom du compte de stockage. - Remplacez

<your ACR name>par le nom du registre Azure Container Registry de votre espace de travail. - Remplacez

<region>par la région de votre espace de travail.

Exigences en matière de communication dans le cluster

Pour installer l’extension Azure Machine Learning sur le calcul Kubernetes, tous les composants liés à Azure Machine Learning sont déployés dans un espace de noms azureml. La communication suivante dans le cluster est nécessaire pour garantir que les charges de travail ML fonctionnent bien dans le cluster AKS.

- Les composants de l’espace de noms

azuremldoivent être en mesure de communiquer avec le serveur d’API Kubernetes. - Les composants de l’espace de noms

azuremldoivent être en mesure de communiquer l’un avec l’autre. - Les composants de l’espace de noms

azuremldoivent être en mesure de communiquer aveckube-dnsetkonnectivity-agentdans l’espace de nomskube-system. - Si le cluster est utilisé pour l’inférence en temps réel, les POD

azureml-fe-xxxdoivent être en mesure de communiquer avec les POD du modèle déployé sur le port 5001 dans un autre espace de noms. Les PODazureml-fe-xxxdoivent ouvrir 11001, 12001, 12101, 12201, 20000, 8000, 8001, 9001, 9001 pour la communication interne. - Si le cluster est utilisé pour l’inférence en temps réel, les POD de modèles déployés doivent être en mesure de communiquer avec les POD

amlarc-identity-proxy-xxxsur le port 9999.

Scénario : Visual Studio Code

Visual Studio Code s’appuie sur des hôtes et des ports spécifiques pour établir une connexion distante.

Hôtes

Les hôtes de cette section permettent d’installer les packages Visual Studio Code afin d’établir une connexion à distance entre Visual Studio Code et les instances de calcul dans votre espace de travail Azure Machine Learning.

Notes

Il ne s’agit pas d’une liste complète des ordinateurs hôtes requis pour toutes les ressources Visual Studio Code sur Internet, uniquement pour celles les plus couramment utilisées. Par exemple, si vous avez besoin d’accéder à un référentiel GitHub ou à un autre hôte, vous devez identifier et ajouter les ordinateurs hôtes requis pour ce scénario. Pour obtenir la liste complète des noms d’hôtes, consultez Connexions réseau dans Visual Studio Code.

| Nom d’hôte | Objectif |

|---|---|

*.vscode.dev*.vscode-unpkg.net*.vscode-cdn.net*.vscodeexperiments.azureedge.netdefault.exp-tas.com |

Requis pour accéder à vscode.dev (Visual Studio Code pour le web) |

code.visualstudio.com |

Requis pour télécharger et installer VS Code Desktop. Cet hôte n’est pas requis pour VS Code Web. |

update.code.visualstudio.com*.vo.msecnd.net |

Utilisé pour récupérer les bits du serveur VS Code qui sont installés sur l’instance de calcul par le biais d’un script d’installation. |

marketplace.visualstudio.comvscode.blob.core.windows.net*.gallerycdn.vsassets.io |

Requis pour télécharger et installer des extensions VS Code. Ces hôtes activent la connexion à distance pour calculer des instances à l’aide de l’extension Azure Machine Learning pour VS Code. Pour plus d’informations, consultez Se connecter à une instance de calcul Azure Machine Learning dans Visual Studio Code |

https://github.com/microsoft/vscode-tools-for-ai/tree/master/azureml_remote_websocket_server/* |

Utilisé pour récupérer les bits du serveur websocket qui sont installés sur l’instance de calcul. Le serveur websocket est utilisé pour transmettre les requêtes du client Visual Studio Code (application de bureau) au serveur Visual Studio Code s’exécutant sur l’instance de calcul. |

vscode.download.prss.microsoft.com |

Utilisé pour CDN de téléchargement de Visual Studio Code |

Ports

Vous devez autoriser le trafic réseau vers les ports 8704 à 8710. Le serveur VS Code sélectionne dynamiquement le premier port disponible dans cette plage.

Scénario : pare-feu tiers ou Pare-feu Azure sans étiquettes de service

Les instructions de cette section sont génériques, car chaque pare-feu dispose de sa propre terminologie et de configurations spécifiques. Si vous avez des questions, consultez la documentation du pare-feu que vous utilisez.

Conseil

Si vous utilisez Pare-feu Azure et que vous souhaitez utiliser les noms de domaine complets répertoriés dans cette section au lieu d’utiliser des étiquettes de service, suivez les conseils suivants :

- Les noms de domaine complets utilisant des ports HTTP/S (80 et 443) doivent être configurés en tant que règles d’application.

- Les noms de domaine complets utilisant d’autres ports doivent être configurés en tant que règles réseau.

Si vous souhaitez obtenir plus d’informations, consultez Différences entre les règles d’application et les règles réseau.

S’il n’est pas configuré correctement, le pare-feu peut causer des problèmes lors de l’utilisation de votre espace de travail. Des noms d’hôtes différents sont utilisés à la fois par l’espace de travail Azure Machine Learning. Les sections suivantes répertorient les hôtes requis pour Azure Machine Learning.

API de dépendances

Vous pouvez également utiliser l’API REST Azure Machine Learning pour obtenir la liste des hôtes et des ports vers lesquels vous devez autoriser le trafic sortant. Pour utiliser cette API, procédez comme suit :

Obtenez un jeton d’authentification. La commande suivante illustre l’utilisation de l’interface Azure CLI pour obtenir un jeton d’authentification et un ID d’abonnement :

TOKEN=$(az account get-access-token --query accessToken -o tsv) SUBSCRIPTION=$(az account show --query id -o tsv)Appelez l’API. Dans la commande suivante, remplacez les valeurs suivantes :

- Remplacez

<region>par la région Azure où figure votre espace de travail. Par exemple :westus2. - Remplacez

<resource-group>par le groupe de ressources qui contient votre espace de travail. - Remplacez

<workspace-name>par le nom de votre point de terminaison.

az rest --method GET \ --url "https://<region>.api.azureml.ms/rp/workspaces/subscriptions/$SUBSCRIPTION/resourceGroups/<resource-group>/providers/Microsoft.MachineLearningServices/workspaces/<workspace-name>/outboundNetworkDependenciesEndpoints?api-version=2018-03-01-preview" \ --header Authorization="Bearer $TOKEN"- Remplacez

Le résultat de l’appel d’API est un document JSON. L’extrait de code suivant est un extrait de ce document :

{

"value": [

{

"properties": {

"category": "Azure Active Directory",

"endpoints": [

{

"domainName": "login.microsoftonline.com",

"endpointDetails": [

{

"port": 80

},

{

"port": 443

}

]

}

]

}

},

{

"properties": {

"category": "Azure portal",

"endpoints": [

{

"domainName": "management.azure.com",

"endpointDetails": [

{

"port": 443

}

]

}

]

}

},

...

Hôtes Microsoft

Les hôtes des tableaux suivants sont détenus par Microsoft et fournissent les services nécessaires au bon fonctionnement de votre espace de travail. Les tableaux suivants répertorient les hôtes des régions Azure (public), Azure Government et Microsoft Azure géré par 21Vianet.

Important

Azure Machine Learning utilise des comptes Stockage Azure dans votre abonnement et dans les abonnements managés par Microsoft. Le cas échéant, les termes suivants sont utilisés pour les distinguer dans cette section :

- Votre stockage : le ou les comptes Stockage Azure de votre abonnement, qui sont utilisés pour stocker vos données et artefacts, comme les modèles, les données d’entraînement, les journaux d’entraînement et les scripts Python.>

- Stockage Microsoft : l’instance de calcul et les clusters de calcul Azure Machine Learning s’appuient sur Azure Batch et doivent avoir accès au stockage situé dans un abonnement Microsoft. Ce stockage est utilisé uniquement pour la gestion des instances de calcul. Aucune de vos données n’est stockée ici.

Hôtes Azure généraux

| Obligatoire pour | Hôtes | Protocole | Ports |

|---|---|---|---|

| Microsoft Entra ID | login.microsoftonline.com |

TCP | 80, 443 |

| Portail Azure | management.azure.com |

TCP | 443 |

| Azure Resource Manager | management.azure.com |

TCP | 443 |

Hôtes Azure Machine Learning

Important

Dans le tableau suivant, remplacez <storage> par le nom du compte de stockage par défaut de votre espace de travail Azure Machine Learning. Remplacez <region> par la région de votre espace de travail.

| Obligatoire pour | Hôtes | Protocole | Ports |

|---|---|---|---|

| Azure Machine Learning Studio | ml.azure.com |

TCP | 443 |

| API | *.azureml.ms |

TCP | 443 |

| API | *.azureml.net |

TCP | 443 |

| La gestion des modèles | *.modelmanagement.azureml.net |

TCP | 443 |

| Notebook intégré | *.notebooks.azure.net |

TCP | 443 |

| Notebook intégré | <storage>.file.core.windows.net |

TCP | 443, 445 |

| Notebook intégré | <storage>.dfs.core.windows.net |

TCP | 443 |

| Notebook intégré | <storage>.blob.core.windows.net |

TCP | 443 |

| Notebook intégré | graph.microsoft.com |

TCP | 443 |

| Notebook intégré | *.aznbcontent.net |

TCP | 443 |

| AutoML NLP, Vision | automlresources-prod.azureedge.net |

TCP | 443 |

| AutoML NLP, Vision | aka.ms |

TCP | 443 |

Notes

AutoML NLP, Vision est actuellement pris en charge uniquement dans les régions publiques Azure.

Hôtes d’instance de calcul et de cluster de calcul Azure Machine Learning

Conseil

- L’hôte pour le coffre Azure Key Vault est nécessaire uniquement si votre espace de travail a été créé avec l’indicateur hbi_workspace activé.

- Les ports 8787 et 18881 pour l’instance de calcul sont nécessaires uniquement quand votre espace de travail Azure Machine Learning possède un point de terminaison privé.

- Dans le tableau suivant, remplacez

<storage>par le nom du compte de stockage par défaut de votre espace de travail Azure Machine Learning. - Dans la table suivante, remplacez

<region>par la région Azure qui contient votre espace de travail Azure Machine Learning. - La communication websocket doit être autorisée sur l’instance de calcul. Si vous bloquez le trafic websocket, les notebooks Jupyter ne fonctionneront pas correctement.

| Obligatoire pour | Hôtes | Protocole | Ports |

|---|---|---|---|

| Cluster/instance de calcul | graph.windows.net |

TCP | 443 |

| Instance de calcul | *.instances.azureml.net |

TCP | 443 |

| Instance de calcul | *.instances.azureml.ms |

TCP | 443, 8787, 18881 |

| Instance de calcul | <region>.tundra.azureml.ms |

UDP | 5831 |

| Instance de calcul | *.<region>.batch.azure.com |

ANY | 443 |

| Instance de calcul | *.<region>.service.batch.azure.com |

ANY | 443 |

| Accès de stockage Microsoft | *.blob.core.windows.net |

TCP | 443 |

| Accès de stockage Microsoft | *.table.core.windows.net |

TCP | 443 |

| Accès de stockage Microsoft | *.queue.core.windows.net |

TCP | 443 |

| Votre compte de stockage | <storage>.file.core.windows.net |

TCP | 443, 445 |

| Votre compte de stockage | <storage>.blob.core.windows.net |

TCP | 443 |

| Azure Key Vault | *.vault.azure.net | TCP | 443 |

Images Docker gérées par Azure Machine Learning

| Obligatoire pour | Hôtes | Protocole | Ports |

|---|---|---|---|

| Registre de conteneurs Microsoft | mcr.microsoft.com *.data.mcr.microsoft.com |

TCP | 443 |

Conseil

- Azure Container Registry est requis pour toute image Docker personnalisée. Cela comprend des modifications mineures (par exemple, des packages supplémentaires) pour les images de base fournies par Microsoft. Cela est également requis pour le processus de soumission de travaux d’entraînement interne d’Azure Machine Learning. De plus, Microsoft Container Registry est toujours nécessaire, quel que soit le scénario.

- Si vous envisagez d’utiliser une identité fédérée, suivez les instructions de l’article Bonnes pratiques pour sécuriser les services de fédération Active Directory (AD FS).

En outre, utilisez les informations de la section calcul avec IP publique afin d’ajouter des adresses IP pour BatchNodeManagement et AzureMachineLearning.

Pour plus d’informations sur la restriction de l’accès aux modèles déployés sur AKS, consultez Limiter le trafic de sortie dans Azure Kubernetes Service (AKS).

Monitoring, métriques et diagnostics

Si vous n’avez pas sécurisé Azure Monitor pour l’espace de travail, vous devez autoriser le trafic sortant vers les hôtes suivants :

Si vous n’avez pas sécurisé Azure Monitor pour l’espace de travail, vous devez autoriser le trafic sortant vers les hôtes suivants :

Notes

Les informations journalisées sur ces hôtes sont également utilisées par le Support Microsoft pour diagnostiquer les problèmes que vous rencontrez avec votre espace de travail.

dc.applicationinsights.azure.comdc.applicationinsights.microsoft.comdc.services.visualstudio.com*.in.applicationinsights.azure.com

Pour obtenir la liste des adresses IP de ces hôtes, consultez la section adresses IP utilisées par Azure Monitor.

Étapes suivantes

Cet article fait partie d’une série sur la sécurisation d’un workflow Azure Machine Learning. Consultez les autres articles de cette série :

Pour plus d’informations sur la configuration du Pare-feu Azure, consultez Didacticiel : Déployer et configurer le Pare-feu Azure à l’aide du portail Azure.