Tests A/B dans Dynamics 365 Customer Insights - Journeys

Customer Insights - Journeys utilise de puissants tests A/B pour examiner vos parcours des clients basés sur des déclencheurs, vous permettant ainsi d’obtenir des informations sur la meilleure façon d’atteindre vos clients.

À l’aide des tests A/B, vous pouvez mesurer le canal ou la stratégie de messagerie de contenu qui conduit à un succès plus élevé. Chaque test compare un groupe témoin d’utilisateurs (version A) à une variante (version B). Le groupe de contrôle reçoit une expérience par défaut. Le groupe de variantes reçoit une expérience ou un message différent. En comparant les résultats des groupes, vous pouvez déterminer lequel est le plus efficace.

Exemple 1 : Créer un test A/B pour des parcours basés sur des déclencheurs

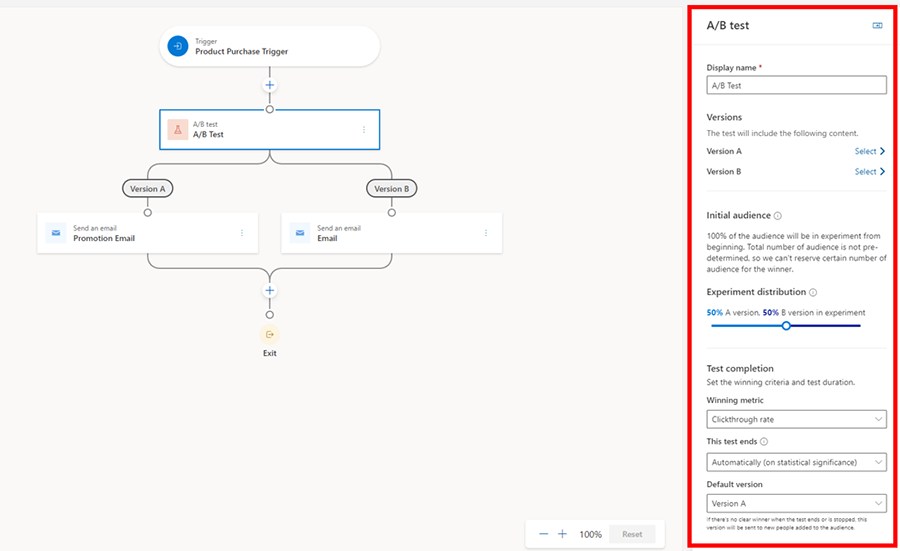

Imaginons que vous souhaitiez tester deux courriers électroniques différents lors d’un parcours basé sur des déclencheurs qui s’active lorsque quelqu’un effectue un achat.

Créez votre contenu initial dans l’éditeur d’e-mail, comme d’habitude. Perfectionnez le contenu autant que possible et veillez à vérifier qu’il n’y a aucune erreur avant de le mettre en service.

Lorsque votre contenu est prêt, accédez à Customer Insights - Journeys>Engagement>Parcours et sélectionnez un parcours existant ou créez-en un nouveau.

Après avoir sélectionné un parcours, sélectionnez le signe (+) pour ajouter un élément, puis procédez comme suit :

- Tester la variation la plus efficace.

- Sélectionnez vos canaux que vous souhaitez tester. Dans cet exemple, vous souhaitez tester deux courriers électroniques : sélectionnez-en un pour la version A et un pour la version B, puis sélectionnez Créer un test.

Lorsque vous sélectionnez la vignette de test A/B, le volet latéral s’ouvre.

Le volet JSON contient les paramètres suivants :

- Nom complet : pour identifier votre test, entrez un nom pour celui-ci. Ce nom s’affiche dans le panneau de test A/B et dans l’analyse de parcours du client lorsque vous regardez quels tests sont en cours d’exécution.

- Versions : sélectionnez le contenu du canal que vous avez préparé à l’étape 1 (dans ce cas, les deux courriers électroniques que vous souhaitez tester). Vous pouvez le faire via une liste déroulante en sélectionnant les vignettes enfants dans le générateur de parcours ou en effectuant une sélection dans le panneau latéral.

- Initiale audience : Il s’agit du groupe audience que vous voudriez retenir du test A/B avant d’obtenir les résultats. Cette option n’est disponible que pour les trajets basés sur des segments puisque vous disposez déjà d’un nombre total de clients pour vous aider à décider du nombre que vous souhaitez retenir. Les parcours basés sur des déclencheurs n’ont pas cette option car les clients entrent lorsqu’ils effectuent une action. En tant que tel, le nombre total de clients qui entrent dans le parcours est inconnu.

- distribution expérience: Choisissez la distribution audience que vous souhaitez.. Le curseur est automatiquement sur 50-50, mais vous pouvez régler le curseur sur la distribution souhaitée. Le minimum qu’une version peut recevoir est de 10 % et le maximum est de 90 %. N’oubliez pas que, traditionnellement, la version A est votre groupe de contrôle et la version B est votre variante.

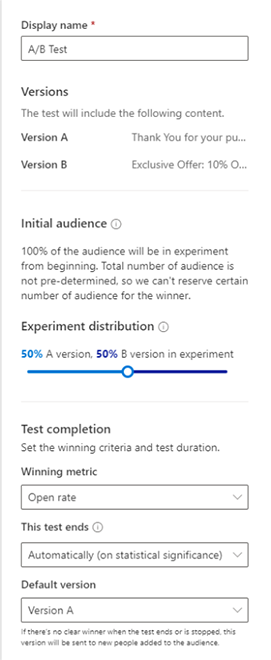

- Métrique gagnante : vous pouvez définir la condition gagnante pour votre test en choisissant une métrique gagnante : la version avec le plus d’événements d’objectif de parcours atteints, le plus de clics ou le plus d’ouverture. Dans ce cas, vous souhaitez augmenter vos taux d’ouverture, vous choisirez donc l’option de taux d’ouverture.

- Ce test se termine : vous pouvez également choisir de mettre fin au test automatiquement ou à une date et une heure spécifiques. Laisser le test déterminer automatiquement un gagnant lorsque les résultats atteignent une signification statistique. Cela signifie qu’une fois qu’un gagnant clair est déterminé, le système envoie la version gagnante au reste de votre audience. La version perdante est rejetée. Si vous choisissez la signification statistique comme option pour mettre fin au test A/B mais qu’il n’y a pas de gagnant clair après 30 jours, le système envoie automatiquement la version par défaut.

- Version par défaut : enfin, choisissez une version par défaut, si le test ne se termine pas correctement. Dans les cas où un gagnant n’a pas été déterminé dans le délai spécifié par la date et l’heure, la version par défaut est automatiquement envoyée.

Le test A/B devrait ressembler à ceci lorsque vous configurez tout et que vous êtes prêt à publier le parcours :

Exemple 2 : Créer un test A/B pour des parcours basés sur des segments

Imaginons que vous vouliez créer un parcours pour accueillir les nouveaux membres qui ont rejoint votre programme de fidélité ce mois-ci. Vous souhaitez augmenter votre taux d’ouverture en testant deux lignes d’objet différentes.

Vous effectuerez les étapes 1 à 3 décrites dans le premier exemple, mais vous remarquerez que le volet latéral est différent. En effet, avec les parcours basés sur des segments, vous avez un nombre total de clients pour commencer ; cela vous permet de créer deux types de tests A/B.

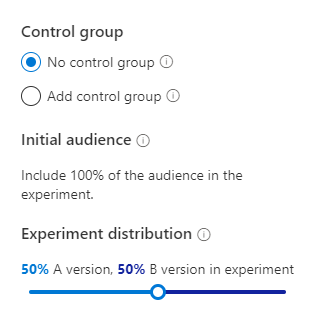

Test A/B sans groupe de contrôle : Ce test A/B se comporte de la même manière que les parcours basés sur des déclencheurs, où les clients parcourent le test au fur et à mesure qu’ils arrivent jusqu’à ce qu’un gagnant soit déterminé.

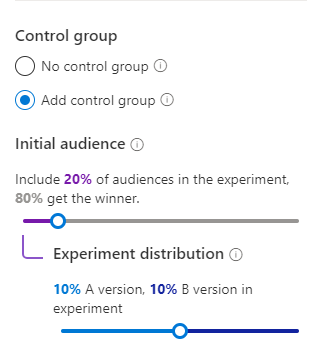

Test A/B avec un groupe de contrôle : Cela vous permet d’indiquer au système exactement combien de clients vous souhaitez tester. Par exemple, votre segment compte 100 membres fidèles, alors vous souhaitez d’abord tester sur 20 % ou 20 membres où chaque version recevra 10 membres respectivement. Après le test A/B, les 80 membres restants recevront la version gagnante. Vous pouvez toujours ajuster le audience initial et la distribution à votre guise.

Pour cet exemple, nous partons avec un test A/B avec un groupe de contrôle. Tous les autres paramètres sont les mêmes que dans le premier exemple.

Surveillez le cycle de vie de vos tests A/B

Après avoir publié votre parcours, vous pouvez l’ouvrir pour suivre le cycle de vie de vos tests.

- Brouillon : ces tests n’ont pas encore été exécutés, vous pouvez donc toujours modifier les paramètres.

- En cours : voici des tests en cours d’exécution. Les paramètres sont verrouillés et vous ne pouvez pas apporter de modifications importantes.

- Arrêté : Ces tests sont arrêtés et le marketeur peut choisir la version à envoyer.

- Terminé : ce sont des tests qui ont été effectués en trouvant un gagnant statistiquement significatif ou en expirant lorsqu’il est prévu de se terminer à une date et une heure définies. Les tests terminés ne peuvent pas être réutilisés.

Comprenez vos résultats

Il existe trois résultats de test A/B possibles :

- Test conclu avec un gagnant clair : le test a conclu qu’une version fonctionnait mieux que l’autre. La version gagnante a un badge « gagnant » et est distribuée à tous les nouveaux clients qui traversent le parcours.

- Le test n’a pas été concluant : le test a conclu que les destinataires sont aussi susceptibles de s’engager avec la version A qu’avec la version B. Dans ce cas, la version par défaut est envoyée à tous les nouveaux clients qui traversent le parcours.

- Le test a été arrêté : cela signifie que vous ou l’un de vos collègues avez arrêté le test avant qu’il ne puisse se terminer. Dans ce cas, la version spécifiée par vous ou votre collègue est envoyée à tous les nouveaux clients qui traversent le parcours.

FAQ

- Puis-je avoir un test A/B avec plus de deux versions ?

- Pas pour le moment.

- Pourquoi l’option de groupe de contrôle pour les trajets basés sur des segments ne s’affiche-t-elle pas ?

- Si vous mettez une branche d’attribut ou une vignette qui modifiera le nombre total du segment, l’option de groupe de contrôle disparaît car le système ne saura pas combien de clients retenir jusqu’à ce que le test soit terminé.

- Pourquoi mon test se termine-t-il de manière inattendue ?

- Si vous avez choisi de terminer le test avec une signification statistique, le système essaie d’obtenir un gagnant dans les 30 premiers jours à compter de la publication du voyage. Si aucune version n’est déclarée gagnante, le test se termine et la version par défaut est envoyée au audience restant.