Parcourir les applications Apache Spark dans le hub de supervision Fabric

Le hub de supervision sert de portail centralisé pour parcourir les activités Apache Spark à travers les éléments. Lorsque vous êtes dans Ingénieurs de données ou Science des données, vous pouvez afficher les applications Apache Spark en cours déclenchées à partir de notebooks, de définitions de travaux Apache Spark et de pipelines. Vous pouvez également rechercher et filtrer des applications Apache Spark en fonction de différents critères. En outre, vous pouvez annuler vos applications Apache Spark en cours et descendre dans la hiérarchie pour afficher plus de détails d’exécution d’une application Apache Spark.

Accéder au hub de supervision

Vous pouvez accéder au hub de supervision pour afficher diverses activités Apache Spark en sélectionnant Hub de supervision dans les liens de navigation de gauche.

Trier, rechercher, filtrer les applications Apache Spark et modifier les options de colonne

Pour une meilleure utilisation et une meilleure détectabilité, vous pouvez trier les applications Apache Spark en sélectionnant différentes colonnes dans l’interface utilisateur. Vous pouvez également filtrer les applications en fonction de différentes colonnes et rechercher des applications spécifiques. Vous pouvez également ajuster l’affichage et l’ordre de tri des colonnes indépendamment par le biais des options de colonne.

Trier les applications Apache Spark

Pour trier les applications Apache Spark, vous pouvez sélectionner sur chaque en-tête de colonne, par exemple Nom, État, Type d’élément, Heure de début, Emplacement, etc.

Filtrer les applications Apache Spark

Vous pouvez filtrer les applications Apache Spark par État, Type d’élément, Heure de début, Expéditeur etEmplacement à l’aide du volet Filtre dans le coin supérieur droit.

Rechercher des applications Apache Spark

Pour rechercher des applications Apache Spark, vous pouvez entrer certains mots clés dans la zone de recherche située dans le coin supérieur droit.

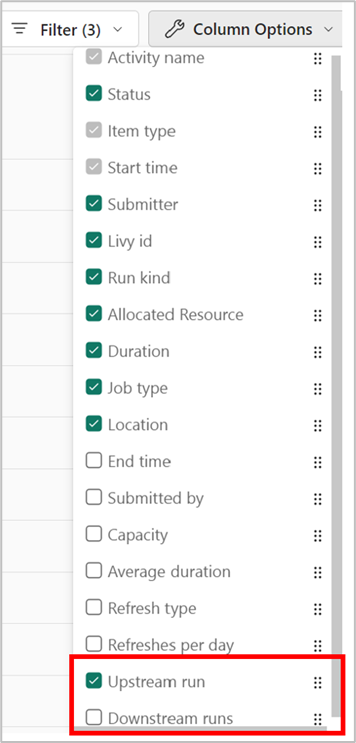

Modifier les options de colonne des applications Apache Spark

Vous pouvez modifier l’ordre dans lequel les listes sont affichées en sélectionnant la liste à afficher et en la faisant glisser parmi les options de liste.

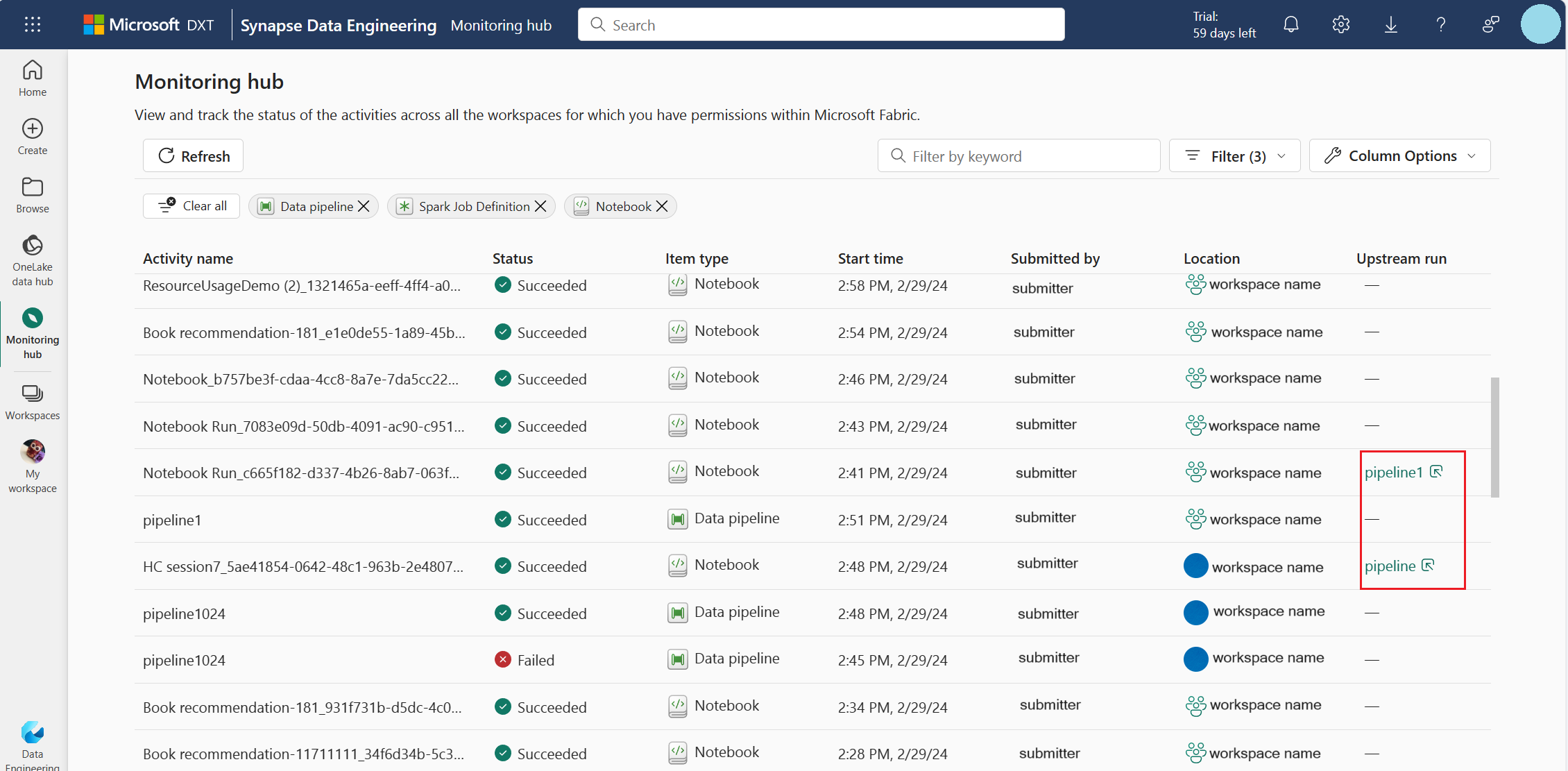

Activer la vue en amont pour les pipelines associés

Si vous avez planifié l’exécution de notebooks et de définitions de travaux Spark dans des pipelines, vous pouvez voir les activités Spark de ces notebooks et définitions de travaux Spark dans le hub de supervision. En outre, vous pouvez également voir le pipeline parent correspondant et toutes ses activités dans le Hub de surveillance.

- Sélectionnez l'option de colonne Exécution en amont.

- Affichez le cycle de pipeline parent associé dans la colonne Exécution en amont, et cliquez sur l’exécution de pipeline pour afficher toutes ses activités.

Gérer une application Apache Spark

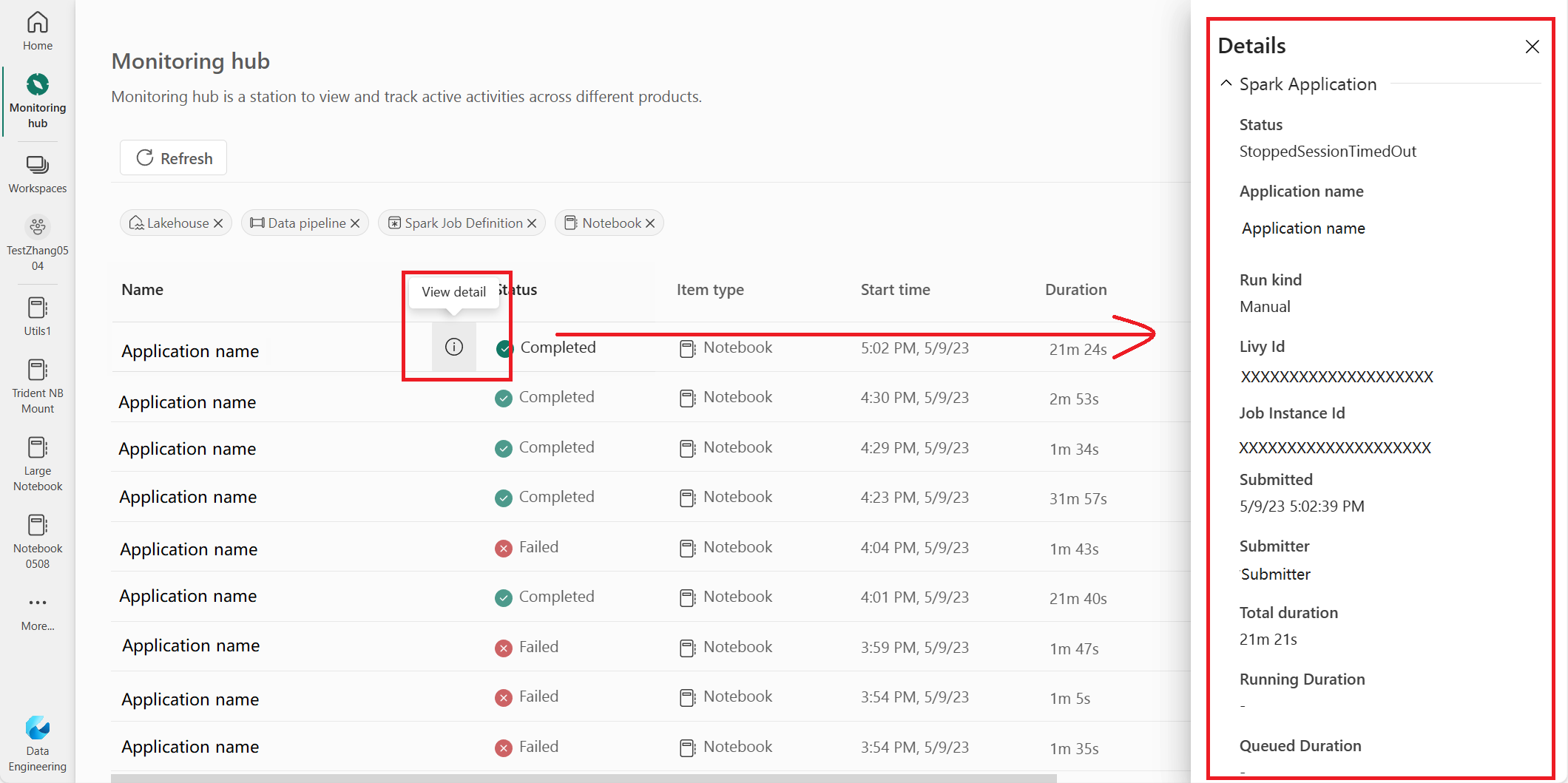

Lorsque vous pointez sur une ligne d’application Apache Spark, vous pouvez voir différentes actions au niveau des lignes qui vous permettent de gérer une application Apache Spark particulière.

Afficher le volet Détails de l’application Apache Spark

Vous pouvez pointer sur une ligne d’application Apache Spark et cliquer sur l’icône Afficher les détails pour ouvrir le volet Détails et afficher plus de détails sur une application Apache Spark.

Annuler une application Apache Spark

Si vous devez annuler une application Apache Spark en cours, pointez sur sa ligne et cliquez sur l’icône Annuler.

Accédez à la vue Détails de l’application Apache Spark

Si vous avez besoin d’informations supplémentaires sur les statistiques d’exécution Apache Spark, accéder aux journaux Apache Spark ou vérifier les données d’entrée et de sortie, vous pouvez cliquer sur le nom d’une application Apache Spark pour accéder à sa page Détails de l’application Apache Spark correspondante.