Déployer et gérer des instances locales Azure dans VMM

Cet article fournit des informations sur la configuration d’une instance locale Azure dans System Center Virtual Machine Manager (VMM). Vous pouvez déployer une instance locale Azure en approvisionnant à partir de serveurs nus ou en ajoutant des hôtes existants. En savoir plus sur le nouveau local Azure.

VMM 2022 prend en charge Azure Local version 22H2 (prise en charge à partir de VMM 2022 UR1).

VMM 2019 Update Rollup 3 (UR3) prend en charge Azure Stack HCI version 20H2. Le produit actuel est Azure Local, version 23H2.

Important

Les instances locales Azure gérées par Virtual Machine Manager ne doivent pas encore joindre le canal en préversion. System Center (y compris Virtual Machine Manager, Operations Manager et d’autres composants) ne prend actuellement pas en charge les versions en préversion d’Azure Local. Pour connaître les dernières mises à jour, consultez le blog System Center.

Avant de commencer

Vérifiez que vous exécutez VMM 2019 UR3 ou version ultérieure.

Qu’est-ce qui est pris en charge ?

Ajout, création et gestion d’instances locales Azure. Consultez les étapes détaillées pour créer et gérer des instances locales Azure.

Possibilité de provisionner et de déployer des machines virtuelles sur les instances locales Azure et d’effectuer des opérations de cycle de vie des machines virtuelles. Les machines virtuelles peuvent être approvisionnées à l’aide de fichiers VHD(x), de modèles ou d’une machine virtuelle existante. Plus d’informations

Configurer un réseau VLAN sur des instances locales dans Azure.

Déploiement et gestion du contrôleur de réseau SDN sur les instances locales Azure.

Gestion des paramètres du pool de stockage, création de disques virtuels, création de volumes partagés de cluster (CSV) et application des paramètres QoS.

Le déplacement de machines virtuelles entre Windows Server et les instances locales Azure fonctionne via la migration réseau et la migration d’une machine virtuelle hors connexion (arrêtée). Dans ce scénario, VMM exporte et importe sous le capot, même si elle est effectuée en tant qu’opération unique.

Les applets de commande PowerShell utilisées pour gérer les clusters Windows Server peuvent également être utilisées pour gérer des instances locales Azure.

Vérifiez que vous exécutez VMM 2022 UR1 ou version ultérieure.

Qu’est-ce qui est pris en charge ?

Ajout, création et gestion d’instances locales Azure. Consultez les étapes détaillées pour créer et gérer des instances locales Azure.

Possibilité de provisionner et de déployer des machines virtuelles sur les instances locales Azure et d’effectuer des opérations de cycle de vie des machines virtuelles. Les machines virtuelles peuvent être approvisionnées à l’aide de fichiers VHD(x), de modèles ou d’une machine virtuelle existante. Plus d’informations

Configurer un réseau basé sur VLAN sur les instances locales d'Azure.

Déploiement et gestion du contrôleur de réseau SDN sur les instances locales Azure.

Gestion des paramètres du pool de stockage, création de disques virtuels, création de volumes partagés de cluster (CSV) et application des paramètres QoS.

Le déplacement de machines virtuelles entre Windows Server et les instances locales Azure fonctionne via la migration réseau et la migration d’une machine virtuelle hors connexion (arrêtée). Dans ce scénario, VMM exporte et importe sous le capot, même si elle est effectuée en tant qu’opération unique.

Les applets de commande PowerShell utilisées pour gérer les clusters Windows Server peuvent également être utilisées pour gérer des instances locales Azure.

Inscrire et annuler l’inscription d’instances locales Azure

Avec VMM 2022, nous présentons les applets de commande PowerShell VMM pour inscrire et annuler l’inscription d’instances Locales Azure.

Utilisez les applets de commande suivantes pour inscrire des instances locales Azure :

Register-SCAzStackHCI -VMHostCluster <HostCluster> -SubscriptionID <string>

Utilisez la commande suivante pour désinscrire un cluster :

Unregister-SCAzStackHCI -VMHostCluster <HostCluster> -SubscriptionID <string>

Pour plus d’informations sur le paramètre pris en charge, consultez Register-SCAzStackHCI et Unregister-SCAzStackHCI.

Qu’est-ce qui n’est pas pris en charge ?

La gestion des clusters étendus Azure Local n’est actuellement pas prise en charge dans VMM.

Les machines locales Azure sont conçues comme des hôtes de virtualisation où vous exécutez toutes vos charges de travail dans des machines virtuelles. Les termes locaux Azure vous permettent d’exécuter uniquement ce qui est nécessaire pour l’hébergement de machines virtuelles. Les instances locales Azure ne doivent pas être utilisées à d’autres fins telles que les serveurs WSUS, les serveurs WDS ou les serveurs de bibliothèque. Reportez-vous aux cas d’utilisation pour Azure Local, Quand utiliser Azure Localet Rôles que vous pouvez exécuter sans virtualiser.

La migration dynamique entre une version de Windows Server et des instances locales Azure n’est pas prise en charge.

Remarque

La migration dynamique entre les instances locales Azure fonctionne, ainsi qu’entre les clusters Windows Server.

- Le seul type de stockage disponible pour Azure Local est Les espaces de stockage direct (S2D). La création ou la gestion d’un cluster non-S2D avec des machines locales Azure n’est pas prise en charge. Si vous avez besoin d’utiliser un autre type de stockage, par exemple des réseaux SAN, utilisez Windows Server comme hôte de virtualisation.

Remarque

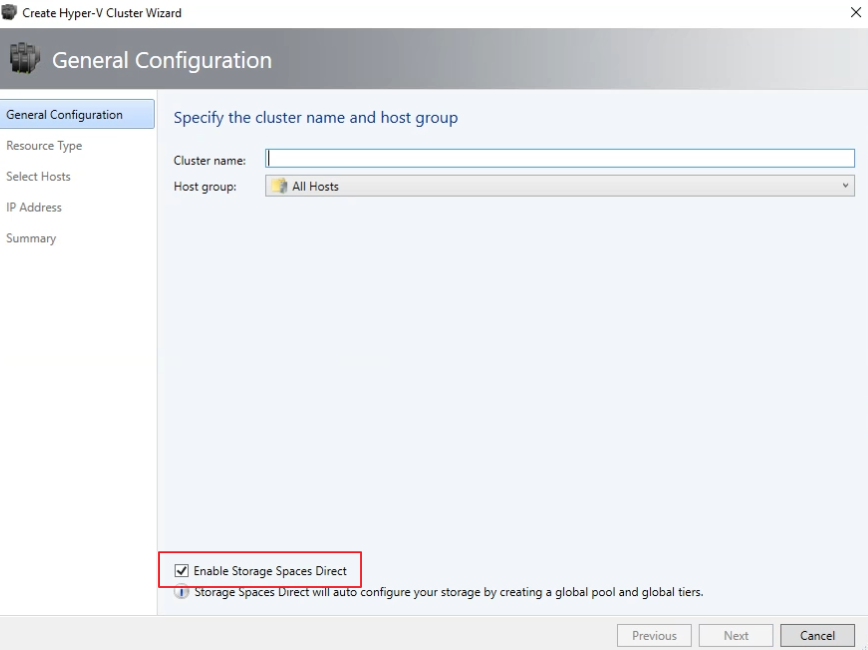

Vous devez activer S2D lors de la création d’une instance locale Azure. Pour activer S2D, dans l’Assistant Création de cluster, accédez à Configuration générale. Sous Spécifier le nom du cluster et le groupe hôte, sélectionnez Activer espaces de stockage direct, comme indiqué ci-dessous :

Après avoir activé un cluster avec S2D, VMM effectue les opérations suivantes :

- La fonctionnalité clustering de basculement est activée.

- Le réplica de stockage et la déduplication des données sont activés.

- Le cluster est éventuellement validé et créé.

- S2D est activé, et un objet de baie de stockage portant le nom que vous avez fourni dans l’Assistant est créé dans VMM.

Lorsque vous utilisez VMM pour créer un cluster hyperconvergé, le pool et les niveaux de stockage sont automatiquement créés en exécutant Enable-ClusterStorageSpacesDirect -Autoconfig $True.

Une fois ces prérequis en place, vous provisionnez un cluster et configurez des ressources de stockage sur celui-ci. Vous pouvez ensuite déployer des machines virtuelles sur le cluster.

Effectuez les étapes suivantes :

Étape 1 : Provisionner le cluster

Vous pouvez approvisionner un cluster par des hôtes Hyper-V et des machines nues :

Provisionner un cluster à partir d’hôtes Hyper-V

Si vous devez ajouter les machines locales Azure à l’infrastructure VMM, suivez ces étapes. S’ils se trouvent déjà dans l’infrastructure VMM, passez à l’étape suivante.

Remarque

- Lorsque vous configurez le cluster, sélectionnez l’option Activer espaces de stockage direct dans la page Configuration générale de l’Assistant Création d’un cluster Hyper-V.

- Dans Type de ressource, sélectionnez Serveurs existants exécutant un système d’exploitation Windows Server, puis sélectionnez les hôtes Hyper-V à ajouter au cluster.

- Tous les hôtes sélectionnés doivent avoir installé Azure Local.

- Étant donné que S2D est activé, le cluster doit être validé.

Provisionner un cluster à partir de machines nues

Remarque

En règle générale, le nœud S2D nécessite des paramètres RDMA, QoS et SET. Pour configurer ces paramètres pour un nœud à l’aide d’ordinateurs nus, vous pouvez utiliser la fonctionnalité de script post-déploiement dans PCP. Voici l’exemple de script de post-déploiement PCP. Vous pouvez également utiliser ce script pour configurer RDMA, QoS et SET tout en ajoutant un nouveau nœud à un déploiement S2D existant à partir d’ordinateurs nus.

- Lisez les conditions préalables pour le déploiement de cluster nu.

Remarque

- Le disque dur virtuel généralisé ou VHDX dans la bibliothèque VMM doit exécuter Azure Stack HCI avec les dernières mises à jour. Les valeurs du système d’exploitation et de la plateforme de virtualisation pour le disque dur doivent être définies.

- Pour le déploiement nu, vous devez ajouter un serveur d’environnement d’exécution de pré-démarrage (PXE) à l’infrastructure VMM. Le serveur PXE est fourni via les services de déploiement Windows. VMM utilise sa propre image WinPE et vous devez vous assurer qu’elle est la plus récente. Pour ce faire, sélectionnez >l’image WinPE de mise à jour de l’infrastructure fabric>et vérifiez que le travail se termine.

- Suivez les instructions pour provisionner un cluster à partir d’ordinateurs nus.

Étape 2 : Configurer la mise en réseau du cluster

Une fois le cluster approvisionné et géré dans l’infrastructure VMM, vous devez configurer la mise en réseau pour les nœuds de cluster.

- Commencez par créer un réseau logique pour mettre en miroir votre réseau de gestion physique.

- Vous devez configurer un commutateur logique avec Switch Embedded Teaming (SET) activé afin que le commutateur soit conscient de la virtualisation. Ce commutateur est connecté au réseau logique de gestion et dispose de toutes les cartes virtuelles hôtes, qui sont nécessaires pour fournir l’accès au réseau de gestion ou configurer la mise en réseau de stockage. S2D s’appuie sur un réseau pour communiquer entre les hôtes. Les adaptateurs compatibles RDMA sont recommandés.

- Créez des réseaux de machines virtuelles.

Étape 3 : Configurer les paramètres DCB sur l’instance locale Azure

Remarque

La configuration des paramètres DCB est une étape facultative pour obtenir des performances élevées pendant le flux de travail de création de cluster S2D. Passez à l’étape 4 si vous ne souhaitez pas configurer les paramètres DCB.

Recommandations

Si vous avez déployé des cartes réseau virtuelles, pour des performances optimales, nous vous recommandons de mapper tous vos cartes réseau virtuelles avec les cartes réseau virtuelles correspondantes. Les affinités entre la carte réseau virtuelle et la carte réseau réseau sont définies de manière aléatoire par le système d’exploitation, et il peut y avoir des scénarios où plusieurs cartes réseau virtuelles sont mappées à la même carte réseau. Pour éviter de tels scénarios, nous vous recommandons de définir manuellement l’affinité entre la carte réseau virtuelle et la carte réseau pNIC en suivant les étapes répertoriées ici.

Lorsque vous créez un profil de port de carte réseau, nous vous recommandons d’autoriser la priorité IEEE. Plus d’informations

Vous pouvez également définir la priorité IEEE à l’aide des commandes PowerShell suivantes :

Set-VMNetworkAdapterVlan -VMNetworkAdapterName 'SMB2' -VlanId '101' -Access -ManagementOS Set-VMNetworkAdapter -ManagementOS -Name 'SMB2' -IeeePriorityTag on

Pour configurer les paramètres DCB, procédez comme suit :

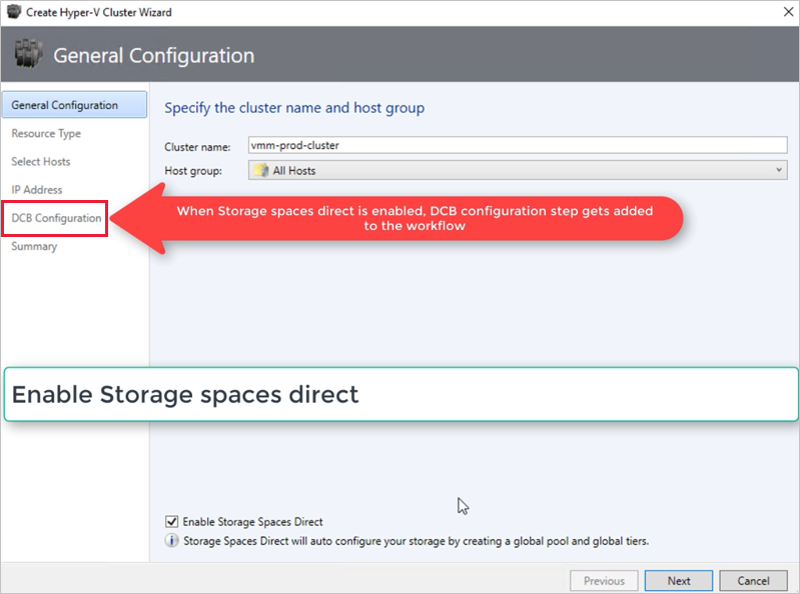

Créez un cluster Hyper-V, sélectionnez Activer espaces de stockage direct. L’option configuration DCB est ajoutée au flux de travail de création de cluster Hyper-V.

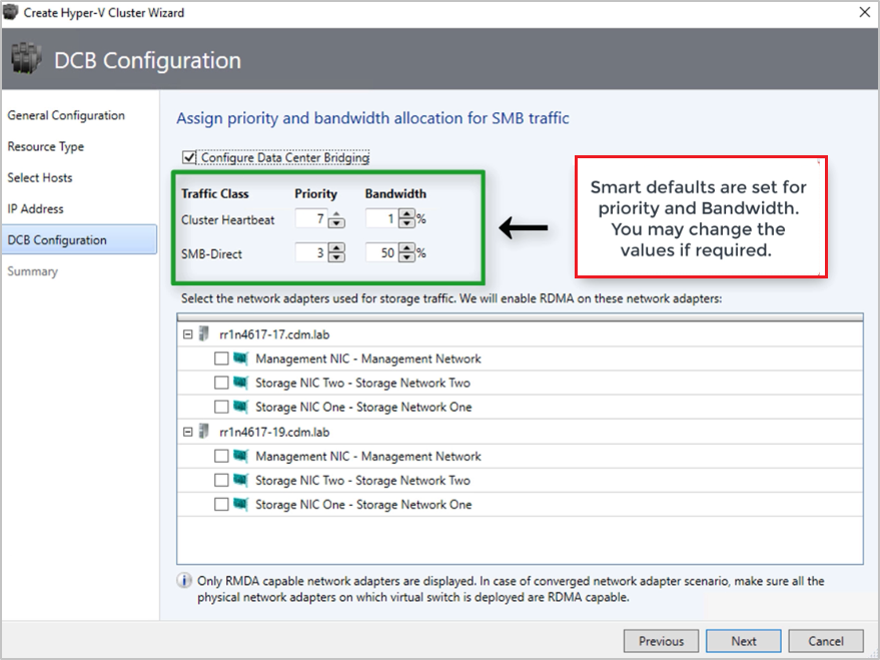

Dans la configuration DCB, sélectionnez Configurer le pontage du centre de données.

Fournissez des valeurs de priorité et de bande passante pour le trafic SMB-Direct et Cluster Heartbeat.

Remarque

Les valeurs par défaut sont affectées à Priority et à Bande passante. Personnalisez ces valeurs en fonction des besoins de l’environnement de votre organisation.

Valeurs par défaut :

| Classe de trafic | Priorité | Bande passante (%) |

|---|---|---|

| Pulsation du cluster | 7 | 1 |

| SMB-Direct | 3 | 50 |

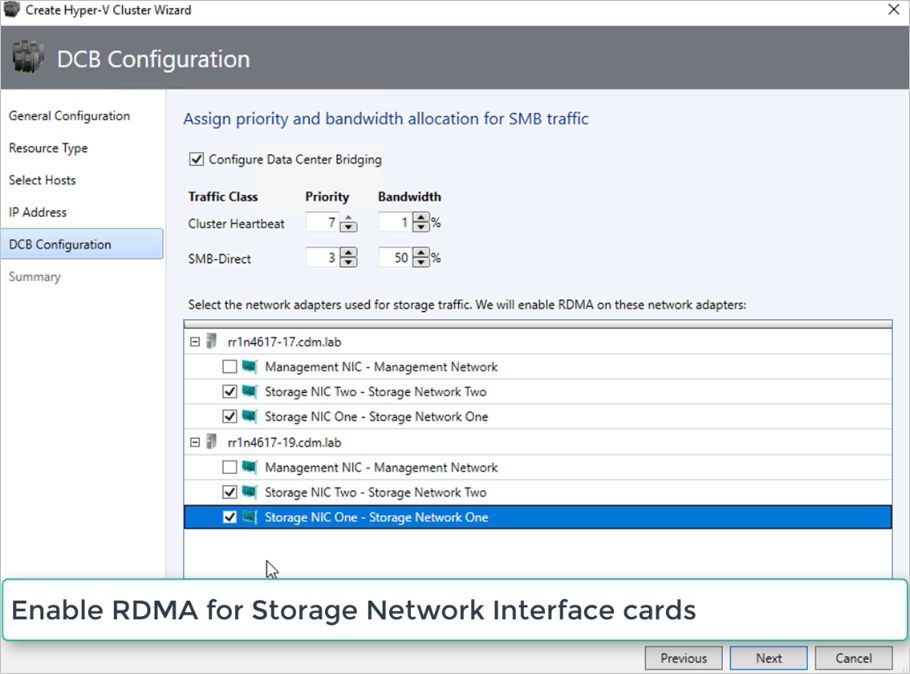

Sélectionnez les cartes réseau utilisées pour le trafic de stockage. RDMA est activé sur ces cartes réseau.

Remarque

Dans un scénario de carte réseau convergée, sélectionnez les cartes réseau virtuelles de stockage. Les cartes réseau sous-jacentes doivent être compatibles RDMA pour que les cartes réseau virtuelles soient affichées et disponibles pour la sélection.

Vérifiez le résumé et sélectionnez Terminer.

Une instance locale Azure est créée et les paramètres DCB sont configurés sur tous les nœuds S2D.

Remarque

- Les paramètres DCB peuvent être configurés sur les clusters Hyper-V S2D existants en accédant à la page Propriétés du cluster et en accédant à la page de configuration DCB.

- Toute modification hors bande des paramètres DCB sur l’un des nœuds entraîne la non-conformité du cluster S2D dans VMM. Une option de correction est fournie dans la page de configuration DCB des propriétés du cluster, que vous pouvez utiliser pour appliquer les paramètres DCB configurés dans VMM sur les nœuds du cluster.

Étape 4 : Inscrire une instance locale Azure auprès d’Azure

Après avoir créé une instance locale Azure, elle doit être inscrite auprès d’Azure dans les 30 jours suivant les conditions d’installation d’Azure Online Service. Si vous utilisez System Center 2022, utilisez Register-SCAzStackHCI applet de commande dans VMM pour inscrire l’instance locale Azure auprès d’Azure. Vous pouvez également suivre ces étapes pour inscrire l’instance locale Azure auprès d’Azure.

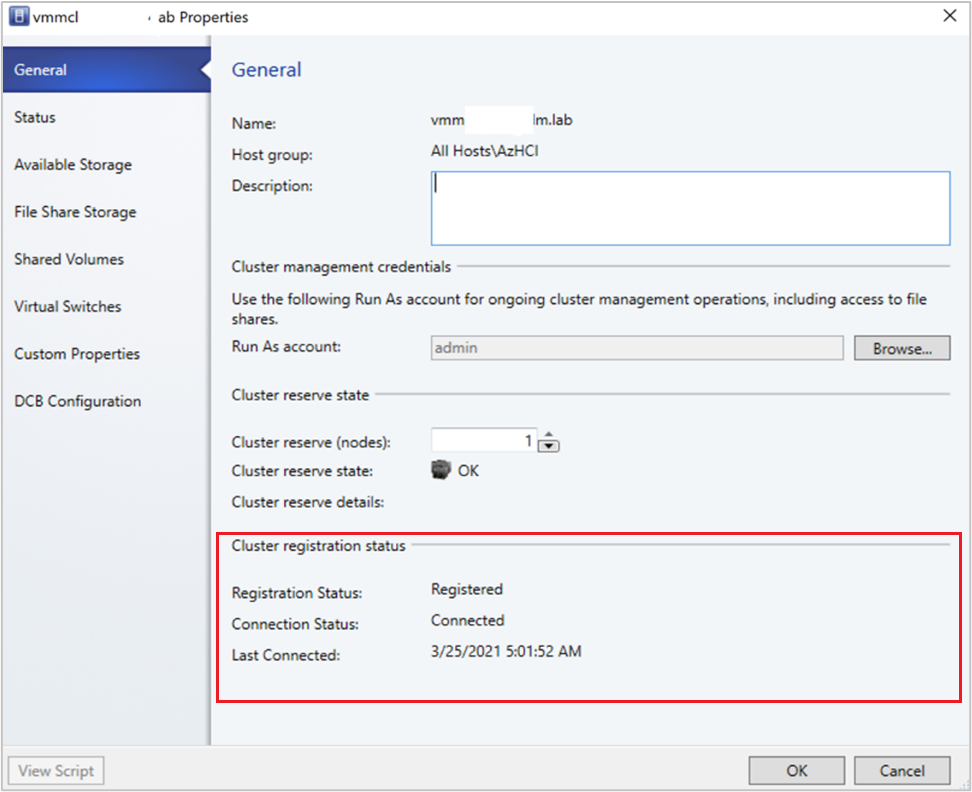

L’état d’inscription reflète dans VMM après une actualisation réussie du cluster.

Étape 5 : Afficher l’état d’inscription des instances Azure Stack HCI

Dans la console VMM, vous pouvez afficher l’état de l’inscription et la date de dernière connexion des clusters Azure Stack HCI.

Sélectionnez Fabric, cliquez avec le bouton droit sur le cluster Azure Stack HCI , puis sélectionnez Propriétés.

Vous pouvez également exécuter

Get-SCVMHostet observer les propriétés de l’objet retourné pour vérifier l’état de l’inscription.

Étape 6 : Gérer le pool et créer des CSV

Vous pouvez maintenant modifier les paramètres du pool de stockage et créer des disques virtuels et des CSV.

Sélectionnez Tableaux de stockage>Fabric.>

Cliquez avec le bouton droit sur le cluster >Gérer le pool, puis sélectionnez le pool de stockage qui a été créé par défaut. Vous pouvez modifier le nom par défaut et ajouter une classification.

Pour créer un volume partagé de cluster, cliquez avec le bouton droit sur le cluster, >Propriétés>Volumes partagés.

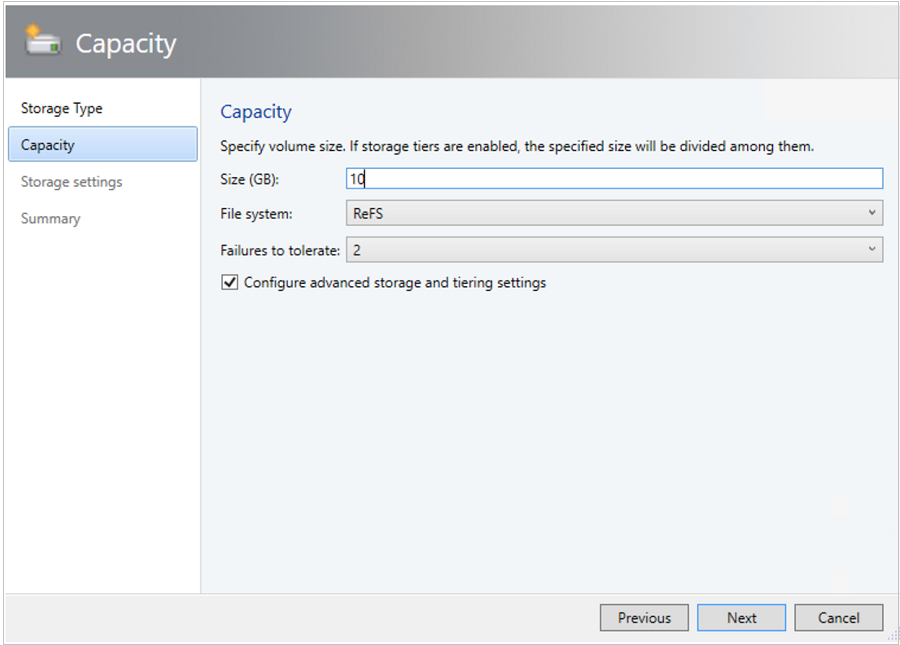

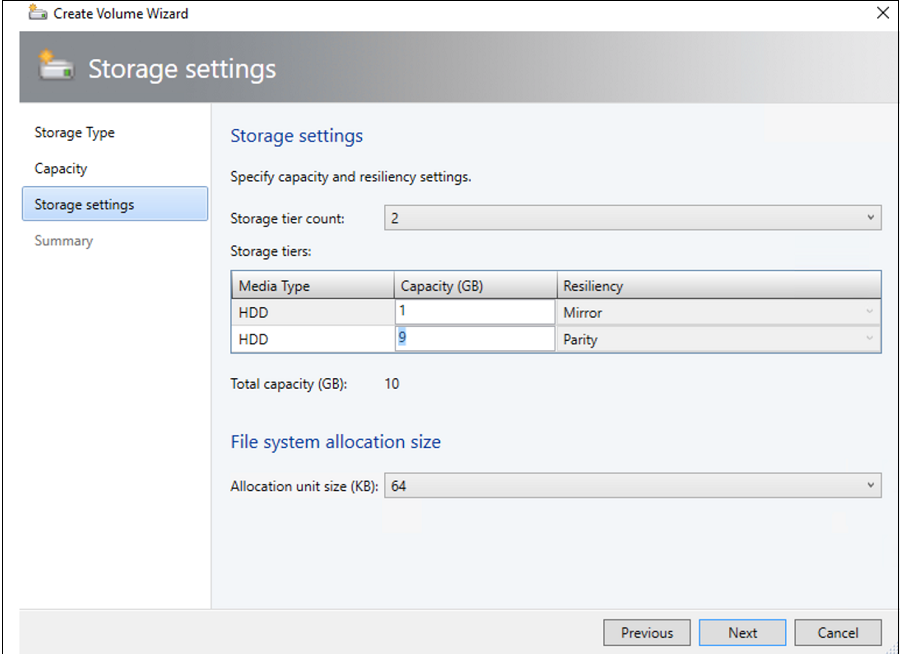

Dans le type de stockage De l’Assistant >Création de volume, spécifiez le nom du volume et sélectionnez le pool de stockage.

En capacité, vous pouvez spécifier la taille du volume, le système de fichiers et les paramètres de résilience (échecs à tolérer). Sélectionnez Configurer les paramètres de stockage et de hiérarchisation avancés pour configurer ces options.

Dans les paramètres de stockage, vous pouvez spécifier le fractionnement, la capacité et la résilience du niveau de stockage.

Dans Résumé, vérifiez les paramètres et terminez l’Assistant. Un disque virtuel est créé automatiquement lorsque vous créez le volume.

Étape 7 : Déployer des machines virtuelles sur le cluster

Dans une topologie hyperconvergée, les machines virtuelles peuvent être déployées directement sur le cluster. Leurs disques durs virtuels sont placés sur les volumes que vous avez créés à l’aide de S2D. Vous créez et déployez ces machines virtuelles comme vous le feriez pour n’importe quelle autre machine virtuelle.

Important

Si l’instance locale Azure n’est pas inscrite auprès d’Azure ou n’est pas connectée à Azure pendant plus de 30 jours après l’inscription, la création de machine virtuelle haute disponibilité (HAVM) est bloquée sur le cluster. Reportez-vous à l’étape 4 et 5 pour l’inscription du cluster.

Étape 8 : Migrer des machines virtuelles de Windows Server vers une instance locale Azure

Utilisez la fonctionnalité de migration réseau dans VMM pour migrer des charges de travail d’Hyper-V (Windows Server 2019 et versions ultérieures) vers Azure Stack HCI.

Remarque

La migration dynamique entre Windows Server et Azure Local n’est pas prise en charge. La migration réseau d’Azure Local vers Windows Server n’est pas prise en charge.

- Désactivez temporairement la migration dynamique sur l’hôte local Azure de destination.

- Sélectionnez machines virtuelles et services>tous les hôtes, puis sélectionnez l’hôte Hyper-V source à partir duquel vous souhaitez migrer.

- Sélectionnez la machine virtuelle à migrer. La machine virtuelle doit être dans un état désactivé.

- Sélectionnez Migrer une machine virtuelle.

- Dans Sélectionner l’hôte, passez en revue et sélectionnez l’hôte local Azure de destination.

- Sélectionnez Suivant pour lancer la migration réseau. VMM effectuera des importations et des exportations au serveur principal.

- Pour vérifier que la machine virtuelle est correctement migrée, vérifiez la liste des machines virtuelles sur l’hôte de destination. Activez la machine virtuelle et réactivez la migration dynamique sur l’hôte local Azure.

Étape 9 : Migrer des charges de travail VMware vers une instance locale Azure à l’aide de SCVMM

VMM offre une expérience simple basée sur l’Assistant pour la conversion V2V (virtuelle en virtuelle). Vous pouvez utiliser l’outil de conversion pour migrer des charges de travail à grande échelle de l’infrastructure VMware vers l’infrastructure Hyper-V. Pour obtenir la liste des serveurs VMware pris en charge, consultez configuration système requise.

Pour connaître les conditions préalables et les limitations de la conversion, consultez Convertir une machine virtuelle VMware en Hyper-V dans l’infrastructure VMM.

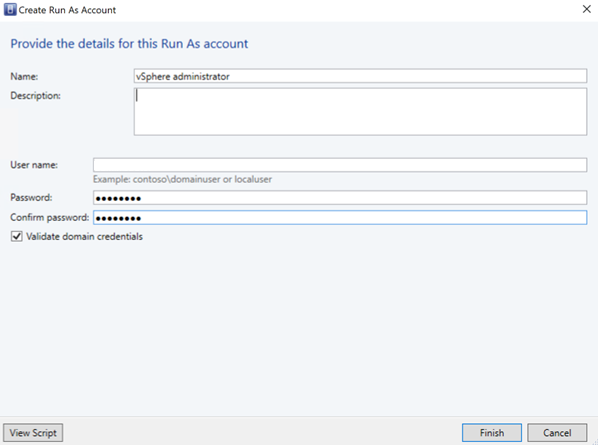

Créez un compte d’identification pour le rôle Administrateur de serveur vCenter dans VMM. Ces informations d’identification d’administrateur sont utilisées pour gérer le serveur vCenter et les hôtes ESXi.

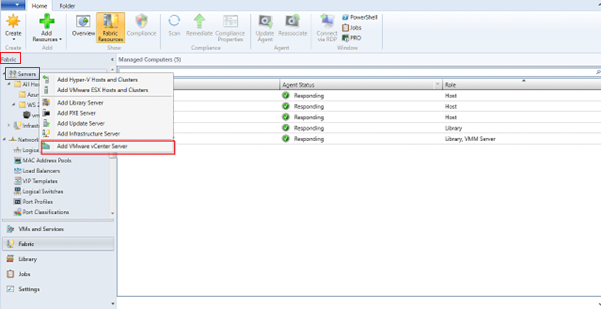

Dans la console VMM, sous Fabric, sélectionnez Serveurs>Ajouter VMware vCenter Server.

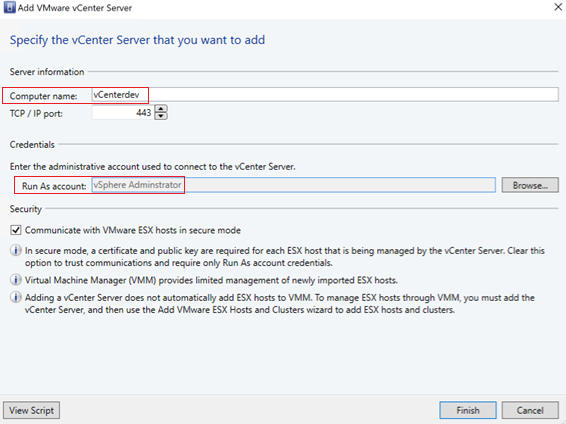

Dans la page Ajouter VMware vCenter Server , procédez comme suit :

Nom de l’ordinateur : spécifiez le nom du serveur vCenter.

Compte d’identification : sélectionnez le compte d’identification créé pour l’administrateur vSphere.

Sélectionnez Terminer.

Dans la page Importer un certificat , sélectionnez Importer.

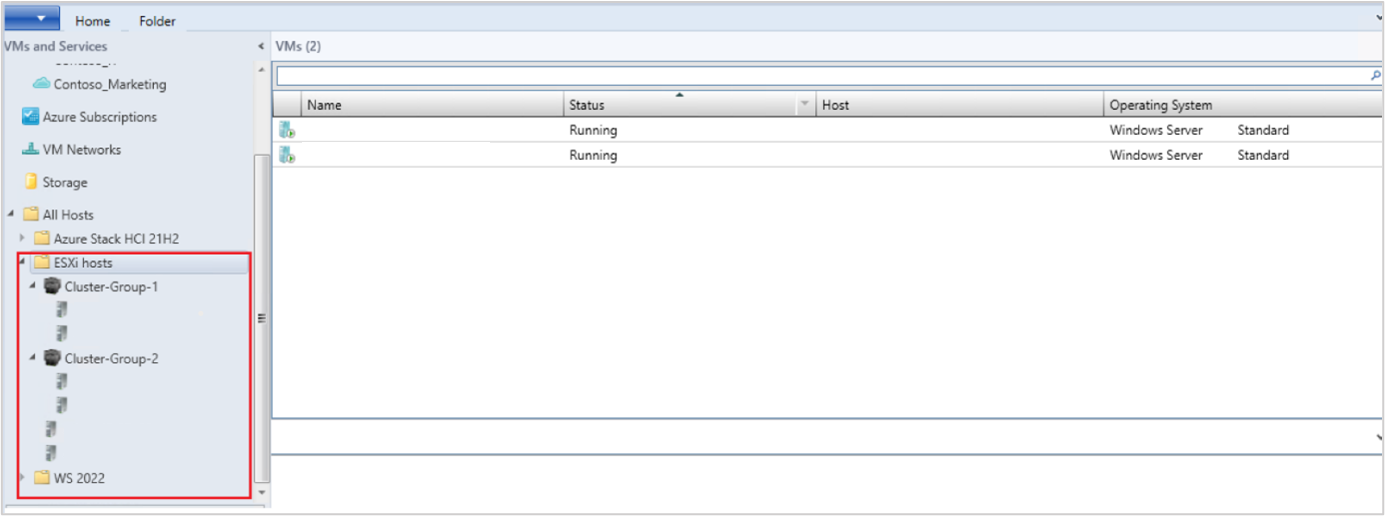

Une fois l’ajout réussi du serveur vCenter, tous les hôtes ESXi sous le vCenter sont migrés vers VMM.

Ajouter des hôtes

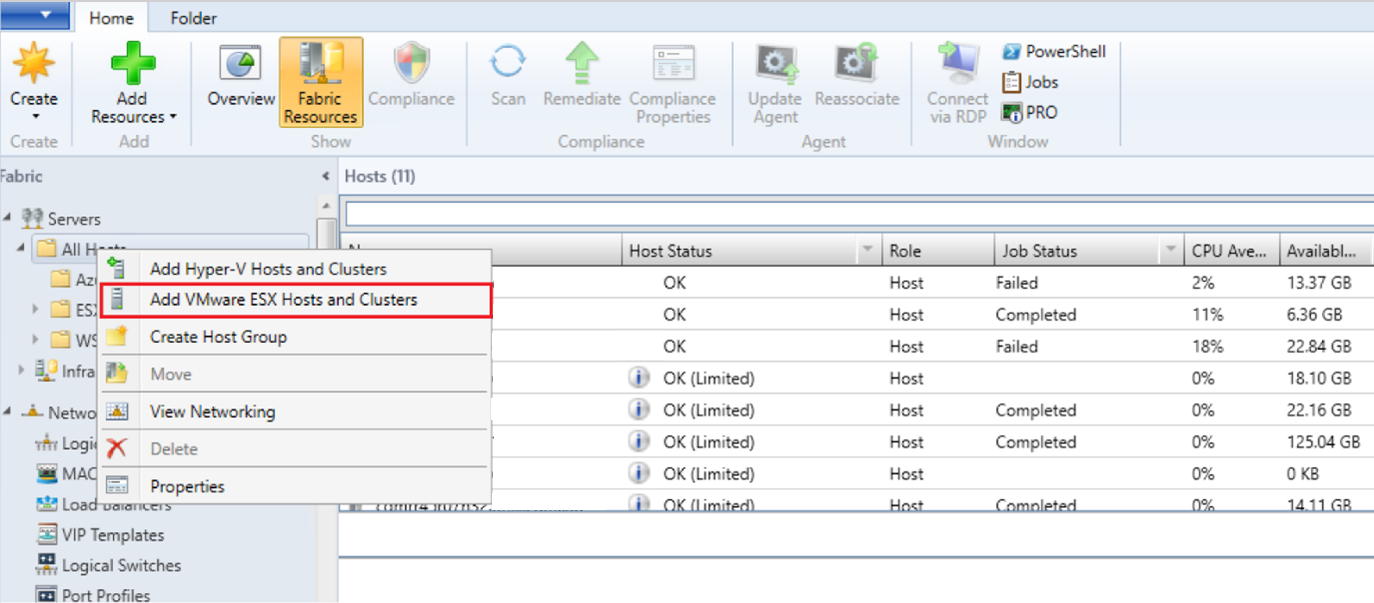

- Dans la console VMM, sous Fabric, sélectionnez Serveurs>Ajouter des hôtes et clusters VMware ESX.

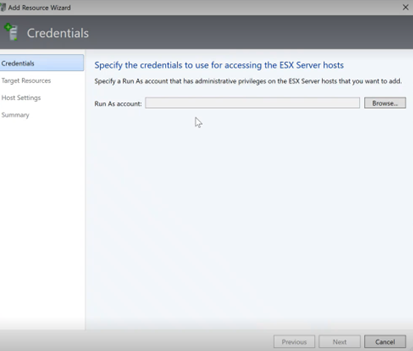

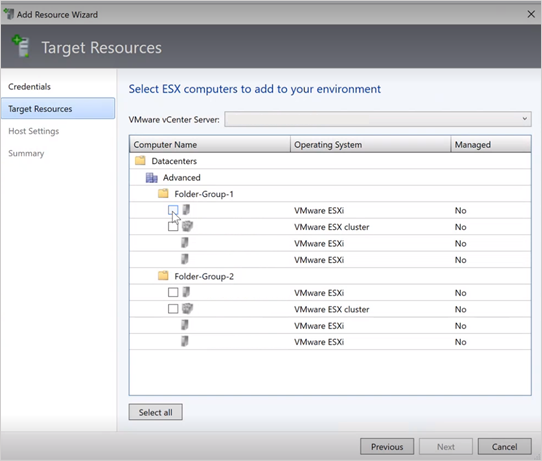

- Dans l’Assistant Ajouter une ressource,

Sous Informations d’identification, sélectionnez le compte d’identification utilisé pour le port, puis sélectionnez Suivant.

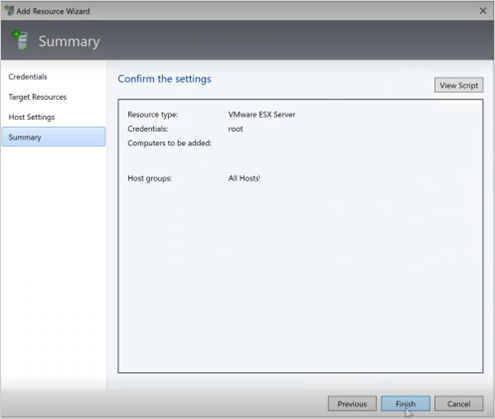

Sous Ressources cibles, sélectionnez tous les clusters ESX qui doivent être ajoutés à VMM, puis sélectionnez Suivant.

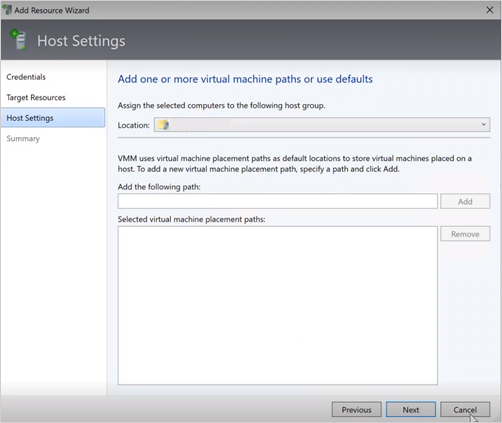

Sous Paramètres de l’hôte, sélectionnez l’emplacement où vous souhaitez ajouter les machines virtuelles, puis sélectionnez Suivant.

Sous Résumé, passez en revue les paramètres et sélectionnez Terminer. En plus des hôtes, les machines virtuelles associées sont également ajoutées.

Vérifier l’état de l’hôte ESXi

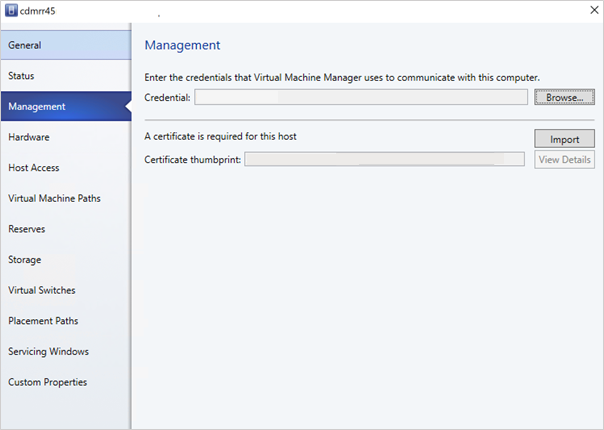

Si l’état de l’hôte ESXi correspond à OK (Limité), cliquez avec le bouton droit sur Gestion des propriétés>, sélectionnez Exécuter en tant que compte utilisé pour le port et importez les certificats pour l’hôte.

Répétez le même processus pour tous les hôtes ESXi.

Après avoir ajouté les clusters ESXi, toutes les machines virtuelles exécutées sur les clusters ESXi sont découvertes automatiquement dans VMM.

Afficher les machines virtuelles

Accédez aux machines virtuelles et services pour afficher les machines virtuelles. Vous pouvez également gérer les opérations de cycle de vie principales de ces machines virtuelles à partir de VMM.

Cliquez avec le bouton droit sur la machine virtuelle et sélectionnez Désactiver (les migrations en ligne ne sont pas prises en charge) qui doivent être migrées et désinstallez les outils VMware du système d’exploitation invité.

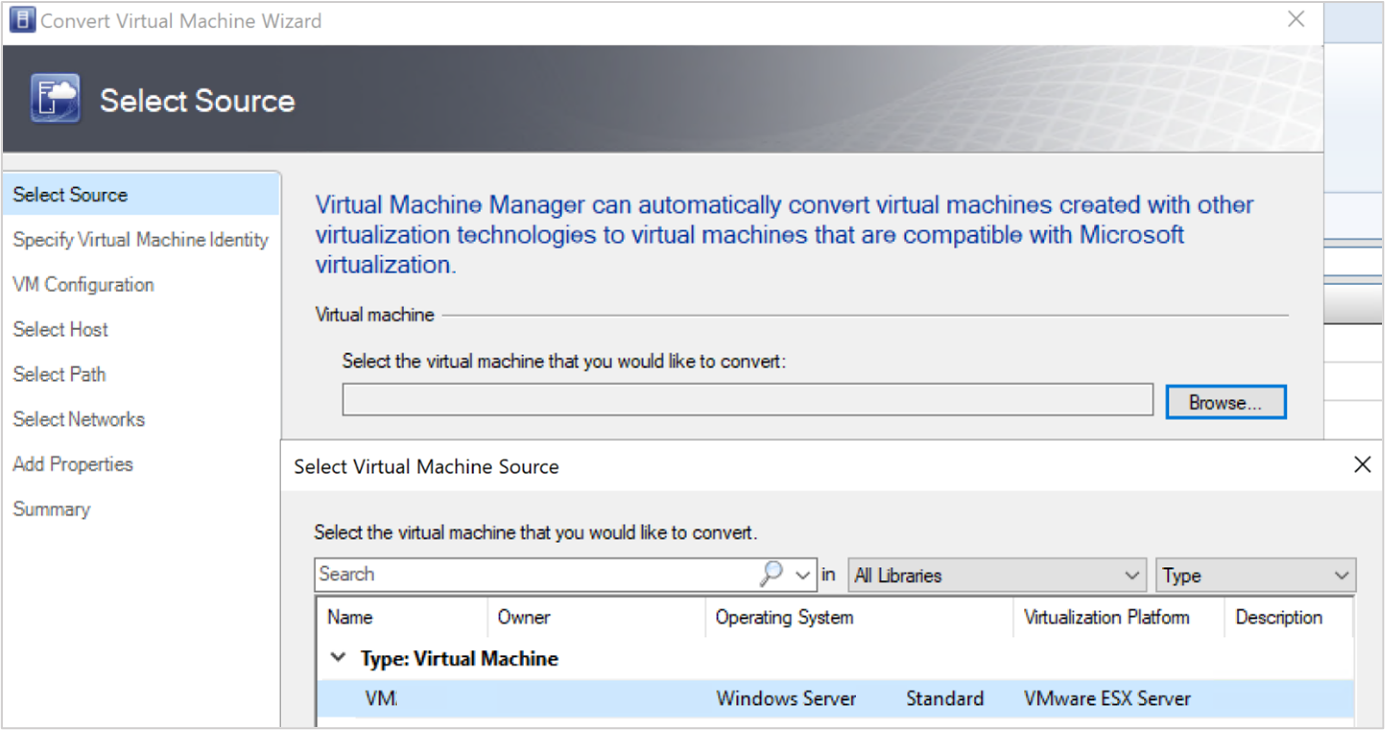

Sélectionnez Home>Create Machines Virtuelles> Convert Virtual Machine.

Dans l’Assistant Conversion de machine virtuelle,

- Sous Sélectionner la source, sélectionnez la machine virtuelle s’exécutant sur le serveur ESXi, puis sélectionnez Suivant.

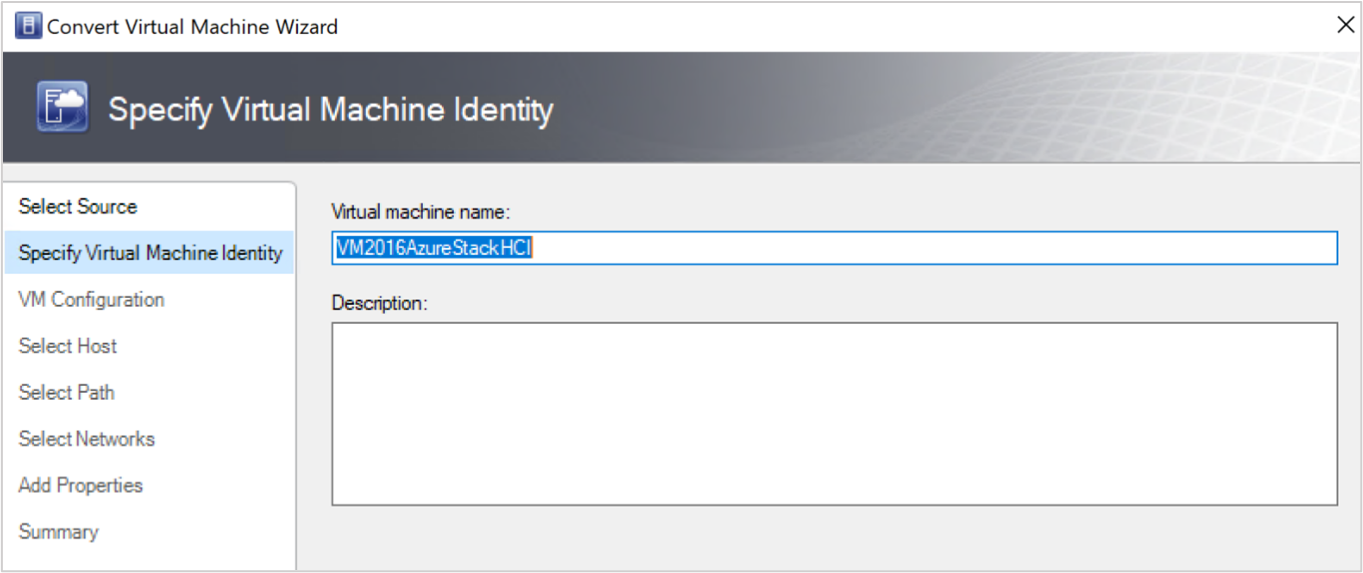

- Sous Spécifier l’identité de machine virtuelle, entrez le nouveau nom de la machine virtuelle si vous souhaitez et sélectionnez Suivant.

- Sous Sélectionner la source, sélectionnez la machine virtuelle s’exécutant sur le serveur ESXi, puis sélectionnez Suivant.

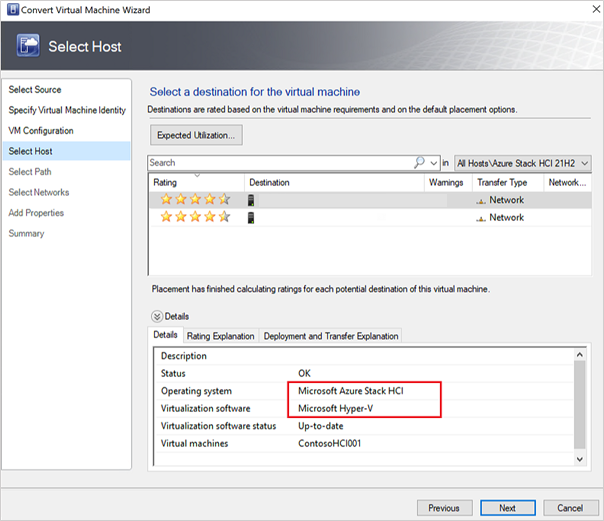

Sous Sélectionner l’hôte, sélectionnez la machine locale Azure cible et spécifiez l’emplacement sur l’hôte pour les fichiers de stockage de machine virtuelle, puis sélectionnez suivant.

Sélectionnez un réseau virtuel pour la machine virtuelle, puis sélectionnez Créer pour terminer la migration.

La machine virtuelle s’exécutant sur le cluster ESXi est correctement migrée vers l’instance locale Azure. Pour l’automatisation, utilisez des commandes PowerShell pour la conversion.