Acquisire dati da Hub eventi in formato Parquet

Questo articolo illustra come usare l'editor di codice per acquisire automaticamente i dati di streaming in Hub eventi in un account Azure Data Lake Storage Gen2 in formato Parquet.

Prerequisiti

Uno spazio dei nomi Hub eventi di Azure con un hub eventi e un account Azure Data Lake Storage Gen2 con un contenitore per archiviare i dati acquisiti. Queste risorse devono essere accessibili pubblicamente e non possono essere protette da un firewall o protette in una rete virtuale di Azure.

Se non si ha un hub eventi, crearne uno seguendo le istruzioni riportate in Avvio rapido: Creare un hub eventi.

Se non si ha un account Data Lake Storage Gen2, crearne uno seguendo le istruzioni riportate in Creare un account di archiviazione

I dati negli hub eventi devono essere serializzati in formato JSON, CSV o Avro. A scopo di test, selezionare Genera dati (anteprima) nel menu a sinistra, selezionare Stock data for dataset (Dati titoli per set di dati) e quindi selezionare Invia.

Configurare un processo per acquisire i dati

Usare la procedura seguente per configurare un processo di Analitica Stream per acquisire i dati in Azure Data Lake Storage Gen2.

Nella portale di Azure passare all'hub eventi.

Nel menu a sinistra selezionare Elabora dati in Funzionalità. Selezionare quindi Avvia nella scheda Acquisisci dati in ADLS Gen2 in formato Parquet.

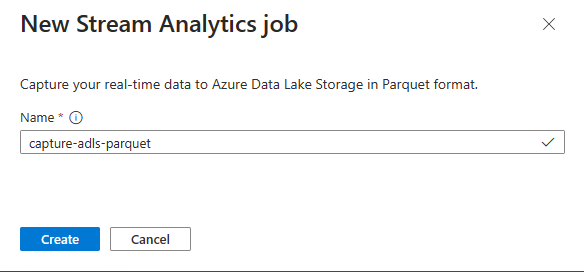

Immettere un nome per il processo di Analitica Stream e quindi selezionare Crea.

Specificare il tipo di serializzazione dei dati in Hub eventi e il metodo di autenticazione usato dal processo per connettersi a Hub eventi. Selezionare Connetti.

Quando la connessione viene stabilita correttamente, viene visualizzato quanto riportato di seguito:

Campi presenti nei dati di input. È possibile scegliere Aggiungi campo oppure selezionare il simbolo a tre punti accanto a un campo per rimuovere, rinominare o modificare il nome facoltativo.

Esempio live di dati in ingresso nella tabella Anteprima dati nella vista diagramma. Viene aggiornato periodicamente. È possibile selezionare Sospendi anteprima streaming per visualizzare una visualizzazione statica dell'input di esempio.

Selezionare il riquadro Azure Data Lake Storage Gen2 per modificare la configurazione.

Nella pagina di configurazione di Azure Data Lake Storage Gen2 seguire questa procedura:

Selezionare la sottoscrizione, il nome dell'account di archiviazione e il contenitore dal menu a discesa.

Dopo aver selezionato la sottoscrizione, il metodo di autenticazione e la chiave dell'account di archiviazione devono essere compilati automaticamente.

Selezionare Parquet per Formato di serializzazione .

Per i BLOB di streaming, è previsto che il modello di percorso della directory sia un valore dinamico. È necessario che la data faccia parte del percorso del file per il BLOB, a cui viene fatto riferimento come

{date}. Per informazioni sui modelli di percorso personalizzati, vedere Azure Stream Analitica partizionamento dell'output del BLOB personalizzato.Seleziona Connetti

Quando viene stabilita la connessione, vengono visualizzati i campi presenti nei dati di output.

Selezionare Salva sulla barra dei comandi per salvare la configurazione.

Selezionare Avvia sulla barra dei comandi per avviare il flusso di streaming per acquisire i dati. Quindi nella finestra avvia flusso Analitica processo:

Scegliere l'ora di inizio dell'output.

Selezionare il piano tariffario.

Selezionare il numero di unità di streaming (SU) con cui viene eseguito il processo. SU rappresenta le risorse di calcolo allocate per eseguire un processo di Analitica Stream. Per altre informazioni, vedere Unità di streaming in Azure Stream Analitica.

Il processo di Analisi di flusso dovrebbe essere visualizzato nella scheda Flusso Analitica processo della pagina Elabora dati per l'hub eventi.

Verificare l'output

Nella pagina dell'istanza di Hub eventi per l'hub eventi selezionare Genera dati, selezionare Dati titoli per il set di dati e quindi selezionare Invia per inviare alcuni dati di esempio all'hub eventi.

Verificare che i file Parquet vengano generati nel contenitore Azure Data Lake Storage.

Selezionare Elabora dati nel menu a sinistra. Passare alla scheda Flussi Analitica processi . Selezionare Apri metriche per monitorarla.

Ecco uno screenshot di esempio delle metriche che mostra gli eventi di input e output.

Considerazioni sull'uso della funzionalità di replica geografica di Hub eventi

Hub eventi di Azure recentemente lanciato il Funzionalità replica geografica in anteprima pubblica. Questa funzionalità è diversa dalla funzionalità ripristino di emergenza geografico di Hub eventi di Azure.

Quando il tipo di failover è Forzato e la coerenza della replica è Asincrona, flusso Analitica processo non garantisce esattamente una volta l'output in un output Hub eventi di Azure.

Flusso di Azure Analitica, come producer con un output di un hub eventi, potrebbe osservare un ritardo limite nel processo durante la durata del failover e durante la limitazione da parte di Hub eventi nel caso in cui il ritardo di replica tra primario e secondario raggiunga il ritardo massimo configurato.

Azure Stream Analitica, come consumer con Hub eventi come input, potrebbe osservare un ritardo limite nel processo durante la durata del failover e potrebbe ignorare i dati o trovare dati duplicati al termine del failover.

A causa di queste avvertenze, è consigliabile riavviare il processo di Analitica Stream con l'ora di inizio appropriata subito dopo il completamento del failover di Hub eventi. Inoltre, poiché la funzionalità di replica geografica di Hub eventi è in anteprima pubblica, non è consigliabile usare questo modello per i processi di stream di produzione Analitica a questo punto. Il comportamento corrente di Stream Analitica migliorerà prima che la funzionalità di replica geografica di Hub eventi sia disponibile a livello generale e possa essere usata nei processi di produzione di Stream Analitica.

Passaggi successivi

Ora si è appreso come usare Stream Analitica nessun editor di codice per creare un processo che acquisisce i dati di Hub eventi in Azure Data Lake Storage Gen2 in formato Parquet. Successivamente, è possibile ottenere altre informazioni su Analitica di Azure Stream e su come monitorare il processo creato.