Come visualizzare i risultati della valutazione in Studio AI della piattaforma Azure

Importante

Gli elementi contrassegnati (anteprima) in questo articolo sono attualmente disponibili in anteprima pubblica. Questa anteprima viene fornita senza un contratto di servizio e non è consigliabile per i carichi di lavoro di produzione. Alcune funzionalità potrebbero non essere supportate o potrebbero presentare funzionalità limitate. Per altre informazioni, vedere le Condizioni supplementari per l'uso delle anteprime di Microsoft Azure.

La pagina di valutazione di Studio AI della piattaforma Azure è un hub versatile che non solo consente di visualizzare e valutare i risultati, ma funge anche da centro di controllo per ottimizzare, risolvere i problemi e selezionare il modello di intelligenza artificiale ideale per le proprie esigenze di distribuzione. Si tratta di una soluzione unica per il processo decisionale basato sui dati e il miglioramento delle prestazioni nei progetti di Studio IA. È possibile accedere e interpretare facilmente i risultati di varie origini, tra cui il flusso, la sessione di test rapido del playground, l'interfaccia utente dell'invio della valutazione e l'SDK. Questa flessibilità garantisce che sia possibile interagire con i risultati in modo ottimale per il flusso di lavoro e le preferenze personali.

Dopo aver visualizzato i risultati della valutazione, è possibile eseguire un esame approfondito. Ciò include non solo la possibilità di visualizzare i singoli risultati, ma anche quella di confrontarli tra più esecuzioni della valutazione. In questo modo, è possibile identificare tendenze, modelli e discrepanze, ottenendo informazioni preziose sulle prestazioni del sistema di intelligenza artificiale in varie condizioni.

Questo articolo illustra come:

- Visualizzare i risultati e le metriche della valutazione.

- Confrontare i risultati della valutazione.

- Ottenere informazioni sulle metriche di valutazione integrate.

- Migliorare le prestazioni.

- Visualizzare i risultati e le metriche della valutazione.

Individuare i risultati della valutazione

Dopo aver inviato la valutazione, è possibile individuare l'esecuzione della valutazione inviata all'interno dell'elenco di esecuzioni passando alla pagina Valutazione.

È possibile monitorare e gestire le esecuzioni della valutazione all'interno dell'elenco di esecuzioni. Con la flessibilità necessaria per modificare le colonne usando l'editor di colonne e implementare i filtri, è possibile personalizzare e creare una versione personale dell'elenco di esecuzioni. Inoltre, è possibile esaminare rapidamente le metriche di valutazione aggregate nelle esecuzioni, riuscendo a eseguire confronti rapidi.

Per ottenere informazioni più approfondite sul modo in cui vengono derivate le metriche di valutazione, è possibile accedere a una spiegazione completa selezionando l'opzione "Altre informazioni sulle metriche". Questa risorsa dettagliata fornisce informazioni importanti sul calcolo e l'interpretazione delle metriche usate nel processo di valutazione.

È possibile scegliere un'esecuzione specifica, che consenta di passare alla pagina dei dettagli dell'esecuzione. Qui è possibile accedere a informazioni complete, inclusi i dettagli sulla valutazione, ad esempio il set di dati di test, il tipo di attività, la richiesta, la temperatura e altro ancora. È anche possibile visualizzare le metriche associate a ogni campione di dati. I grafici dei punteggi delle metriche forniscono una rappresentazione visiva del modo in cui i punteggi vengono distribuiti per ogni metrica in tutto il set di dati.

All'interno della tabella dei dettagli delle metriche è possibile eseguire un esame completo di ogni singolo campione di dati. Qui è possibile esaminare sia l'output generato che il punteggio della metrica di valutazione corrispondente. Questo livello di dettaglio consente di prendere decisioni basate sui dati e di intraprendere azioni specifiche per migliorare le prestazioni del modello.

Alcuni potenziali elementi di azione basati sulle metriche di valutazione possono includere:

- Riconoscimento dei modelli: applicando un filtro per i valori numerici e le metriche, è possibile eseguire il drill-down tra i campioni con punteggi inferiori. Esaminare questi campioni per identificare modelli o problemi ricorrenti nelle risposte del modello. Ad esempio, si potrebbe notare che i punteggi bassi si ottengono spesso quando il modello genera contenuto su un determinato argomento.

- Perfezionamento del modello: usare le informazioni dettagliate dei campioni di punteggio inferiore per migliorare l'istruzione del prompt di sistema o ottimizzare il modello. Se si osservano problemi costanti con, ad esempio coerenza o pertinenza, è anche possibile modificare di conseguenza i dati o i parametri di training del modello.

- Personalizzazione delle colonne: l'editor di colonne consente di creare una visualizzazione personalizzata della tabella, concentrandosi sulle metriche e sui dati più rilevanti per gli obiettivi della valutazione. In questo modo è possibile semplificare l'analisi e individuare le tendenze in modo più efficace.

- Ricerca delle parole chiave: la casella di ricerca consente di cercare parole o frasi specifiche nell'output generato. Ciò può essere utile per individuare problemi o modelli correlati ad argomenti o parole chiave particolari e risolverli in modo specifico.

La tabella dei dettagli delle metriche offre molti dati utili per attuare azioni di miglioramento del modello, dal riconoscimento dei modelli alla personalizzazione della vista per l'analisi efficiente, al perfezionamento del modello in base ai problemi identificati.

Le visualizzazioni aggregate o le metriche vengono suddividete in base a Prestazioni e qualità e Metriche di rischio e sicurezza. È possibile visualizzare la distribuzione dei punteggi nel set di dati valutato e visualizzare i punteggi aggregati per ogni metrica.

- Per le metriche relative alle prestazioni e alla qualità, viene eseguita l'aggregazione calcolando una media tra tutti i punteggi per ogni metrica.

- Per le metriche relative ai rischi e alla sicurezza, viene eseguita l'aggregazione calcolando una percentuale di difetti per ogni metrica.

- Per le metriche relative al danno del contenuto, la percentuale di difetti viene definita come percentuale di istanze nel set di dati di test che superano una soglia sulla scala di gravità rispetto all'intera dimensione del set di dati. Per impostazione predefinita, la soglia è impostata su "Media".

- Per il materiale protetto e l'attacco indiretto, la percentuale di difetti viene calcolata come la percentuale di istanze in cui l'output è "True" (Percentuale di difetto = (#trues /#instances) × 100).

Ecco alcuni esempi dei risultati delle metriche per lo scenario di risposta alle domande:

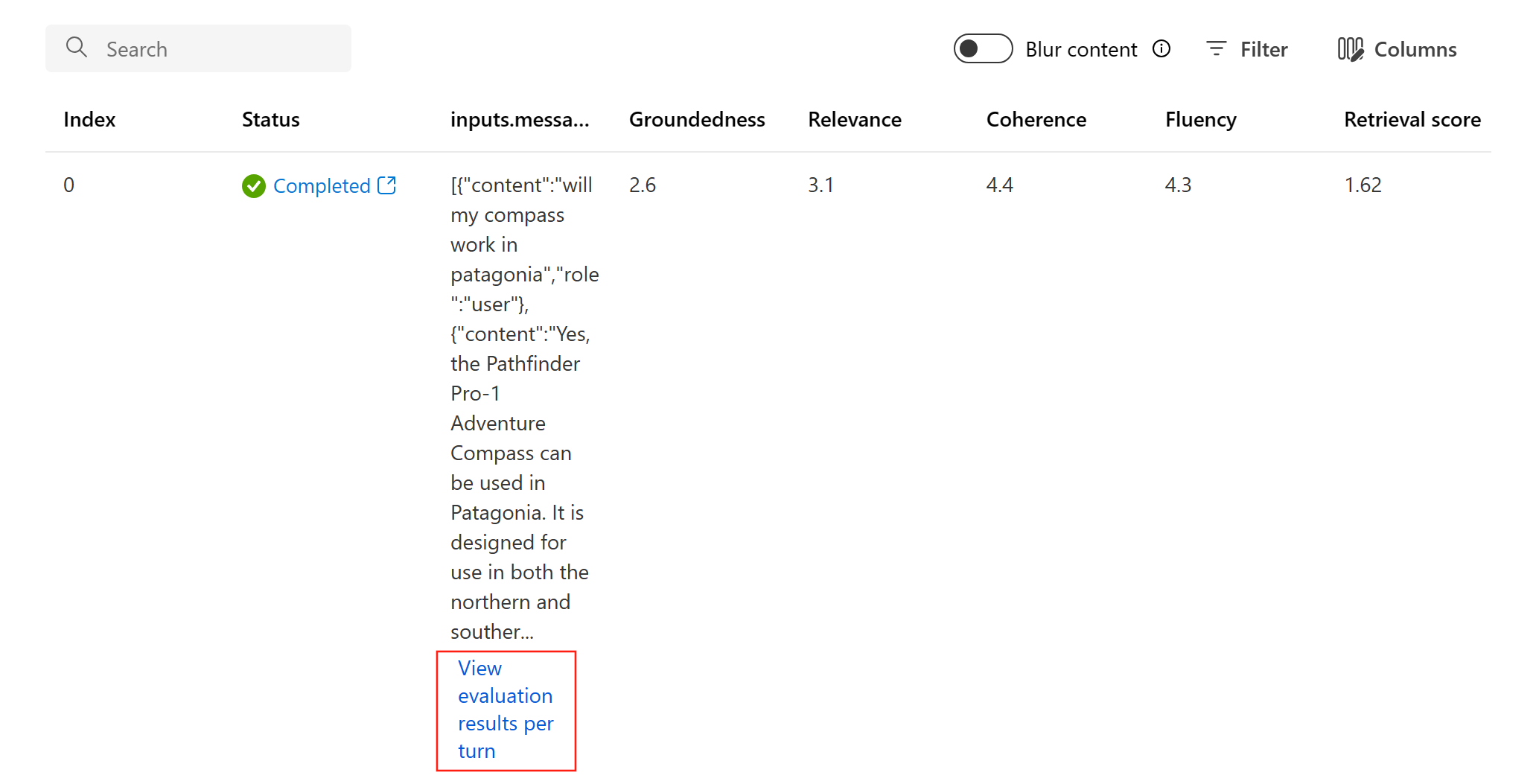

Ecco alcuni esempi dei risultati delle metriche per lo scenario di conversazione:

Per lo scenario di conversazione a più turni, è possibile selezionare “Visualizza i risultati della valutazione per turno” per controllare le metriche di valutazione per ogni turno in una conversazione.

Per le metriche relative ai rischi e alla sicurezza, la valutazione fornisce un punteggio di gravità e un ragionamento per ogni punteggio. Ecco alcuni esempi dei risultati delle metriche di rischio e sicurezza per lo scenario di risposta alle domande:

I risultati della valutazione potrebbero avere significati diversi per destinatari diversi. Ad esempio, le valutazioni della sicurezza potrebbero generare un'etichetta per una gravità "bassa" di contenuto violento che potrebbe non essere allineata alla definizione di un revisore umano in tal senso. È disponibile una colonna di feedback umano con pollici in su e pollici in giù quando si analizzano i risultati della valutazione, al fine di individuare le istanze approvate o contrassegnate come non corrette da un revisore umano.

Quando si comprende ogni metrica di rischio del contenuto, è possibile visualizzare facilmente ogni definizione di metrica e scala di gravità selezionando il nome della metrica sopra il grafico per visualizzare una spiegazione dettagliata in un popup.

In caso di problemi con l'esecuzione, è anche possibile eseguire il debug dell'esecuzione della valutazione con il log e l'analisi.

Ecco alcuni esempi dei log che è possibile usare per eseguire il debug dell'esecuzione della valutazione:

Di seguito è riportato un esempio della visualizzazione di traccia e debug:

Se si sta valutando un prompt flow, è possibile selezionare il pulsante Visualizza nel flusso per passare alla pagina del flusso valutato per eseguire l'aggiornamento al flusso. Ad esempio, l'aggiunta di altre istruzioni per la richiesta dei metadati o la modifica di alcuni parametri e la rivalutazione.

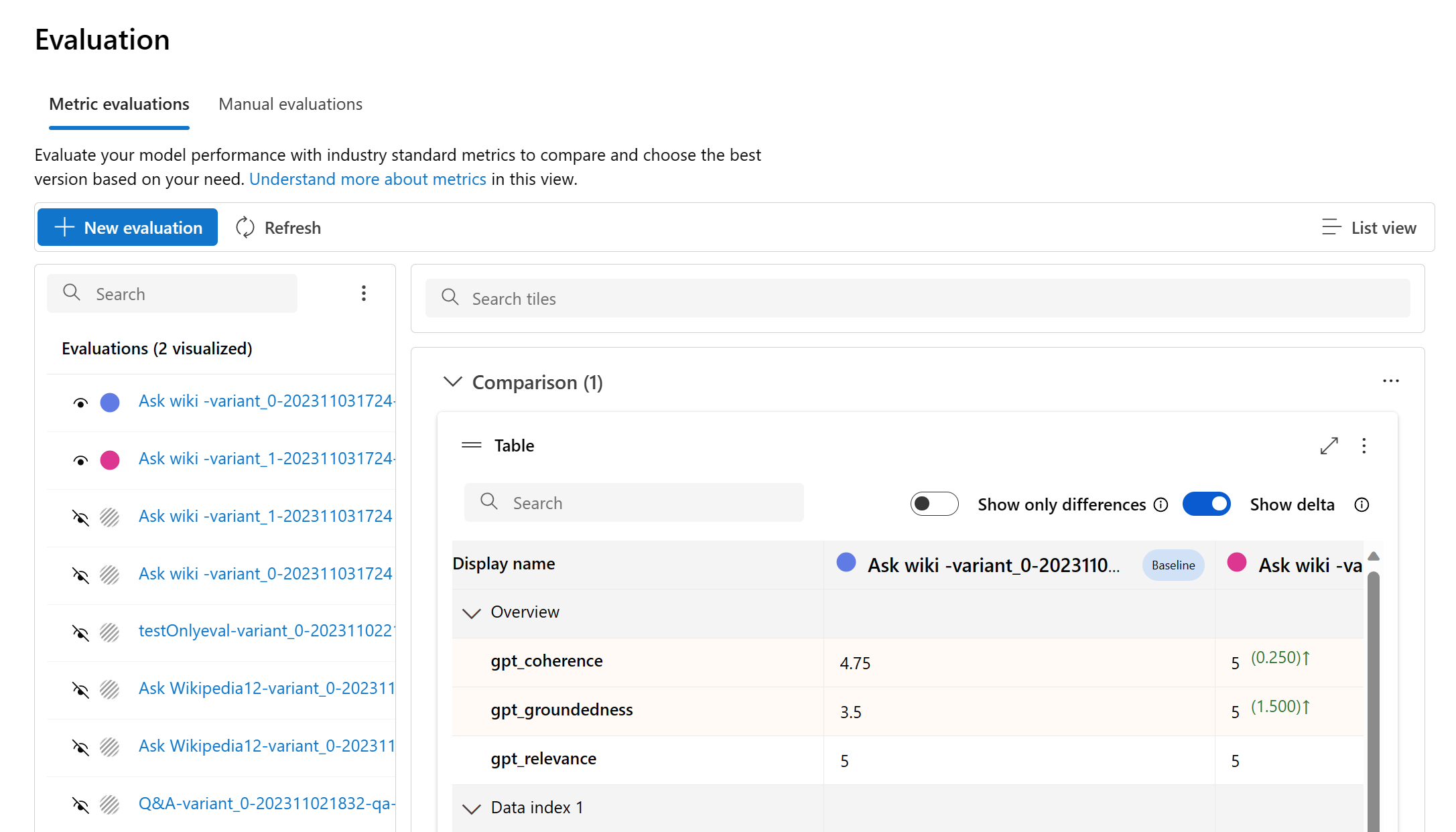

Confrontare i risultati della valutazione

Per semplificare il confronto completo tra due o più esecuzioni, è possibile selezionare le esecuzioni desiderate e avviare il processo selezionando il pulsante Confronta o, per una visualizzazione dettagliata e generale del dashboard, il pulsante Passare alla visualizzazione Dashboard. Questa funzionalità consente di analizzare e confrontare le prestazioni e i risultati di più esecuzioni, consentendo di eseguire un processo decisionale più informato e di apportare miglioramenti mirati.

Nella visualizzazione Dashboard è possibile accedere a due componenti importanti: il grafico di confronto della distribuzione delle metriche e la tabella di confronto. Questi strumenti consentono di eseguire un'analisi affiancata delle esecuzioni della valutazione selezionate, permettendo di confrontare vari aspetti di ciascun campione di dati con facilità e precisione.

Nella tabella di confronto è possibile stabilire una baseline per il confronto passando il puntatore del mouse sull'esecuzione specifica che si vuole usare come punto di riferimento e impostare come baseline. Inoltre, attivando l'interruttore "Mostra delta", è possibile visualizzare facilmente le differenze tra l'esecuzione della baseline e le altre esecuzioni per i valori numerici. Inoltre, quando l'interruttore "Mostra solo differenze" è abilitato, la tabella mostra solo le righe diverse nelle esecuzioni selezionate, agevolando l'identificazione di variazioni distinte.

Usando queste funzionalità di confronto, è possibile prendere una decisione informata per selezionare la versione migliore:

- Confronto della baseline: impostando un'esecuzione di base, è possibile identificare un punto di riferimento rispetto al quale confrontare le altre esecuzioni. In questo modo è possibile vedere in che modo ogni esecuzione devia dallo standard scelto.

- Valutazione del valore numerico: l'abilitazione dell'opzione "Mostra delta" consente di comprendere l'entità delle differenze tra la baseline e le altre esecuzioni. Ciò è utile per valutare le prestazioni delle varie esecuzioni in termini di metriche della valutazione specifiche.

- Isolamento delle differenze: la funzionalità "Mostra solo differenze" semplifica l'analisi evidenziando solo le aree in cui sono presenti discrepanze tra le esecuzioni. Questo può essere fondamentale per individuare i punti in cui sono necessari miglioramenti o regolazioni.

Usando questi strumenti di confronto in modo efficace, è possibile identificare quale versione del modello o del sistema offre le prestazioni migliori in relazione ai criteri e alle metriche definiti, consentendo in definitiva di selezionare l'opzione migliore per l'applicazione.

Misurazione della vulnerabilità di jailbreak

La valutazione del jailbreak è una misurazione comparativa, non una metrica assistita dall'intelligenza artificiale. Eseguire valutazioni su due set di dati diversi e con red team: un set di dati di test antagonista di base rispetto allo stesso set di dati di test antagonista con iniezioni di jailbreak nel primo turno. È possibile usare il simulatore di dati antagonisti per generare il set di dati con o senza iniezioni di jailbreak.

Per capire se l'applicazione è vulnerabile al jailbreak, è possibile specificare quale sia la linea di base e quindi attivare o disattivare l'opzione "Frequenza difetti di jailbreak" nella tabella di confronto. La percentuale di difetti di jailbreak è definita come la percentuale di istanze nel set di dati di test in cui un'iniezione di jailbreak ha generato un punteggio di gravità superiore per qualsiasi metrica di rischio del contenuto rispetto a una baseline per l'intera dimensione del set di dati. È possibile selezionare più valutazioni nel dashboard di confronto per visualizzare la differenza nei tassi di difetto.

Suggerimento

La percentuale di difetti di jailbreak viene calcolata relativamente solo per i set di dati delle stesse dimensioni e solo quando tutte le esecuzioni includono metriche di rischio e sicurezza del contenuto.

Ottenere informazioni sulle metriche di valutazione integrate

Le informazioni le metriche predefinite sono fondamentali per valutare le prestazioni e l'efficacia dell'applicazione di intelligenza artificiale. Ottenendo informazioni dettagliate su questi strumenti di misurazione chiave, l'utente ha i mezzi per interpretare i risultati, prendere decisioni informate e ottimizzare l'applicazione per ottenere risultati ottimali. Per altre informazioni sul significato di ogni metrica, sul modo in cui viene calcolata, sul suo ruolo nella valutazione di diversi aspetti del modello e su come interpretare i risultati per apportare miglioramenti basati sui dati, vedere Metriche di valutazione e monitoraggio.

Passaggi successivi

Altre informazioni su come valutare le applicazioni di intelligenza artificiale generative:

- Valutare le app di intelligenza artificiale generativa tramite il playground

- Valutare le app di intelligenza artificiale generativa con Studio AI della piattaforma Azure o SDK

Altre informazioni sulle tecniche di mitigazione dei danni.