Strumento LLM per i flussi in Studio AI della piattaforma Azure

Importante

Gli elementi contrassegnati (anteprima) in questo articolo sono attualmente disponibili in anteprima pubblica. Questa anteprima viene fornita senza un contratto di servizio e non è consigliabile per i carichi di lavoro di produzione. Alcune funzionalità potrebbero non essere supportate o potrebbero presentare funzionalità limitate. Per altre informazioni, vedere le Condizioni supplementari per l'uso delle anteprime di Microsoft Azure.

Per usare modelli linguistici di grandi dimensioni (LLM) per l'elaborazione del linguaggio naturale, si usa lo strumento LLM del prompt flow.

Nota

Per gli incorporamenti per convertire il testo in rappresentazioni vettoriali dense per varie attività di elaborazione del linguaggio naturale, vedere Strumento di incorporamento.

Prerequisiti

Preparare un prompt come descritto nella documentazione dello strumento di prompt. Lo strumento LLM e lo strumento di prompt supportano entrambi i modelli Jinja. Per altre informazioni e procedure consigliate, vedere Tecniche di progettazione dei prompt.

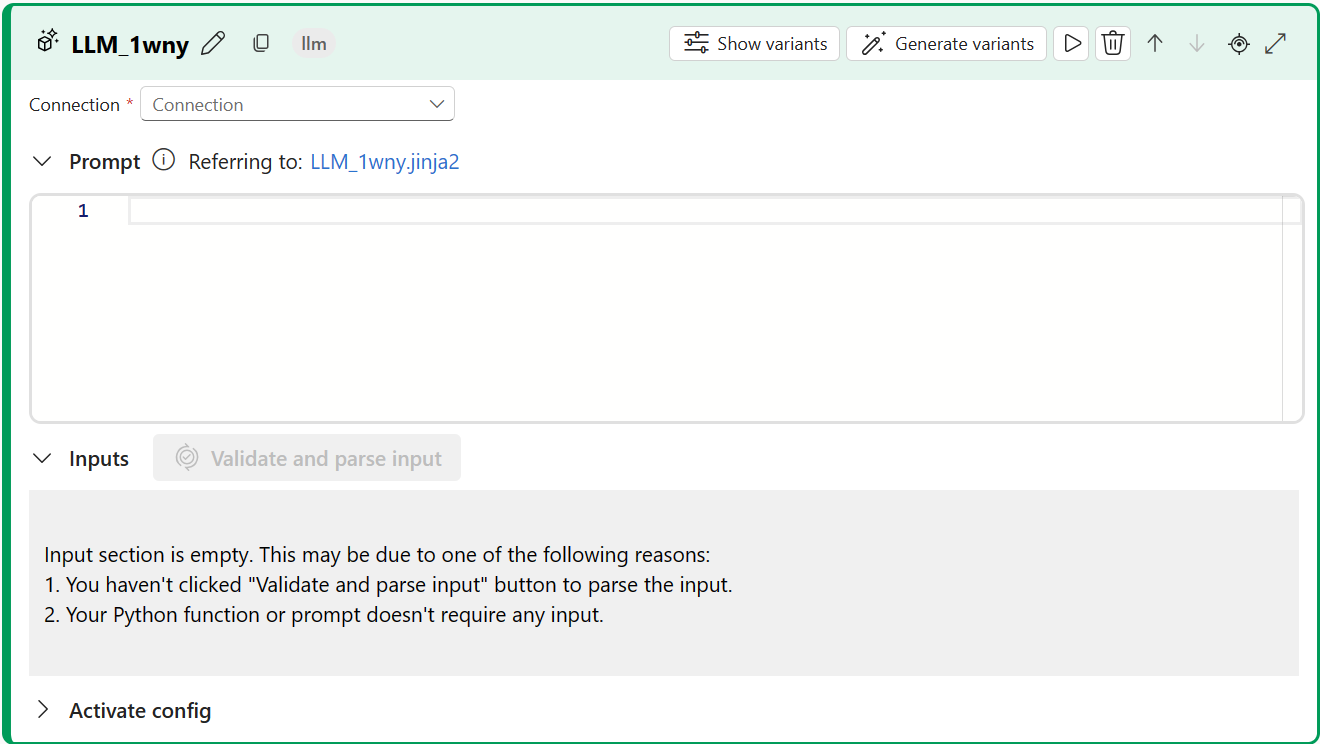

Compilare con lo strumento LLM

Creare o aprire un flusso in Studio AI della piattaforma Azure. Per altre informazioni, vedere Creare un flusso.

Selezionare + LLM per aggiungere lo strumento LLM al flusso.

Selezionare la connessione a una delle risorse di cui è stato effettuato il provisioning. Ad esempio, selezionare Default_AzureOpenAI.

Nell'elenco a discesa API, selezionare chat o completamento.

Immettere i valori per i parametri di input dello strumento LLM descritti nella tabella Input di completamento del testo. Se è stata selezionata l'API chat, vedere la tabella Input di chat. Se è stata selezionata l'API di completamento, vedere la tabella Input di completamento del testo. Per informazioni su come preparare l'input del prompt, vedere Prerequisiti.

Aggiungere altri strumenti al flusso in base alle esigenze. In alternativa, selezionare Esegui per eseguire il flusso.

Gli output sono descritti nella tabella degli output.

Input

Sono disponibili i parametri di input seguenti.

Input di completamento del testo

| Nome | Tipo | Descrizione | Richiesto |

|---|---|---|---|

| prompt | string | Richiesta di testo per il modello linguistico. | Sì |

| model, deployment_name | string | Modello linguistico da usare. | Sì |

| max_tokens | integer | Numero massimo di token da generare nel completamento. Il valore predefinito è 16. | No |

| temperatura | float | Casualità del testo generato. Il valore predefinito è 1. | No |

| stop | list | Sequenza di arresto per il testo generato. Il valore predefinito è Null. | No |

| suffix | string | Testo aggiunto alla fine del completamento. | No |

| top_p | float | Probabilità di usare la scelta principale dai token generati. Il valore predefinito è 1. | No |

| logprobs | integer | Numero di probabilità di log da generare. Il valore predefinito è Null. | No |

| echo | boolean | Valore che indica se eseguire l'eco della richiesta nella risposta. Il valore predefinito è false. | No |

| presence_penalty | float | Valore che controlla il comportamento del modello relativo alle frasi ripetute. Il valore predefinito è 0. | No |

| frequency_penalty | float | Valore che controlla il comportamento del modello relativo alla generazione di frasi rare. Il valore predefinito è 0. | No |

| best_of | integer | Numero di completamento migliori da generare. Il valore predefinito è 1. | No |

| logit_bias | dizionario | Distorsione logit per il modello linguistico. Il valore predefinito è un dizionario vuoto. | No |

Input di chat

| Nome | Tipo | Descrizione | Richiesto |

|---|---|---|---|

| prompt | string | Richiesta di testo a cui il modello linguistico deve rispondere. | Sì |

| model, deployment_name | string | Modello linguistico da usare. | Sì |

| max_tokens | integer | Numero massimo di token da generare nella risposta. Il valore predefinito è inf. | No |

| temperatura | float | Casualità del testo generato. Il valore predefinito è 1. | No |

| stop | list | Sequenza di arresto per il testo generato. Il valore predefinito è Null. | No |

| top_p | float | Probabilità di usare la scelta principale dai token generati. Il valore predefinito è 1. | No |

| presence_penalty | float | Valore che controlla il comportamento del modello relativo alle frasi ripetute. Il valore predefinito è 0. | No |

| frequency_penalty | float | Valore che controlla il comportamento del modello relativo alla generazione di frasi rare. Il valore predefinito è 0. | No |

| logit_bias | dizionario | Distorsione logit per il modello linguistico. Il valore predefinito è un dizionario vuoto. | No |

Output

L'output varia a seconda dell'API selezionata per gli input.

| API | Tipo restituito | Descrizione |

|---|---|---|

| Completion | string | Testo di un completamento previsto. |

| Chat | string | Testo di una risposta di conversazione. |