Come funziona Gestione orchestrazione flussi di lavoro di Azure Data Factory?

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi completa per le aziende. Microsoft Fabric copre tutti gli elementi, dallo spostamento dei dati all'analisi scientifica dei dati, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Scopri come avviare gratuitamente una nuova versione di valutazione .

Nota

Workflow Orchestration Manager è basato su Apache Airflow.

Nota

Workflow Orchestration Manager per Azure Data Factory si basa sull'applicazione Apache Airflow open source. La documentazione e altre esercitazioni per Airflow sono disponibili nelle pagine della documentazione o della community di Apache Airflow.

Workflow Orchestration Manager in Azure Data Factory usa grafici Aciclici diretti (DAG) basati su Python per eseguire i flussi di lavoro di orchestrazione. Per usare questa funzionalità, è necessario fornire i dag e i plug-in in Archiviazione BLOB di Azure. È possibile avviare l'interfaccia utente airflow da ADF usando un'interfaccia della riga di comando (CLI) o un software development kit (SDK) per gestire i dag.

Creare un ambiente di Workflow Orchestration Manager

La procedura seguente consente di configurare e configurare l'ambiente di Workflow Orchestration Manager.

Prerequisiti

Sottoscrizione di Azure: se non si ha una sottoscrizione di Azure, creare un account gratuito prima di iniziare. Creare o selezionare una data factory esistente nell'area in cui è supportata l'anteprima di Workflow Orchestration Manager.

Procedura per creare l'ambiente

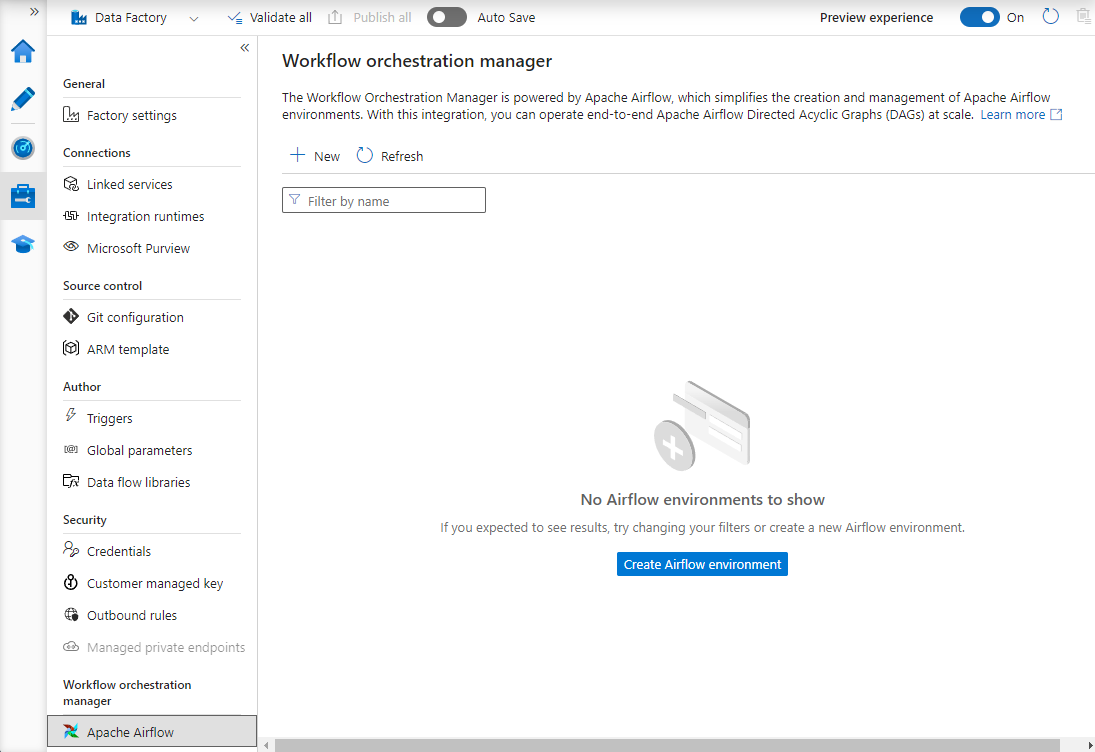

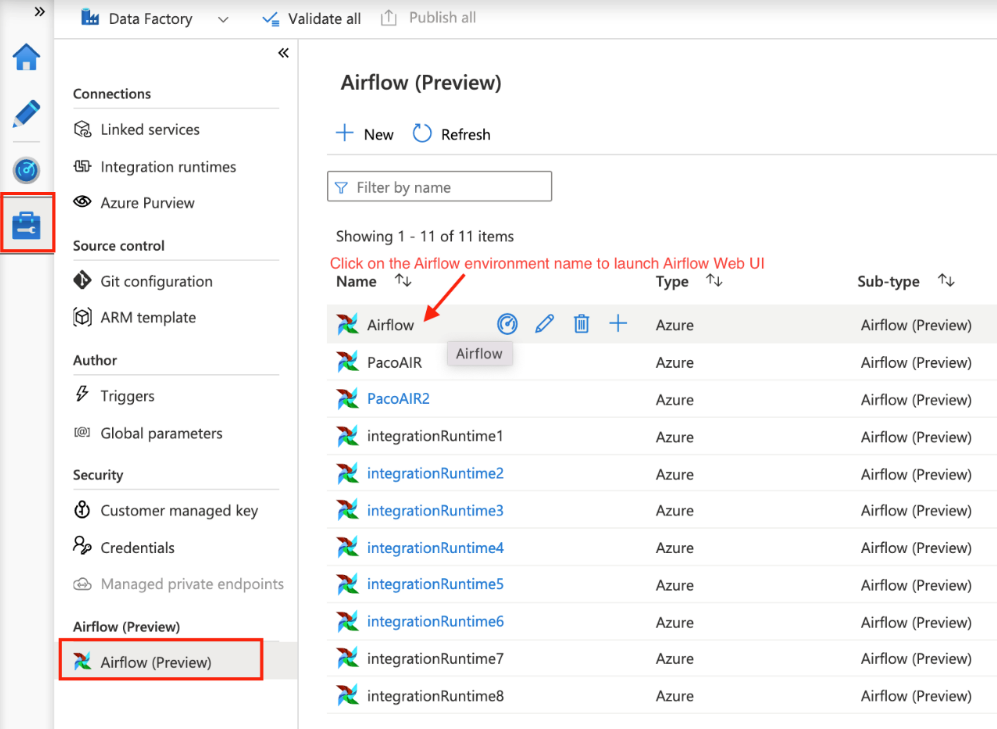

Creare un nuovo ambiente workflow Orchestration Manager. Passare a Gestisci hub ->Airflow (anteprima) ->+Nuovo per creare un nuovo ambiente Airflow

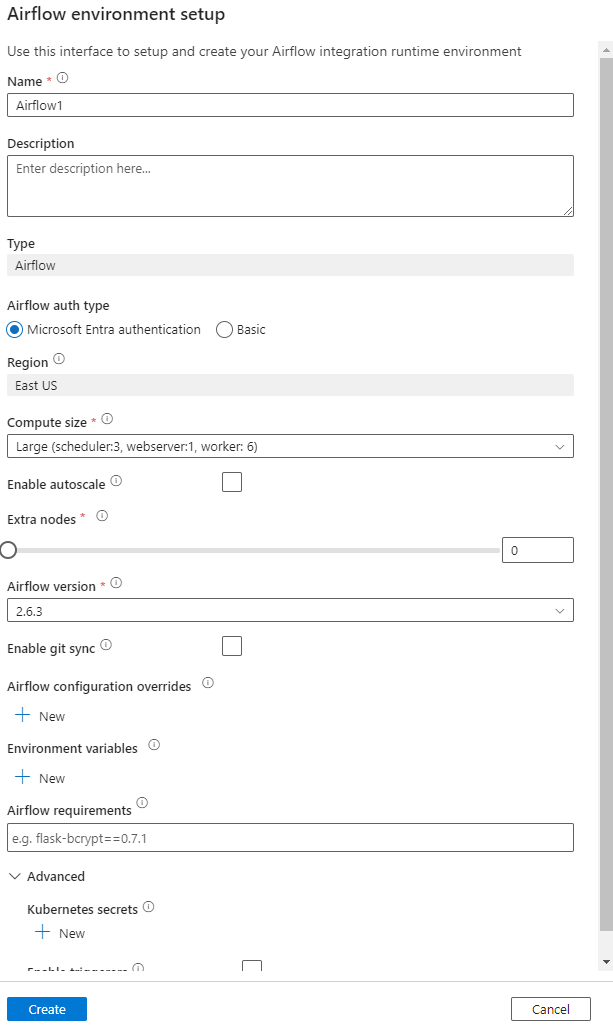

Specificare i dettagli (configurazione airflow)

Importante

Quando si usa l'autenticazione di base , ricordare il nome utente e la password specificati in questa schermata. Sarà necessario eseguire l'accesso in un secondo momento nell'interfaccia utente di Workflow Orchestration Manager. L'opzione predefinita è Microsoft Entra ID e non richiede la creazione di nome utente/password per l'ambiente Airflow, ma usa invece le credenziali dell'utente connesso ad Azure Data Factory per accedere/monitorare i dag.

Variabili di ambiente un archivio di valori chiave semplice all'interno di Airflow per archiviare e recuperare contenuto o impostazioni arbitrarie.

I requisiti possono essere usati per preinstallare le librerie Python. È anche possibile aggiornare questi elementi in un secondo momento.

Importare gruppi di disponibilità del database

I passaggi seguenti descrivono come importare gruppi di disponibilità del database in Workflow Orchestration Manager.

Prerequisiti

È necessario caricare un daG di esempio in un account di Archiviazione accessibile (dovrebbe essere nella cartella dag).

Nota

Le Archiviazione BLOB dietro la rete virtuale non sono supportate durante l'anteprima.

Configurazione di KeyVault in storageLinkedServices non supportata per l'importazione di dag.

DaG Apache Airflow v2.x di esempio. Esempio di APACHE Airflow v1.10 DAG.

Passaggi da importare

Copiare e incollare il contenuto (v2.x o v1.10 in base all'ambiente Airflow configurato) in un nuovo file denominato tutorial.py.

Caricare il tutorial.py in un archivio BLOB. (Come caricare un file in BLOB)

Nota

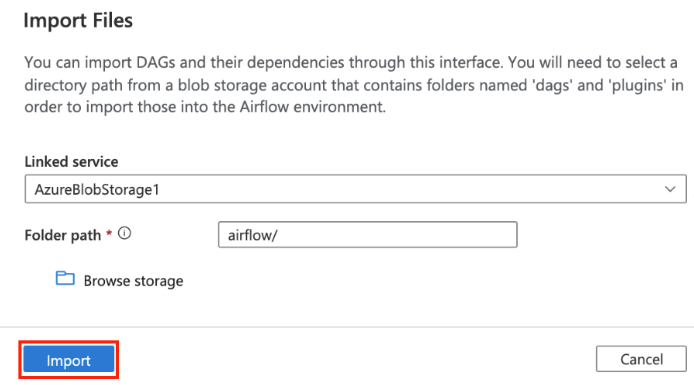

È necessario selezionare un percorso di directory da un account di archiviazione BLOB contenente cartelle denominate dags e plug-in per importarli nell'ambiente Airflow. I plug-in non sono obbligatori. È anche possibile avere un contenitore denominato dags e caricare tutti i file Airflow al suo interno.

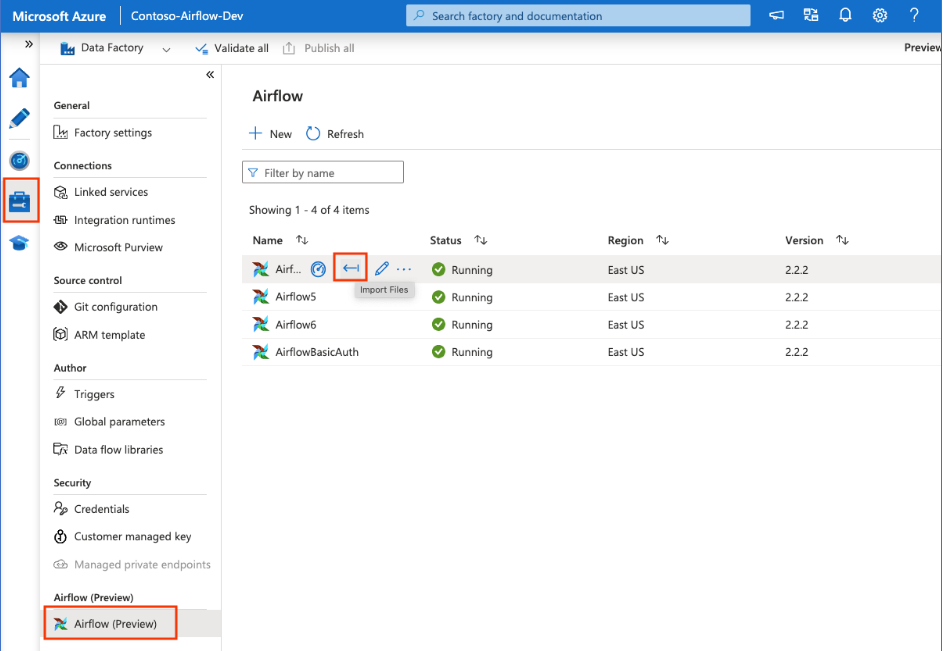

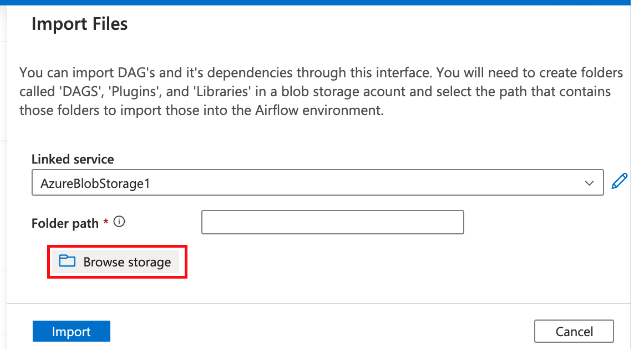

Selezionare Airflow (anteprima) in Gestisci hub. Passare quindi il puntatore sull'ambiente Airflow creato in precedenza e selezionare Import files to Import all DAG and dependencies into the Airflow Environment (Importa file per importare tutti i dag e le dipendenze nell'ambiente Airflow).

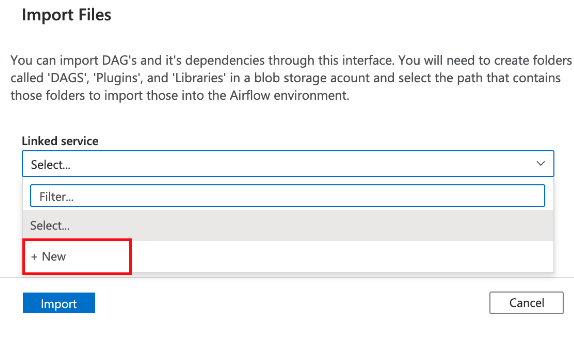

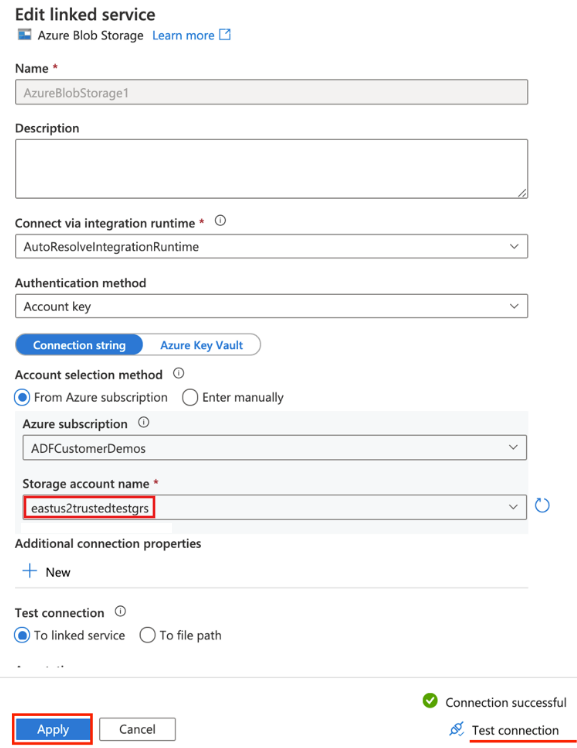

Creare un nuovo servizio collegato per l'account di archiviazione accessibile indicato nel prerequisito oppure usarne uno esistente se si dispone già di un gruppo di disponibilità dati personalizzato.

Usare l'account di archiviazione in cui è stato caricato il dag (verificare i prerequisiti). Testare la connessione e quindi selezionare Crea.

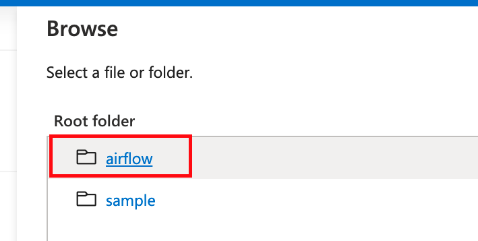

Esplorare e selezionare airflow se si usa l'URL di firma di accesso condiviso di esempio o selezionare la cartella contenente la cartella dag con i file DAG.

Nota

È possibile importare i dag e le relative dipendenze tramite questa interfaccia. È necessario selezionare un percorso di directory da un account di archiviazione BLOB contenente cartelle denominate dags e plug-in per importarli nell'ambiente Airflow. I plug-in non sono obbligatori.

Nota

L'importazione di dag potrebbe richiedere alcuni minuti durante l'anteprima. Il centro notifiche (icona a forma di campana nell'interfaccia utente di Azure Data Factory) può essere usato per tenere traccia degli aggiornamenti dello stato di importazione.

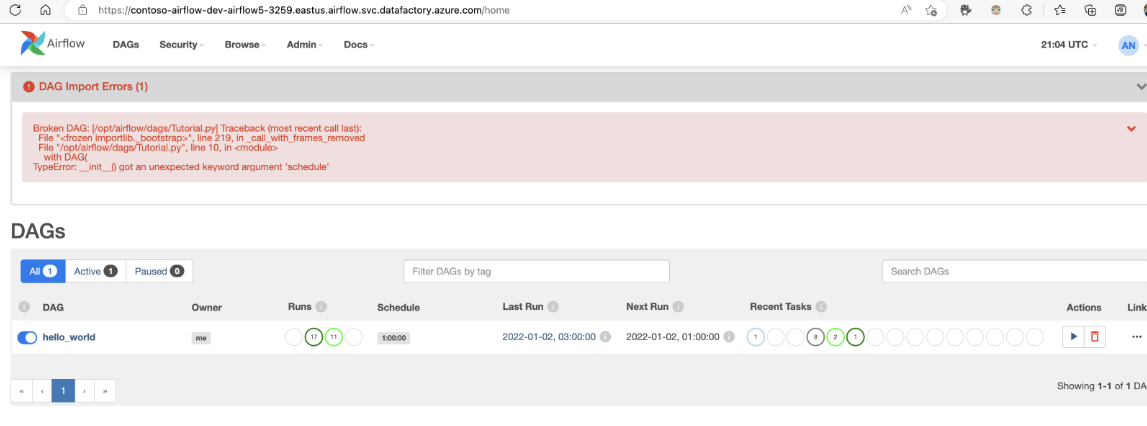

Risoluzione dei problemi relativi all'importazione daG

Problema: l'importazione DAG richiede più di 5 minuti di mitigazione: ridurre le dimensioni dei dag importati con una singola importazione. Un modo per ottenere questo risultato consiste nel creare più cartelle DAG con gruppi di disponibilità dati inferiori in più contenitori.

Problema: i DAG importati non vengono visualizzati quando si accede all'interfaccia utente di Airflow. Mitigazione: accedere all'interfaccia utente di Airflow e verificare se sono presenti errori di analisi DAG. Questo problema può verificarsi se i file DAG contengono codice incompatibile. Troverai i numeri di riga e i file esatti, che presentano il problema tramite l'interfaccia utente airflow.

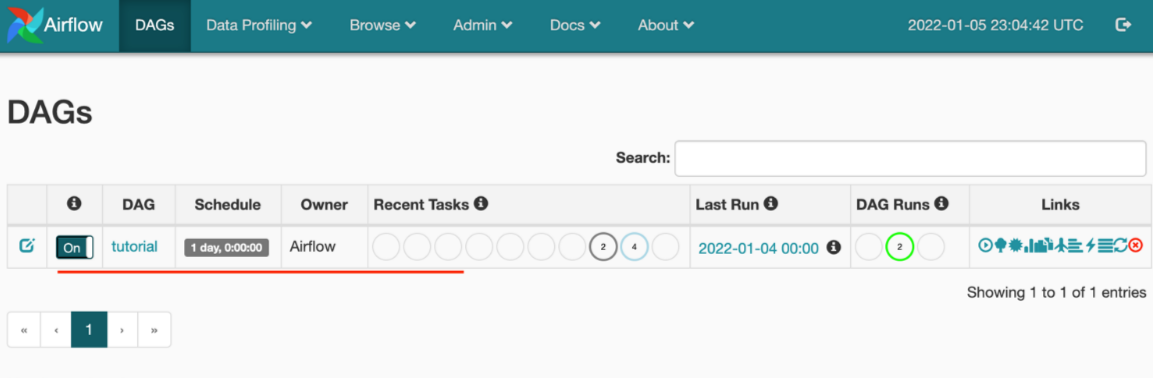

Monitorare le esecuzioni di DAG

Per monitorare i dag Airflow, accedere all'interfaccia utente di Airflow con il nome utente e la password creati in precedenza.

Selezionare l'ambiente Airflow creato.

Accedere usando la password del nome utente specificata durante la creazione del runtime di integrazione Airflow. È possibile reimpostare il nome utente o la password modificando il runtime di integrazione airflow, se necessario.

Rimuovere i dag dall'ambiente Airflow

Se si usa Airflow versione 1.x, eliminare i dag distribuiti in qualsiasi ambiente Airflow (IR), è necessario eliminare i dag in due posizioni diverse.

- Eliminare il DAG dall'interfaccia utente airflow

- Eliminare il DAG nell'interfaccia utente di Azure Data Factory

Nota

Questa è l'esperienza corrente durante l'anteprima pubblica e questa esperienza verrà migliorata.