Eventi

Ottieni gratuitamente la certificazione in Microsoft Fabric.

19 nov, 23 - 10 dic, 23

Per un periodo di tempo limitato, il team della community di Microsoft Fabric offre buoni per esami DP-600 gratuiti.

Prepara oraQuesto browser non è più supportato.

Esegui l'aggiornamento a Microsoft Edge per sfruttare i vantaggi di funzionalità più recenti, aggiornamenti della sicurezza e supporto tecnico.

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita!

Azure Data Lake Storage Gen1 (in precedenza noto come Azure Data Lake Store) è un repository su vasta scala a livello aziendale per carichi di lavoro di analisi di Big Data. Data Lake Storage Gen1 consente di acquisire dati di qualsiasi dimensione, tipo e velocità di inserimento. I dati vengono acquisiti in una singola posizione per le analisi esplorative e operative.

Azure Data Factory è un servizio di integrazione dei dati completamente gestito e basato sul cloud. È possibile usare il servizio per popolare il lake con i dati dal sistema esistente e risparmiare tempo durante la compilazione di soluzioni di analisi.

Azure Data Factory offre i vantaggi seguenti per il caricamento di dati in Azure Data Lake Storage Gen1:

Questo articolo illustra come usare lo strumento Copia dati di Data Factory per caricare dati da Amazon S3 in Azure Data Lake Storage Gen1. È possibile seguire una procedura simile a quella usata per copiare dati da altri tipi di archivi dati.

Nota

Per altre informazioni, vedere Copiare dati da e in Azure Data Lake Storage Gen1 usando Azure Data Factory.

Se non è ancora stato creato il data factory, seguire la procedura descritta in Avvio rapido: creare un data factory usando il portale di Azure e Azure Data Factory Studio per crearne uno. Dopo averlo creato, passare alla data factory nel portale di Azure.

Selezionare Apri nel riquadro Apri Azure Data Factory Studio per avviare l'applicazione Integrazione dei dati in una scheda separata.

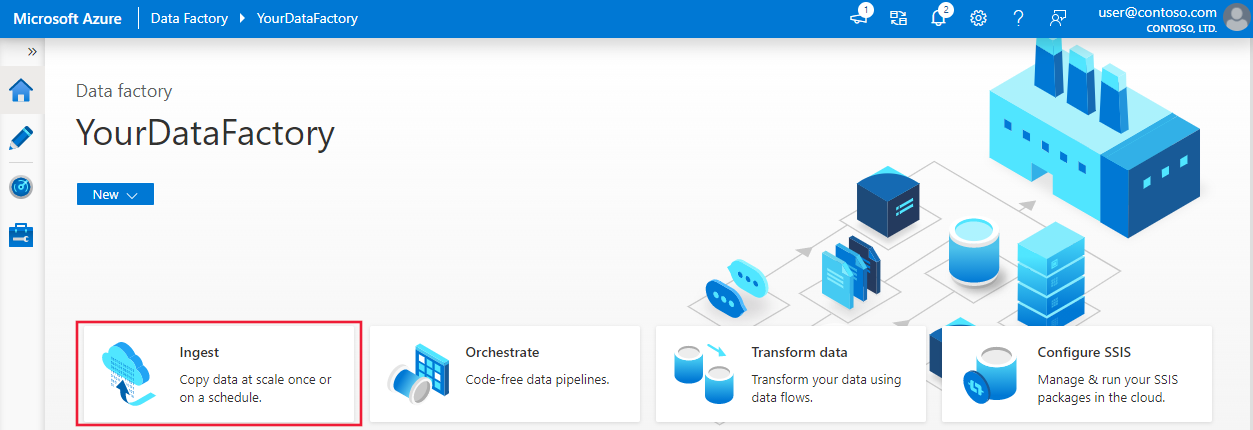

Nella home page selezionare il riquadro Inserimento per avviare lo strumento Copia dati:

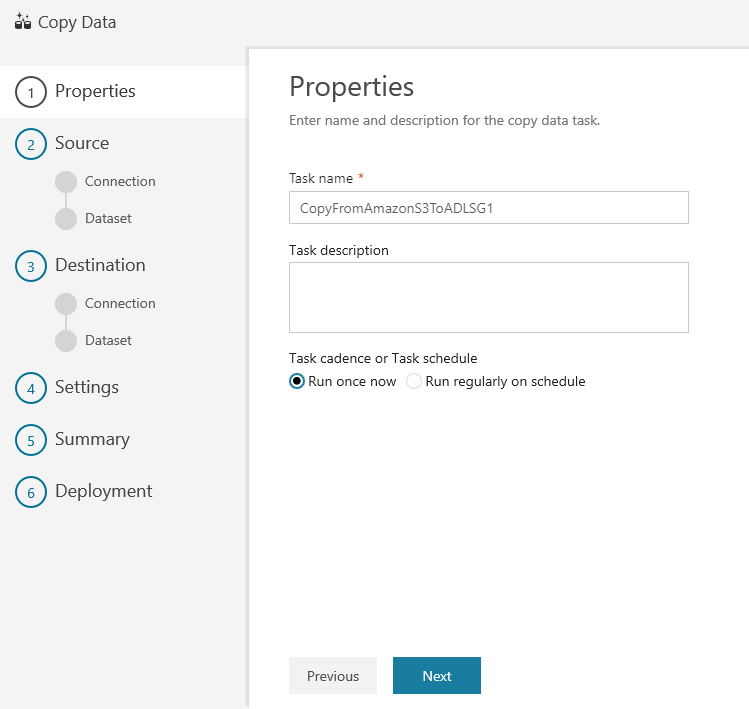

Nella pagina Proprietà specificare CopyFromAmazonS3ToADLS per il campo Nome attività, quindi selezionare Avanti:

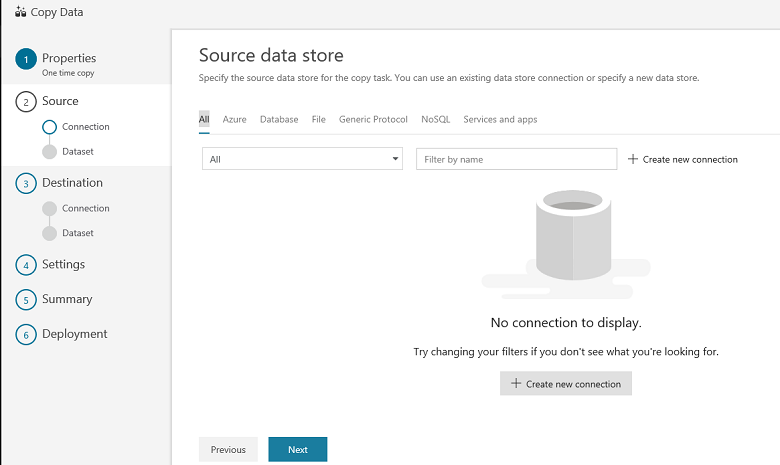

Nella pagina Archivio dati di origine selezionare + Crea nuova connessione:

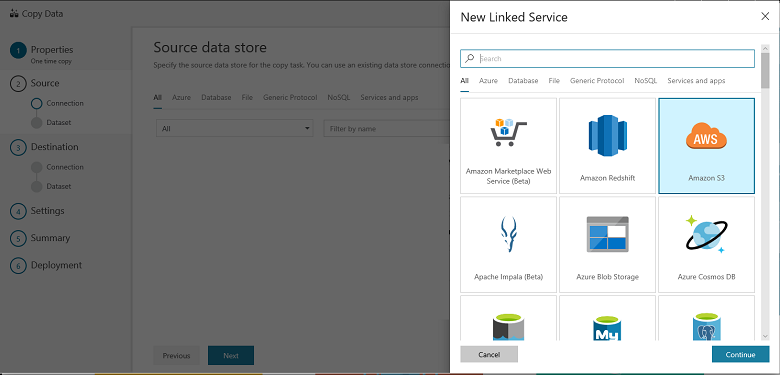

Selezionare Amazon S3 e quindi Continua

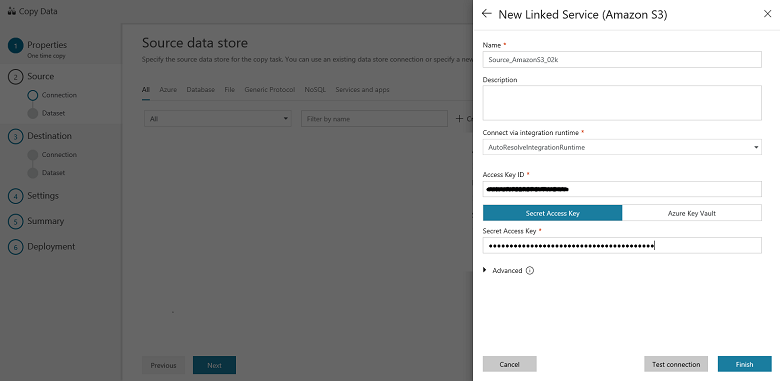

Nella pagina Specificare la connessione ad Amazon S3, effettuare i passaggi seguenti:

Specificare il valore ID della chiave di accesso.

Specificare il valore Chiave di accesso segreta.

Selezionare Fine.

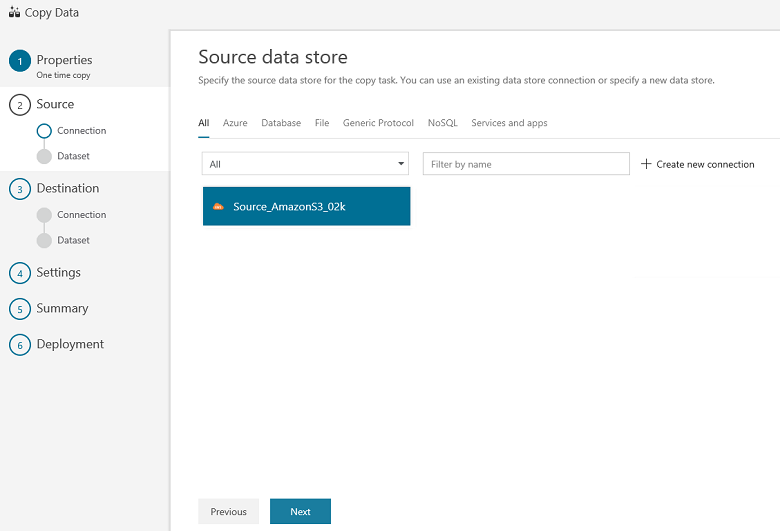

Si noterà una nuova connessione. Selezionare Avanti.

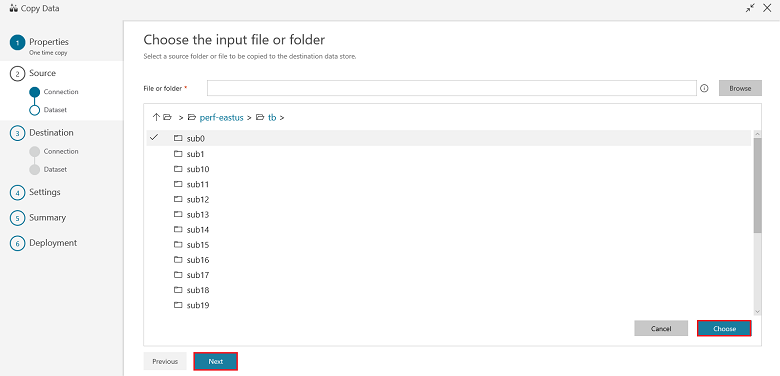

Nella pagina Choose the input file or folder (Scegliere il file o la cartella di input) passare alla cartella e al file da copiare. Selezionare la cartella o il file, selezionare Scegli, quindi selezionare Avanti:

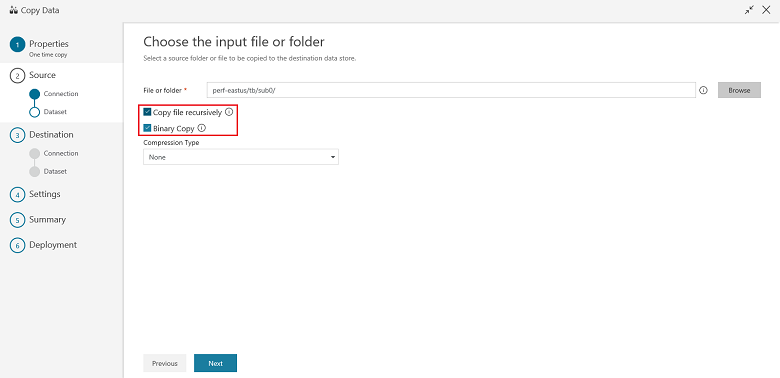

Scegliere il comportamento di copia selezionando le opzioni Copia i file in modo ricorsivo e Copia binaria (copia i file così come sono). Selezionare Next (Avanti):

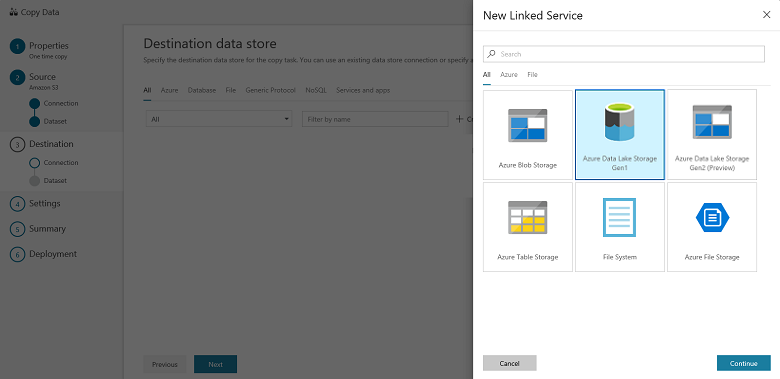

Nella pagina Archivio dati di destinazione selezionare + Crea nuova connessione e quindi selezionare Azure Data Lake Storage Gen1 e selezionare Continua:

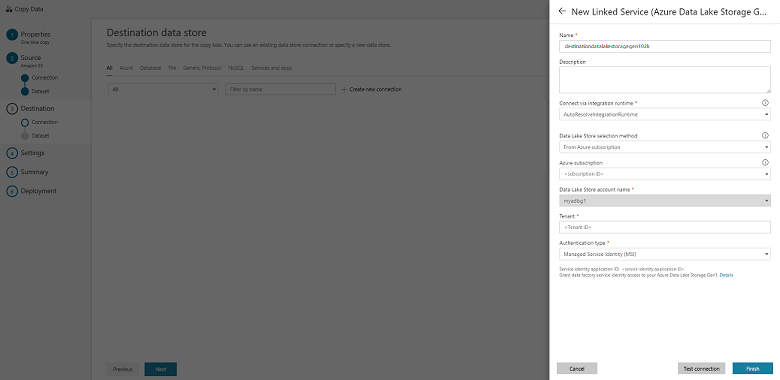

Nella pagina Nuovo servizio collegato (Azure Data Lake Storage Gen1) seguire questa procedura:

Importante

In questa procedura dettagliata si usa un'identità gestita delle risorse di Azure per autenticare l'account Data Lake Storage Gen1. Assicurarsi di concedere le autorizzazioni appropriate all'entità del servizio gestita in Data Lake Storage Gen1 seguendo queste istruzioni.

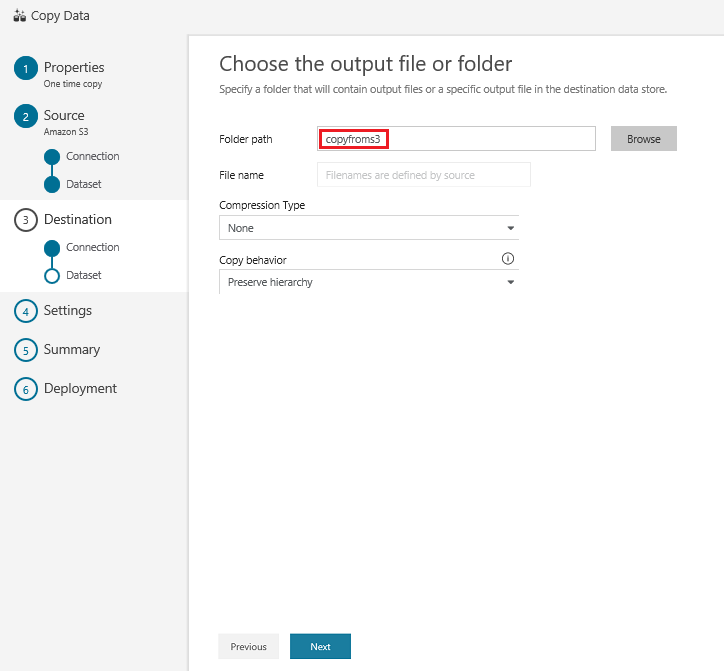

Nella pagina Choose the output file or folder (Scegliere il file o la cartella di output) immettere copyfroms3 come nome della cartella di output, quindi selezionare Avanti:

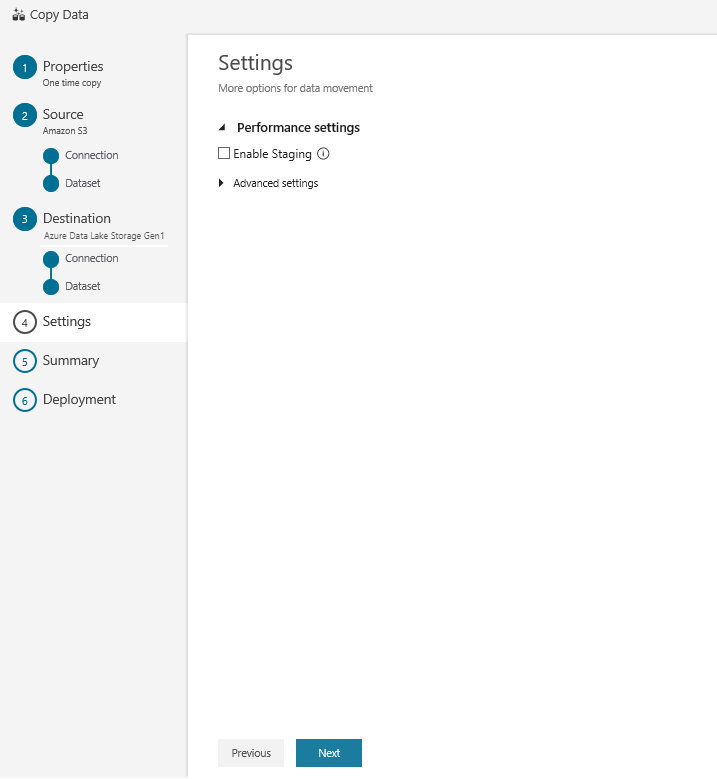

Nella pagina Impostazioni selezionare Avanti:

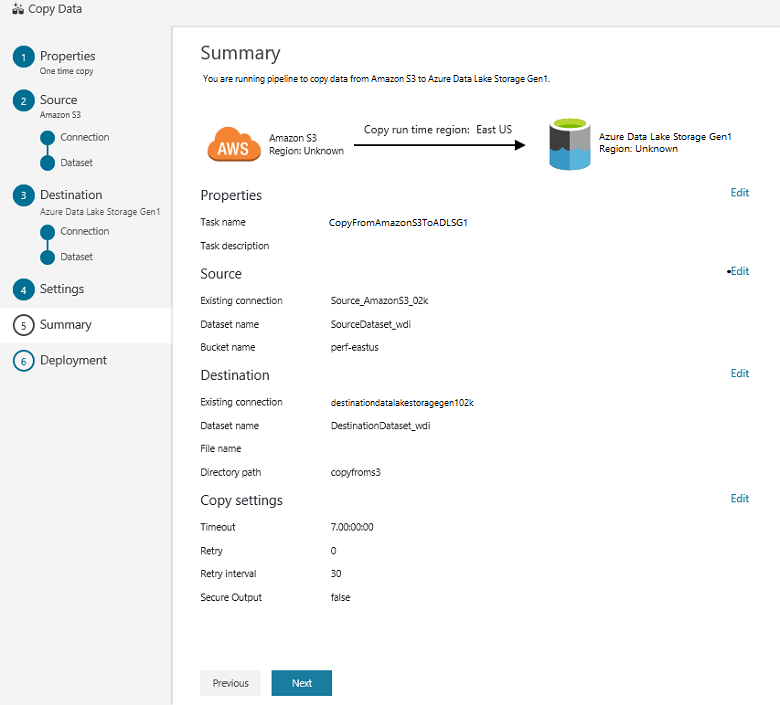

Nella pagina Riepilogo esaminare le impostazioni e quindi selezionare Avanti:

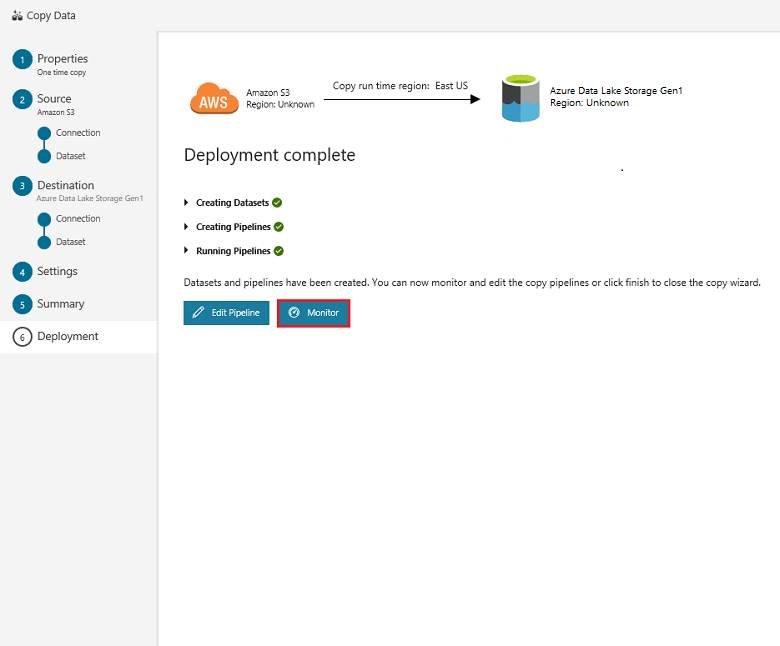

Nella pagina Distribuzione selezionare Monitoraggio per monitorare la pipeline (attività):

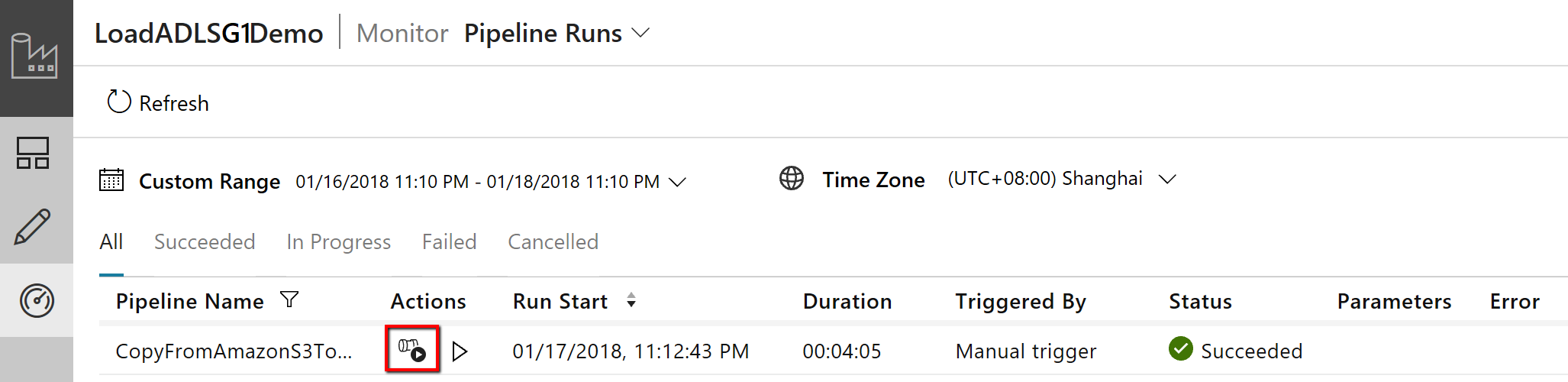

Si noti che la scheda Monitoraggio a sinistra è selezionata automaticamente. La colonna Azioni contiene collegamenti per visualizzare i dettagli delle esecuzioni dell'attività ed eseguire di nuovo la pipeline:

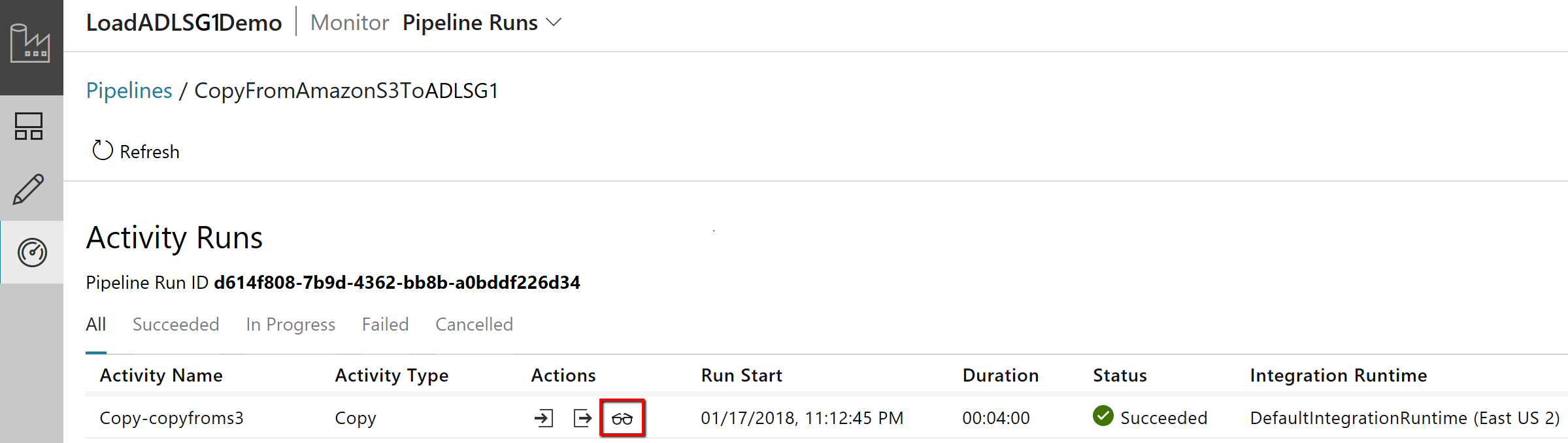

Per visualizzare le esecuzioni di attività associate all'esecuzione della pipeline, selezionare il collegamento View Activity Runs (Visualizza le esecuzioni di attività) nella colonna Azioni. Dato che la pipeline contiene una sola attività (attività di copia), viene visualizzata una sola voce. Per tornare alla visualizzazione delle esecuzioni di pipeline, selezionare il collegamento Pipeline in alto. Selezionare Aggiorna per aggiornare l'elenco.

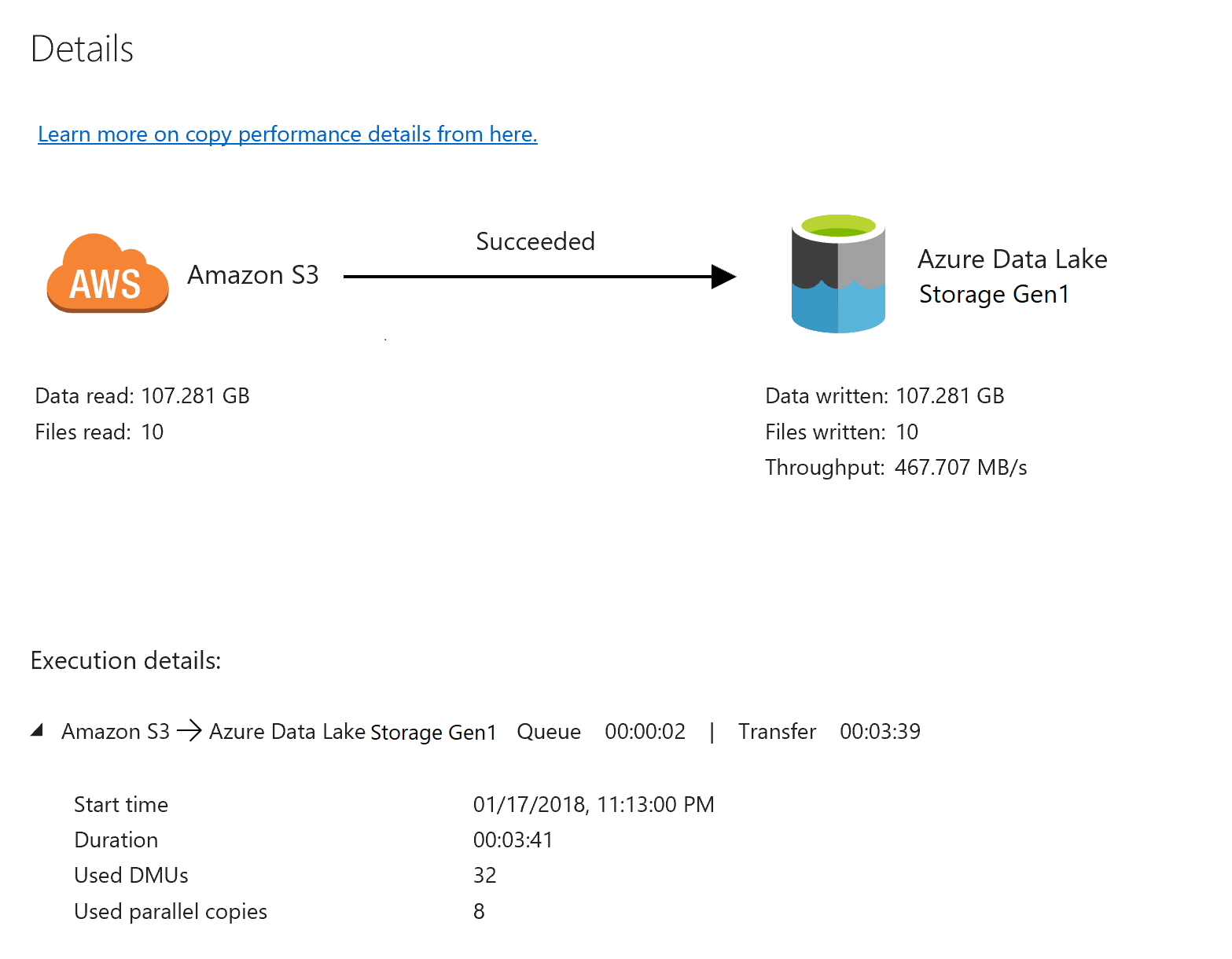

Per monitorare i dettagli di esecuzione per ogni attività di copia, selezionare il collegamento Dettagli in Azioni nella visualizzazione di monitoraggio delle attività. È possibile monitorare dettagli come il volume dei dati copiati dall'origine al sink, la velocità effettiva dei dati, i passaggi di esecuzione con la durata corrispondente e le configurazioni usate:

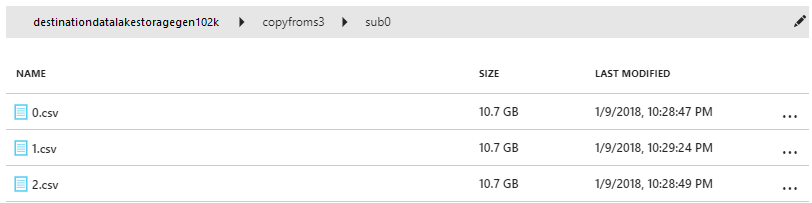

Verificare che i dati vengano copiati nell'account Data Lake Storage Gen1:

Leggere l'articolo seguente per altre informazioni sul supporto di Azure Data Lake Storage Gen1:

Eventi

Ottieni gratuitamente la certificazione in Microsoft Fabric.

19 nov, 23 - 10 dic, 23

Per un periodo di tempo limitato, il team della community di Microsoft Fabric offre buoni per esami DP-600 gratuiti.

Prepara ora