Kubernetes nel dispositivo Azure Stack Edge Pro GPU

SI APPLICA A:  Azure Stack Edge Pro - GPU

Azure Stack Edge Pro - GPU Azure Stack Edge Pro 2

Azure Stack Edge Pro 2 Azure Stack Edge Pro R

Azure Stack Edge Pro R Azure Stack Edge Mini R

Azure Stack Edge Mini R

Kubernetes è una piattaforma open source ampiamente diffusa per orchestrare le applicazioni in contenitori. Questo articolo offre una panoramica di Kubernetes e quindi descrive il relativo funzionamento nel dispositivo Azure Stack Edge.

Informazioni su Kubernetes

Kubernetes offre una piattaforma semplice e affidabile per gestire le applicazioni basate su contenitori e i componenti di rete e archiviazione associati. È possibile creare, distribuire e dimensionare rapidamente le app in contenitori con Kubernetes.

In quanto piattaforma aperta, Kubernetes consente di compilare le applicazioni con il linguaggio di programmazione, le librerie del sistema operativo o il bus di messaggistica preferito. Per pianificare e distribuire le versioni, Kubernetes può essere integrato con gli attuali strumenti di integrazione continua e recapito continuo.

Per altre informazioni, vedere Funzionamento di Kubernetes.

Kubernetes su Azure Stack Edge

Nel dispositivo Azure Stack Edge è possibile creare un cluster Kubernetes configurando l'ambiente di calcolo. Quando il ruolo di calcolo è configurato, il cluster Kubernetes, i nodi master e i nodi di lavoro vengono tutti distribuiti e configurati automaticamente. Questo cluster viene quindi usato per la distribuzione del carico di lavoro tramite kubectl, IoT Edge o Azure Arc.

Il dispositivo Azure Stack Edge è disponibile come configurazione a 1 nodo o a 2 nodi (solo per il modello GPU Pro) che costituisce il cluster di infrastruttura. Il cluster Kubernetes è separato dal cluster di infrastruttura e viene distribuito al di sopra di questo. Il cluster di infrastruttura fornisce l'archiviazione permanente per il dispositivo Azure Stack Edge, mentre il cluster Kubernetes è responsabile esclusivamente dell'orchestrazione delle applicazioni.

Il cluster Kubernetes include nodi master e nodi di lavoro. I nodi Kubernetes in un cluster sono macchine virtuali che eseguono le applicazioni e i flussi di lavoro cloud.

Il nodo master di Kubernetes è responsabile di mantenere lo stato desiderato del cluster. Il nodo master controlla anche il nodo di lavoro che a sua volta esegue le applicazioni in contenitori.

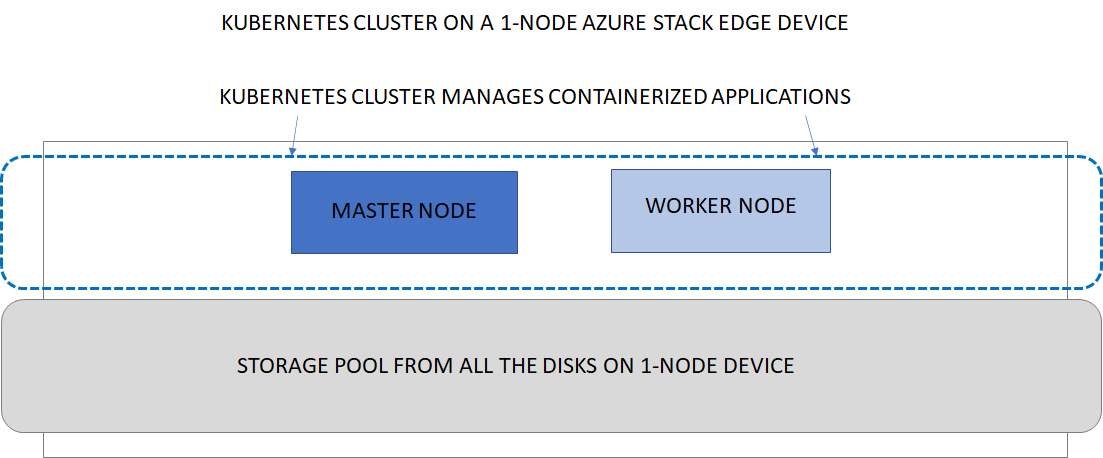

Cluster Kubernetes su dispositivo a nodo singolo

Il diagramma seguente illustra l'implementazione di Kubernetes in un dispositivo Azure Stack Edge a 1 nodo. Il dispositivo a 1 nodo include un nodo master e un nodo di lavoro. Il dispositivo a 1 nodo non è a disponibilità elevata e, in caso di errore del nodo singolo, il dispositivo diventa inattivo. Anche il cluster Kubernetes diventa inattivo.

Cluster Kubernetes su dispositivo a due nodi

Il dispositivo Azure Stack Edge a 2 nodi include un nodo master e due nodi di lavoro. Il dispositivo a 2 nodi è a disponibilità elevata e, in caso di errore di uno dei nodi, il nodo master esegue il failover sull'altro nodo. Sia il dispositivo sia il cluster Kubernetes continuano a funzionare.Per altre informazioni sull'architettura del cluster Kubernetes, vedere Concetti di base di Kubernetes.

Requisiti di calcolo di Kubernetes

I nodi master e di lavoro di Kubernetes sono macchine virtuali che utilizzano CPU e memoria. Quando si distribuiscono carichi di lavoro Kubernetes, è importante comprendere i requisiti di calcolo per le macchine virtuali master e di lavoro.

| Tipo di macchina virtuale Kubernetes | Requisito di CPU e memoria |

|---|---|

| VM master | CPU: 4 core, RAM: 4 GB |

| VM di lavoro | CPU: 30% dei core fisici disponibili, RAM: 25% della specifica del dispositivo |

Provisioning del volume di archiviazione

Per supportare carichi di lavoro delle applicazioni, è possibile montare volumi di archiviazione per dati persistenti nelle condivisioni del dispositivo Azure Stack Edge. È possibile usare volumi sia statici che dinamici.

Per altre informazioni, vedere le opzioni di provisioning dell'archiviazione per le applicazioni in Archiviazione di Kubernetes per il dispositivo Azure Stack Edge.

Rete

Le funzionalità di rete di Kubernetes consentono di configurare la comunicazione all'interno della rete di Kubernetes, tra cui rete da contenitore a contenitore, da pod a pod, da pod a servizio e da Internet a servizio. Per altre informazioni, vedere il modello di rete in Funzionalità di rete di Kubernetes per il dispositivo Azure Stack Edge.

Aggiornamenti

Man mano che diventano disponibili nuove versioni di Kubernetes, è possibile aggiornare il cluster usando gli aggiornamenti standard disponibili per il dispositivo Azure Stack Edge. Per informazioni su come eseguire l'aggiornamento, vedere Applicare gli aggiornamenti per Azure Stack Edge.

Accesso e monitoraggio

Il cluster Kubernetes nel dispositivo Azure Stack Edge consente il controllo degli accessi in base al ruolo di Kubernetes. Per altre informazioni, vedere Controllo degli accessi in base al ruolo di Kubernetes nel dispositivo Azure Stack Edge Pro GPU.

È anche possibile monitorare l'integrità del cluster e delle risorse tramite il dashboard di Kubernetes. Sono disponibili anche i log dei contenitori. Per altre informazioni, vedere Usare il dashboard di Kubernetes per monitorare l'integrità del cluster Kubernetes nel dispositivo Azure Stack Edge.

È anche disponibile Monitoraggio di Azure come componente aggiuntivo per raccogliere dati sull'integrità di contenitori, nodi e controller. Per altre informazioni, vedere Panoramica di Monitoraggio di Azure

Registro contenitori Edge

Kubernetes nel dispositivo Azure Stack Edge consente l'archiviazione privata delle immagini fornendo un registro contenitori locale. Per altre informazioni, vedere Abilitare il registro contenitori Edge nel dispositivo Azure Stack Edge Pro GPU.

Gestione delle applicazioni

Dopo aver creato un cluster Kubernetes nel dispositivo Azure Stack Edge, è possibile gestire le applicazioni distribuite al suo interno tramite uno dei metodi seguenti:

- Accesso nativo tramite

kubectl - IoT Edge

- Azure Arc

Questi metodi vengono illustrati nelle sezioni seguenti.

Kubernetes e kubectl

Dopo aver distribuito il cluster Kubernetes, è possibile gestire le applicazioni distribuite al suo interno localmente da un computer client. Si usa uno strumento nativo, ad esempio kubectl tramite la riga di comando per interagire con le applicazioni.

Per altre informazioni sulla distribuzione del cluster Kubernetes, vedere Distribuire un cluster Kubernetes nel dispositivo Azure Stack Edge. Per informazioni sulla gestione, vedere Usare kubectl per gestire il cluster Kubernetes nel dispositivo Azure Stack Edge.

Kubernetes e Azure Arc

Azure Arc è uno strumento di gestione ibrido che consente di distribuire applicazioni nei cluster Kubernetes. Azure Arc consente anche di usare Monitoraggio di Azure per i contenitori per visualizzare e monitorare i cluster. Per altre informazioni, vedere Che cos'è Kubernetes abilitato per Azure Arc? Per informazioni sui prezzi di Azure Arc, vedere Prezzi di Azure Arc.

A partire da marzo 2021, Kubernetes abilitato per Azure Arc è disponibile a livello generale per gli utenti e si applicano gli addebiti per l'utilizzo standard. Per i clienti privilegiati dell'anteprima, Kubernetes abilitato per Azure Arc sarà disponibile gratuitamente per i dispositivi Azure Stack Edge. Per usufruire dell'offerta di anteprima, creare una richiesta di supporto:

- In Tipo di problema selezionare Fatturazione.

- In Sottoscrizione selezionare la propria sottoscrizione.

- In Servizio selezionare Servizi personali, quindi selezionare Azure Stack Edge.

- Per Risorsa selezionare la risorsa.

- Per Riepilogo digitare una descrizione del problema.

- Per Tipo di problemaselezionare Addebiti imprevisti.

- Per Sottotipo del problemaselezionare Informazioni sugli addebiti per la versione di valutazione gratuita.

Passaggi successivi

- Vedere altre informazioni sull'archiviazione di Kubernetes nel dispositivo Azure Stack Edge.

- Vedere informazioni sul modello di rete di Kubernetes nel dispositivo Azure Stack Edge.

- Distribuire Azure Stack Edge nel portale di Azure.