Come creare una definizione del processo Apache Spark in Fabric

Questa esercitazione illustra come creare una definizione del processo Spark in Microsoft Fabric.

Prerequisiti

Prima di iniziare, sono necessari:

- Un account tenant di Fabric con una sottoscrizione attiva. Creare un account gratuitamente.

Suggerimento

Per eseguire l'elemento di definizione del processo Spark, è necessario disporre di un file di definizione principale e di un contesto lakehouse predefinito. Se non esiste un lakehouse, è possibile crearne uno seguendo i passaggi descritti in Creare un lakehouse.

Creare una definizione di processo Spark

Il processo di creazione della definizione del processo Spark è veloce e semplice; esistono svariati modi per iniziare.

Opzioni per creare una definizione del processo Spark

Vi sono alcuni modi per iniziare a usare il processo di creazione:

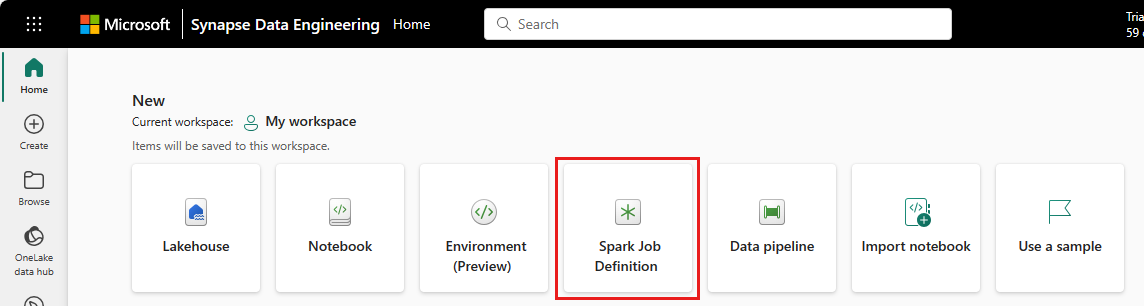

Home page di Ingegneria dei dati: è possibile creare facilmente una definizione del processo Spark tramite la scheda Definizione del processo Spark nella sezione Nuovo della home page.

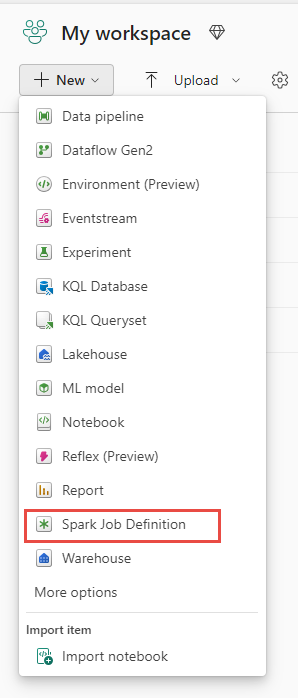

Visualizzazione dell'area di lavoro: è anche possibile creare una definizione del processo Spark tramite l'area di lavoro in Ingegneria dei dati usando il menu a discesa Nuovo.

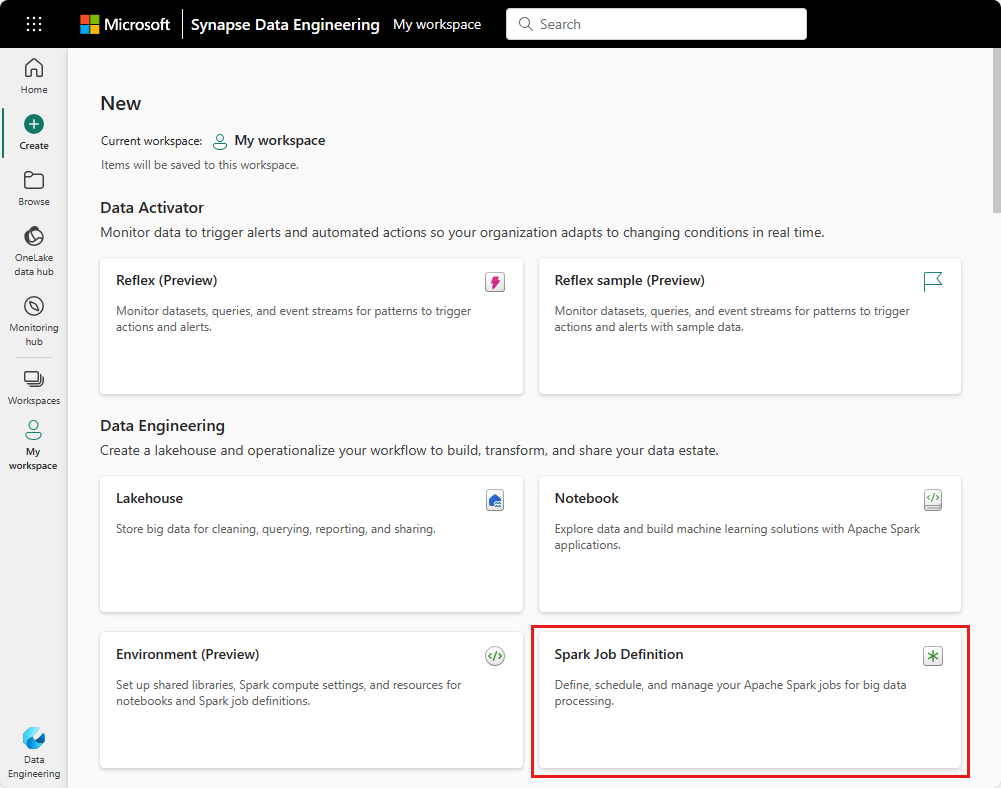

Crea visualizzazione: un altro punto di ingresso per creare una definizione del processo Spark è la pagina Crea in Ingegneria dei dati.

È necessario assegnare un nome alla definizione del processo Spark al momento della creazione. Il nome deve essere univoco nell'area di lavoro corrente. La nuova definizione del processo Spark viene creata nell'area di lavoro corrente.

Creare una definizione del processo Spark per PySpark (Python)

Per creare una definizione del processo Spark per PySpark:

Scaricare il file Parquet di esempio yellow_tripdata_2022-01.parquet e caricarlo nella sezione dei file del lakehouse.

Creare una nuova definizione del processo Spark.

Selezionare PySpark (Python) dal menu a discesa Lingua.

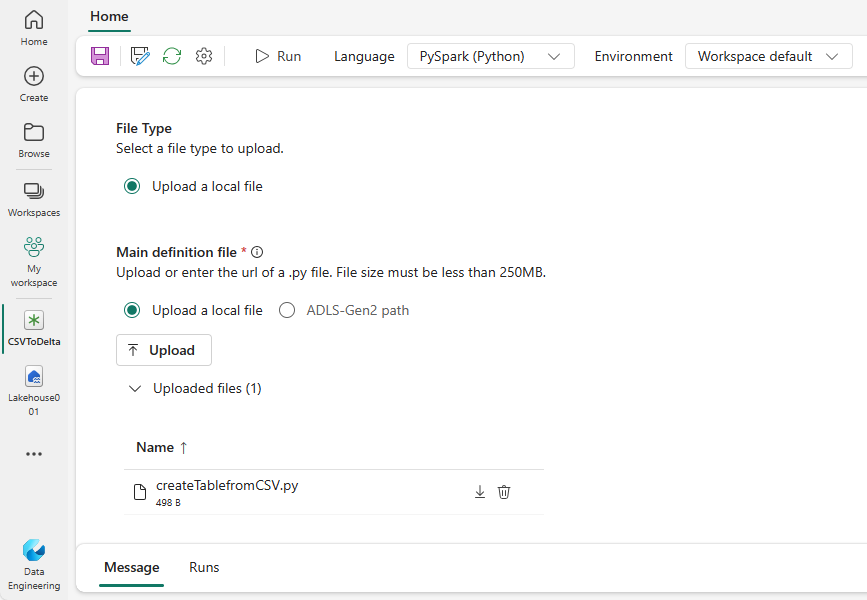

Scaricare l'esempio createTablefromParquet.py e caricarlo come file di definizione principale. Il file di definizione principale (job.Main) è il file che contiene la logica dell'applicazione ed è obbligatorio per eseguire un processo Spark. Per ogni definizione del processo Spark, è possibile caricare un solo file di definizione principale.

È possibile caricare il file di definizione principale dal desktop locale oppure caricare da un'istanza di Azure Data Lake Storage (ADLS) Gen2 esistente specificando il percorso ABFSS completo del file. Ad esempio:

abfss://your-storage-account-name.dfs.core.windows.net/your-file-path.Caricare i file di riferimento come file .py. I file di riferimento sono i moduli Python importati dal file di definizione principale. Proprio come il file di definizione principale, si possono caricare dal desktop o da un ADLS Gen2 esistente. Sono supportati molteplici file di riferimento.

Suggerimento

Se si usa un percorso ADLS Gen2, per assicurarsi che il file sia accessibile, è necessario assegnare all'account utente che esegue il processo l'autorizzazione appropriata per l'account di archiviazione. È consigliabile procedere in due modi diversi:

- Assegnare all'account utente un ruolo Contributore per l'account di archiviazione.

- Concedere l'autorizzazione di lettura ed esecuzione all'account utente per il file tramite l'elenco di controllo di accesso (ACL) ADLS Gen2.

Per un'esecuzione manuale, l'account dell'utente connesso attuale viene usato per eseguire il processo.

Fornire gli argomenti della riga di comando per il processo, se necessario. Usare uno spazio come una barra di divisione per separare gli argomenti.

Aggiungere il riferimento del lakehouse al processo. È necessario avere almeno un riferimento del lakehouse aggiunto al processo. Questo lakehouse è il contesto lakehouse predefinito per il processo.

Sono supportati molteplici riferimenti del lakehouse. Cercare il nome del lakehouse non predefinito e l'URL di OneLake completo nella pagina Impostazioni Spark.

Creare una definizione del processo Spark per Scala/Java

Per creare una definizione del processo Spark per Scala/Java:

Creare una nuova definizione del processo Spark.

Selezionare Spark(Scala/Java) dal menu a discesa Lingua.

Caricare il file di definizione principale come file .jar. Il file di definizione principale è il file che contiene la logica dell'applicazione di questo processo ed è obbligatorio per eseguire un processo Spark. Per ogni definizione del processo Spark, è possibile caricare un solo file di definizione principale. Fornire il nome della classe principale.

Caricare i file di riferimento come file .jar. I file di riferimento sono i file a cui viene fatto riferimento/che vengono importati dal file di definizione principale.

Fornire gli argomenti della riga di comando per il processo, se necessario.

Aggiungere il riferimento del lakehouse al processo. È necessario avere almeno un riferimento del lakehouse aggiunto al processo. Questo lakehouse è il contesto lakehouse predefinito per il processo.

Creare una definizione del processo Spark per R

Per creare una definizione del processo SparkR(R):

Creare una nuova definizione del processo Spark.

Selezionare SparkR(R) nel menu a discesa Lingua.

Caricare il file di definizione principale come file R. Il file di definizione principale è il file che contiene la logica dell'applicazione di questo processo ed è obbligatorio per eseguire un processo Spark. Per ogni definizione del processo Spark, è possibile caricare un solo file di definizione principale.

Caricare i file di riferimento come file R. I file di riferimento sono i file a cui viene fatto riferimento/che vengono importati dal file di definizione principale.

Fornire gli argomenti della riga di comando per il processo, se necessario.

Aggiungere il riferimento del lakehouse al processo. È necessario avere almeno un riferimento del lakehouse aggiunto al processo. Questo lakehouse è il contesto lakehouse predefinito per il processo.

Nota

La definizione del processo Spark verrà creata nell'area di lavoro corrente.

Opzioni per personalizzare le definizioni del processo Spark

Sono disponibili alcune opzioni per personalizzare ulteriormente l'esecuzione delle definizioni del processo Spark.

- Calcolo Spark: nella scheda Calcolo Spark, si può vedere la versione run-time, ossia la versione di Spark che verrà usata per eseguire il processo. È anche possibile vedere le impostazioni di configurazione di Spark che verranno usate per eseguire il processo. È possibile personalizzare le impostazioni di configurazione di Spark facendo clic sul pulsante Aggiungi.

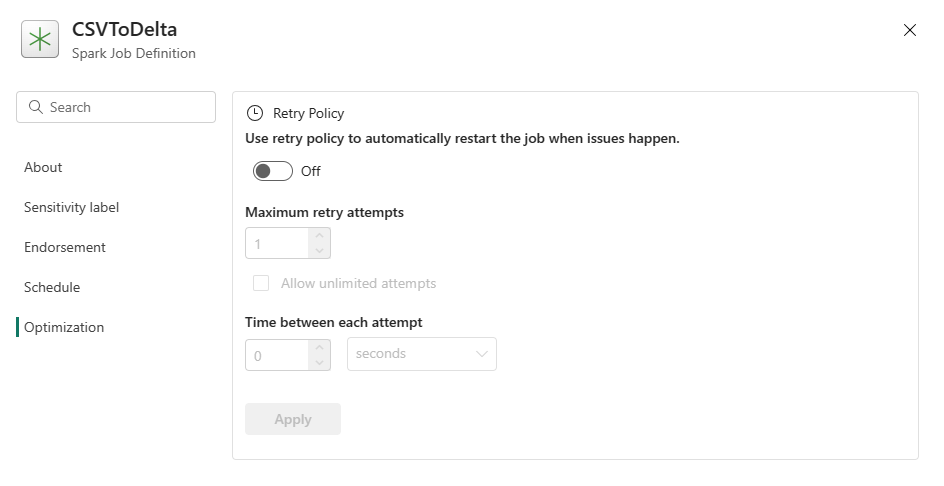

Ottimizzazione: nella scheda Ottimizzazione, è possibile abilitare e configurare i criteri di ripetizione per il processo. Se abilitato, il processo viene ritentato in caso di errore. È anche possibile impostare il numero massimo di tentativi e l'intervallo tra i nuovi tentativi. Per ogni tentativo di ripetizione, il processo viene riavviato. Assicurarsi che il processo sia idempotente.