Architettura della soluzione BI nel COE (Center of Excellence)

Questo articolo è destinato ai professionisti IT e ai responsabili IT. Verranno fornite informazioni sull'architettura della soluzione BI nel COE e sulle diverse tecnologie adottate. Le tecnologie includono Azure, Power BI ed Excel. Nel loro insieme possono essere sfruttate per offrire una piattaforma BI cloud basata sui dati e scalabile.

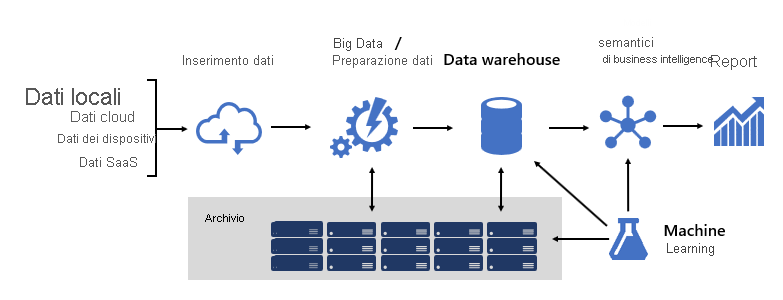

La progettazione di una solida piattaforma BI può essere paragonata alla costruzione di un ponte che connette dati di origine trasformati e arricchiti ai consumer di dati. La progettazione di una struttura di tale complessità richiede una mentalità tecnica, sebbene possa trattarsi di una delle architetture IT più creative e gratificanti da progettare. In un'organizzazione di grandi dimensioni, un'architettura della soluzione BI può essere costituita da:

- Origini dati

- Inserimento dati

- Preparazione dati/Big data

- Data warehouse

- Modelli semantici di BI

- Report

La piattaforma deve supportare specifiche richieste. In particolare, deve offrire livelli di scalabilità e prestazioni in grado di soddisfare le aspettative dei servizi aziendali e dei consumer di dati. Allo stesso tempo, deve essere sicura su tutti i livelli. Deve anche essere sufficientemente resiliente da adattarsi ai cambiamenti, perché è una certezza che nel tempo sarà necessario portare online nuovi dati e nuove aree di interesse.

Framework

In Microsoft, fin dall'inizio, è stato adottato un approccio simile a quello per i sistemi, investendo nello sviluppo di framework. I framework tecnici e per i processi aziendali aumentano le possibilità di riutilizzo della progettazione e della logica e consentono di ottenere risultati coerenti. Offrono anche flessibilità nell'architettura sfruttando molte tecnologie e semplificano e riducono il sovraccarico tecnico grazie a processi ripetibili.

Si è appurato che i framework ben progettati migliorano la visibilità per derivazione dei dati, analisi dell'impatto, manutenzione della logica di business, gestione della tassonomia ed efficacia della governance. Inoltre, lo sviluppo è diventato più veloce e la collaborazione tra team numerosi è diventata più reattiva ed efficace.

In questo articolo verranno descritti molti dei framework adottati da Microsoft.

Modelli di dati

I modelli di dati consentono di controllare le modalità di strutturazione dei dati e di accesso. Per i servizi aziendali e i consumer di dati, i modelli di dati rappresentano l'interfaccia con la piattaforma BI.

Una piattaforma BI può fornire tre diversi tipi di modelli:

- Modelli aziendali

- Modelli semantici di BI

- Modelli di Machine Learning

Modelli aziendali

I modelli aziendali vengono creati e gestiti dagli architetti IT. Sono talvolta noti anche come modelli dimensionali o data mart. In genere, i dati vengono archiviati in formato relazionale come tabelle delle dimensioni e dei fatti. Queste tabelle archiviano i dati puliti e arricchiti consolidati da molti sistemi e rappresentano un'origine autorevole per la creazione di report e l'analisi.

I modelli aziendali rendono disponibile una singola origine dati coerente per la creazione di report e BI. Vengono creati una sola volta e condivisi come standard aziendale. I criteri di governance assicurano che i dati siano sicuri, quindi l'accesso a set di dati sensibili, ad esempio informazioni sui clienti o finanziarie, viene limitato in base alle specifiche esigenze. Adottano convenzioni di denominazione che garantiscono la coerenza, consolidando ulteriormente la credibilità e la qualità dei dati.

In una piattaforma BI cloud i modelli aziendali possono essere distribuiti in un pool Synapse SQL in Azure Synapse. Il pool Synapse SQL diventa quindi la singola versione della verità su cui l'organizzazione può contare per ottenere informazioni cognitive dettagliate rapide e affidabili.

Modelli semantici di BI

I modelli semantici di BI rappresentano un livello semantico sovrapposto ai modelli aziendali. Vengono creati e gestiti da sviluppatori di BI e utenti aziendali. Gli sviluppatori di BI creano modelli semantici di BI di base che ricavano i dati dai modelli aziendali. Gli utenti aziendali possono creare modelli indipendenti di dimensioni minori oppure possono estendere i modelli semantici di BI di base con origini esterne o di reparto. I modelli semantici di BI sono in genere incentrati su una singola area di interesse e spesso sono ampiamente condivisi.

Le capacità aziendali non sono supportate solo dai dati, ma anche da modelli semantici di BI che descrivono concetti, relazioni, regole e standard. In questo modo, rappresentano strutture intuitive e di facile comprensione che definiscono le relazioni tra i dati e incapsulano le regole aziendali in forma di calcoli. Possono anche imporre autorizzazioni per i dati con granularità fine, assicurando che le persone giuste abbiano accesso ai dati corretti. In particolare, accelerano le prestazioni delle query, offrendo funzionalità di analisi interattiva estremamente reattive, anche su terabyte di dati. Analogamente ai modelli aziendali, i modelli semantici di BI adottano convenzioni di denominazione che garantiscono la coerenza.

In una piattaforma BI cloud, gli sviluppatori di BI possono distribuire modelli semantici di BI in Azure Analysis Services o in capacità di Power BI Premium di capacità Microsoft Fabric.

Importante

A volte questo articolo si riferisce a Power BI Premium o alle relative sottoscrizioni di capacità (SKU P). Tenere presente che Microsoft sta attualmente consolidando le opzioni di acquisto e ritirando gli SKU di Power BI Premium per capacità. I clienti nuovi ed esistenti devono invece prendere in considerazione l'acquisto di sottoscrizioni con capacità Fabric (SKU F).

Per altre informazioni, vedere Aggiornamento importante disponibile per le licenze Power BI Premium e Domande frequenti su Power BI Premium.

Si consiglia la distribuzione in Power BI quando rappresenta il livello di report e analisi usato in azienda. Questi prodotti supportano modalità di archiviazione diverse, consentendo alle tabelle del modello di dati di memorizzare nella cache i dati o di usare DirectQuery, ovvero una tecnologia che esegue il pass-through delle query all'origine dati sottostante. DirectQuery è una modalità di archiviazione ideale quando le tabelle del modello rappresentano grandi volumi di dati o se è necessario fornire risultati in tempo quasi reale. Le due modalità di archiviazione possono essere combinate: i modelli compositi combinano tabelle che usano modalità di archiviazione diverse in un singolo modello.

Per i modelli usati in modo intensivo per le query, è possibile usare Azure Load Balancer per distribuire uniformemente il carico delle query tra repliche del modello. Sono anche supportate la scalabilità delle applicazioni e la creazione di modelli semantici di BI a disponibilità elevata.

Modelli di Machine Learning

I modelli di Machine Learning (ML) vengono creati e gestiti dai data scientist e sono sviluppati principalmente da origini non elaborate nel data lake.

I modelli di Machine Learning sottoposti a training possono rivelare modelli all'interno dei dati. In molti casi, questi modelli possono essere usati per eseguire stime utilizzabili per arricchire i dati. È ad esempio possibile basarsi sui comportamenti di acquisto per stimare l'abbandono dei clienti o segmentarli. I risultati della stima possono essere aggiunti ai modelli aziendali per consentire l'analisi in base al segmento del cliente.

In una piattaforma BI cloud è possibile usare Azure Machine Learning per eseguire il training, la distribuzione, l'automazione, la gestione e il monitoraggio dei modelli di Machine Learning.

Data warehouse

Il fulcro di una piattaforma BI è il data warehouse, che ospita i modelli aziendali. Si tratta di un'origine di dati approvati, come sistema di record e come hub, che rende disponibili i modelli aziendali per attività di creazione di report, BI e data science.

Molti servizi aziendali, incluse le applicazioni line-of-business (LOB), possono affidarsi al data warehouse come fonte autorevole e governata di conoscenze aziendali.

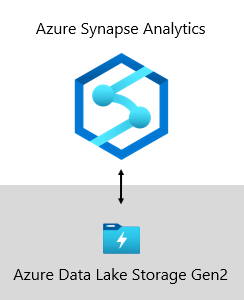

Il data warehouse di Microsoft è ospitato in Azure Data Lake Storage Gen2 (ADLS Gen2) e Azure Synapse Analytics.

- ADLS Gen2 usa Archiviazione di Azure come base per la creazione di data lake aziendali in Azure. È progettato per gestire l'archiviazione di petabyte di informazioni e allo stesso tempo sostenere una velocità effettiva di centinaia di gigabit. Offre anche capacità di archiviazione e transazioni a basso costo. Se non bastasse, supporta anche l'accesso compatibile con Hadoop, che consente di gestire i dati e accedervi esattamente come si farebbe con un file system HDFS (Hadoop Distributed File System). Infatti, Azure HDInsight, Azure Databricks e Azure Synapse Analytics supportano tutti l'accesso a dati archiviati in ADLS Gen2. In una piattaforma BI è quindi appropriato archiviare dati di origine non elaborati, dati semielaborati o di staging e dati pronti per l'ambiente di produzione. Microsoft usa questo tipo di piattaforma per archiviare tutti i dati aziendali.

- Azure Synapse Analytics è un servizio di analisi che riunisce funzionalità aziendali di data warehouse e analisi di Big Data. Offre la libertà di eseguire query sui dati in base alle proprie esigenze, usando risorse serverless su richiesta o con provisioning, su larga scala. Synapse SQL, un componente di Azure Synapse Analytics, supporta analisi complete basate su T-SQL, quindi è ideale per ospitare i modelli aziendali che includono le tabelle delle dimensioni e dei fatti. Le tabelle possono essere caricate in modo efficiente da ADLS Gen2 usando semplici query T-SQL Polybase. È quindi possibile sfruttare la potenza di MPP per eseguire analisi con prestazioni elevate.

Framework di Motore regole di business

È stato sviluppato un framework di Motore regole di business per catalogare qualsiasi logica di business che possa essere implementata nel livello del data warehouse. Possono essere molte le funzionalità di un Motore regole di business, ma nel contesto di un data warehouse è utile per la creazione di colonne calcolate nelle tabelle relazionali. Queste colonne calcolate sono in genere rappresentate come calcoli matematici o espressioni mediante istruzioni condizionali.

L'intento è dividere la logica di business dal codice BI di base. Tradizionalmente, le regole di business sono hardcoded nelle stored procedure SQL, quindi sono spesso necessarie misure complicate per la loro manutenzione in caso di variazioni delle esigenze aziendali. In un Motore regole di business, le regole di business vengono definite una sola volta e usate più volte quando applicate a entità data warehouse diverse. Se è necessario modificare la logica di calcolo, sarà sufficiente aggiornarla in un'unica posizione e non in numerose stored procedure. Esiste anche un vantaggio collaterale: un framework del Motore regole di business fornisce trasparenza e visibilità nella logica di business implementata, che può essere esposta tramite un set di report che creano la documentazione ad aggiornamento automatico.

Origini dati

Un data warehouse è in grado di consolidare i dati praticamente da qualsiasi origine dati. Si basa principalmente su origini dati LOB, che sono in genere database relazionali che archiviano dati specifici del soggetto per vendite, marketing, finanze e così via. Questi database possono essere ospitati nel cloud o possono risiedere in locale. Altre origini dati possono essere basate su file, in particolare i log Web o i dati IoT originati dai dispositivi. I dati possono anche provenire da fornitori di SaaS (Software-as-a-Service).

Alcuni dei sistemi interni di Microsoft inviano i dati operativi di output direttamente ad ADLS Gen2 usando formati di file non elaborati. Oltre al data lake, altri sistemi di origine di Microsoft comprendono applicazioni LOB relazionali, cartelle di lavoro di Excel, altre origini basate su file, nonché repository di gestione dei dati master (MDM) e di dati personalizzati. I repository MDM consentono a Microsoft di gestire i dati master per garantire versioni autorevoli, standardizzate e convalidate dei dati.

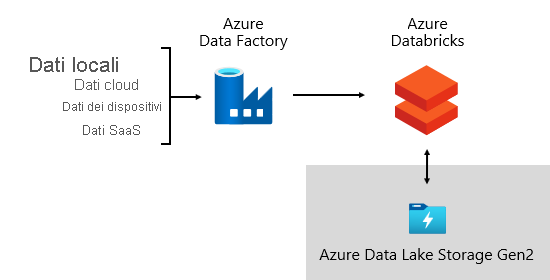

Inserimento dati

Periodicamente, e in base ai ritmi dell'azienda, i dati vengono inseriti dai sistemi di origine e caricati nel data warehouse. L'operazione può avvenire una volta al giorno o a intervalli più frequenti. L'inserimento dei dati riguarda l'estrazione, la trasformazione e il caricamento dei dati (ETL) o anche la direzione opposta: estrazione, caricamento e trasformazione dei dati. La differenza dipende dalla posizione in cui avviene la trasformazione. Vengono applicate trasformazioni per pulizia, conformità, integrazione e standardizzazione dei dati. Per altre informazioni, vedere ETL (Extract, Transform, and Load).

L'obiettivo è alla fine caricare i dati corretti nel modello aziendale nel modo più rapido ed efficiente possibile.

Microsoft usa Azure Data Factory (ADF). I servizi vengono usati per pianificare e orchestrare le convalide dei dati, le trasformazioni e i caricamenti bulk da sistemi di origine esterni nel data lake. Viene gestito da framework personalizzati per elaborare i dati in parallelo e su larga scala. Inoltre, è prevista una registrazione completa per supportare la risoluzione dei problemi, il monitoraggio delle prestazioni e l'attivazione di notifiche di avviso quando vengono soddisfatte determinate condizioni.

Nel frattempo, Azure Databricks, ovvero le piattaforme di analisi basate su Apache Spark ottimizzate per la piattaforma di servizi cloud di Azure, si occupa delle trasformazioni specifiche per le attività di data science. Consente inoltre di creare ed eseguire i modelli di Machine Learning tramite notebook Python. I punteggi da questi modelli di Machine Learning vengono caricati nel data warehouse per integrare le stime con le applicazioni e i report aziendali. Dato che Azure Databricks accede direttamente ai file del data lake, elimina o riduce al minimo la necessità di copiare o acquisire i dati.

Framework di inserimento dati

È stato sviluppato un framework di inserimento dati come set di tabelle e procedure di configurazione. Supporta un approccio basato sui dati per l'acquisizione di grandi volumi di dati a velocità elevata e con codice minimo. In breve, questo framework semplifica il processo di acquisizione dei dati per il caricamento nel data warehouse.

Il framework dipende dalle tabelle di configurazione in cui sono archiviate le informazioni relative all'origine dati e alla destinazione dei dati, ad esempio il tipo di origine, il server, il database, lo schema e i dettagli correlati alle tabelle. Questo approccio di progettazione significa che non è necessario sviluppare pipeline ADF specifiche o pacchetti di SQL Server Integration Services (SSIS). Le procedure vengono invece scritte nel linguaggio prescelto per creare pipeline ADF generate ed eseguite in modo dinamico in fase di esecuzione. L'acquisizione dei dati diventa quindi un esercizio di configurazione facile da rendere operativo. Tradizionalmente, sarebbero necessarie molte risorse di sviluppo per creare pacchetti ADF o SSIS hardcoded.

Il framework di inserimento dati è stato progettato anche per semplificare il processo di gestione delle modifiche dello schema di origine upstream. È facile aggiornare i dati di configurazione, manualmente o automaticamente, quando vengono rilevate modifiche dello schema per acquisire i nuovi attributi aggiunti nel sistema di origine.

Framework di orchestrazione

È stato sviluppato un framework di orchestrazione per rendere operative le pipeline di dati e orchestrarle. Questo framework usa una progettazione basata sui dati che dipende da un set di tabelle di configurazione. In queste tabelle vengono archiviati i metadati che descrivono le dipendenze della pipeline e come eseguire il mapping dei dati di origine alle strutture di dati di destinazione. L'investimento per lo sviluppo di questo framework adattivo è stato molto fruttuoso: non è più un requisito gestire come hardcoded ogni spostamento dei dati.

Archiviazione di dati

Un data lake può archiviare volumi elevati di dati non elaborati per un uso successivo insieme alle trasformazioni dei dati di staging.

Microsoft usa ADLS Gen2 come unica fonte di verità. Questo servizio archivia i dati non elaborati insieme ai dati di staging e ai dati pronti per la produzione. Offre una soluzione per data lake a scalabilità elevata ed economicamente conveniente per l'analisi dei Big Data. Combinando la potenza di un file system a prestazioni elevate con scalabilità elevata, è ottimizzato per i carichi di lavoro analitici dei dati, accelerando i tempi per ottenere informazioni cognitive dettagliate.

ADLS Gen2 offre il meglio di due mondi: l'archiviazione BLOB e uno spazio dei nomi del file system a prestazioni elevate, configurato con autorizzazioni di accesso con granularità fine.

I dati perfezionati vengono quindi archiviati in un database relazionale per fornire un archivio dati ad alte prestazioni e altamente scalabile per i modelli aziendali, con sicurezza, governance e gestibilità. I data mart specifici del soggetto vengono archiviati in Azure Synapse Analytics, e caricati da Azure Databricks o da query T-SQL Polybase.

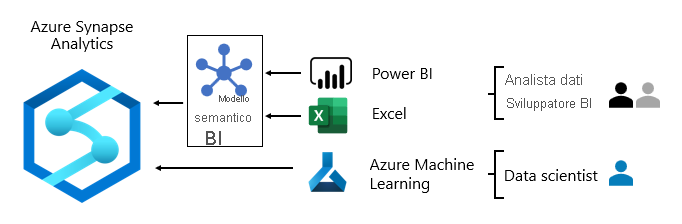

Consumo di dati

A livello di report, i servizi aziendali utilizzano dati aziendali originati dal data warehouse. Accedono anche ai dati direttamente nel data lake per attività di analisi o data science ad hoc.

Le autorizzazioni con granularità fine vengono applicate a tutti i livelli: nel data lake, nei modelli aziendali e nei modelli semantici di BI. Le autorizzazioni assicurano che i consumer di dati possano visualizzare solo i dati per cui dispongono dei diritti di accesso.

Microsoft usa report e dashboard di Power BI oltre a report impaginati di Power BI. Alcuni report e analisi ad hoc vengono eseguiti in Excel, in particolare per la creazione di report finanziari.

Vengono pubblicati dizionari dei dati, che offrono informazioni di riferimento sui modelli di dati e vengono resi disponibili agli utenti in modo che possano individuare informazioni sulla piattaforma BI. I dizionari documentano le progettazioni de modelli, fornendo descrizioni di entità, formati, struttura, derivazione dei dati, relazioni e calcoli. Microsoft usa Azure Data Catalog per rendere facilmente individuabili e comprensibili le origini dati.

In genere, i modelli di utilizzo dei dati variano in base al ruolo:

- Gli analisti dei dati si connettono direttamente ai modelli semantici di BI di base. Quando i modelli semantici di BI base contengono tutti i dati e la logica necessari, usano le connessioni in tempo reale per creare report e dashboard di Power BI. Quando è necessario estendere i modelli con i dati di reparto, creano modelli compositi di Power BI. Se sono necessari report in formato foglio di calcolo, viene usato Excel per produrre report basati sui modelli semantici di BI di base o sui modelli semantici di BI di reparto.

- Gli sviluppatori di BI e gli autori di report operativi si connettono direttamente ai modelli aziendali. Usano Power BI Desktop per creare report di analisi a connessione dinamica. Possono anche creare report di BI di tipo operativo in forma di report impaginati di Power BI, scrivendo query SQL native per accedere ai dati dai modelli aziendali di Azure Synapse Analytics usando T-SQL o modelli semantici di Power BI usando DAX o MDX.

- I data scientist si connettono direttamente ai dati nel data lake. Usano Azure Databricks e notebook Python per sviluppare modelli di Machine Learning, che sono spesso sperimentali e richiedono competenze speciali per l'uso in produzione.

Contenuto correlato

Per altre informazioni su questo articolo, consultare le risorse seguenti:

- Roadmap per l'adozione dell'infrastruttura: Centro di eccellenza

- Business intelligence aziendale in Azure con Azure Synapse Analytics

- Domande? Contattare la community di Power BI

- inviare suggerimenti, Contribuire con idee per migliorare Power BI

Servizi professionali

Sono disponibili partner Power BI certificati per aiutare le organizzazioni ad allestire correttamente un COE. Possono fornire soluzioni di formazione a prezzi vantaggiosi oppure eseguire un audit dei dati. Per collaborare con un partner Power BI, visitare il portale dei partner Power BI.

È anche possibile coinvolgere partner di consulenza esperti, in grado di esaminare, valutare o implementare Power BI.