Distribuire e gestire istanze locali di Azure in VMM

Questo articolo fornisce informazioni su come configurare un'istanza locale di Azure in System Center Virtual Machine Manager (VMM). È possibile distribuire un'istanza locale di Azure effettuando il provisioning da server bare metal o aggiungendo host esistenti. Scopri di più sulla nuova Azure Local.

VMM 2022 supporta Azure Local, versione 22H2 (supportato da VMM 2022 UR1).

VMM 2019 Update Rollup 3 (UR3) supporta Azure Stack HCI versione 20H2. Il prodotto attuale è Azure Local, versione 23H2.

Importante

Le istanze locali di Azure gestite da Virtual Machine Manager non devono ancora essere unite il canale di anteprima. System Center (inclusi Virtual Machine Manager, Operations Manager e altri componenti) attualmente non supporta le versioni di anteprima locale di Azure. Per gli aggiornamenti più recenti, vedere il blog di System Center.

Prima di iniziare

Assicurarsi di eseguire VMM 2019 UR3 o versione successiva.

Che cos'è supportato?

Aggiunta, creazione e gestione delle istanze locali di Azure. Vedere i passaggi dettagliati per creare e gestire istanze locali di Azure.

Possibilità di effettuare il provisioning e la distribuzione di macchine virtuali nelle istanze locali di Azure ed eseguire operazioni del ciclo di vita delle macchine virtuali. È possibile effettuare il provisioning delle macchine virtuali usando file VHD(x), modelli o da una macchina virtuale esistente. Altre informazioni.

Distribuzione e gestione del controller di rete SDN nelle istanze locali di Azure.

Gestione delle impostazioni del pool di archiviazione, creazione di dischi virtuali, creazione di volumi condivisi cluster e applicazione delle impostazioni QoS.

Lo spostamento delle macchine virtuali tra Windows Server e le istanze locali di Azure avviene tramite la migrazione di rete e la migrazione di una macchina virtuale offline (spenta). In questo scenario VMM esegue l'esportazione e l'importazione in background, anche se viene eseguita come singola operazione.

I cmdlet di PowerShell usati per gestire i cluster Windows Server possono essere usati anche per gestire le istanze locali di Azure.

Assicurarsi di eseguire VMM 2022 UR1 o versione successiva.

Che cos'è supportato?

Aggiunta, creazione e gestione delle istanze locali di Azure. Vedere i passaggi dettagliati per creare e gestire istanze locali di Azure.

Possibilità di effettuare il provisioning e la distribuzione di macchine virtuali nelle istanze locali di Azure ed eseguire operazioni del ciclo di vita delle macchine virtuali. È possibile effettuare il provisioning delle macchine virtuali usando file VHD(x), modelli o da una macchina virtuale esistente. Altre informazioni.

Distribuzione e gestione del controller di rete SDN nelle istanze locali di Azure.

Gestione delle impostazioni del pool di archiviazione, creazione di dischi virtuali, creazione di volumi condivisi cluster e applicazione delle impostazioni QoS.

Lo spostamento di macchine virtuali tra Windows Server e le istanze locali di Azure avviene tramite la migrazione di rete e la migrazione di una macchina virtuale offline (spenta). In questo scenario VMM esegue l'esportazione e l'importazione in background, anche se viene eseguita come singola operazione.

I cmdlet di PowerShell usati per gestire i cluster Windows Server possono essere usati anche per gestire le istanze locali di Azure.

Registrare e annullare la registrazione delle istanze locali di Azure

Con VMM 2022 vengono introdotti i cmdlet di PowerShell VMM per registrare e annullare la registrazione delle istanze locali di Azure.

Usare i cmdlet seguenti per registrare un'istanza locale di Azure:

Register-SCAzStackHCI -VMHostCluster <HostCluster> -SubscriptionID <string>

Usare il comando seguente per annullare la registrazione di un cluster:

Unregister-SCAzStackHCI -VMHostCluster <HostCluster> -SubscriptionID <string>

Per informazioni dettagliate sul parametro supportato, vedere Register-SCAzStackHCI e Unregister-SCAzStackHCI.

Cosa non è supportato?

La gestione dei cluster estesi locali di Azure non è attualmente supportata in VMM.

I computer locali di Azure sono progettati come host di virtualizzazione in cui vengono eseguiti tutti i carichi di lavoro nelle macchine virtuali. I termini locali di Azure consentono di eseguire solo gli elementi necessari per l'hosting di macchine virtuali. Le istanze locali di Azure non devono essere usate per altri scopi, ad esempio server WSUS, server WDS o server di libreria. Fare riferimento a Casi d'uso per l'Azure Locale, a Quando usare l'Azure Locale, e a Ruoli che è possibile eseguire senza virtualizzare nell'Azure Locale.

La migrazione in tempo reale tra qualsiasi versione di Windows Server e istanze locali di Azure non è supportata.

Nota

La migrazione in tempo reale tra istanze locali di Azure funziona, nonché tra cluster Windows Server.

- L'unico tipo di archiviazione disponibile per Azure Local è Storage Spaces Direct (S2D). La creazione o la gestione di un cluster non S2D con computer locali di Azure non è supportata. Se è necessario usare qualsiasi altro tipo di spazio di archiviazione, ad esempio le reti SAN, usare Windows Server come host di virtualizzazione.

Nota

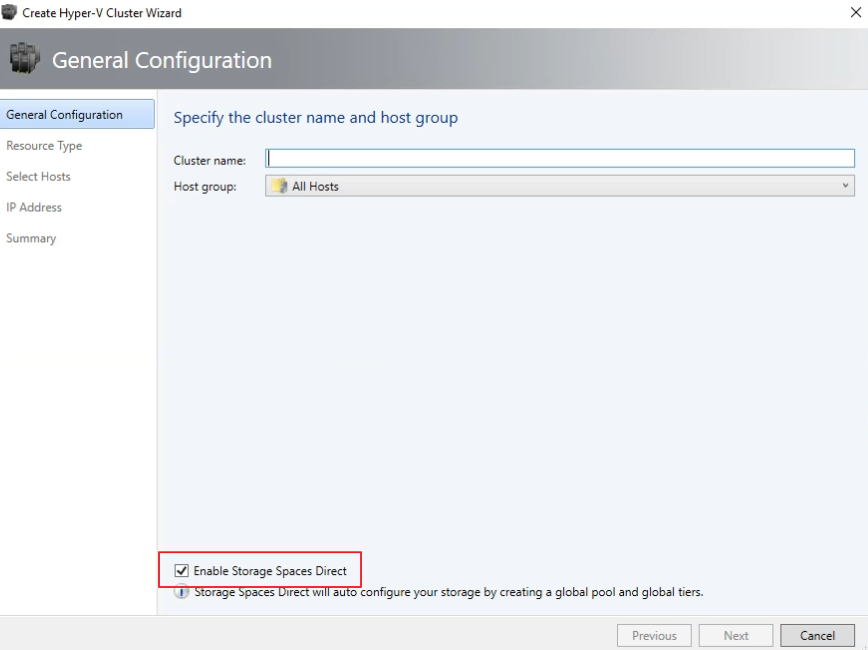

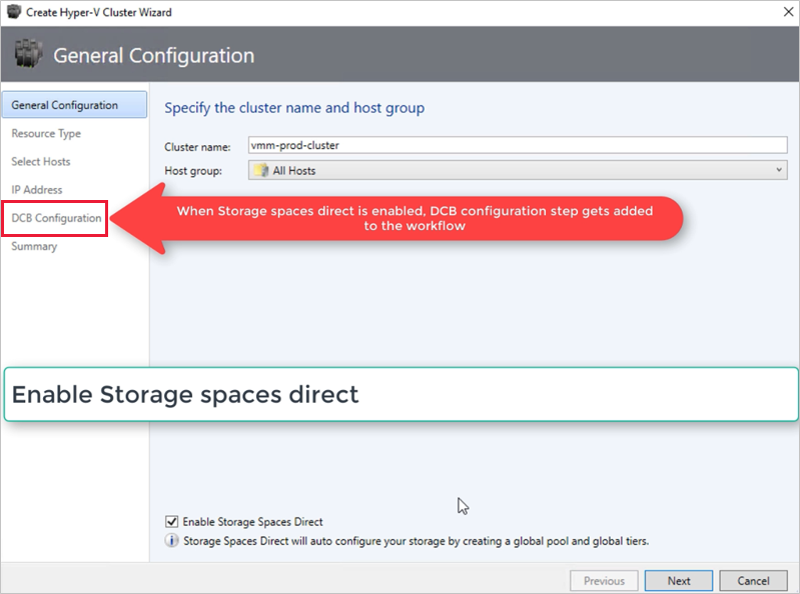

È necessario abilitare S2D durante la creazione di un'istanza locale di Azure. Per abilitare S2D, nella creazione guidata del cluster passare a Configurazione generale. In Specificare il nome del cluster e il gruppo host selezionare Abilita Spazi di archiviazione diretta come illustrato di seguito:

Dopo aver abilitato un cluster con S2D, VMM esegue le operazioni seguenti:

- La funzionalità Clustering di failover è abilitata.

- La replica di archiviazione e la deduplicazione dei dati sono abilitate.

- Il cluster viene facoltativamente convalidato e creato.

- S2D è abilitato e in VMM viene creato un oggetto array di archiviazione con lo stesso nome specificato nella procedura guidata.

Quando si usa VMM per creare un cluster iperconvergente, il pool e i livelli di archiviazione vengono creati automaticamente eseguendo Enable-ClusterStorageSpacesDirect -Autoconfig $True.

Dopo aver stabilito questi prerequisiti, effettuare il provisioning di un cluster e configurare le risorse di archiviazione. È quindi possibile distribuire macchine virtuali nel cluster.

Seguire questa procedura:

Passaggio 1: Effettuare il provisioning del cluster

È possibile effettuare il provisioning di un cluster da host Hyper-V e computer bare metal:

Effettuare il provisioning di un cluster da host Hyper-V

Se è necessario aggiungere le macchine locali di Azure all'infrastruttura VMM, seguire questa procedura. Se si trovano già nell'infrastruttura VMM, passare al passaggio successivo.

Nota

- Quando si configura il cluster, selezionare l'opzione Abilita Spazi di archiviazione diretta nella pagina Configurazione generale della creazione guidata cluster Hyper-V.

- In Tipo di risorsa selezionare Server esistenti che eseguono un sistema operativo Windows Server e selezionare gli host Hyper-V da aggiungere al cluster.

- Tutti gli host selezionati devono avere installato Azure Local.

- Poiché S2D è abilitato, il cluster deve essere convalidato.

Effettuare il provisioning di un cluster da computer bare metal

Nota

In genere, il nodo S2D richiede impostazioni RDMA, QoS e SET. Per configurare queste impostazioni per un nodo usando computer bare metal, è possibile usare la funzionalità script post-distribuzione in PCP. Ecco lo script di post-distribuzione PCP di esempio. È anche possibile usare questo script per configurare RDMA, QoS e SET durante l'aggiunta di un nuovo nodo a una distribuzione S2D esistente da computer bare metal.

- Leggere i prerequisiti per la distribuzione di cluster bare metal.

Nota

- Il disco rigido virtuale generalizzato o VHDX nella libreria VMM deve eseguire Azure Stack HCI con gli aggiornamenti più recenti. I valori della piattaforma sistema operativo e della piattaforma di virtualizzazione per il disco rigido devono essere impostati.

- Per la distribuzione bare metal, è necessario aggiungere un server PXE (Pre-Boot Execution Environment) all'infrastruttura VMM. Il server PXE viene fornito tramite Servizi di distribuzione Windows. VMM usa la propria immagine WinPE ed è necessario assicurarsi che sia la più recente. A tale scopo, selezionare >>Infrastruttura Update WinPE immagine e assicurarsi che il processo venga completato.

- Seguire le istruzioni per il provisioning di un cluster da computer bare metal.

Passaggio 2: Configurare la rete per il cluster

Dopo il provisioning e la gestione del cluster nell'infrastruttura VMM, è necessario configurare la rete per i nodi del cluster.

- Per iniziare, creare una rete logica per eseguire il mirroring della rete di gestione fisica.

- È necessario configurare un commutatore logico con Switch Embedded Teaming (SET) abilitato in modo che il commutatore sia a conoscenza della virtualizzazione. Questo commutatore è connesso alla rete logica di gestione e dispone di tutte le schede virtuali host necessarie per fornire l'accesso alla rete di gestione o configurare la rete di archiviazione. S2D si basa su una rete per comunicare tra host. Sono consigliati adattatori con supporto per RDMA.

- Creare reti VM.

Passaggio 3: Configurare le impostazioni DCB nell'istanza locale di Azure

Nota

La configurazione delle impostazioni DCB è un passaggio facoltativo per ottenere prestazioni elevate durante il flusso di lavoro di creazione del cluster S2D. Andare al passaggio 4 se non si desidera configurare le impostazioni dcb.

Consigli

Se sono state distribuite vNIC, per ottenere prestazioni ottimali, è consigliabile eseguire il mapping di tutte le schede di interfaccia di rete virtuali con i pc corrispondenti. Le affinità tra vNIC e pNIC vengono impostate in modo casuale dal sistema operativo e possono verificarsi scenari in cui vengono mappati più schede di interfaccia di rete virtuale alla stessa scheda di interfaccia di rete. Per evitare questi scenari, è consigliabile impostare manualmente l'affinità tra la scheda di interfaccia di rete virtuale e la scheda di interfaccia di rete tramite pNIC seguendo i passaggi elencati qui.

Quando si crea un profilo di porta della scheda di rete, è consigliabile consentire la priorità IEEE. Altre informazioni.

È anche possibile impostare la priorità IEEE usando i comandi di PowerShell seguenti:

Set-VMNetworkAdapterVlan -VMNetworkAdapterName 'SMB2' -VlanId '101' -Access -ManagementOS Set-VMNetworkAdapter -ManagementOS -Name 'SMB2' -IeeePriorityTag on

Per configurare le impostazioni dcb, seguire questa procedura:

Creare un nuovo cluster Hyper-V, selezionare Abilita Spazi di archiviazione diretta. L'opzione di configurazione DCB viene aggiunta al flusso di lavoro di creazione del cluster Hyper-V.

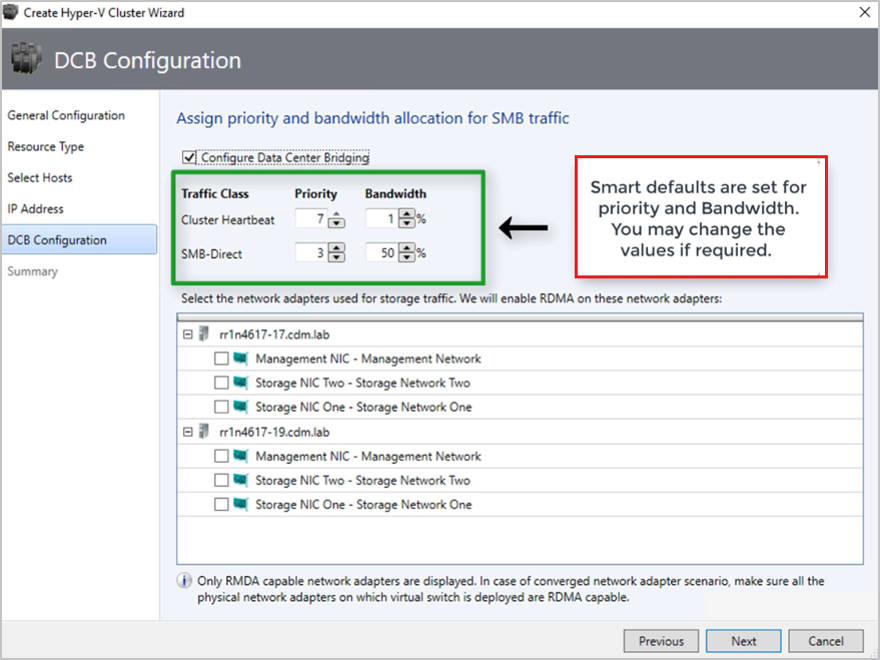

In Configurazione dcb selezionare Configura Data Center Bridging.

Specificare i valori priorità e larghezza di banda per il traffico heartbeat diretto da SMB e cluster.

Nota

I valori predefiniti vengono assegnati a Priority e Bandwidth. Personalizzare questi valori in base alle esigenze dell'ambiente dell'organizzazione.

Valori predefiniti:

| Classe di traffico | Priorità | Larghezza di banda (%) |

|---|---|---|

| Cluster Heartbeat | 7 | 1 |

| SMB diretto | 3 | 50 |

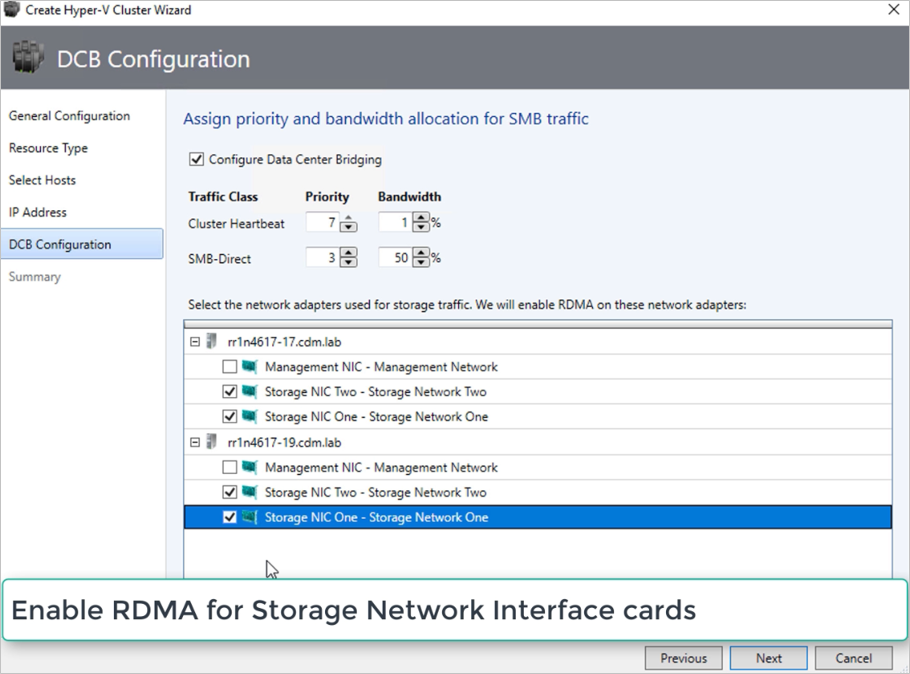

Selezionare le schede di rete usate per il traffico di archiviazione. RDMA è abilitato in queste schede di rete.

Nota

In uno scenario di scheda di interfaccia di rete convergente selezionare le schede di interfaccia di rete di archiviazione. I pNIC sottostanti devono essere in grado di supportare RDMA per la visualizzazione e la disponibilità delle schede virtuali per la selezione.

Esaminare il riepilogo e selezionare Fine.

Verrà creata un'istanza locale di Azure e i parametri DCB vengono configurati in tutti i nodi S2D.

Nota

- Le impostazioni DCB possono essere configurate nei cluster S2D Hyper-V esistenti visitando la pagina Proprietà cluster e passando alla pagina di configurazione DCB.

- Qualsiasi modifica fuori banda alle impostazioni DCB in uno dei nodi causerà la mancata conformità del cluster S2D in VMM. Nella pagina di configurazione di DCB delle proprietà del cluster verrà fornita un'opzione di correzione, che è possibile usare per applicare le impostazioni DCB configurate in VMM nei nodi del cluster.

Passaggio 4: Registrare l'istanza locale di Azure con Azure

Dopo aver creato un'istanza locale di Azure, deve essere registrata in Azure entro 30 giorni dall'installazione in base alle condizioni del servizio online di Azure. Se si usa System Center 2022, usare Register-SCAzStackHCI cmdlet in VMM per registrare l'istanza locale di Azure con Azure. In alternativa, seguire questi passaggi per registrare l'istanza locale di Azure con Azure.

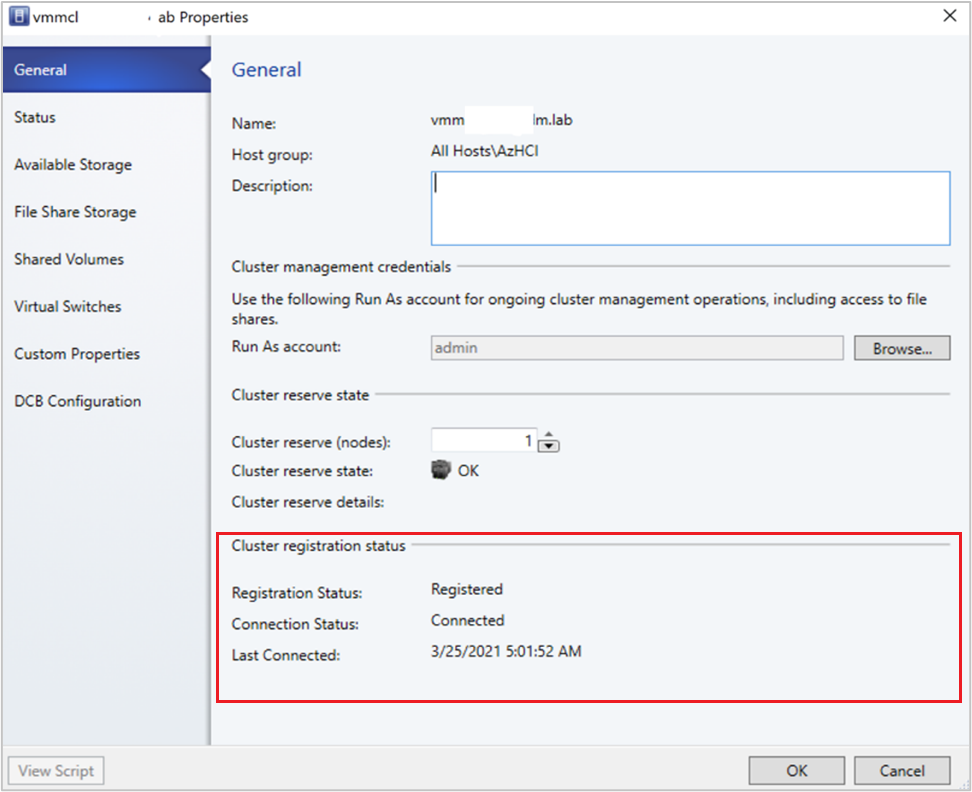

Lo stato della registrazione si rifletterà in VMM dopo un aggiornamento del cluster riuscito.

Passaggio 5: Visualizzare lo stato di registrazione delle istanze di Azure Stack HCI

Nella console VMM è possibile visualizzare lo stato di registrazione e l'ultima data connessa dei cluster Azure Stack HCI.

Selezionare Infrastruttura, fare clic con il pulsante destro del mouse sul cluster Azure Stack HCI e scegliere Proprietà.

In alternativa, eseguire

Get-SCVMHoste osservare le proprietà dell'oggetto restituito per controllare lo stato della registrazione.

Passaggio 6: Gestire il pool e creare volumi condivisi cluster

È ora possibile modificare le impostazioni del pool di archiviazione e creare dischi virtuali e volumi condivisi cluster.

Selezionare >Storage Arrays (Array di archiviazione infrastruttura).>

Fare clic con il pulsante destro del mouse sul cluster >Gestisci pool e selezionare il pool di archiviazione creato per impostazione predefinita. È possibile modificare il nome predefinito e aggiungere una classificazione.

Per creare un file CSV, fare clic con il pulsante destro del mouse sul cluster >Proprietà>volumi condivisi.

In Create Volume Wizard Storage Type (Crea tipo di archiviazione creazione guidata>volume) specificare il nome del volume e selezionare il pool di archiviazione.

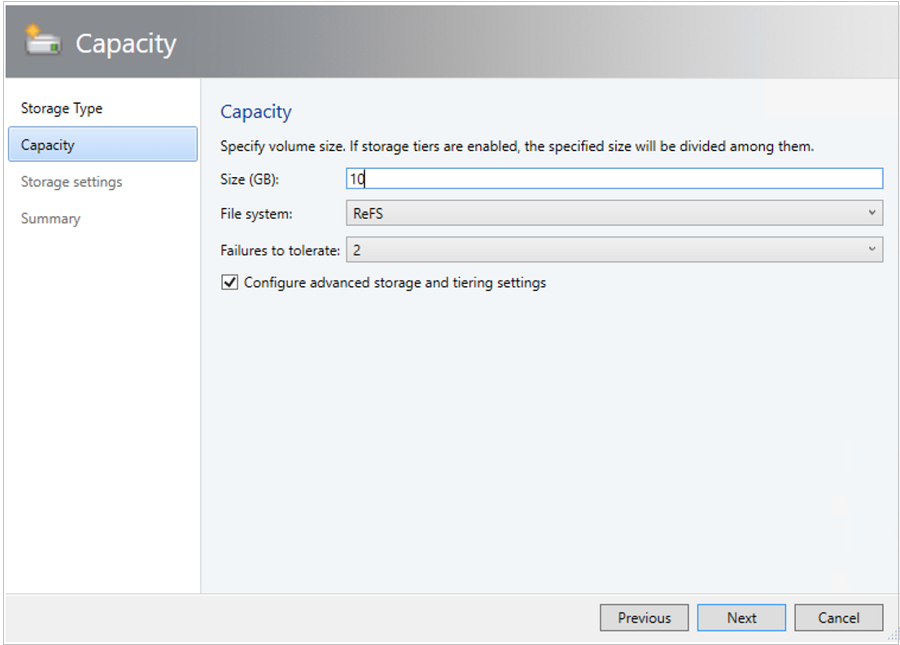

In Capacità è possibile specificare le impostazioni di dimensioni del volume, file system e resilienza (errori da tollerare). Selezionare Configura impostazioni avanzate di archiviazione e suddivisione in livelli per configurare queste opzioni.

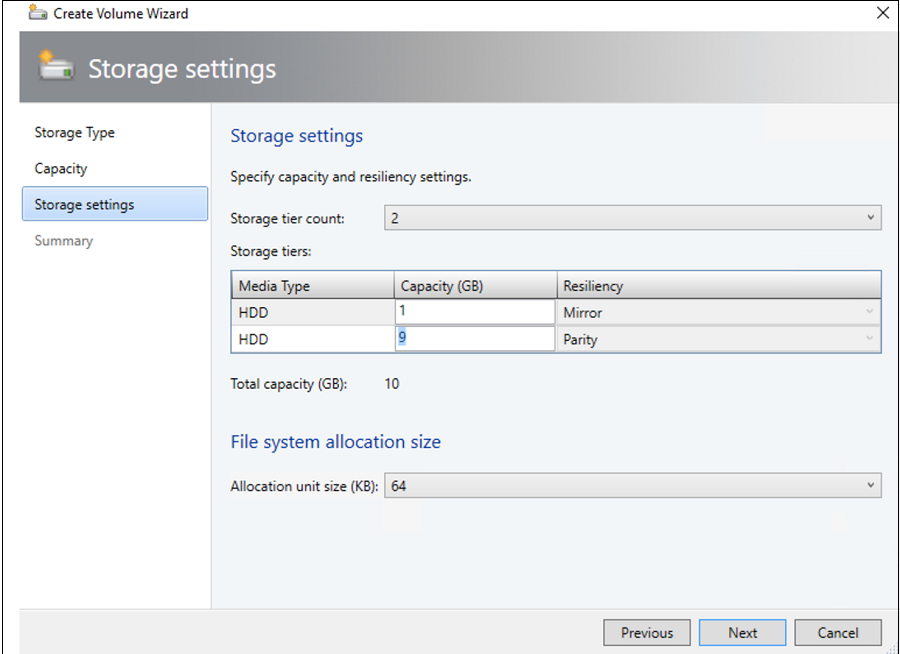

In Impostazioni di archiviazione è possibile specificare la suddivisione, la capacità e la resilienza del livello di archiviazione.

In Riepilogo verificare le impostazioni e completare la procedura guidata. Un disco virtuale verrà creato automaticamente quando si crea il volume.

Passaggio 7: Distribuire macchine virtuali nel cluster

In una topologia iperconvergente, le macchine virtuali possono essere distribuite direttamente nel cluster. I dischi rigidi virtuali vengono inseriti nei volumi creati con S2D. È possibile creare e distribuire queste macchine virtuali esattamente come si creerebbe qualsiasi altra macchina virtuale.

Importante

Se l'istanza locale di Azure non è registrata in Azure o non è connessa ad Azure per più di 30 giorni dopo la registrazione, la creazione della macchina virtuale a disponibilità elevata (HAVM) verrà bloccata nel cluster. Fare riferimento al passaggio 4 e 5 per la registrazione del cluster.

Passaggio 8: Eseguire la migrazione di macchine virtuali da Windows Server a un'istanza locale di Azure

Usare la funzionalità di migrazione di rete in VMM per eseguire la migrazione dei carichi di lavoro da Hyper-V (Windows Server 2019 e versioni successive) ad Azure Stack HCI.

Nota

La migrazione in tempo reale tra Windows Server e Azure Local non è supportata. La migrazione di rete da Azure locale a Windows Server non è supportata.

- Disabilitare temporaneamente la migrazione in tempo reale nell'host locale di Azure di destinazione.

- Selezionare Macchine virtuali e servizi>Tutti gli host e quindi selezionare l'host Hyper-V di origine da cui si vuole eseguire la migrazione.

- Selezionare la macchina virtuale di cui si vuole eseguire la migrazione. La macchina virtuale deve trovarsi in uno stato disattivato.

- Selezionare Migrate Virtual Machine (Esegui migrazione macchina virtuale).

- In seleziona Host, esamina e seleziona l'host di destinazione locale di Azure.

- Selezionare Avanti per avviare la migrazione di rete. VMM eseguirà importazioni ed esportazioni nel back-end.

- Per verificare che la migrazione della macchina virtuale sia stata eseguita correttamente, controllare l'elenco delle macchine virtuali nell'host di destinazione. Attivare la macchina virtuale e riabilitare la migrazione in tempo reale nell'host locale di Azure.

Passaggio 9: Eseguire la migrazione di carichi di lavoro VMware all'istanza locale di Azure usando SCVMM

VMM offre un'esperienza semplice basata su procedura guidata per la conversione da V2V (da virtuale a virtuale). È possibile usare lo strumento di conversione per eseguire la migrazione di carichi di lavoro su larga scala dall'infrastruttura VMware all'infrastruttura Hyper-V. Per l'elenco dei server VMware supportati, vedere Requisiti di sistema.

Per i prerequisiti e le limitazioni per la conversione, vedere Convertire una macchina virtuale VMware in Hyper-V nell'infrastruttura VMM.

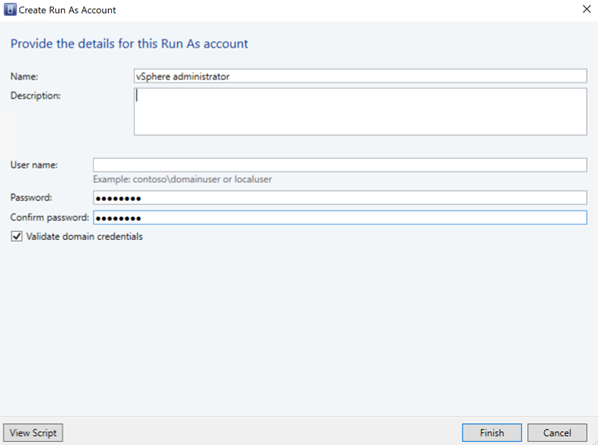

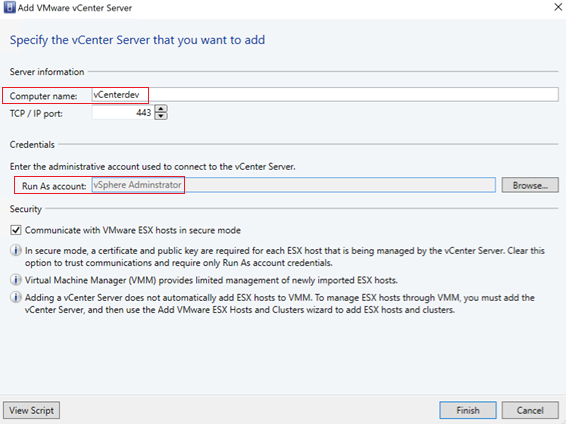

Creare l'account Runas per il ruolo di amministratore del server vCenter in VMM. Queste credenziali di amministratore vengono usate per gestire i server vCenter e gli host ESXi.

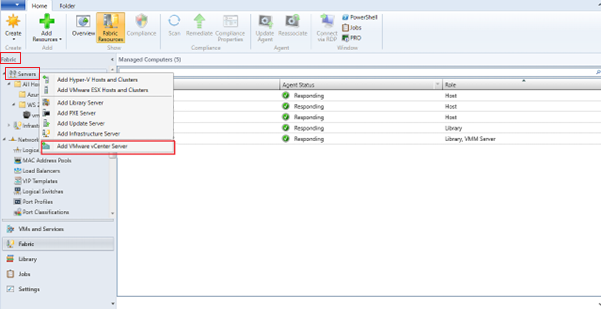

Nella console VMM, in Infrastruttura selezionare >Aggiungi server VMware vCenter Server.

Nella pagina Aggiungi server VMware vCenter eseguire le operazioni seguenti:

Nome computer: specificare il nome del server vCenter.

Account RunAs: selezionare l'account RunAs creato per l'amministratore di vSphere.

Selezionare Fine.

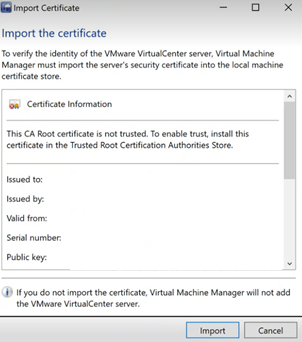

Nella pagina Importa certificato selezionare Importa.

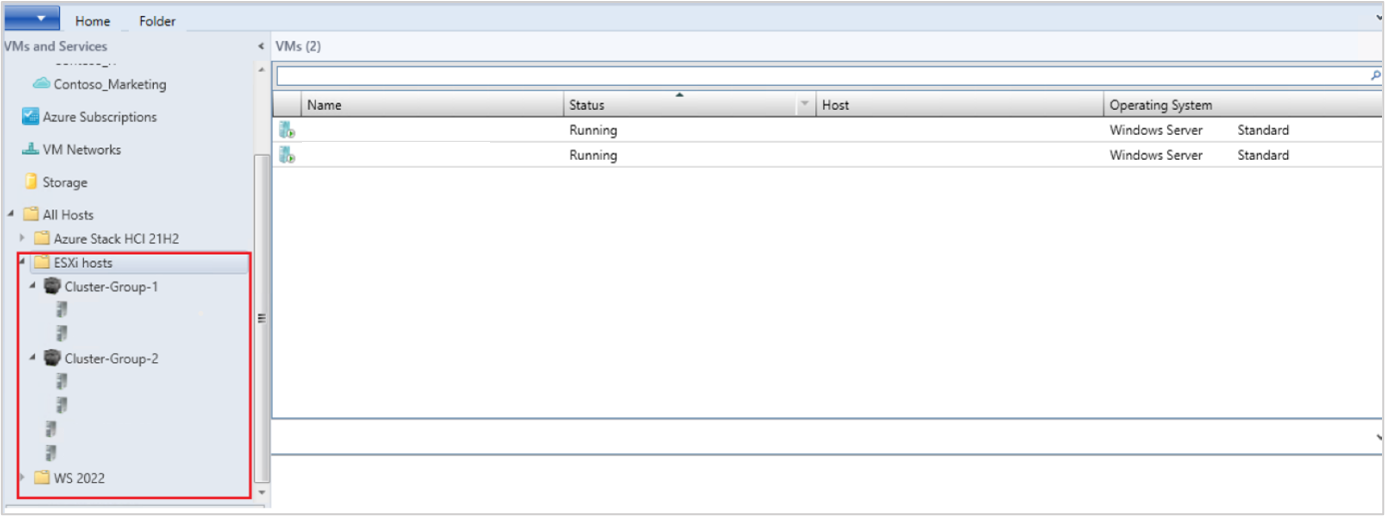

Dopo aver completato l'aggiunta del server vCenter, viene eseguita la migrazione di tutti gli host ESXi in vCenter a VMM.

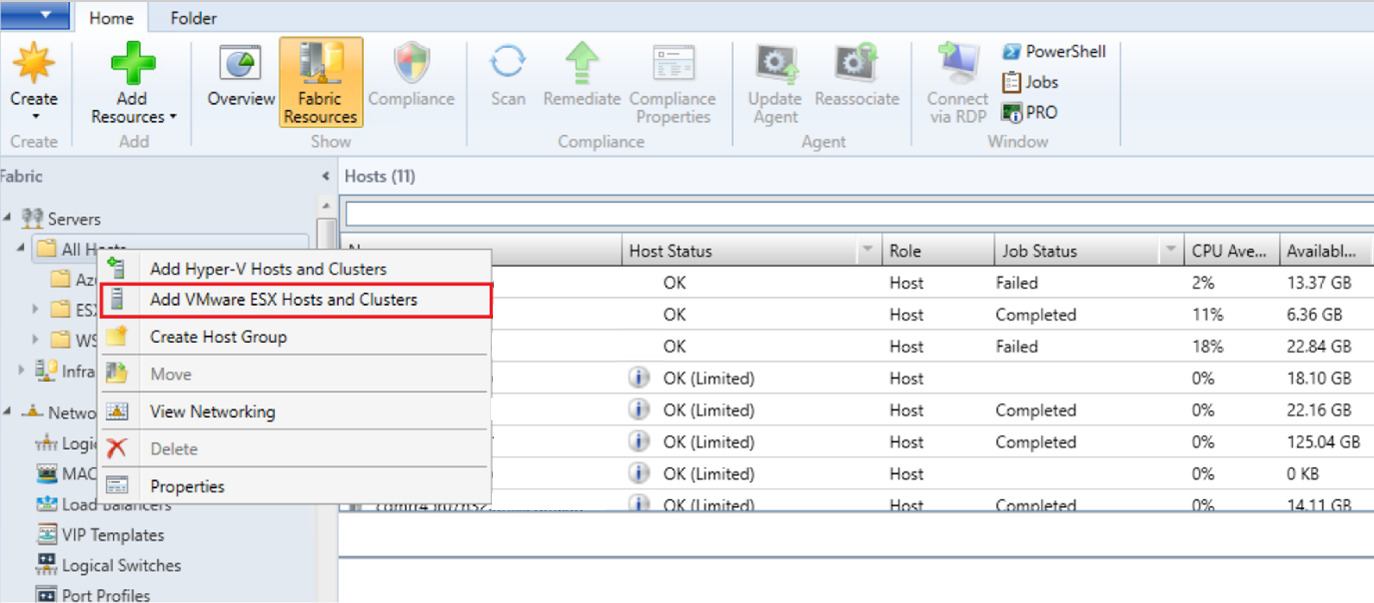

Aggiungere host

- Nella console VMM, in Infrastruttura selezionare >Aggiungi host e cluster VMware ESX.

-

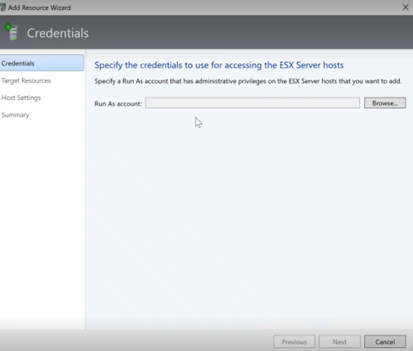

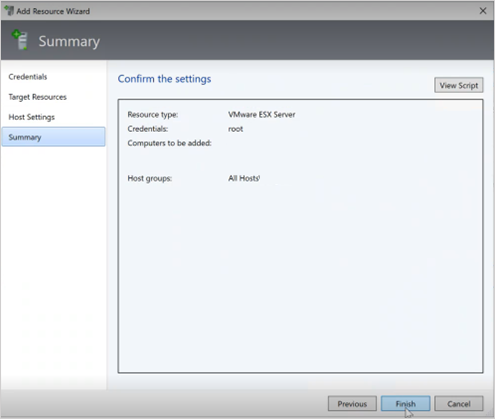

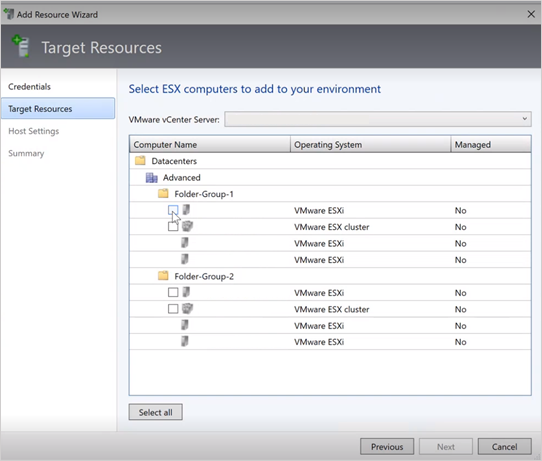

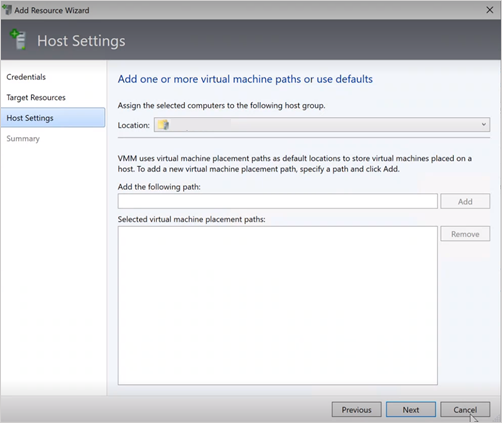

Nella Procedura guidata Aggiungi risorsa,

In Credenziali selezionare l'account Runas usato per la porta e selezionare Avanti.

In Risorse di destinazione selezionare tutti i cluster ESX che devono essere aggiunti a VMM e selezionare Avanti.

In Impostazioni host selezionare il percorso in cui si vogliono aggiungere le macchine virtuali e selezionare Avanti.

In Riepilogo esaminare le impostazioni e selezionare Fine. Insieme agli host, verranno aggiunte anche le macchine virtuali associate.

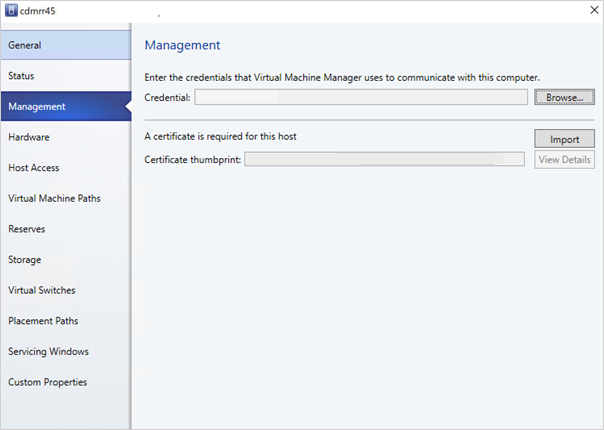

Verificare lo stato dell'host ESXi

Se lo stato dell'host ESXi corrisponde a OK (limitato), fare clic con il pulsante destro del mouse su Gestione proprietà>, selezionare Account Runas usato per la porta e importare i certificati per l'host.

Ripetere lo stesso processo per tutti gli host ESXi.

Dopo aver aggiunto i cluster ESXi, tutte le macchine virtuali in esecuzione nei cluster ESXi vengono individuate automaticamente in VMM.

Visualizzare le macchine virtuali

Passare a Macchine virtuali e servizi per visualizzare le macchine virtuali. È anche possibile gestire le operazioni principali del ciclo di vita di queste macchine virtuali da VMM.

Fare clic con il pulsante destro del mouse sulla macchina virtuale e selezionare Power Off (le migrazioni online non sono supportate) di cui è necessario eseguire la migrazione e disinstallare gli strumenti VMware dal sistema operativo guest.

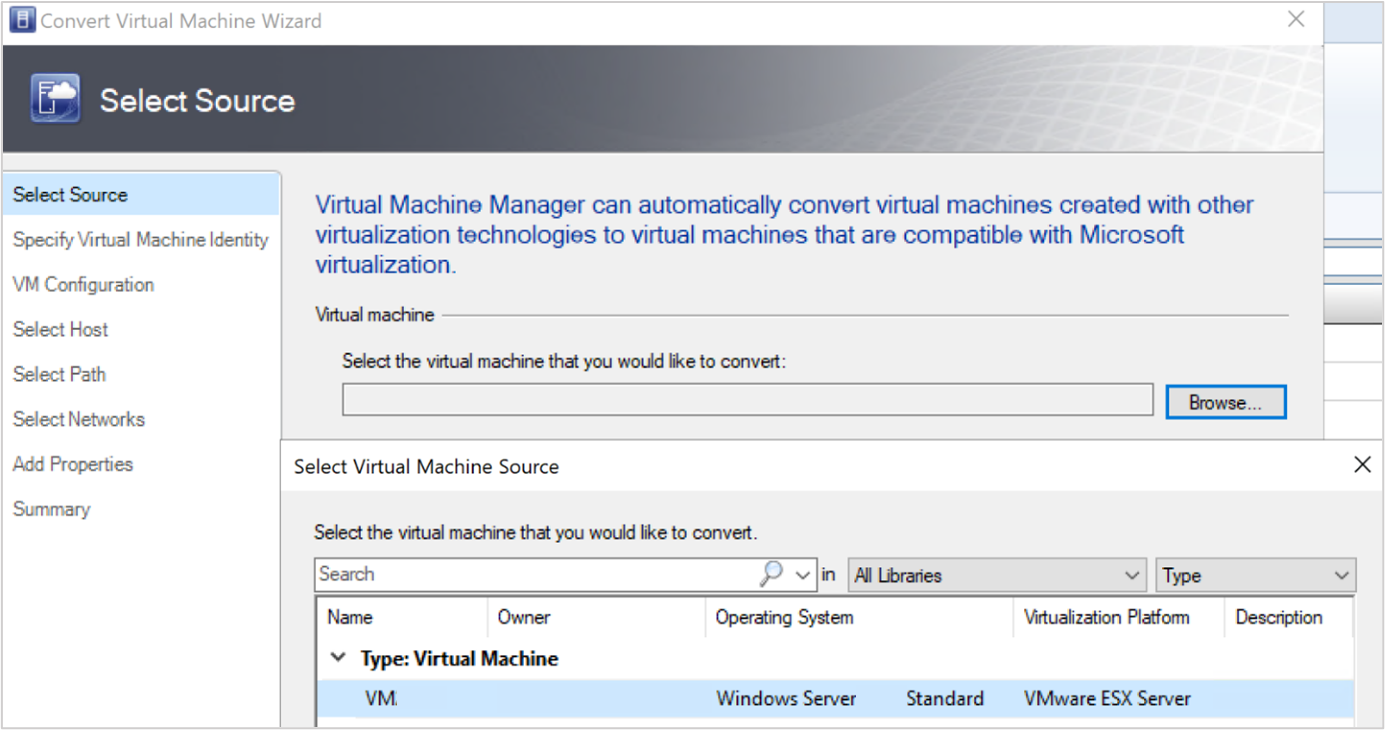

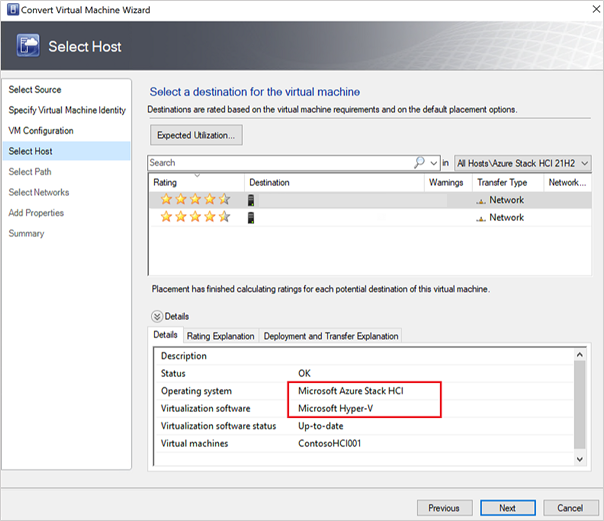

Selezionare >> Converti macchina virtuale.

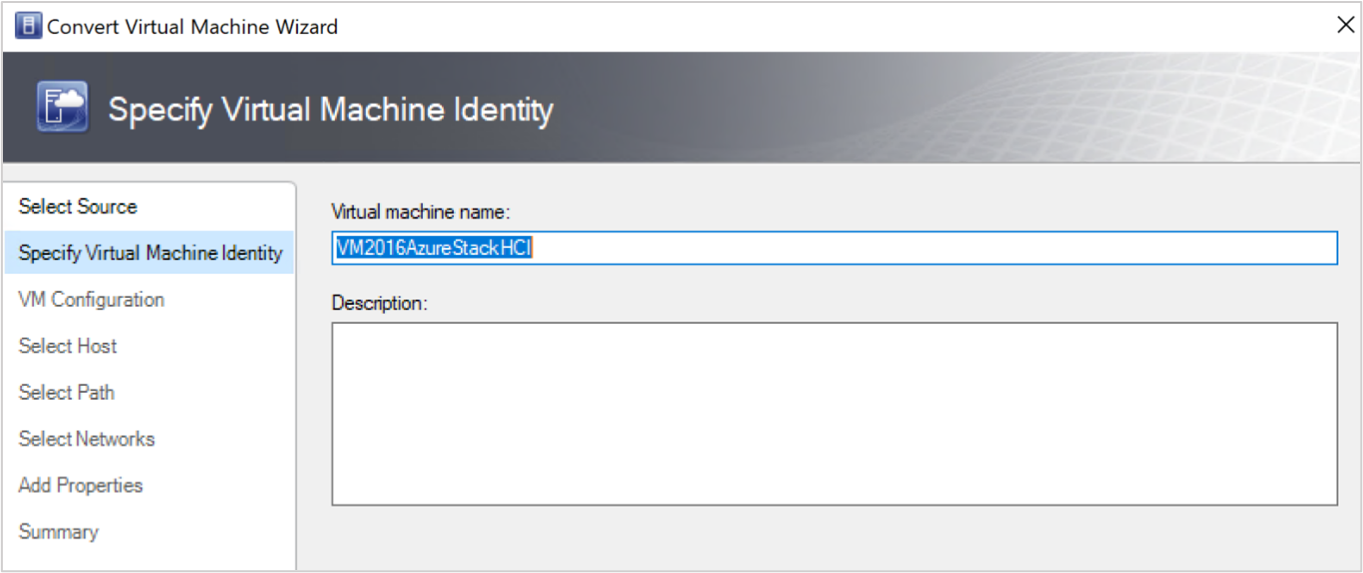

Nella Conversione guidata macchina virtuale,

- In Seleziona origine selezionare la macchina virtuale in esecuzione nel server ESXi e selezionare Avanti.

- In Specifica identità macchina virtuale immettere il nuovo nome per la macchina virtuale se si vuole e selezionare Avanti.

- In Seleziona origine selezionare la macchina virtuale in esecuzione nel server ESXi e selezionare Avanti.

In Seleziona host, seleziona il computer locale di Azure di destinazione e specifica il percorso nell'host per i file di archiviazione delle macchine virtuali e seleziona Avanti.

Selezionare una rete virtuale per la macchina virtuale e selezionare Crea per completare la migrazione.

La macchina virtuale in esecuzione nel cluster ESXi viene migrata correttamente nell'istanza locale di Azure. Per l'automazione, usare i comandi di PowerShell per la conversione.