Azure Stack HCI バージョン 23H2 のクラウド デプロイに関するネットワークに関する考慮事項

適用対象: Azure Stack HCI バージョン 23H2

この記事では、クラウド デプロイ用の Azure Stack HCI バージョン 23H2 システム ネットワークを設計および計画する方法について説明します。 続行する前に、さまざまな Azure Stack HCI ネットワーク パターン 使用可能な構成について理解してください。

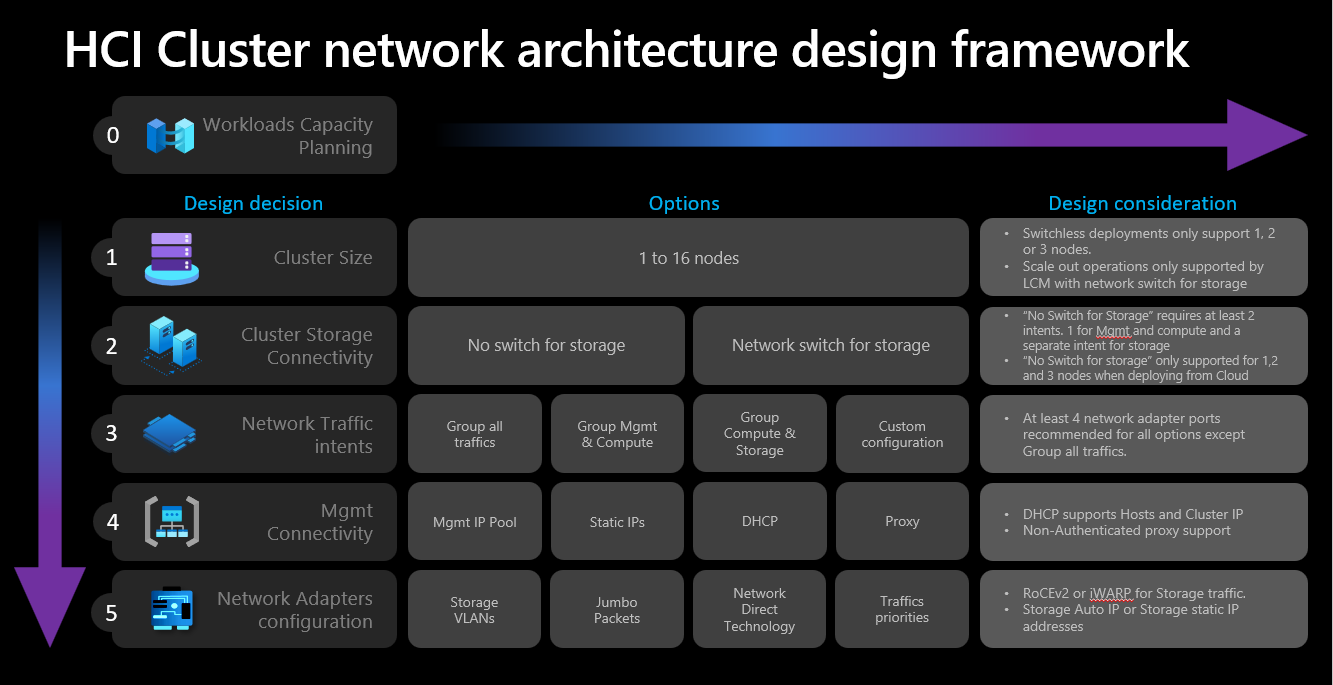

ネットワーク設計フレームワーク

次の図は、Azure Stack HCI システムのネットワーク 設計フレームワーク (クラスター サイズ、クラスター ストレージ接続、ネットワーク トラフィックの意図、管理接続、およびネットワーク アダプター構成) を定義するさまざまな決定と手順を示しています。 設計の決定ごとに、後続の手順で使用できる設計オプションが有効または許可されます。

手順 1: クラスター のサイズを決定する

Azure Stack HCI システムのサイズを判断するには、 Azure Stack HCI sizer ツールを使用します。このツールでは仮想マシン (VM)、VM のサイズ、Azure Virtual Desktop、SQL Server、AKS などの VM のワークロードの使用など、プロファイルを定義できます。

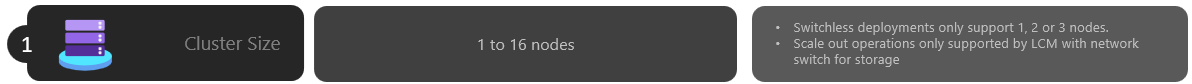

Azure Stack HCI システム サーバーの要件に関する記事で説明されているように Azure Stack HCI システムでサポートされるサーバーの最大数は 16 です。 ワークロードの容量計画を完了したら、インフラストラクチャでワークロードを実行するために必要なサーバー ノードの数を十分に理解している必要があります。

ワークロードに 4 つ以上のノードが必要な場合: ストレージ ネットワーク トラフィックにスイッチレス構成をデプロイして使用することはできません。 ストレージ トラフィックを処理するには、リモート ダイレクト メモリ アクセス (RDMA) をサポートする物理スイッチを含める必要があります。 Azure Stack HCI クラスター ネットワーク アーキテクチャの詳細については、「 Network 参照パターンの概要を参照してください。

ワークロードに 3 つ以下のノードが必要な場合: ストレージ接続用にスイッチレス構成または切り替え構成を選択できます。

後で 3 つ以上のノードにスケールアウトする場合: ストレージ ネットワーク トラフィックには物理スイッチを使用する必要があります。 スイッチレス デプロイのスケールアウト操作では、Microsoft が Azure Stack HCI のソフトウェア開発サイクルの一環としてアクティブに検証していないノード間のネットワーク ケーブル接続を手動で構成する必要があります。

クラスター サイズの決定に関する考慮事項の概要を次に示します。

| Decision | 説明 |

|---|---|

| クラスター サイズ (クラスターあたりのノード数) | Azure portal または Azure Resource Manager テンプレートを使用したスイッチレス構成は、1、2、または 3 つのノード クラスターでのみ使用できます。 4 つ以上のノードを持つクラスターでは、ストレージ ネットワーク トラフィックに物理スイッチが必要です。 |

| スケールアウト要件 | オーケストレーターを使用してクラスターをスケールアウトする場合は、ストレージ ネットワーク トラフィックに物理スイッチを使用する必要があります。 |

手順 2: クラスター ストレージの接続性を確認する

物理ネットワーク要件で説明されているように、Azure Stack HCI では、ストレージ ネットワーク トラフィックに対して次の 2 種類の接続がサポートされています。

- トラフィックを処理するには、物理ネットワーク スイッチを使用します。

- ストレージ トラフィック用のクロス ネットワークまたはファイバー ケーブルを使用して、ノード間のノードを直接接続します。

各オプションの長所と短所は、上記のリンク先の記事に記載されています。

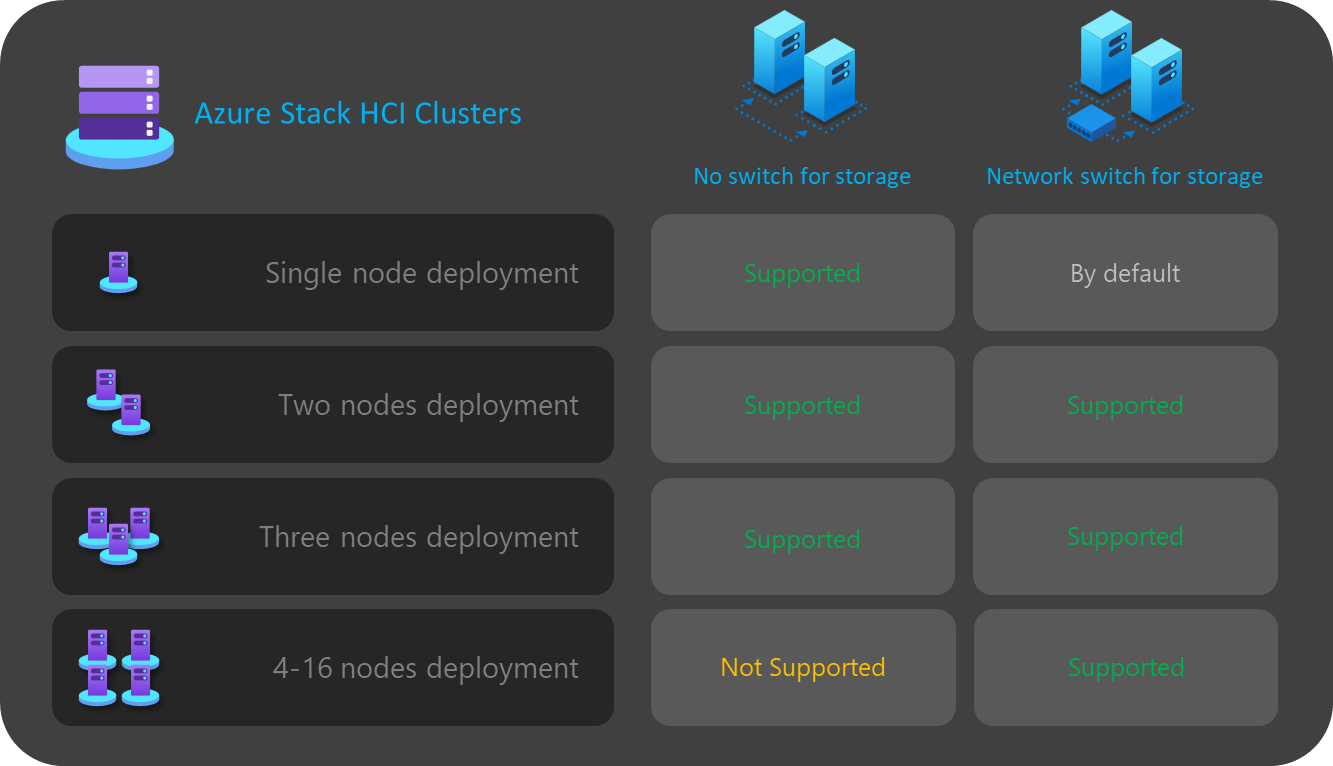

前述のように、クラスターのサイズが 3 ノード以下の場合にのみ、2 つのオプションを決定できます。 4 つ以上のノードを持つクラスターは、ストレージ用のネットワーク スイッチを使用して自動的にデプロイされます。

クラスターのノードが 3 つ未満の場合、ストレージ接続の決定は、次の手順で定義できるネットワーク意図の数と種類に影響します。

たとえば、スイッチレス構成の場合は、2 つのネットワーク トラフィックの意図を定義する必要があります。 クロス ケーブルを使用した東西通信のストレージ トラフィックには、南北接続がないため、ネットワーク インフラストラクチャの残りの部分から完全に分離されています。 つまり、管理送信接続とコンピューティング ワークロードに対して 2 つ目のネットワーク意図を定義する必要があります。

各ネットワーク インテントは、それぞれ 1 つの物理ネットワーク アダプター ポートでのみ定義できますが、フォールト トレランスは提供されません。 そのため、ネットワーク意図ごとに少なくとも 2 つの物理ネットワーク ポートを使用することをお勧めします。 記憶域にネットワーク スイッチを使用する場合は、ストレージを含むすべてのネットワーク トラフィックを 1 つのネットワーク インテントにグループ化できます。これは、 hyperconverged または 完全に集約されたホスト ネットワーク構成とも呼ばれます 。

クラスター ストレージ接続の決定に関する考慮事項の概要を次に示します。

| Decision | 説明 |

|---|---|

| ストレージ用のスイッチなし | Azure portal または Resource Manager テンプレートのデプロイを使用したスイッチレス構成は、1、2、または 3 つのノード クラスターでのみサポートされます。 1 つまたは 2 つのノード ストレージ スイッチレス クラスターは、Azure portal または Resource Manager テンプレートを使用してデプロイできます。 3 ノード ストレージ スイッチレス クラスターは、Resource Manager テンプレートを使用してのみデプロイできます。 スケールアウト操作は、スイッチレス デプロイではサポートされていません。 デプロイ後にノード数を変更するには、手動で構成する必要があります。 ストレージ スイッチレス構成を使用する場合は、少なくとも 2 つのネットワーク意図が必要です。 |

| ストレージ用のネットワーク スイッチ | オーケストレーターを使用してクラスターをスケールアウトする場合は、ストレージ ネットワーク トラフィックに物理スイッチを使用する必要があります。 このアーキテクチャは、1 から 16 までの任意の数のノードで使用できます。 適用されませんが、すべてのネットワーク トラフィックの種類 (管理、コンピューティング、ストレージ) に対して 1 つの意図を使用できます。 |

次の図は、さまざまなデプロイで使用できるストレージ接続オプションをまとめたものです。

手順 3: ネットワーク トラフィックの意図を決定する

Azure Stack HCI の場合、すべてのデプロイはホスト ネットワーク構成にネットワーク ATC に依存します。 ネットワーク意図は、Azure portal を使用して Azure Stack HCI をデプロイするときに自動的に構成されます。 ネットワークの意図とそのトラブルシューティング方法の詳細については、「 Common network ATC コマンドを参照してください。

このセクションでは、ネットワーク トラフィックの意図に対する設計上の決定の影響と、それらがフレームワークの次のステップにどのように影響するかを説明します。 クラウド デプロイの場合は、4 つのオプションから選択して、ネットワーク トラフィックを 1 つ以上の意図にグループ化できます。 使用可能なオプションは、クラスター内のノードの数と使用されるストレージ接続の種類によって異なります。

使用可能なネットワークインテントオプションについては、以下のセクションで説明します。

ネットワークの意図: すべてのトラフィックをグループ化する

Network ATC は、管理、コンピューティング、ストレージのネットワーク トラフィックを含む一意の意図を構成します。 この意図に割り当てられたネットワーク アダプターは、すべてのネットワーク トラフィックの帯域幅とスループットを共有します。

このオプションには、ストレージ トラフィック用の物理スイッチが必要です。 スイッチレス アーキテクチャが必要な場合は、この種類の意図を使用できません。 ストレージ接続のスイッチレス構成を選択すると、Azure portal によってこのオプションが自動的に除外されます。

高可用性を確保するには、少なくとも 2 つのネットワーク アダプター ポートを使用することをお勧めします。

ストレージの RDMA トラフィックをサポートするには、少なくとも 10 Gbps のネットワーク インターフェイスが必要です。

ネットワークの意図: グループ管理とコンピューティング トラフィック

ネットワーク ATC は、2 つの意図を構成します。 1 つ目の意図には管理とコンピューティング ネットワーク トラフィックが含まれており、2 番目の意図にはストレージ ネットワーク トラフィックのみが含まれます。 各意図には、異なるネットワーク アダプター ポートのセットが必要です。

このオプションは、次の場合に、切り替えストレージ接続とスイッチレス ストレージ接続の両方に使用できます。

高可用性を確保するために、意図ごとに少なくとも 2 つのネットワーク アダプター ポートを使用できます。

記憶域にネットワーク スイッチを使用する場合は、RDMA に物理スイッチが使用されます。

ストレージの RDMA トラフィックをサポートするには、少なくとも 10 Gbps のネットワーク インターフェイスが必要です。

ネットワークの意図: コンピューティング トラフィックとストレージ トラフィックをグループ化する

ネットワーク ATC は、2 つの意図を構成します。 最初の意図にはコンピューティングとストレージのネットワーク トラフィックが含まれており、2 番目の意図には管理ネットワーク トラフィックのみが含まれます。 各意図は、異なるネットワーク アダプター ポートのセットを使用する必要があります。

このオプションでは、同じポートがコンピューティング トラフィックと共有されるため、ストレージ トラフィックの物理スイッチが必要です。これには南北通信が必要です。 スイッチレス構成が必要な場合は、この種類の意図を使用できません。 ストレージ接続のスイッチレス構成を選択すると、Azure portal によってこのオプションが自動的に除外されます。

このオプションには、RDMA の物理スイッチが必要です。

高可用性を確保するには、少なくとも 2 つのネットワーク アダプター ポートを使用することをお勧めします。

RDMA トラフィックをサポートするコンピューティングとストレージの意図には、少なくとも 10 Gbps のネットワーク インターフェイスをお勧めします。

管理インテントがコンピューティング意図なしで宣言されている場合でも、Network ATC はスイッチ埋め込みチーミング (SET) 仮想スイッチを作成して、管理ネットワークに高可用性を提供します。

ネットワーク意図: カスタム構成

少なくとも 1 つの意図に管理トラフィックが含まれている限り、独自の構成を使用して最大 3 つの意図を定義します。 2 つ目のコンピューティング意図が必要な場合は、このオプションを使用することをお勧めします。 この 2 つ目のコンピューティング意図要件のシナリオには、リモート ストレージ トラフィック、VM バックアップ トラフィック、または異なる種類のワークロードに対する個別のコンピューティング意図が含まれます。

ストレージの意図が他の意図と異なる場合は、切り替えストレージ接続とスイッチレス ストレージ接続の両方にこのオプションを使用します。

このオプションは、別のコンピューティング意図が必要な場合、または異なるネットワーク アダプター経由で異なる種類のトラフィックを完全に分離する場合に使用します。

高可用性を確保するには、意図ごとに少なくとも 2 つのネットワーク アダプター ポートを使用します。

RDMA トラフィックをサポートするコンピューティングとストレージの意図には、少なくとも 10 Gbps のネットワーク インターフェイスをお勧めします。

次の図は、さまざまなデプロイで使用できるネットワークインテントオプションをまとめたものです。

手順 4: 管理と記憶域ネットワーク接続を決定する

この手順では、インフラストラクチャ サブネットのアドレス空間、これらのアドレスをクラスターに割り当てる方法、およびインターネットおよびドメイン ネーム システム (DNS) や Active Directory サービスなどの他のイントラネット サービスへの送信接続のためのノードにプロキシまたは VLAN ID の要件がある場合を定義します。

ルーティング、ファイアウォール、またはサブネットの要件を予測できるように、デプロイを開始する前に、次のインフラストラクチャ サブネット コンポーネントを計画して定義する必要があります。

ネットワーク アダプター ドライバー

オペレーティング システムをインストールし、ノードにネットワークを構成する前に、ネットワーク アダプターに OEM またはネットワーク インターフェイス ベンダーによって提供される最新のドライバーがあることを確認する必要があります。 既定の Microsoft ドライバーを使用する場合、ネットワーク アダプターの重要な機能が表示されない場合があります。

管理 IP プール

Azure Stack HCI システムの初期デプロイを行うときは、既定でデプロイされるインフラストラクチャ サービスの連続する IP の IP 範囲を定義する必要があります。

範囲に現在および将来のインフラストラクチャ サービスに十分な IP を確保するには、少なくとも 6 つの連続する使用可能な IP アドレスの範囲を使用する必要があります。 これらのアドレスは、クラスター IP、Azure Resource Bridge VM、およびそのコンポーネントに使用されます。

インフラストラクチャ ネットワークで他のサービスを実行することが予想される場合は、インフラストラクチャ IP の追加バッファーをプールに割り当てることをお勧めします。 計画したプールのサイズが最初に使い果たされた場合は、PowerShell を使用してインフラストラクチャ ネットワークのデプロイ後に他の IP プールを追加できます。

デプロイ時にインフラストラクチャ サブネットの IP プールを定義する場合は、次の条件を満たす必要があります。

| # | 条件 |

|---|---|

| 1 | IP 範囲で連続する IP を使用する必要があり、すべての IP がその範囲内で使用可能である必要があります。 この IP 範囲は、デプロイ後に変更することはできません。 |

| 2 | IP の範囲にはクラスター ノード管理 IP を含めてはなりませんが、ノードと同じサブネット上に存在する必要があります。 |

| 3 | 管理 IP プールに定義されている既定のゲートウェイは、インターネットへの送信接続を提供する必要があります。 |

| 4 | DNS サーバーは、Active Directory とインターネットでの名前解決を保証する必要があります。 |

| 5 | 管理 IP には送信インターネット アクセスが必要です。 |

管理 VLAN ID

Azure HCI クラスターの管理サブネットでは、既定の VLAN を使用することをお勧めします。ほとんどの場合、VLAN ID 0 として宣言されています。 ただし、ネットワーク要件でインフラストラクチャ ネットワークに特定の管理 VLAN を使用する場合は、管理トラフィックに使用する物理ネットワーク アダプターで構成する必要があります。

管理に 2 つの物理ネットワーク アダプターを使用する場合は、両方のアダプターに VLAN を設定する必要があります。 これは、サーバーのブートストラップ構成の一部として、および Azure Arc に登録する前に、この VLAN を使用してノードを正常に登録するために行う必要があります。

物理ネットワーク アダプターで VLAN ID を設定するには、次の PowerShell コマンドを使用します。

この例では、物理ネットワーク アダプター NIC1で VLAN ID 44 を構成します。

Set-NetAdapter -Name "NIC1" -VlanID 44

VLAN ID が設定され、ノードの IP が物理ネットワーク アダプターで構成されると、オーケストレーターは管理に使用される物理ネットワーク アダプターからこの VLAN ID 値を読み取って格納するため、デプロイ時に必要な Azure Resource Bridge VM またはその他のインフラストラクチャ VM に使用できます。 Azure portal からのクラウド デプロイ中に管理 VLAN ID を設定することはできません。物理スイッチ VLAN が正しくルーティングされていない場合、ノードと Azure の間の接続が切断されるリスクがあるためです。

仮想スイッチを使用した管理 VLAN ID

シナリオによっては、デプロイを開始する前に仮想スイッチを作成する必要があります。

Note

仮想スイッチを作成する前に、Hype-V ロールを有効にしてください。 詳細については、「 必要な Windows ロールのインストール」を参照してください。

仮想スイッチの構成が必要であり、特定の VLAN ID を使用する必要がある場合は、次の手順に従います。

1. 推奨される名前付け規則を使用して仮想スイッチを作成する

Azure Stack HCI デプロイでは、管理、コンピューティング、およびストレージの意図に合った仮想スイッチと仮想ネットワーク アダプターを作成して構成するために、Network ATC に依存しています。 既定では、Network ATC は意図の仮想スイッチを作成するときに、仮想スイッチの特定の名前を使用します。

同じ名前付け規則で仮想スイッチ名に名前を付けることをお勧めします。 仮想スイッチの推奨名は次のとおりです。

"ConvergedSwitch($IntentName)"。 $IntentName は、デプロイ時にポータルに入力された意図の名前と一致する必要があります。 この文字列は、次の手順で説明するように、管理に使用される仮想ネットワーク アダプターの名前とも一致する必要があります。

次の例は、 $IntentNameで推奨される名前付け規則を使用して、PowerShell で仮想スイッチを作成する方法を示しています。 ネットワーク アダプター名の一覧は、管理およびコンピューティング ネットワーク トラフィックに使用する物理ネットワーク アダプターの一覧です。

$IntentName = "MgmtCompute"

New-VMSwitch -Name "ConvergedSwitch($IntentName)" -NetAdapterName "NIC1","NIC2" -EnableEmbeddedTeaming $true -AllowManagementOS $true

2. すべてのノードに必要なネットワーク ATC 名前付け規則を使用して管理仮想ネットワーク アダプターを構成する

仮想スイッチと関連する管理仮想ネットワーク アダプターが作成されたら、ネットワーク アダプター名がネットワーク ATC の名前付け標準に準拠していることを確認します。

具体的には、管理トラフィックに使用される仮想ネットワーク アダプターの名前には、次の規則を使用する必要があります。

- ネットワーク アダプターと仮想ネットワーク アダプターの名前は、

vManagement($intentname)を使用する必要があります。 - この名前では大文字と小文字が区別されます。

$Intentnameには任意の文字列を指定できますが、仮想スイッチに使用される名前と同じである必要があります。Mgmt意図名を定義するときは、Azure portal でこの同じ文字列を使用してください。

管理仮想ネットワーク アダプター名を更新するには、次のコマンドを使用します。

$IntentName = "MgmtCompute"

#Rename VMNetworkAdapter for management because during creation, Hyper-V uses the vSwitch name for the virtual network adapter.

Rename-VmNetworkAdapter -ManagementOS -Name "ConvergedSwitch(MgmtCompute)" -NewName "vManagement(MgmtCompute)"

#Rename NetAdapter because during creation, Hyper-V adds the string “vEthernet” to the beginning of the name.

Rename-NetAdapter -Name "vEthernet (ConvergedSwitch(MgmtCompute))" -NewName "vManagement(MgmtCompute)"

3. すべてのノードの管理仮想ネットワーク アダプターに VLAN ID を構成する

仮想スイッチと管理仮想ネットワーク アダプターが作成されたら、このアダプターに必要な VLAN ID を指定できます。 仮想ネットワーク アダプターに VLAN ID を割り当てるオプションは異なりますが、サポートされる唯一のオプションは、 Set-VMNetworkAdapterIsolation コマンドを使用することです。

必要な VLAN ID を構成したら、管理仮想ネットワーク アダプターに IP アドレスとゲートウェイを割り当てて、他のノード、DNS、Active Directory、およびインターネットとの接続があることを検証できます。

次の例では、既定ではなく VLAN ID 8 を使用するように管理仮想ネットワーク アダプターを構成する方法を示します。

Set-VMNetworkAdapterIsolation -ManagementOS -VMNetworkAdapterName "vManagement($IntentName)" -AllowUntaggedTraffic $true -IsolationMode Vlan -DefaultIsolationID "8"

4. 展開中に管理インテントの物理ネットワーク アダプターを参照する

新しく作成された仮想ネットワーク アダプターは、Azure portal 経由でデプロイするときに使用可能と表示されますが、ネットワーク構成はネットワーク ATC に基づいていることに注意してください。 つまり、管理または管理とコンピューティングの意図を構成する場合でも、その意図に使用される物理ネットワーク アダプターを選択する必要があります。

Note

ネットワーク インテントの仮想ネットワーク アダプターを選択しないでください。

同じロジックが Azure Resource Manager テンプレートに適用されます。 仮想ネットワーク アダプターを使用しない、ネットワークの意図に使用する物理ネットワーク アダプターを指定する必要があります。

VLAN ID の概要に関する考慮事項を次に示します。

| # | 考慮事項 |

|---|---|

| 1 | サーバーを Azure Arc に登録する前に、管理のために物理ネットワーク アダプターで VLAN ID を指定する必要があります。 |

| 2 | サーバーを Azure Arc に登録する前に仮想スイッチが必要な場合は、特定の手順を使用します。 |

| 3 | 管理 VLAN ID は、デプロイ時にホスト構成からインフラストラクチャ VM に引き継がされます。 |

| 4 | Azure portal のデプロイまたは Resource Manager テンプレートのデプロイ用の VLAN ID 入力パラメーターはありません。 |

ストレージ用のカスタム IP

既定では、ネットワーク ATC は次の表からストレージ用の IP と VLAN を自動的に割り当てます。

| ストレージ アダプター | IP アドレスとサブネット | VLAN |

|---|---|---|

| pNIC1 | 10.71.1.x | 711 |

| pNIC2 | 10.71.2.x | 712 |

| pNIC3 | 10.71.3.x | 713 |

ただし、デプロイ要件が既定の IP と VLAN に適合しない場合は、独自の IP、サブネット、VLAN をストレージに使用できます。 この機能は、ARM テンプレートを使用してクラスターをデプロイする場合にのみ使用でき、テンプレートで次のパラメーターを指定する必要があります。

- enableStorageAutoIP: このパラメーターは、指定しない場合は true に設定されます。 デプロイ時にカスタム ストレージ IP を有効にするには、このパラメーターを false に設定する必要があります。

- storageAdapterIPInfo: このパラメーターには "enableStorageAutoIP" パラメーターとの依存関係があり、ストレージ自動 IP パラメーターが false に設定されている場合は常に必要です。 ARM テンプレートの "storageAdapterIPInfo" パラメーター内で、 "ipv4Address" と "subnetMask" パラメーターを、独自の IP とサブネット マスクを持つ各ノードとネットワーク アダプターに指定する必要もあります。

- vlanId: 上の表で説明したように、このパラメーターは、ネットワーク ATC の既定の VLAN を変更する必要がない場合に使用します。 ただし、これらの既定の VLAN がネットワークで機能しない場合は、各ストレージ ネットワークに独自の VLAN ID を指定できます。

次の ARM テンプレートには、ストレージ用のネットワーク スイッチを備えた 2 つのノード HCI クラスターの例が含まれています。ストレージ IP は、カスタム ストレージ IP を使用して 2 ノードデプロイにカスタマイズされます

ノードとクラスターの IP 割り当て

Azure Stack HCI システムの場合、サーバー ノードとクラスター IP に IP を割り当てるには、2 つのオプションがあります。

静的ホスト構成プロトコルと動的ホスト構成プロトコル (DHCP) プロトコルの両方がサポートされています。

適切なノード IP 割り当ては、クラスターライフサイクル管理の鍵となります。 Azure Arc にノードを登録する前に、静的オプションと DHCP オプションを決定します。

Arc リソース ブリッジやネットワーク コントローラーなどのインフラストラクチャ VM とサービスでは、管理 IP プールの静的 IP が使用され続けます。 これは、DHCP を使用して IP をノードとクラスター IP に割り当てる場合でも、管理 IP プールが引き続き必要であることを意味します。

以降のセクションでは、各オプションの影響について説明します。

静的 IP の割り当て

ノードに静的 IP が使用されている場合、管理 IP プールを使用して使用可能な IP を取得し、デプロイ時にクラスター IP に自動的に割り当てます。

管理 IP プールに定義されている IP 範囲の一部ではないノードには、管理 IP を使用することが重要です。 サーバー ノード IP は、定義された IP 範囲の同じサブネット上にある必要があります。

ノードのすべての物理ネットワーク アダプターに対して、既定のゲートウェイと構成済みの DNS サーバーの管理 IP を 1 つだけ割り当てることをお勧めします。 これにより、管理ネットワークの意図が作成された後に IP が変更されないようにします。 これにより、デプロイ プロセス中 (Azure Arc の登録中も含む) にノードが送信接続を維持することも保証されます。

ルーティングの問題を回避し、送信接続と Arc 登録に使用される IP を特定するために、Azure portal では、複数の既定のゲートウェイが構成されているかどうかを検証します。

OS 構成中に仮想スイッチと管理仮想ネットワーク アダプターが作成された場合、ノードの管理 IP をその仮想ネットワーク アダプターに割り当てる必要があります。

DHCP IP 割り当て

ノードの IP が DHCP サーバーから取得された場合は、クラスター IP にも動的 IP が使用されます。 インフラストラクチャ VM とサービスには静的 IP が引き続き必要です。つまり、管理 IP プールのアドレス範囲は、ノードとクラスター IP に使用される DHCP スコープから除外する必要があります。

たとえば、インフラストラクチャの静的 IP に対して管理 IP 範囲が 192.168.1.20/24 から 192.168.1.30/24 と定義されている場合、サブネット 192.168.1.0/24 に定義されている DHCP スコープには、インフラストラクチャ サービスとの IP 競合を回避するために、管理 IP プールと同等の除外が必要です。 また、ノード IP に DHCP 予約を使用することをお勧めします。

管理インテントを作成した後に管理 IP を定義するプロセスでは、ネットワークインテント用に選択された最初の物理ネットワーク アダプターの MAC アドレスを使用する必要があります。 この MAC アドレスは、管理目的で作成された仮想ネットワーク アダプターに割り当てられます。 つまり、最初の物理ネットワーク アダプターが DHCP サーバーから取得する IP アドレスは、仮想ネットワーク アダプターが管理 IP として使用するのと同じ IP アドレスです。 そのため、ノード IP の DHCP 予約を作成することが重要です。

クラウドのデプロイ時に使用されるネットワーク検証ロジックは、構成に既定のゲートウェイがある複数の物理ネットワーク インターフェイスを検出すると失敗します。 ホスト IP 割り当てに DHCP を使用する必要がある場合は、前述のように SET (スイッチ埋め込みチーミング) 仮想スイッチと管理仮想ネットワーク アダプターを事前に作成する必要があるため、管理仮想ネットワーク アダプターのみが DHCP サーバーから IP アドレスを取得します。

クラスター ノードの IP に関する考慮事項

IP アドレスの概要に関する考慮事項を次に示します。

| # | 考慮事項 |

|---|---|

| 1 | ノード IP は、静的アドレスか動的アドレスかに関係なく、定義された管理 IP プール範囲の同じサブネット上にある必要があります。 |

| 2 | 管理 IP プールにノード IP を含めてはなりません。 動的 IP 割り当てが使用されている場合は、DHCP の除外を使用します。 |

| 3 | 可能な限りノードの DHCP 予約を使用します。 |

| 4 | DHCP アドレスは、ノード IP とクラスター IP でのみサポートされます。 インフラストラクチャ サービスは、管理プールの静的 IP を使用します。 |

| 5 | 管理ネットワークインテントが作成されると、最初の物理ネットワーク アダプターの MAC アドレスが管理仮想ネットワーク アダプターに割り当てられます。 |

プロキシの要件

多くの場合、プロキシは、オンプレミス インフラストラクチャ内のインターネットにアクセスするために必要です。 Azure Stack HCI では、認証されていないプロキシ構成のみがサポートされます。 Azure Arc にノードを登録するにはインターネット アクセスが必要であるため、サーバー ノードを登録する前に、プロキシ構成を OS 構成の一部として設定する必要があります。 (詳細については、プロキシ設定の構成に関するページを参照してください。)

Azure Stack HCI OS には、すべての OS コンポーネントがインターネットにアクセスできるようにするために同じプロキシ構成を必要とする 3 つの異なるサービス (WinInet、WinHTTP、環境変数) があります。 ノードに使用されるのと同じプロキシ構成が Arc Resource Bridge VM と AKS に自動的に引き継がれ、デプロイ時にインターネットにアクセスできるようになります。

プロキシ構成に関する考慮事項の概要を次に示します。

| # | 説明 |

|---|---|

| 1 | Azure Arc にノードを登録する前に、プロキシの構成を完了する必要があります。 |

| 2 | WinINET、WinHTTP、および環境変数には、同じプロキシ構成を適用する必要があります。 |

| 3 | 環境チェッカーを使用すると、すべてのプロキシ コンポーネントでプロキシ構成の一貫性が確保されます。 |

| 4 | Arc Resource Bridge VM と AKS のプロキシ構成は、デプロイ時にオーケストレーターによって自動的に行われます。 |

| 5 | 認証されていないプロキシのみがサポートされます。 |

ファイアウォールの要件

現在、Azure Stack HCI とそのコンポーネントが正常に接続できるように、ファイアウォールで複数のインターネット エンドポイントを開く必要があります。 必要なエンドポイントの詳細な一覧については、 ファイアウォールの要件を参照してください。

Azure Arc にノードを登録する前に、ファイアウォールの構成を行う必要があります。スタンドアロン バージョンの環境チェッカーを使用して、ファイアウォールがこれらのエンドポイントに送信されるトラフィックをブロックしていないことを検証できます。 詳細については、「 Azure Stack HCI 環境チェッカー を参照して、Azure Stack HCI のデプロイの準備状況を評価します。

ファイアウォールに関する考慮事項の概要を次に示します。

| # | 説明 |

|---|---|

| 1 | Azure Arc にノードを登録する前に、ファイアウォールの構成を行う必要があります。 |

| 2 | スタンドアロン モードの環境チェッカーを使用して、ファイアウォール構成を検証できます。 |

手順 5: ネットワーク アダプターの構成を決定する

ネットワーク アダプターは、使用されるネットワーク トラフィックの種類 (管理、コンピューティング、ストレージ) によって修飾されます。 Windows Server カタログを確認すると、Windows Server 2022 認定は、アダプターが修飾されているネットワーク トラフィックを示します。

Azure Stack HCI 用のサーバーを購入する前に、3 つのトラフィックの種類すべてが Azure Stack HCI で必要であるため、少なくとも 1 つのアダプターが管理、コンピューティング、およびストレージに対して修飾されている必要があります。 クラウド展開では、ネットワーク ATC に依存して、適切なトラフィックの種類のネットワーク アダプターを構成するため、サポートされているネットワーク アダプターを使用することが重要です。

Network ATC で使用される既定値については、 クラスター ネットワーク設定に記載されています。 既定値を使用することをお勧めします。 そのため、必要に応じて、Azure portal または Resource Manager テンプレートを使用して次のオプションをオーバーライドできます。

- ストレージ VLAN: この値をストレージに必要な VLAN に設定します。

- ジャンボ パケット: ジャンボ パケットのサイズを定義します。

- ネットワーク ダイレクト: ネットワーク アダプターの RDMA を無効にする場合は、この値を false に設定します。

- ネットワーク ダイレクト テクノロジ: この値を

RoCEv2またはiWarpに設定します。 - トラフィック優先度データセンター ブリッジング (DCB): 要件に合った優先順位を設定します。 既定の DCB 値は、Microsoft と顧客によって検証されるため、使用することを強くお勧めします。

ネットワーク アダプターの構成に関する考慮事項の概要を次に示します。

| # | 説明 |

|---|---|

| 1 | 可能な限り既定の構成を使用してください。 |

| 2 | 物理スイッチは、ネットワーク アダプターの構成に従って構成する必要があります。 Azure Stack HCI の Physical ネットワーク要件を参照してください。 |

| 3 | Windows Server カタログを使用して、ネットワーク アダプターが Azure Stack HCI でサポートされていることを確認します。 |

| 4 | 既定値を受け入れると、ネットワーク ATC はストレージ ネットワーク アダプター IP と VLAN を自動的に構成します。 これはストレージ自動 IP 構成と呼ばれます。 場合によっては、ストレージ自動 IP がサポートされていないため、Resource Manager テンプレートを使用して各ストレージ ネットワーク アダプター IP を宣言する必要があります。 |