Azure AI Studio のモデルカタログとコレクション

重要

この記事で "(プレビュー)" と付記されている項目は、現在、パブリック プレビュー段階です。 このプレビューはサービス レベル アグリーメントなしで提供されており、運用環境ではお勧めしません。 特定の機能はサポート対象ではなく、機能が制限されることがあります。 詳しくは、Microsoft Azure プレビューの追加使用条件に関するページをご覧ください。

Azure AI Studio のモデルカタログは、生成 AI アプリケーションを構築するための幅広いモデルを検索して使用するためのハブです。 モデルカタログには、Microsoft によってトレーニングされたモデルを含む、Azure OpenAI Service、Mistral、Meta、Cohere、NVIDIA、Hugging Face などのモデル プロバイダーにわたる数百のモデルが取り上げられています。 Microsoft 以外のプロバイダーのモデルは、Microsoft 製品使用条件で定義されている、Microsoft 以外の製品であり、モデルに付属される条件に従います。

モデル コレクション

モデルカタログでは、モデルが次の 3 つのコレクションに編成されています。

Azure AI によるキュレーション: Azure AI プラットフォーム上でシームレスに動作するようにパッケージ化され、最適化された、最も一般的な Microsoft 以外のオープン ウェイト モデルとプロプライエタリ モデル。 これらのモデルの使用には、モデル プロバイダーのライセンス条項が適用されます。 Azure AI Studio でこれらのモデルをデプロイする場合、その可用性は Azure サービス レベル アグリーメント (SLA) が適用される対象となり、Microsoft はデプロイの問題に対するサポートを提供します。

Meta、NVIDIA、Mistral AI などのパートナーのモデルは、カタログ上のこのコレクションで利用できるモデルの例です。 これらのモデルは、カタログ内のモデル タイルに緑色のチェックマークが付いているかどうかで特定できます。 または、Azure AI によるキュレーション コレクションでフィルター処理することもできます。

Azure OpenAI モデル (Azure でのみ利用可能): Azure OpenAI Service との統合を通じて利用できる主力 Azure OpenAI モデル。 Microsoft は、製品使用条件および Azure OpenAI Service の SLA に従って、これらのモデルとその使用をサポートしています。

Hugging Face ハブのオープン モデル: マネージド コンピューティングによるリアルタイム推論のための Hugging Face ハブの数百のモデル。 Hugging Face は、このコレクションに掲載されているモデルを作成および維持しています。 サポートが必要な場合は、Hugging Face フォーラムまたは Hugging Face サポートを利用してください。 詳細については、Azure AI Studio を使用したオープン モデルのデプロイに関するページを参照してください。

このフォームを使用して、モデルカタログにモデルを追加する要求を送信できます。

モデルカタログ機能の概要

マネージド コンピューティング オプションを使用して、Azure AI によるキュレーションおよび Hugging Face ハブのオープン モデル コレクション内のモデルのいくつかをデプロイできます。 一部のモデルは、従量課金制のサーバーレス API を介してデプロイできます。

これらのモデルを検出、比較、評価、微調整し (サポートされている場合)、大規模にデプロイできます。 その後、エンタープライズレベルのセキュリティとデータ ガバナンスを備えた生成 AI アプリケーションにモデルを統合できます。 次の一覧では、アクティビティについて詳しく説明します。

- 検索: モデル カードを確認し、サンプル推論を試し、コード サンプルを参照して、モデルの評価、微調整、またはデプロイを行います。

- 比較: 業界で利用可能なモデルとデータセットのベンチマークを比較して、どれが自社のビジネス シナリオに適合するかを評価できます。

- 評価: 独自のテスト データを提供して、モデルが特定のワークロードに適しているかどうかを評価します。 評価メトリックを使用すると、選択したモデルがシナリオでどの程度適切に機能するかを視覚化できます。

- 微調整: 独自のトレーニング データを使用して微調整可能なモデルをカスタマイズし、すべての微調整ジョブのメトリックを比較して最適なモデルを選択します。 組み込みの最適化により、微調整が高速化され、必要なメモリとコンピューティングが削減されます。

- デプロイ: 事前トレーニング済みモデルまたは微調整されたモデルを推論用にシームレスにデプロイします。 マネージド コンピューティングにデプロイできるモデルをダウンロードすることもできます。

Azure OpenAI モデルの詳細については、「Azure OpenAI Service とは」を参照してください。

モデル デプロイ: マネージド コンピューティングとサーバーレス API (従量課金制)

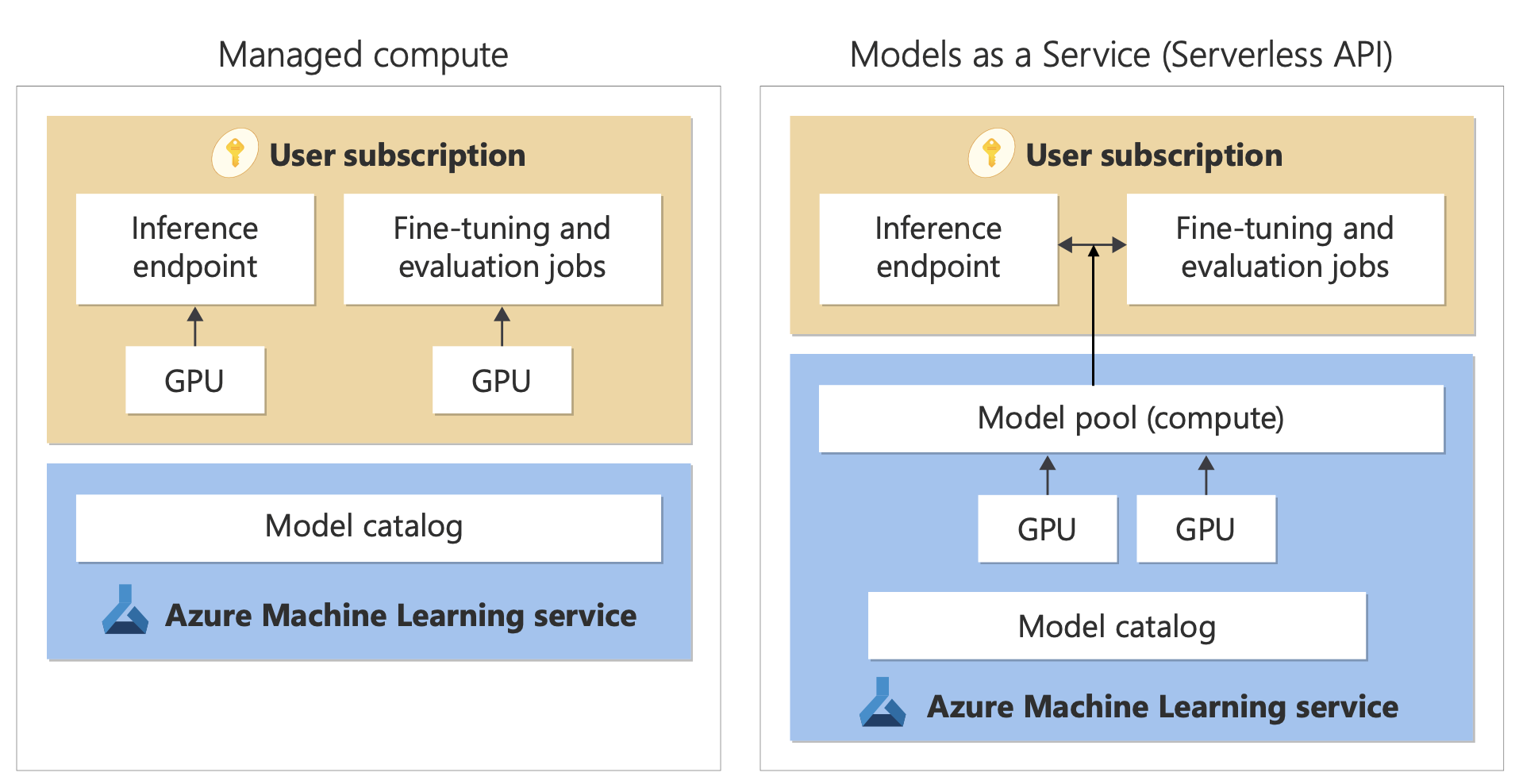

モデルカタログには、マネージド コンピューティングとサーバーレス API という、使用するモデルをデプロイするための 2 つの異なる方法が用意されています。

次の表に示すように、モデルごとに使用できるデプロイ オプションと機能は異なります。 デプロイ オプションを使用したデータ処理の詳細を確認してください。

モデル デプロイ オプションの機能

| 機能 | マネージド コンピューティング | サーバーレス API (従量課金制) |

|---|---|---|

| デプロイ エクスペリエンスと課金 | モデルの重みは、マネージド コンピューティングを備えた専用の仮想マシンにデプロイされます。 マネージド コンピューティングは、1 つ以上のデプロイを持つことができ、推論に REST API が利用可能になります。 デプロイで使用される仮想マシンのコア時間に対して課金されます。 | モデルへのアクセスは、モデルにアクセスするための API をプロビジョニングするデプロイを通じて行われます。 この API は、推論のために Microsoft がホストおよび管理するモデルへのアクセスを提供します。 API への入力と出力に対して (通常はトークンで) 課金されます。 デプロイする前に価格情報が提供されます。 |

| API 認証 | キーと Microsoft Entra 認証。 | キーのみ。 |

| コンテンツの安全性 | Azure AI Content Safety サービス API を使用します。 | Azure AI Content Safety フィルターを、推論 API と統合して使用できます。 Azure AI Content Safety フィルターは、個別に課金されます。 |

| ネットワークの分離 | Azure AI Studio ハブ用にマネージド ネットワークを構成する。 | マネージド コンピューティングは、使用しているハブの公衆ネットワーク アクセス (PNA) のフラグ設定に従います。 詳細については、この記事で後述する「サーバーレス API を使用してデプロイされたモデルのネットワークの分離」を参照してください。 |

サポートされているデプロイ オプションで使用可能なモデル

| モデル | マネージド コンピューティング | サーバーレス API (従量課金制) |

|---|---|---|

| Llama ファミリ モデル | Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-3-8B Llama-3-70B |

Llama-3-70B-Instruct Llama-3-8B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Mistral ファミリ モデル | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Ministral-3B Mistral-NeMo |

| Cohere ファミリ モデル | 使用不可 | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual Cohere-rerank-v3-english Cohere-rerank-v3-multilingual |

| JAIS | 使用不可 | jais-30b-chat |

| 医療 AI ファミリ モデル | MedImageInsight CxrReportGen MedImageParse |

利用不可 |

| Phi-3 ファミリ モデル | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

| Nixtla | 使用不可 | TimeGEN-1 |

| その他のモデル | 使用可能 | 使用不可 |

マネージド コンピューティング

モデルをマネージド コンピューティングとしてデプロイする機能は、Azure Machine Learning のプラットフォーム機能に基づいて構築されており、大規模言語モデル (LLM) 操作のライフ サイクル全体にわたって、モデルカタログ内のモデルの幅広いコレクションをシームレスに統合できます。

マネージド コンピューティングとしてデプロイするためのモデルの可用性

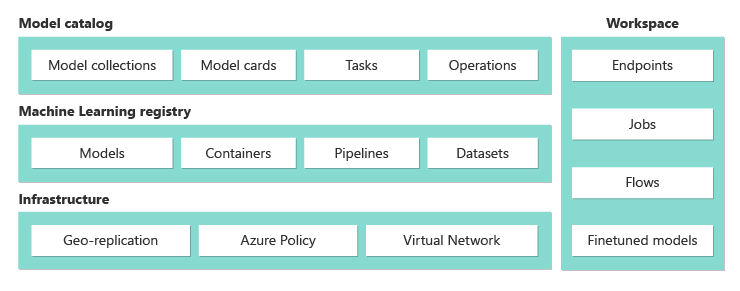

モデルは、Azure Machine Learning レジストリを通じて利用できます。 これらのレジストリにより、Azure Machine Learning 資産のホスティングと配布に機械学習を優先するアプローチが可能になります。 これらの資産には、モデルの重み、モデルを実行するためのコンテナー ランタイム、モデルを評価および微調整するためのパイプライン、ベンチマークとサンプルのデータセットが含まれます。

レジストリは、高度にスケーラブルでエンタープライズ対応のインフラストラクチャの上に構築されており、次を実現します。

組み込みの geo レプリケーションで、低遅延のアクセス モデル成果物をすべての Azure リージョンに提供します。

Azure Policy を使用したモデルへのアクセスの制限や、マネージド仮想ネットワークを使用した安全なデプロイなど、エンタープライズ セキュリティ要件をサポートします。

マネージド コンピューティングを使用した推論用モデルのデプロイ

マネージド コンピューティングへのデプロイに使用できるモデルは、Azure Machine Learning のマネージド コンピューティングにデプロイして、リアルタイム推論に利用できます。 マネージド コンピューティングへのデプロイには、モデルを最適に実行するために必要な特定の製品に対する Azure サブスクリプションの仮想マシン クォータが必要です。 一部のモデルでは、モデルのテスト用に一時的に共有されるクォータにデプロイできます。

モデルのデプロイの詳細については、次を参照してください。

マネージド コンピューティングを使用した生成 AI アプリの構築

Azure Machine Learning の "プロンプト フロー" 機能は、プロトタイプ作成に優れたエクスペリエンスを提供します。 Open Model LLM ツールでは、マネージド コンピューティングでデプロイされたモデルをプロンプト フローで使用できます。 また、Azure Machine Learning 拡張機能を使用して、LangChain などの一般的な LLM ツールでマネージド コンピューティングによって公開される REST API を使用することもできます。

マネージド コンピューティングとしてデプロイされたモデルのコンテンツの安全性

Azure AI Content Safety サービスは、マネージド コンピューティングで使用して、性的コンテンツ、暴力、憎悪、自傷行為などのさまざまなカテゴリの有害なコンテンツをスクリーニングするために使用できます。 このサービスを使用して、ジェイルブレイク リスク検出や保護されたマテリアル テキストの検出などの高度な脅威をスクリーニングすることもできます。

Llama 2 用 Azure AI Content Safety との統合のリファレンスについては、このノートブックを参照してください。 または、プロンプト フローで Content Safety (テキスト) ツールを使用して、スクリーニングのためにモデルからの応答を Azure AI Content Safety に渡すこともできます。 「Azure AI Content Safety の価格」で説明されているように、そのような使用に対しては別途課金されます。

従量課金制のサーバーレス API

モデルカタログ内の特定のモデルを、従量課金制のサーバーレス API としてデプロイできます。 このデプロイ方法は、"サービスとしてのモデル" (MaaS) とも呼ばれ、モデルをサブスクリプションでホストせずに API として使用する方法を提供します。 モデルは Microsoft が管理するインフラストラクチャでホストされ、モデル プロバイダーのモデルへの API ベースのアクセスが可能になります。 API ベースのアクセスにより、モデルにアクセスするコストが大幅に削減され、プロビジョニング エクスペリエンスがシンプルになります。

従量課金制のサーバーレス API としてデプロイできるモデルはモデル プロバイダーによって提供されますが、それらは Microsoft が管理する Azure インフラストラクチャでホストされ、API を介してアクセスされます。 モデル プロバイダーはライセンス条項を定義し、モデルの利用価格を設定します。 Azure Machine Learning service。

- ホスティング インフラストラクチャを管理します。

- 推論 API を使用できるようにします。

- MaaS を使用してデプロイされたモデルによって送信されたプロンプトとコンテンツ出力のデータ プロセッサとして機能します。

MaaS のデータ処理の詳細については、データ プライバシーに関する記事を参照してください。

請求

MaaS を使用してデプロイされたモデルの検索、サブスクリプション、使用エクスペリエンスは、Azure AI Studio と Azure Machine Learning スタジオにあります。 ユーザーはモデルの使用に関するライセンス条項に同意します。 使用する価格情報はデプロイ時に提供されます。

Microsoft 以外のプロバイダーのモデルは、Microsoft コマーシャル マーケットプレースの利用規約に従って、Azure Marketplace を通じて課金されます。

Microsoft のモデルは、ファースト パーティ従量課金サービスとして Azure メーターを介して課金されます。 製品使用条件に記載されているように、ファースト パーティ従量課金サービスは Azure メーターを使用して購入しますが、Azure サービス使用条件の対象ではありません。 これらのモデルの使用には、提供されているライセンス条項が適用されます。

モデルの微調整

一部のモデルでは、サーバーレスの微調整もサポートされています。 これらのモデルの場合、従量課金制のホストされたファインチューニングを利用して、ユーザーが提供したデータを使用してモデルを調整できます。 詳細については、ファインチューニングの概要に関するページを参照してください。

サーバーレス API としてデプロイされたモデルを使用した RAG

Azure AI Studio では、ベクター インデックスと取得拡張生成 (RAG) を使用できます。 サーバーレス API を使用してデプロイできるモデルを使用して、カスタム データに基づいて埋め込みと推論を生成できます。 これらの埋め込みと推論により、ユース ケースに固有の回答を生成できます。 詳細については、「Azure AI Studio でベクター インデックスを構築および使用する」に関する記事を参照してください。

オファーとモデルのリージョン別の利用可能性

従量課金制の課金を利用できるのは、所有している Azure サブスクリプションが、モデル プロバイダーがこのオファーを利用可能にしている国内の課金アカウントに属しているユーザーだけです。 関連するリージョンでこのオファーが利用できる場合、ユーザーはモデルのデプロイまたはファインチューニングの内の必要な方が利用できる Azure リージョン内にハブ/プロジェクトを所有している必要があります。 詳細については、「サーバーレス API エンドポイントでのモデルのリージョンごとの利用可能性 | Azure AI Studio」を参照してください。

サーバーレス API を使用してデプロイされたモデルのコンテンツの安全性

サーバーレス API を介してデプロイされた言語モデルの場合、Azure AI では、ヘイト、自傷行為、性的、暴力的なコンテンツなどの有害なコンテンツを検出する、Azure AI Content Safety テキスト モデレーション フィルターの既定の構成が実装されます。 コンテンツのフィルター処理 (プレビュー) の詳細については、「Azure AI Content Safety の有害なカテゴリ」を参照してください。

ヒント

コンテンツ フィルタリング (プレビュー) は、サーバーレス API を介してデプロイされる特定のモデルの種類では使用できません。 これらのモデルの種類には、埋め込みモデルと時系列モデルが含まれます。

コンテンツのフィルター処理 (プレビュー) は、サービスがコンテンツを生成するためのプロンプトを処理するときに同期的に行われます。 そのような使用については、「Azure AI Content Safety の価格」に従って別途課金される場合があります。 次のいずれかで、個々のサーバーレス エンドポイントのコンテンツのフィルター処理 (プレビュー) を無効にできます。

- 言語モデルを初めてデプロイした時点で

- 後から、デプロイの詳細ページでコンテンツのフィルター処理の切り替えの選択により

Azure AI モデル推論 API 以外の API を使用して、サーバーレス API 経由でデプロイされたモデルを操作することにしたとします。 このような状況では、Azure AI Content Safety を使用して個別に実装しない限り、コンテンツ フィルタリング (プレビュー) は有効になりません。

Azure AI Content Safety の概要については、「クイックスタート: テキスト コンテンツの分析」を参照してください。 サーバーレス API を使用してデプロイされたモデルを操作するときにコンテンツ フィルタリング (プレビュー) を使用しない場合は、有害なコンテンツにユーザーをさらすリスクが高くなります。

サーバーレス API を使用してデプロイされたモデルのネットワークの分離

サーバーレス API としてデプロイされたモデルのマネージド コンピューティングは、デプロイが存在するプロジェクトがある AI Studio ハブの公衆ネットワーク アクセスのフラグ設定に従います。 マネージド コンピューティングのセキュリティ保護を促進するには、AI Studio ハブの公衆ネットワーク アクセス フラグを無効にします。 ハブのプライベート エンドポイントを使用すると、クライアントからマネージド コンピューティングへの受信通信のセキュリティ保護を促進できます。

AI Studio ハブの公衆ネットワーク アクセス フラグを設定するには:

- Azure ポータルにアクセスします。

- ハブが属しているリソース グループを検索し、このリソース グループに一覧表示されているリソースから AI Studio ハブを選択します。

- ハブの概要ページの左ペインで、[設定]>[ネットワーク] に移動します。

- [パブリック アクセス] タブで、公衆ネットワーク アクセス フラグの設定を構成できます。

- 変更を保存。 変更が反映されるまでに最大 5 分かかる場合があります。

制限事項

2024 年 7 月 11 日より前に作成されたマネージド コンピューティングを持つ AI Studio ハブがある場合、このハブのプロジェクトに追加されたマネージド コンピューティングは、そのハブのネットワーク構成に従いません。 代わりに、ハブの新しいマネージド コンピューティングを作成し、プロジェクトに新しいサーバーレス API デプロイを作成して、新しいデプロイがハブのネットワーク構成に従うことができるようにする必要があります。

2024 年 7 月 11 日より前に MaaS デプロイが作成された AI Studio ハブがあり、このハブでマネージド コンピューティングを有効にしている場合、既存の MaaS デプロイはハブのネットワーク構成に従いません。 ハブ内のサーバーレス API デプロイでハブのネットワーク構成に従うようにするには、デプロイをもう一度作成する必要があります。

現在、プライベート ハブでは公衆ネットワーク アクセス フラグが無効になっているため、プライベート ハブの MaaS デプロイでは Azure OpenAI On Your Data のサポートを利用できません。

ネットワーク構成の変更 (公衆ネットワーク アクセス フラグの有効化または無効化など) が反映されるまでに最大 5 分かかる場合があります。