HBv2 シリーズの仮想マシンのサイズ

適用対象: ✔️ Linux VM ✔️ Windows VM ✔️ フレキシブル スケール セット ✔️ 均一スケール セット

HBv2 シリーズのサイズの VM については、いくつかのパフォーマンス テストが実行されています。 このパフォーマンス テストの結果の一部を次に示します。

| ワークロード | HBv2 |

|---|---|

| STREAM Triad | 350 GB/秒 (CCX あたり 21-23 GB/秒) |

| High-Performance Linpack (HPL) | 4 テラフロップス (Rpeak、FP64)、8 テラフロップス (Rpeak、FP32) |

| RDMA の待機時間と帯域幅 | 1.2 マイクロ秒、190 Gb/秒 |

| ローカル NVMe SSD 上の FIO | 2.7 GB/秒の読み取り、1.1 GB/秒の書き込み。102k IOPS 読み取り、115 IOPS 書き込み |

| 8 * Azure Premium SSD 上の IOR (P40 Managed Disks、RAID0)** | 1.3 GB/秒の読み取り、2.5 GB/書き込み。101k IOPS 読み取り、105k IOPS 書き込み |

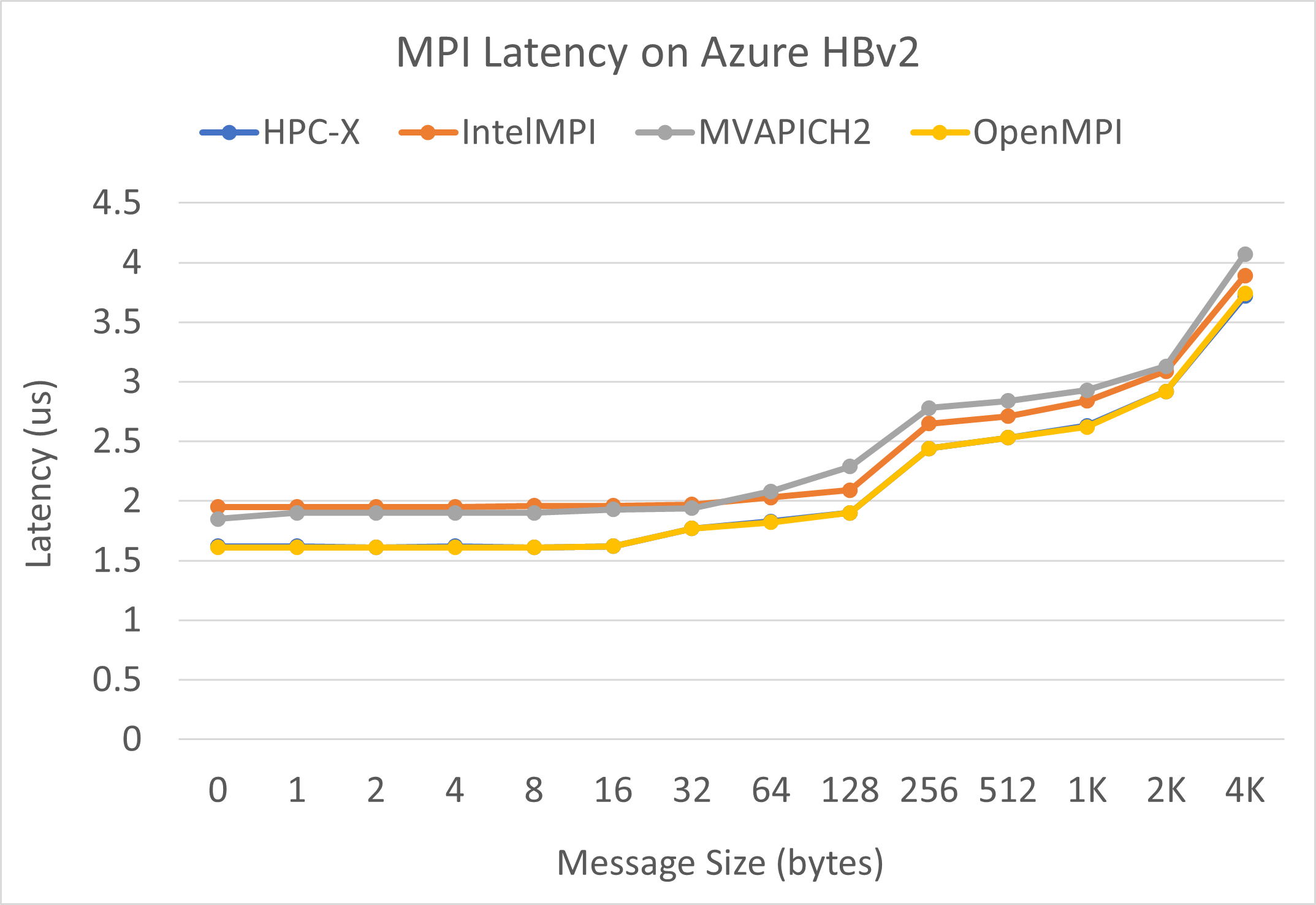

MPI 待機時間

OSU マイクロベンチマーク スイートからの MPI 待機時間テストが実行されます。 サンプル スクリプトは GitHub にあります。

./bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./osu_latency

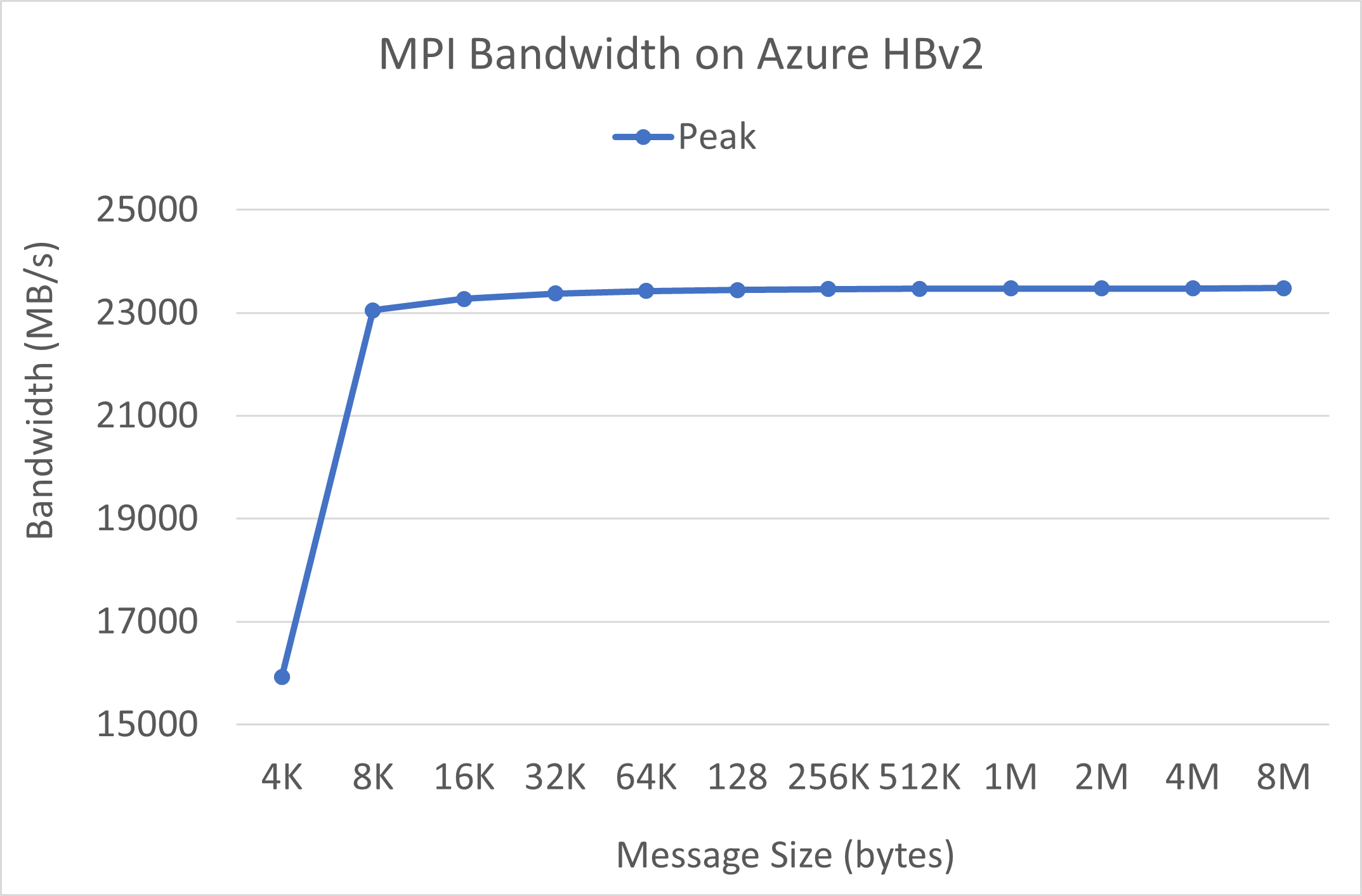

MPI 帯域幅

OSU マイクロベンチマーク スイートからの MPI 帯域幅テストが実行されます。 サンプル スクリプトは GitHub にあります。

./mvapich2-2.3.install/bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./mvapich2-2.3/osu_benchmarks/mpi/pt2pt/osu_bw

Mellanox Perftest

Mellanox Perftest パッケージには、待機時間 (ib_send_lat) や帯域幅 (ib_send_bw) などの多くの InfiniBand テストがあります。 コマンドの例を次に示します。

numactl --physcpubind=[INSERT CORE #] ib_send_lat -a

次の手順

- Azure Compute Tech Community のブログで、最新の発表、HPC ワークロードの例、およびパフォーマンスの結果について参照します。

- アーキテクチャの面から見た HPC ワークロードの実行の概要については、「Azure でのハイ パフォーマンス コンピューティング (HPC)」を参照してください。