CNTK v2.7 リリース ノート

親愛なるコミュニティ、

ONNX と ONNX ランタイムへの継続的な貢献により、AI フレームワーク エコシステム内での相互運用が容易になり、従来の ML モデルとディープ ニューラル ネットワークの両方に対して、高パフォーマンスのクロスプラットフォーム推論機能に簡単にアクセスできるようになりました。 ここ数年、Microsoft Cognitive Toolkit を含め、このような主要なオープンソース機械学習プロジェクトを開発する特権を持っています。これにより、ユーザーは業界全体のディープ ラーニングの進歩を大規模に活用できます。

本日の 2.7 リリースは、CNTK の最後のメイン リリースになります。 バグ修正のためのマイナー リリースが今後いくつかある場合がありますが、これらはケース バイ ケースで評価されます。 このリリース後の新機能開発の予定はありません。

CNTK 2.7 リリースでは、ONNX 1.4.1 が完全にサポートされており、ONNX と ONNX ランタイムを活用するために CNTK モデルを運用化しようとしているユーザーに推奨されます。 今後も、ユーザーは、それをサポートするフレームワークの数を通じて、進化する ONNX イノベーションを活用し続けることができます。 たとえば、ユーザーは、TensorFlow-ONNX コンバーターを使用して、OnNX モデルを PyTorch からネイティブにエクスポートしたり、TensorFlow モデルを ONNX に変換したりできます。

私たちは、CNTKの最初のオープンソースリリース以来、長年にわたって共同作成者やユーザーから受け取ったすべてのサポートに非常に感謝しています。 CNTK では、Microsoft チームと外部ユーザーの両方が、フレームワークの作成者である Microsoft Speech 研究者によって達成された音声認識の歴史的なブレークスルーなど、あらゆる方法で複雑で大規模なワークロードをディープ ラーニング アプリケーションで実行できるようになりました。

onNX は、Bingや Office などの Microsoft 製品全体で使用されるモデルの提供にますます採用されているため、エコシステムを前進させるための厳しい生産要求と研究からのイノベーションの合成に専念しています。

何よりも、私たちの目標は、ソフトウェアスタックとハードウェアスタック全体のディープラーニングのイノベーションを可能な限りオープンでアクセス可能にすることです。 私たちは、CNTKの既存の強みと新しい最先端の研究の両方を他のオープンソースプロジェクトに取り組み、そのような技術の範囲を本当に広げていきます。

感謝の気持ちで、

-- CNTK チーム

このリリースのハイライト

- Windows と Linux の両方で CUDA 10 に移行しました。

- ONNX エクスポートでの事前 RNN ループをサポートします。

- ONNX 形式で 2 GB を超えるモデルをエクスポートします。

- Brain Script train アクションで FP16 をサポートします。

CUDA 10 の CNTK サポート

CNTK で CUDA 10 がサポートされるようになりました。 これには、Visual Studio 2017 v15.9 for Windows への環境をビルドするための更新プログラムが必要です。

Windows でビルド環境とランタイム環境をセットアップするには:

- Visual Studio 2017

インストールします。 注: CUDA 10 以降では、特定の VC Tools バージョン 14.11 をインストールして実行する必要はなくなりました。 - Nvidia CUDA 10

インストールする - PowerShell から、次を実行します: DevInstall.ps1

- Visual Studio 2017 を起動し、CNTK.slnを開きます。

Docker を使用して Linux 上にビルド環境とランタイム環境をセットアップするには、ここでDockerfiles

ONNX エクスポートでの事前 RNN ループのサポート

再帰ループを含む CNTK モデルは、スキャン操作を使用して ONNX モデルにエクスポートできます。

ONNX 形式で 2 GB を超えるモデルをエクスポートする

ONNX 形式で 2 GB を超えるモデルをエクスポートするには、cntk を使用します。Function API: save(self, filename, format=ModelFormat.CNTKv2, use_external_files_to_store_parameters=False) と 'format' を ModelFormat.ONNX に設定し、use_external_files_to_store_parameters True に設定します。 この場合、モデル パラメーターは外部ファイルに保存されます。 エクスポートされたモデルは、onnxruntime でモデル評価を行うときに、外部パラメーター ファイルと共に使用する必要があります。

2018-11-26。

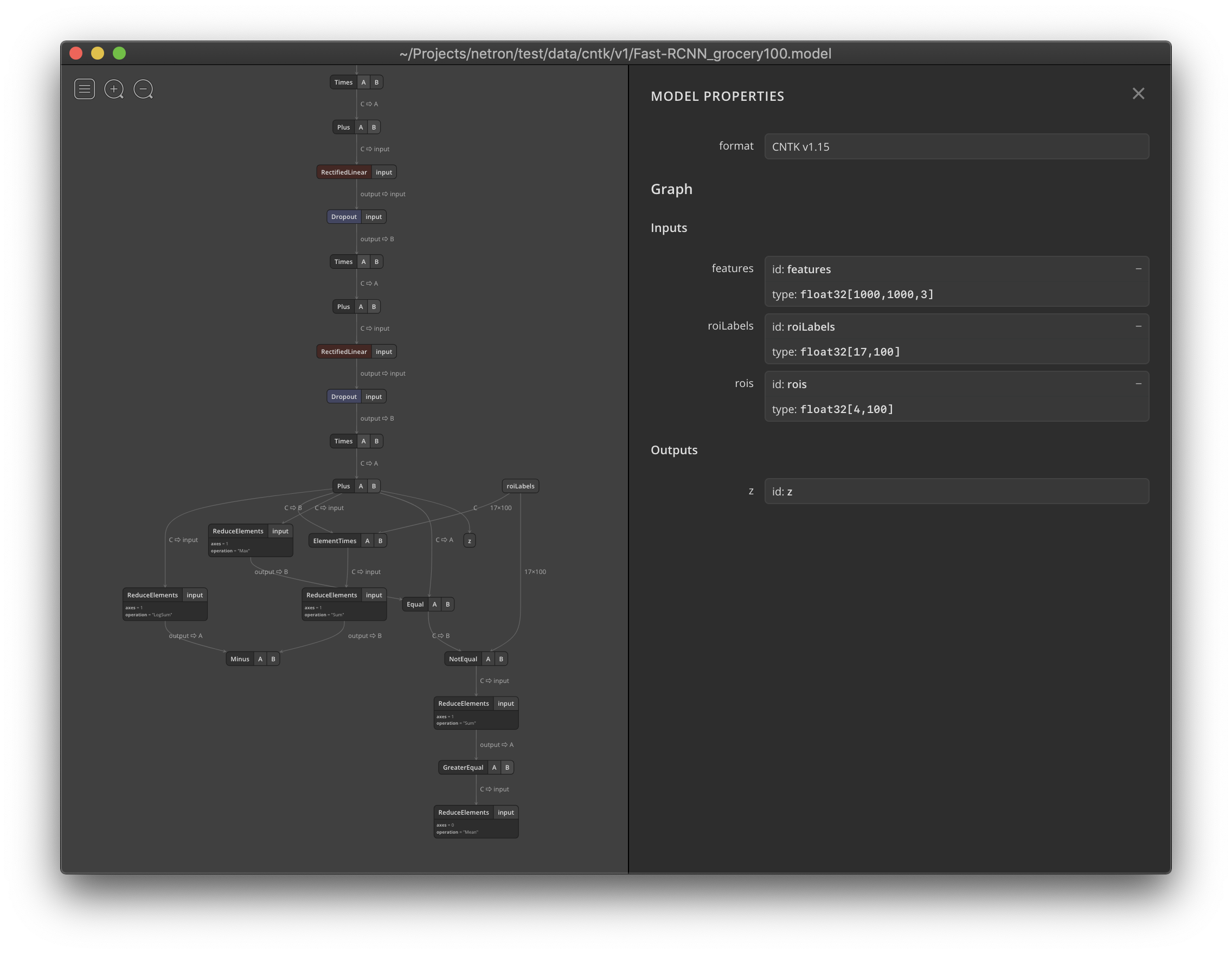

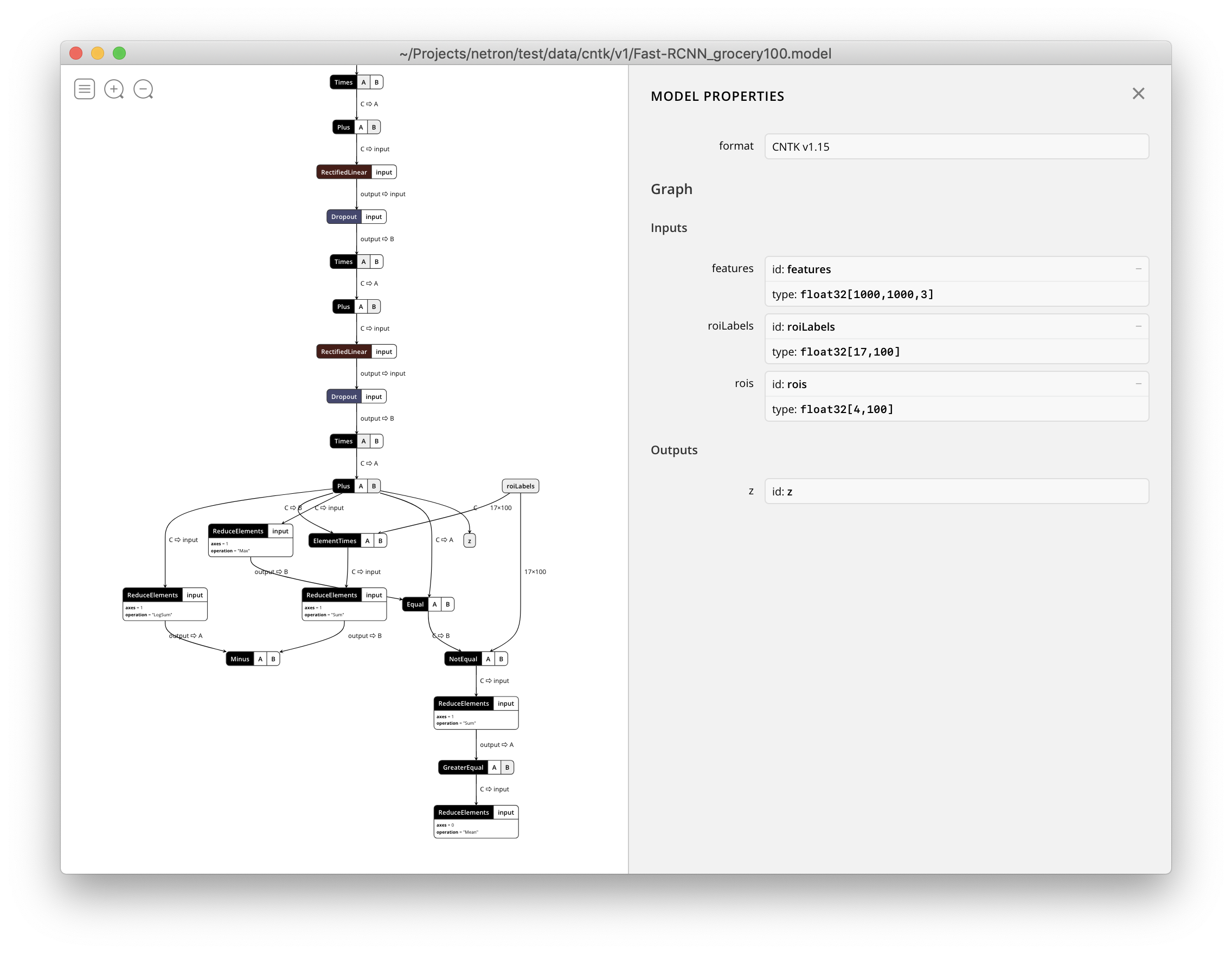

Netron では、CNTK v1 および CNTK v2 .model ファイルの視覚化がサポートされるようになりました。