生成 AI モデルをデプロイする

プロンプトに対する応答を受け取るには、最初にチャット対象または API 呼び出しを行うモデルをデプロイする必要があります。 新しいデプロイを作成するときは、デプロイする基本モデルを指定する必要があります。 1 分あたりのトークン数 (TPM) がデプロイ クォータ内に収まる限りは、1 つまたは複数の Azure OpenAI リソースに任意の数のデプロイをデプロイできます。

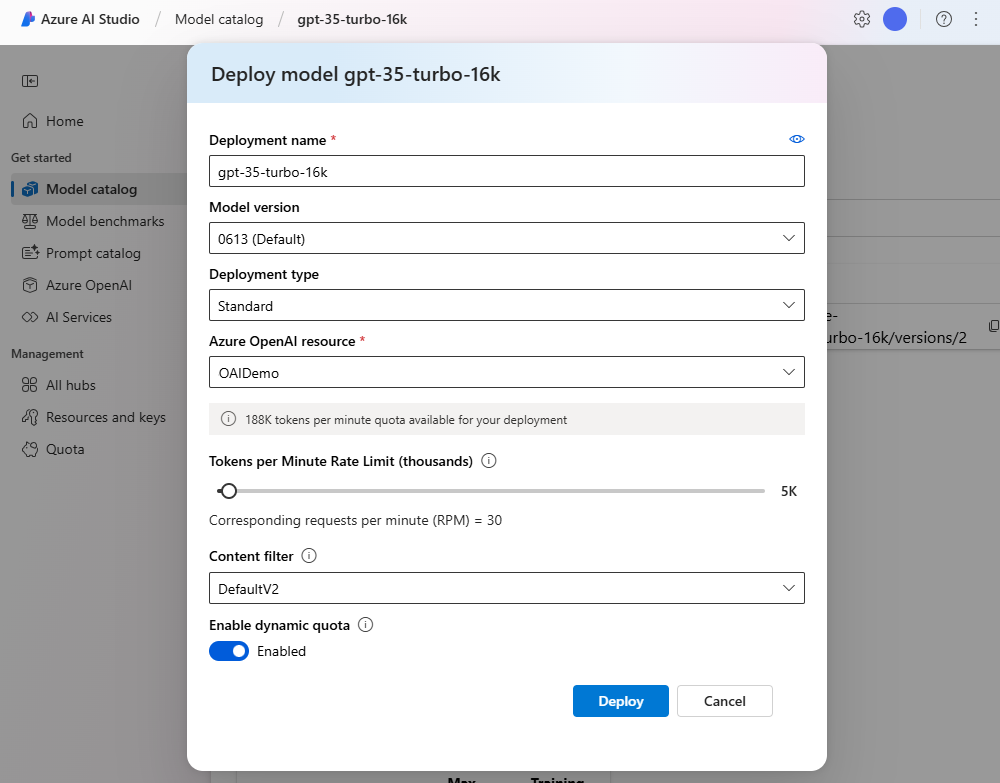

Azure AI Studio を使用してデプロイする

Azure AI Studio の [デプロイ] ページでは、メニューからモデル名を選択することで新しいデプロイを作成できます。 モデル ページには、使用できる基本モデルの一覧が表示されます。

Studio の [デプロイ] ページでは、デプロイ名、モデル名、モデルのバージョン、状態、作成日など、すべてのデプロイに関する情報を見ることもできます。

Azure CLI を使用したデプロイ

コンソールを使ってモデルをデプロイすることもできます。 この例を使い、次の変数を独自のリソースの値に置き換えます。

- OAIResourceGroup: 実際のリソース グループ名に置き換えます

- MyOpenAIResource: 実際のリソース名に置き換えます

- MyModel: モデルの一意の名前に置き換えます

- gpt-35-turbo: "デプロイする基本モデルに置き換えます"

az cognitiveservices account deployment create \

-g OAIResourceGroup \

-n MyOpenAIResource \

--deployment-name MyModel \

--model-name gpt-35-turbo \

--model-version "0301" \

--model-format OpenAI \

--sku-name "Standard" \

--sku-capacity 1

REST API を使用したデプロイ

REST API を使ってモデルをデプロイできます。 要求本文で、デプロイする基本モデルを指定します。 例については、Azure OpenAI のドキュメントを参照してください。