Azure API Management에서 Azure OpenAI API에 대한 의미 체계 캐싱을 사용하도록 설정합니다.

적용 대상: 기본 v2 | 표준 v2

Azure OpenAI API 요청에 대한 응답의 의미 체계 캐싱을 사용하도록 설정하여 백 엔드 API에 부과된 대역폭 및 처리 요구 사항을 줄이고 API 소비자가 인식하는 대기 시간을 줄입니다. 의미 체계 캐싱을 사용하면 동일한 프롬프트에 대해 캐시된 응답을 반환할 수 있으며 텍스트가 동일하지 않더라도 의미가 비슷한 프롬프트에 대해서도 캐시된 응답을 반환할 수 있습니다. 백그라운드 지식은 자습서: Azure Cache for Redis를 의미 체계 캐시로 사용을 참조하세요.

참고 항목

이 문서의 구성 단계에서는 Azure OpenAI API에 대한 의미 체계 캐싱을 사용하도록 설정합니다. 이러한 단계는 Azure AI 모델 유추 API를 통해 사용할 수 있는 해당 LLM(대규모 언어 모델) API에 대한 의미 체계 캐싱을 사용하도록 일반화할 수 있습니다.

필수 조건

- API Management 인스턴스에 하나 이상의 Azure OpenAI Service API를 추가해야 합니다. 자세한 내용은 Azure API Management에 Azure OpenAI Service API 추가를 참조하세요.

- Azure OpenAI 서비스에는 다음에 대한 배포가 있어야 합니다.

- 채팅 완료 API(또는 완료 API) - API 소비자 호출에 사용되는 배포

- 포함 API - 의미 체계 캐싱에 사용되는 배포

- Azure OpenAI API에 대한 관리 ID 인증을 사용하도록 API Management 인스턴스를 구성해야 합니다. 자세한 내용은 Azure API Management를 사용하여 Azure OpenAI API에 대한 액세스 인증 및 권한 부여를 참조하세요.

- Azure Cache for Redis Enterprise Redis Enterprise 캐시에서 RediSearch 모듈을 사용하도록 설정해야 합니다.

참고 항목

새 Redis Enterprise 캐시를 만들 때만 RediSearch 모듈을 사용하도록 설정할 수 있습니다. 기존 캐시에 모듈을 추가할 수 없습니다. 자세한 정보

- Azure API Management 인스턴스에 구성된 외부 캐시입니다. 단계는 Azure API Management에서 외부 Azure Cache for Redis 사용을 참조하세요.

채팅 API 배포 테스트

먼저 Azure OpenAI 배포를 테스트하여 채팅 완료 API 또는 채팅 API가 예상대로 작동하는지 확인합니다. 단계는 Azure API Management로 Azure OpenAI API 가져오기를 참조하세요.

예를 들어, 요청 본문에 프롬프트가 포함된 API 엔드포인트에 POST 요청을 보내 Azure OpenAI 채팅 API를 테스트합니다. 응답에는 프롬프트 완료가 포함되어야 합니다. 요청 예:

POST https://my-api-management.azure-api.net/my-api/openai/deployments/chat-deployment/chat/completions?api-version=2024-02-01

요청 본문:

{"messages":[{"role":"user","content":"Hello"}]}

요청이 성공하면 응답에 채팅 메시지 완료가 포함됩니다.

포함 API에 대한 백 엔드 만들기

다음 설정을 사용하여 포함 API 배포에 대한 백 엔드 리소스를 구성합니다.

- 이름 - 원하는 이름입니다(예:

embeddings-backend). 이 이름을 사용하여 정책에서 백 엔드를 참조하세요. - 형식 - 사용자 지정 URL을 선택합니다.

- 런타임 URL - 다음과 유사한 Azure OpenAI Service에 포함 API 배포의 URL입니다.

https://my-aoai.openai.azure.com/openai/deployments/embeddings-deployment/embeddings

백 엔드 테스트

백 엔드를 테스트하려면 Azure OpenAI Service API에 대한 API 작업을 만듭니다.

- API의 디자인 탭에서 + 작업 추가를 선택합니다.

- 작업에 대한 표시 이름을 입력하고 선택적으로 이름을 입력합니다.

- 프런트 엔드 섹션의 URL에서 POST를 선택하고 경로

/을 입력합니다. - 헤더 탭에서 이름이

Content-Type이고 값이application/json인 필수 헤더를 추가합니다. - 저장을 선택합니다.

API 작업의 인바운드 처리 섹션에서 다음 정책을 구성합니다. set-backend-service 정책에서 만든 백 엔드 이름을 대체합니다.

<policies>

<inbound>

<set-backend-service backend-id="embeddings-backend" />

<authentication-managed-identity resource="https://cognitiveservices.azure.com/" />

[...]

</inbound>

[...]

</policies>

테스트 탭에서 2024-02-01과 같은 값을 가진 api-version 쿼리 매개 변수를 추가하여 작업을 테스트합니다. 유효한 요청 본문을 제공합니다. 예시:

{"input":"Hello"}

요청이 성공하면 응답에 입력 텍스트의 벡터 표현이 포함됩니다.

{

"object": "list",

"data": [{

"object": "embedding",

"index": 0,

"embedding": [

-0.021829502,

-0.007157768,

-0.028619017,

[...]

]

}]

}

의미 체계 캐싱 정책 구성

Azure API Management에서 Azure OpenAI API에 대한 의미 체계 캐싱을 사용하도록 설정하려면 다음 정책을 구성합니다.

API의 인바운드 처리 섹션에서 azure-openai-semantic-cache-lookup 정책을 추가합니다.

embeddings-backend-id특성에서 만든 포함 API 백 엔드를 지정합니다.참고 항목

다른 큰 언어 모델 API에 대한 의미 체계 캐싱을 사용하도록 설정하는 경우 llm-semantic-cache-lookup 정책을 대신 사용합니다.

예시:

<azure-openai-semantic-cache-lookup score-threshold="0.8" embeddings-backend-id="embeddings-deployment" embeddings-backend-auth="system-assigned" ignore-system-messages="true" max-message-count="10"> <vary-by>@(context.Subscription.Id)</vary-by> </azure-openai-semantic-cache-lookup>API의 아웃바운드 처리 섹션에서 azure-openai-semantic-cache-store 정책을 추가합니다.

참고 항목

다른 큰 언어 모델 API에 대한 의미 체계 캐싱을 사용하도록 설정하는 경우 llm-semantic-cache-store 정책을 대신 사용합니다.

예시:

<azure-openai-semantic-cache-store duration="60" />

캐싱 확인

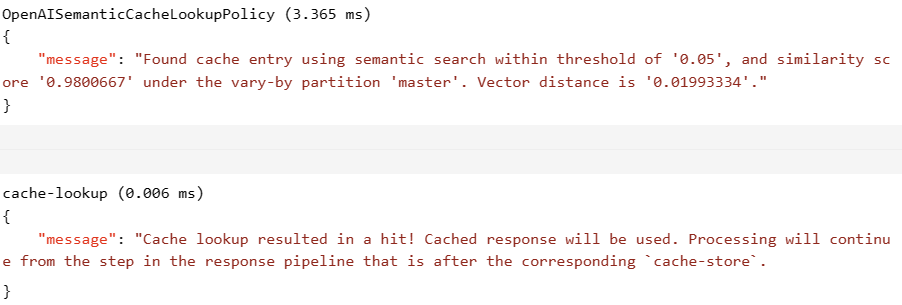

의미 체계 캐싱이 예상대로 작동하는지 확인하려면 포털의 테스트 콘솔을 사용하여 테스트 완료 또는 채팅 완료 작업을 추적합니다. 추적을 검사하여 후속 시도에서 캐시가 사용되었는지 확인합니다. Azure API Management에서 API 호출 추적에 대해 자세히 알아봅니다.

예를 들어, 캐시가 사용된 경우 출력 섹션에는 다음 스크린샷과 유사한 항목이 포함됩니다.