최적화된 LLM 서비스 엔드포인트를 프로비전된 처리량으로 마이그레이션

이 문서에서는 기존 LLM 서비스 엔드포인트를 Foundation Model API를 사용하여 사용 가능한 프로비전된 처리량 환경으로 마이그레이션하는 방법을 설명합니다.

변경 내용은 무엇인가요?

프로비전된 처리량은 최적화된 LLM 서비스 엔드포인트를 시작하기 위한 더 간단한 환경을 제공합니다. Databricks는 다음을 위해 LLM 모델 서비스 시스템을 수정했습니다.

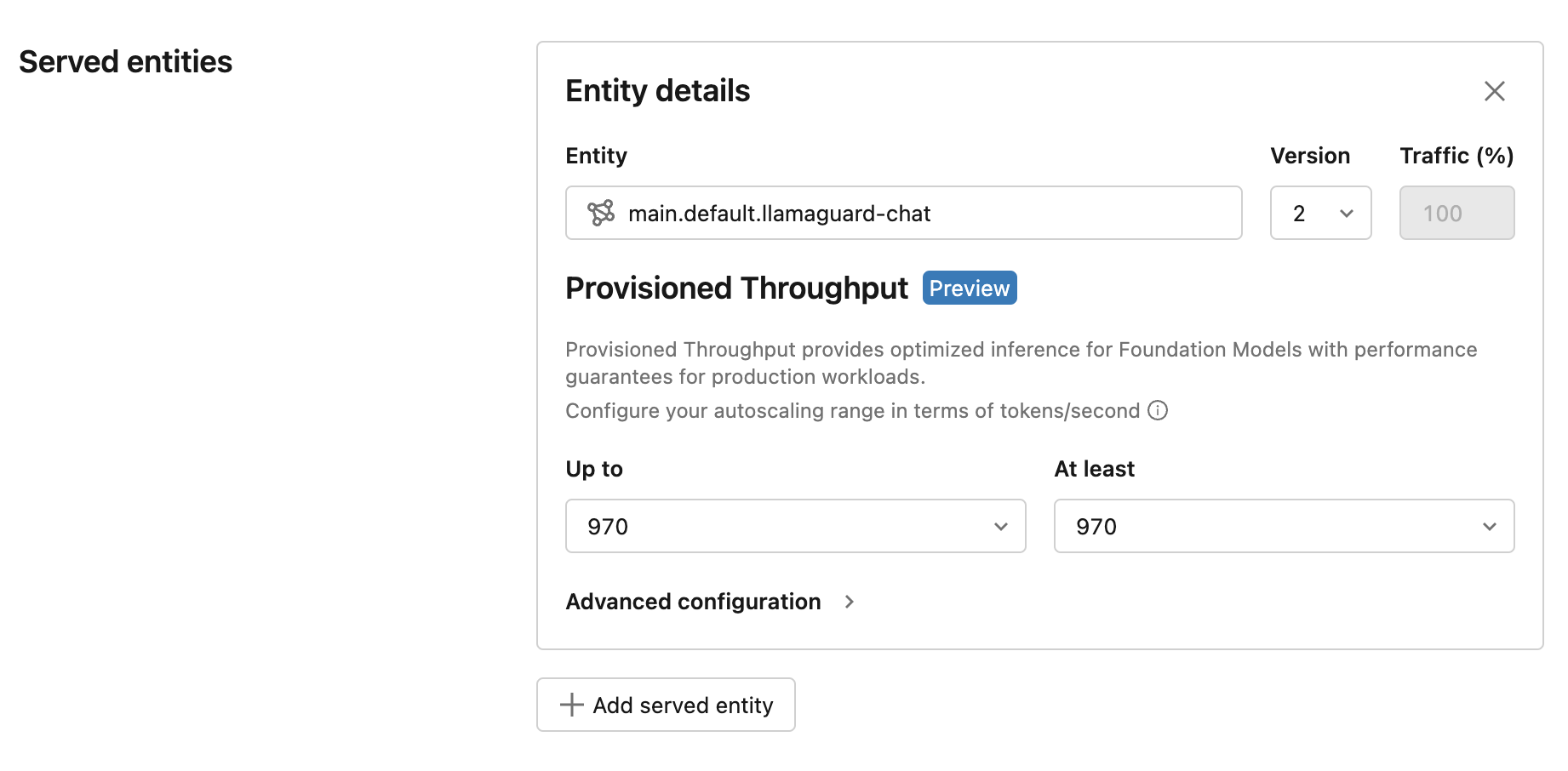

- 스케일 아웃 범위는 동시성 대신 초당 토큰과 같은 LLM 네이티브 용어로 구성할 수 있습니다.

- 고객은 더 이상 GPU 워크로드 유형을 직접 선택할 필요가 없습니다.

엔드포인트를 제공하는 새 LLM은 기본적으로 프로비전된 처리량으로 만들어집니다. GPU 워크로드 유형을 계속 선택하려는 경우 이 환경은 API를 사용하는 경우에만 지원됩니다.

LLM 서비스 엔드포인트를 프로비전된 처리량으로 마이그레이션

기존 엔드포인트를 프로비전된 처리량으로 마이그레이션하는 가장 간단한 방법은 엔드포인트를 새 모델 버전으로 업데이트하는 것입니다. 새 모델 버전을 선택하면 프로비전된 처리량에 대한 환경이 UI에 표시됩니다. UI는 일반적인 사용 사례에 대한 Databricks 벤치마킹을 기반으로 초당 토큰 범위를 표시합니다.

이 업데이트된 제품의 성능은 최적화 개선 및 엔드포인트 가격 변경 없이 다시 기본 때문에 더욱 향상됩니다. 제품 피드백 또는 우려 사항에 model-serving-feedback@databricks.com 문의하세요.