Co to jest zamiana tekstu na mowę?

W tym omówieniu poznasz korzyści i możliwości funkcji zamiany tekstu na mowę w usłudze Mowa, która jest częścią usług Azure AI.

Zamiana tekstu na mowę umożliwia aplikacjom, narzędziom lub urządzeniom konwertowanie tekstu na język ludzki, taki jak syntetyzowana mowa. Funkcja zamiany tekstu na mowę jest również znana jako synteza mowy. Użyj wstępnie utworzonych głosów neuronowych, takich jak człowiek, lub utwórz niestandardowy neuronowy głos, który jest unikatowy dla twojego produktu lub marki. Aby uzyskać pełną listę obsługiwanych głosów, języków i ustawień regionalnych, zobacz Obsługa języka i głosu dla usługi Mowa.

Podstawowe funkcje

Zamiana tekstu na mowę obejmuje następujące funkcje:

| Funkcja | Podsumowanie | Demonstracja |

|---|---|---|

| Wstępnie utworzony neuronowy głos (nazywany neuronowym na stronie cen) | Bardzo naturalne, gotowe do użycia głosy. Utwórz subskrypcję platformy Azure i zasób usługi Mowa, a następnie użyj zestawu SDK usługi Mowa lub odwiedź portal usługi Speech Studio i wybierz wstępnie utworzone głosy neuronowe, aby rozpocząć pracę. Sprawdź szczegóły cennika. | Sprawdź galerię głosów i określ odpowiedni głos dla Twoich potrzeb biznesowych. |

| Niestandardowy neuronowy głos (nazywany niestandardowym neuronem neuronowym na stronie cennika) | Łatwa w użyciu samoobsługa do tworzenia naturalnego głosu marki z ograniczonym dostępem do odpowiedzialnego użycia. Utwórz subskrypcję platformy Azure i zasób usługi Mowa (z warstwą S0) i zastosuj się do korzystania z niestandardowej funkcji głosowej. Po udzieleniu dostępu odwiedź portal usługi Speech Studio i wybierz pozycję Niestandardowy głos , aby rozpocząć pracę. Sprawdź szczegóły cennika. | Sprawdź przykłady głosu. |

Więcej informacji o funkcjach zamiany tekstu neuronowego na mowę

Zamiana tekstu na mowę używa głębokich sieci neuronowych, aby głosy komputerów niemal nie do odróżnienia od nagrań ludzi. Dzięki jasnemu artykulacji słów tekst neuronowy do mowy znacznie zmniejsza zmęczenie nasłuchiwaniem, gdy użytkownicy wchodzą w interakcje z systemami sztucznej inteligencji.

Wzorce stresu i intonacji w języku mówionym są nazywane prosodią. Tradycyjne systemy zamiany tekstu na mowę dzielą prozady na oddzielne kroki analizy językowej i przewidywania akustycznego zarządzane przez niezależne modele. To może spowodować muffled, buzzy syntezy głosu.

Poniżej przedstawiono więcej informacji o funkcjach neuronowych zamian tekstu na mowę w usłudze Mowa oraz o tym, jak przezwyciężyć limity tradycyjnych systemów zamiany tekstu na mowę:

Synteza mowy w czasie rzeczywistym: użyj zestawu SPEECH SDK lub interfejsu API REST, aby przekonwertować tekst na mowę przy użyciu wstępnie utworzonych głosów neuronowych lub niestandardowych głosów neuronowych.

Asynchroniczna synteza długiego dźwięku: użyj interfejsu API syntezy wsadowej do asynchronicznego syntetyzowania tekstu w plikach mowy dłuższych niż 10 minut (na przykład książek audio lub wykładów). W przeciwieństwie do syntezy wykonywanej za pośrednictwem zestawu SPEECH SDK lub interfejsu API REST zamiany mowy na tekst odpowiedzi nie są zwracane w czasie rzeczywistym. Oczekuje się, że żądania są wysyłane asynchronicznie, odpowiedzi są sondowane i syntetyzowany dźwięk jest pobierany, gdy usługa udostępnia je.

Wstępnie utworzone głosy neuronowe: Usługa Azure AI Speech używa głębokich sieci neuronowych do przezwyciężenia limitów tradycyjnej syntezy mowy dotyczącej stresu i intonacji w języku mówionym. Przewidywanie prosody i synteza głosu odbywają się jednocześnie, co skutkuje bardziej płynnymi i naturalnie brzmiącymi wyjściami. Każdy wstępnie utworzony model neuronowego głosu jest dostępny przy 24 kHz i wysokiej wierności 48 kHz. Możesz użyć neuronowych głosów do:

- Sprawić, aby interakcje z czatbotami i asystentami głosowymi bardziej naturalne i angażujące.

- Konwertowanie tekstów cyfrowych, takich jak książki elektroniczne, na audiobooki.

- Ulepszanie systemów nawigacji w samochodzie.

Aby uzyskać pełną listę neuronowych głosów platformy, zobacz Obsługa języka i głosu dla usługi Mowa.

Ulepszanie tekstu w danych wyjściowych mowy za pomocą języka SSML: Język znaczników syntezy mowy (SSML) to język znaczników oparty na języku XML używany do dostosowywania tekstu do danych wyjściowych mowy. Za pomocą języka SSML można dostosować ton, dodać przerwy, poprawić wymowę, zmienić częstotliwość mówienia, dostosować głośność i przypisywać wiele głosów do pojedynczego dokumentu.

Możesz użyć języka SSML, aby zdefiniować własne leksykony lub przełączyć się na różne style mówienia. Dzięki wielojęzycznym głosom możesz również dostosować języki mówiące za pomocą języka SSML. Aby poprawić dane wyjściowe głosu dla danego scenariusza, zobacz Ulepszanie syntezy za pomocą języka znaczników syntezy mowy i syntezy mowy za pomocą narzędzia do tworzenia zawartości audio.

Visemes: Visemes są kluczowymi pozycjami w obserwowanej mowie, w tym położenie ust, szczęki i języka w produkcji konkretnej fonemy. Visemes mają silną korelację z głosami i fonezami.

Używając zdarzeń viseme w zestawie SPEECH SDK, można wygenerować dane animacji twarzy. Te dane mogą służyć do animowania twarzy w komunikacji z czytaniem ust, edukacji, rozrywki i obsługi klienta. Viseme jest obecnie obsługiwany tylko w przypadku

en-USneuronowych głosów (angielski usa).

Uwaga

Planujemy wycofanie tradycyjnych/standardowych głosów i nienadobowego niestandardowego głosu w 2024 roku. Następnie nie będziemy już ich obsługiwać.

Jeśli aplikacje, narzędzia lub produkty korzystają z dowolnego ze standardowych głosów i niestandardowych głosów, musisz przeprowadzić migrację do wersji neuronowej. Aby uzyskać więcej informacji, zobacz Migrowanie do głosów neuronowych.

Rozpocznij

Aby rozpocząć pracę z zamianą tekstu na mowę , zobacz przewodnik Szybki start. Zamiana tekstu na mowę jest dostępna za pośrednictwem zestawu SPEECH SDK, interfejsu API REST i interfejsu wiersza polecenia usługi Mowa.

Napiwek

Aby przekonwertować tekst na mowę przy użyciu podejścia bez kodu, wypróbuj narzędzie do tworzenia zawartości audio w programie Speech Studio.

Przykładowy kod

Przykładowy kod zamiany tekstu na mowę jest dostępny w witrynie GitHub. Te przykłady obejmują konwersję tekstu na mowę w najpopularniejszych językach programowania:

Niestandardowy neuronowy głos

Oprócz wstępnie utworzonych głosów neuronowych można tworzyć niestandardowe neuronowe głosy, które są unikatowe dla twojego produktu lub marki. Wszystko, co trzeba rozpocząć, to kilka plików audio i skojarzonych transkrypcji. Aby uzyskać więcej informacji, zobacz Wprowadzenie do niestandardowego neuronowego głosu.

Nota cenowa

Rozliczane znaki

Gdy używasz funkcji zamiany tekstu na mowę, opłaty są naliczane za każdy znak przekonwertowany na mowę, w tym interpunkcję. Mimo że sam dokument SSML nie jest rozliczany, opcjonalne elementy używane do dostosowywania sposobu konwersji tekstu na mowę, takie jak phonemy i skoki, są liczone jako rozliczane znaki. Oto lista elementów rozliczanych:

- Tekst przekazany do funkcji zamiany tekstu na mowę w treści żądania SSML

- Wszystkie znaczniki w polu tekstowym treści żądania w formacie SSML, z wyjątkiem

<speak>tagów i<voice> - Litery, znaki interpunkcyjne, spacje, karty, znaczniki i wszystkie znaki odstępu

- Każdy punkt kodu zdefiniowany w standardze Unicode

Aby uzyskać szczegółowe informacje, zobacz Cennik usługi Mowa.

Ważne

Każdy chiński znak jest liowany jako dwa znaki do rozliczeń, w tym kanji używany w języku japońskim, hanja używany w języku koreańskim lub hanzi używany w innych językach.

Trenowanie modelu i czas hostingu dla niestandardowego neuronowego głosu

Niestandardowe trenowanie i hostowanie neuronowego głosu są obliczane według godzin i rozliczane na sekundę. Aby uzyskać cenę jednostkową rozliczeń, zobacz Cennik usługi Mowa.

Niestandardowy czas trenowania neuronowego głosu (CNV) jest mierzony przez "godzinę obliczeniową" (jednostkę do mierzenia czasu pracy maszyny). Zazwyczaj podczas trenowania modelu głosowego dwa zadania obliczeniowe są uruchamiane równolegle. W związku z tym obliczone godziny obliczeniowe są dłuższe niż rzeczywisty czas trenowania. Średnio trenowanie głosu CNV Lite trwa mniej niż jedną godzinę obliczeniową; podczas gdy w przypadku CNV Pro, trenowanie głosu w jednym stylu trwa zwykle od 20 do 40 godzin obliczeniowych, a około 90 godzin obliczeniowych w celu trenowania głosu w wielu stylach. Czas trenowania CNV jest rozliczany z limitem 96 godzin obliczeniowych. W takim przypadku, gdy model głosowy jest trenowany w ciągu 98 godzin obliczeniowych, opłaty będą naliczane tylko za 96 godzin obliczeniowych.

Niestandardowy hostowanie punktów końcowych neuronowego głosu (CNV) jest mierzone przez rzeczywisty czas (godzina). Czas hostingu (godziny) dla każdego punktu końcowego jest obliczany o 00:00 UTC każdego dnia przez poprzednie 24 godziny. Jeśli na przykład punkt końcowy był aktywny przez 24 godziny pierwszego dnia, opłata jest naliczana za 24 godziny o 00:00 UTC w drugim dniu. Jeśli punkt końcowy jest nowo utworzony lub zawieszony w ciągu dnia, opłaty są naliczane za skumulowany czas działania do 00:00 UTC drugiego dnia. Jeśli punkt końcowy nie jest obecnie hostowany, nie jest rozliczany. Oprócz obliczenia dziennego o godzinie 00:00 UTC każdego dnia rozliczenia są również wyzwalane natychmiast po usunięciu lub zawieszeniu punktu końcowego. Na przykład w przypadku punktu końcowego utworzonego o godzinie 08:00 UTC 1 grudnia godzina hostingu zostanie obliczona na 16 godzin o 00:00 UTC 2 grudnia i 24 godziny o 00:00 UTC 3 grudnia. Jeśli użytkownik zawiesi hostowanie punktu końcowego o godzinie 16:30 UTC 3 grudnia, czas trwania (16,5 godziny) od 00:00 do 16:30 UTC 3 grudnia zostanie obliczony na potrzeby rozliczeń.

Osobisty głos

W przypadku korzystania z funkcji głosu osobistego opłaty są naliczane zarówno za przechowywanie profilu, jak i syntezę.

- Magazyn profilu: po utworzeniu osobistego profilu głosowego będzie on rozliczany do momentu jego usunięcia z systemu. Jednostka rozliczeniowa jest na głos dziennie. Jeśli magazyn głosowy trwa krócej niż 24 godziny, będzie rozliczany jako jeden pełny dzień.

- Synteza: Rozliczane na postać. Aby uzyskać szczegółowe informacje na temat znaków podlegających rozliczaniu, zobacz powyższe rozliczane znaki.

Awatar zamiany tekstu na mowę

W przypadku korzystania z funkcji awatara zamiany tekstu na mowę opłaty będą naliczane na podstawie długości danych wyjściowych wideo i będą naliczane na sekundę. Jednak w przypadku awatara w czasie rzeczywistym opłaty są oparte na czasie, gdy awatar jest aktywny, niezależnie od tego, czy mówi, czy pozostaje cichy, a także będą rozliczane na sekundę. Aby zoptymalizować koszty użycia awatara w czasie rzeczywistym, zapoznaj się z poradami podanymi w przykładowym kodzie (wyszukaj frazę "Użyj lokalnego wideo dla bezczynności"). Hosting awatara jest rozliczany na sekundę na punkt końcowy. Możesz zawiesić punkt końcowy, aby zaoszczędzić koszty. Jeśli chcesz zawiesić punkt końcowy, możesz usunąć go bezpośrednio. Aby użyć go ponownie, po prostu ponownie wdróż punkt końcowy.

Monitorowanie metryk zamiany tekstu na mowę na platformę Azure

Monitorowanie kluczowych metryk skojarzonych z tekstem w usługach mowy ma kluczowe znaczenie dla zarządzania użyciem zasobów i kontrolowaniem kosztów. W tej sekcji opisano, jak znaleźć informacje o użyciu w witrynie Azure Portal i podać szczegółowe definicje kluczowych metryk. Aby uzyskać więcej informacji na temat metryk usługi Azure Monitor, zobacz Omówienie metryk usługi Azure Monitor.

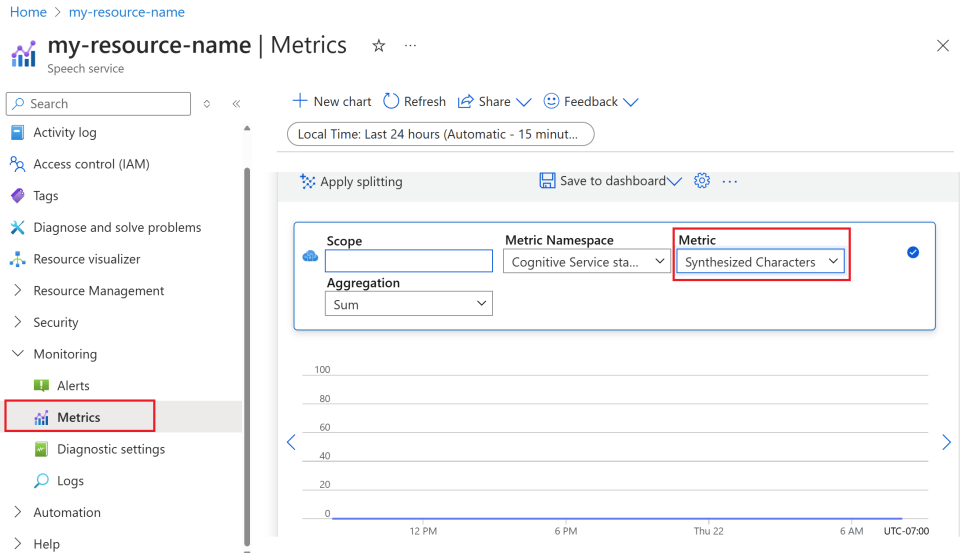

Jak znaleźć informacje o użyciu w witrynie Azure Portal

Aby efektywnie zarządzać zasobami platformy Azure, ważne jest regularne uzyskiwanie dostępu do informacji o użyciu i ich przeglądanie. Poniżej przedstawiono sposób znajdowania informacji o użyciu:

Przejdź do witryny Azure Portal i zaloguj się przy użyciu konta platformy Azure.

Przejdź do obszaru Zasoby i wybierz zasób, który chcesz monitorować.

Wybierz pozycję Metryki w obszarze Monitorowanie z menu po lewej stronie.

Dostosowywanie widoków metryk.

Dane można filtrować według typu zasobu, typu metryki, zakresu czasu i innych parametrów, aby tworzyć widoki niestandardowe zgodne z potrzebami monitorowania. Ponadto możesz zapisać widok metryki na pulpitach nawigacyjnych, wybierając pozycję Zapisz na pulpicie nawigacyjnym , aby ułatwić dostęp do często używanych metryk.

Konfigurowanie alertów.

Aby efektywniej zarządzać użyciem, skonfiguruj alerty, przechodząc do karty Alerty w obszarze Monitorowanie z menu po lewej stronie. Alerty mogą powiadamiać o osiągnięciu określonych progów użycia, co pomaga zapobiec nieoczekiwanym kosztom.

Definicja metryk

Poniżej znajduje się tabela podsumowująca kluczowe metryki dla usług zamiany tekstu na mowę platformy Azure.

| Nazwa metryki | Opis |

|---|---|

| Znaki syntetyzowane | Śledzi liczbę znaków przekonwertowanych na mowę, w tym wstępnie utworzony głos neuronowy i niestandardowy głos neuronowy. Aby uzyskać szczegółowe informacje o rozliczanych znakach, zobacz Billable characters (Znaki rozliczane). |

| Syntetyzowane sekundy wideo | Mierzy całkowity czas trwania syntezy wideo, w tym syntezę awatara wsadowego, syntezę awatara w czasie rzeczywistym i niestandardową syntezę awatara. |

| Model awatara hostuje sekundy | Śledzi łączny czas w sekundach hostowanych przez niestandardowy model awatara. |

| Godziny hostingu modelu głosowego | Śledzi łączny czas w godzinach hostowanych przez niestandardowy model neuronowego głosu. |

| Minuty trenowania modelu głosowego | Mierzy łączny czas w minutach trenowania niestandardowego neuronowego modelu głosu. |

Dokumenty referencyjne

Odpowiedzialne AI

System sztucznej inteligencji obejmuje nie tylko technologię, ale także osoby, które go używają, osoby, których to dotyczy, oraz środowisko, w którym jest wdrażane. Zapoznaj się z uwagami dotyczącymi przejrzystości, aby dowiedzieć się więcej na temat odpowiedzialnego używania sztucznej inteligencji i wdrażania w systemach.

- Uwaga dotycząca przezroczystości i przypadki użycia niestandardowego neuronowego głosu

- Cechy i ograniczenia dotyczące używania niestandardowego neuronowego głosu

- Ograniczony dostęp do niestandardowego neuronowego głosu

- Wytyczne dotyczące odpowiedzialnego wdrażania syntetycznej technologii głosowej

- Ujawnianie talentów głosowych

- Wytyczne dotyczące projektowania ujawniania informacji

- Wzorce projektowe ujawniania

- Kodeks postępowania dotyczącego integracji zamiany tekstu na mowę

- Dane, prywatność i zabezpieczenia niestandardowego neuronowego głosu