Modelo de leitura da Informação de Documentos

Importante

- As versões preliminares públicas da Informação de Documentos oferecem acesso antecipado a recursos que estão em desenvolvimento ativo. Recursos, abordagens e processos podem ser alterados, antes da Disponibilidade Geral (GA), com base nos comentários do usuário.

- A versão de visualização pública das bibliotecas de clientes da Informação de Documentos usa como padrão a versão da API REST 2024-07-31-preview.

- Atualmente, a versão de visualização pública 2024-07-31-preview só está disponível nas regiões do Azure a seguir. Observe que o modelo generativo personalizado (extração de campos do documento) no Estúdio de IA está disponível somente na região Centro-Norte dos EUA:

- Leste dos EUA

- Oeste dos EUA 2

- Oeste da Europa

- Centro-Norte dos EUA

Este conteúdo se aplica a:![]() v4.0 (versão prévia) | Versões anteriores:

v4.0 (versão prévia) | Versões anteriores:![]() v3.1 (GA)

v3.1 (GA)![]() v3.0 (GA)

v3.0 (GA)

Este conteúdo se aplica a:![]() v4.0 (versão prévia) | Versões anteriores:

v4.0 (versão prévia) | Versões anteriores:![]() v3.1 (GA)

v3.1 (GA)![]() v3.0 (GA)

v3.0 (GA)

Observação

Para extrair um texto de imagens externas, como rótulos, placas de rua e cartazes, use o recurso Leitura da Análise de Imagem de IA do Azure v4.0 otimizado para imagens gerais não documentais com uma API síncrona aprimorada pelo desempenho que facilita a inserção do OCR em seus cenários de experiência do usuário.

O modelo OCR (Reconhecimento óptico de caracteres) de leitura da Informação de Documentos é executado em uma resolução mais alta do que a Pesquisa Visual da IA do Azure ; lê e extrai texto impresso e manuscrito de documentos PDF e imagens digitalizadas. Ele também inclui suporte para extrair texto de documentos do Microsoft Word, do Excel, do PowerPoint e de HTML. Ele detecta parágrafos, linhas de texto, palavras, locais e idiomas. O Modelo de Leitura é o mecanismo de OCR subjacente para outros modelos predefinidos da Informação de Documentos, como Layout, Documento Geral, Fatura, Recibo, Identidade (ID), cartão de seguro saúde, W2 além de modelos personalizados.

O que é o reconhecimento óptico de caracteres?

O OCR (Reconhecimento Óptico de Caracteres) para documentos é otimizado para documentos grandes com uso intenso de texto em vários formatos de arquivo e idiomas globais. Ele inclui recursos como verificação de maior resolução de imagens de documento para melhor manipulação de texto menor e denso; detecção de parágrafo e gerenciamento de formulário preenchível. Os recursos de OCR também incluem cenários avançados, como caixas de caracteres únicos e extração precisa de campos-chave comumente encontrados em faturas, recibos e outros cenários predefinidos.

Opções de desenvolvimento (v4)

A Informação de Documentos v4.0 (2024-07-31-preview) dá suporte às seguintes ferramentas, aplicativos e bibliotecas:

| Recurso | Recursos | ID do Modelo |

|---|---|---|

| Ler o modelo OCR | • Estúdio de Informação de Documentos • API REST • SDK do C# • SDK do Python • SDK do Java • SDK do JavaScript |

prebuilt-read |

Requisitos de entrada (v4)

Formatos de arquivo com suporte:

Modelar PDF Image,: JPEG/JPG,PNG,BMP,TIFF,HEIFMicrosoft Office:

Word (DOCX), Excel (XLSX), PowerPoint (PPTX), HTMLLer ✔ ✔ ✔ Layout ✔ ✔ ✔ (2024-07-31-preview, 2024-02-29-preview, 2023-10-31-preview) Documento geral ✔ ✔ Predefinida ✔ ✔ Extração personalizada ✔ ✔ Classificação personalizada ✔ ✔ ✔ (2024-07-31-preview, 2024-02-29-preview) Para ter melhores resultados, forneça uma foto clara ou uma digitalização de alta qualidade por documento.

Para PDF e TIFF, até 2.000 páginas podem ser processadas (com uma assinatura de camada gratuita, apenas as duas primeiras páginas são processadas).

O tamanho do arquivo para análise de documentos é de 500 MB para a camada paga (S0) e

4MB para a camada gratuita (F0).As dimensões da imagem devem estar entre 50 x 50 pixels e 10.000 x 10.000 pixels.

Se os PDFs estiverem com bloqueio de senha, você deverá remover o bloqueio antes do envio.

A altura mínima do texto a ser extraído é de 12 pixels para uma imagem de 1.024 x 768 pixels. Essa dimensão corresponde a aproximadamente

8pontos de texto a 150 pontos por polegada (DPI).Para treinamento de modelo personalizado, o número máximo de páginas para dados de treinamento é 500 para o modelo de modelo personalizado e 50.000 para o modelo neural personalizado.

Para o treinamento do modelo de extração personalizado, o tamanho total dos dados de treinamento é de 50 MB para o modelo de modelo e

1GB para o modelo neural.Para o treinamento de modelo de classificação personalizado, o tamanho total dos dados de treinamento é de

1GB, com um máximo de 10.000 páginas. Para a versão 2024-07-31-preview e posteriores, o tamanho total dos dados de treinamento é de2GB, com um máximo de 10.000 páginas.

Introdução ao modelo de leitura (v4)

Tente extrair dados de formulários e documentos pelo Estúdio da Informação de Documentos. Você precisará dos seguintes ativos:

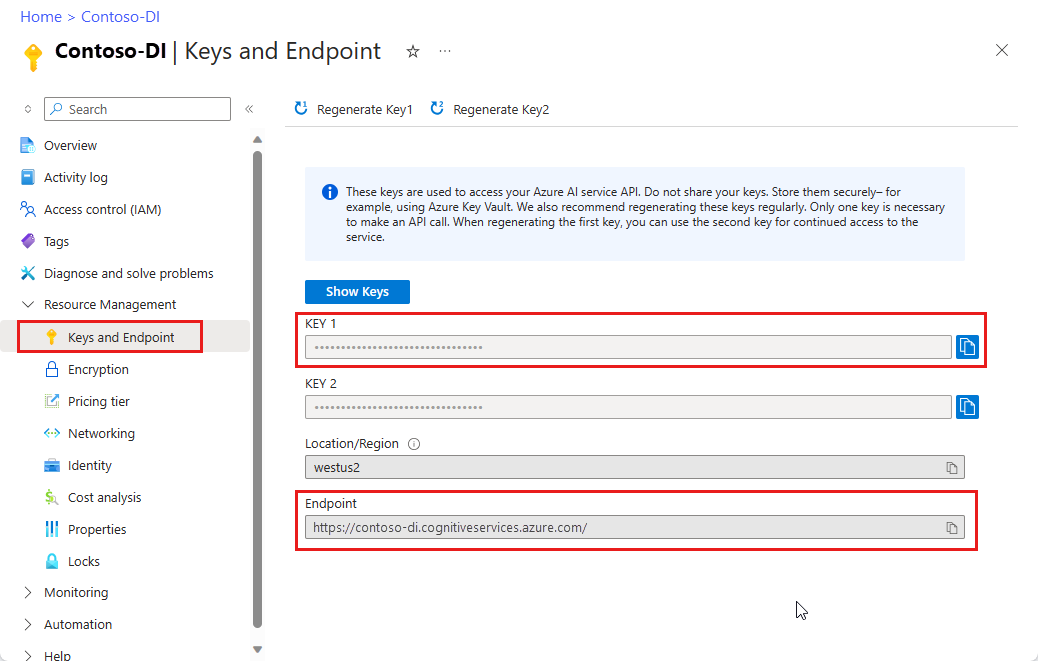

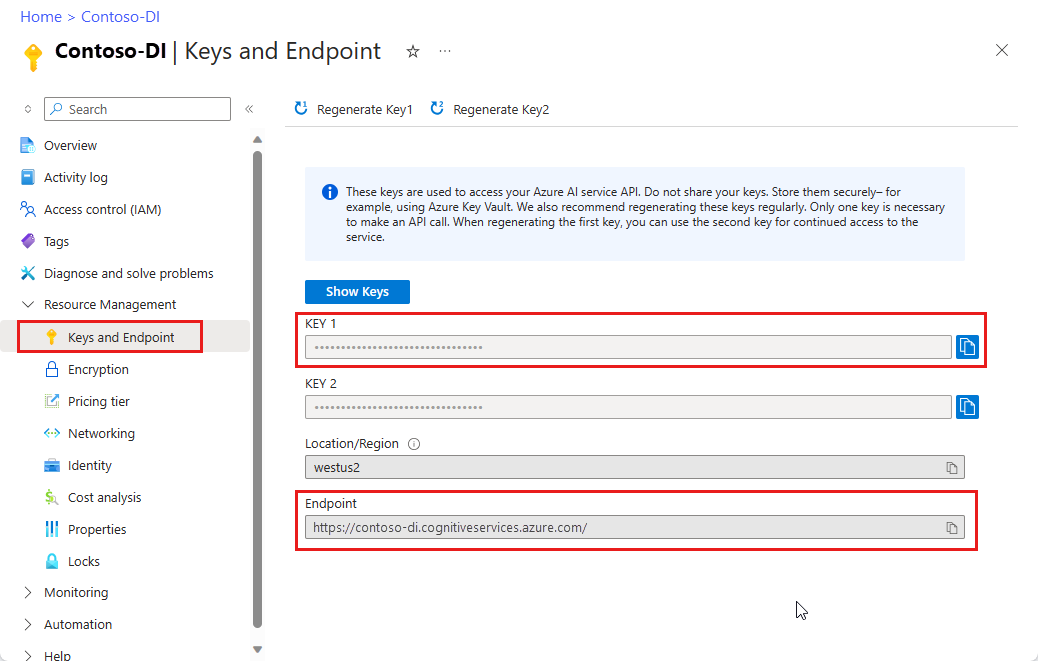

Uma assinatura do Azure: você pode criar uma gratuitamente.

Uma instância da Informação de Documentos no portal do Azure. Você pode usar o tipo de preço gratuito (

F0) para experimentar o serviço. Depois que o recurso for implantado, selecione Ir para o recurso para obter a chave e o ponto de extremidade.

Observação

Atualmente, o Estúdio da Informação de Documentos não dá suporte aos formatos de arquivo Microsoft Word, Excel, PowerPoint e HTML.

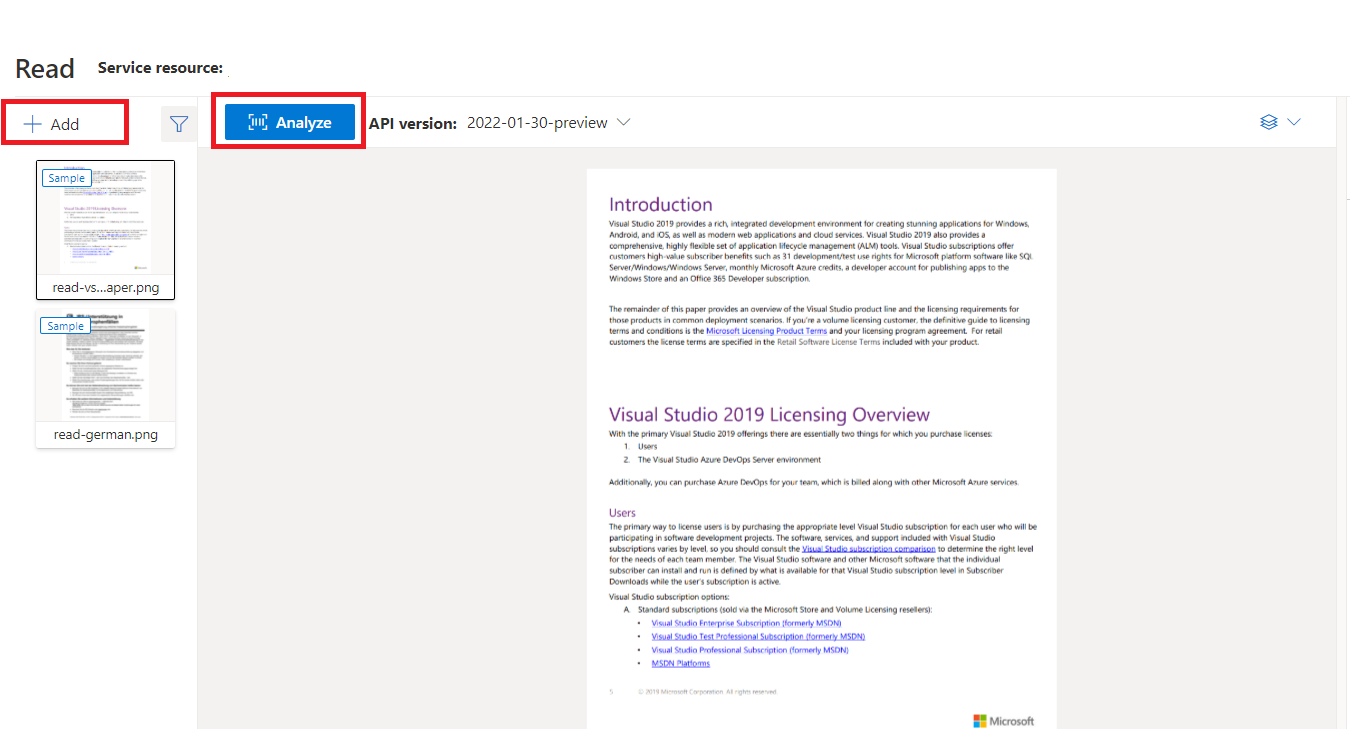

Documento de exemplo processado com o Estúdio da Informação de Documentos

Na página inicial do Estúdio da Informação de Documentos, selecione Ler.

Você pode analisar o documento de amostra ou carregar seus próprios arquivos.

Selecione o botão Executar análise e, se necessário, configure as opções Analisar :

Idiomas e localidades com suporte (v4)

Confira a página Suporte a Idiomas: modelos de análise de documentos, para obter uma lista completa dos idiomas com suporte.

Extração de dados (v4)

Observação

O Microsoft Word e o arquivo HTML são compatíveis com a v4.0. Em comparação aos PDF e imagens, não há suporte para os recursos abaixo:

- Não há ângulos, largura/altura e a unidade com cada objeto de página.

- Para cada objeto detectado, não há polígono nem região com limites.

- Não há suporte para o intervalo de páginas (

pages) como parâmetro. - Nenhum objeto

lines.

PDFs pesquisáveis

A funcionalidade do PDF pesquisável permite que você converta um PDF analógico, como arquivos PDF de imagem digitalizada, em um PDF com texto inserido. O texto inserido habilita a pesquisa de texto profundo no conteúdo extraído do PDF sobrepondo as entidades de texto detectadas sobre os arquivos de imagem.

Importante

- Atualmente, a funcionalidade do PDF pesquisável só tem suporte pelo modelo OCR de Leitura

prebuilt-read. Ao usar esse recurso, especifique omodelIdcomoprebuilt-read, pois outros tipos de modelo retornarão o erro para essa versão de visualização. - O PDF pesquisável está incluído no modelo

prebuilt-read2024-07-31-preview sem custos adicionais para gerar uma saída em PDF pesquisável.- Atualmente, o PDF pesquisável só oferece suporte a arquivos PDF como entrada. No futuro, haverá suporte para outros tipos de arquivos, como arquivos de imagem.

Usar PDFs pesquisáveis

Para usar o PDF pesquisável, faça uma solicitação POST usando a operação Analyze e especifique o formato de saída como pdf:

POST /documentModels/prebuilt-read:analyze?output=pdf

{...}

202

Verifique a conclusão da operação Analyze. Depois que a operação terminar, emita uma solicitação GET para recuperar o formato PDF dos resultados da operação Analyze.

Após a conclusão bem-sucedida, o PDF pode ser recuperado e baixado como application/pdf. Essa operação permite o download direto do formulário de texto inserido do PDF em vez de do JSON codificado em Base64.

// Monitor the operation until completion.

GET /documentModels/prebuilt-read/analyzeResults/{resultId}

200

{...}

// Upon successful completion, retrieve the PDF as application/pdf.

GET /documentModels/prebuilt-read/analyzeResults/{resultId}/pdf

200 OK

Content-Type: application/pdf

Parâmetro Pages

A coleção de páginas é uma lista de páginas dentro do documento. Cada página é representada sequencialmente dentro do documento e inclui o ângulo de orientação que indica se a página foi girada, além de largura e altura (dimensões em pixels). As unidades de página na saída do modelo são computadas conforme mostrado:

| Formato de arquivo | Unidade de página computada | Total de páginas |

|---|---|---|

| Imagens (JPEG/JPG, PNG, BMP, HEIF) | Cada imagem = 1 unidade de página | Total de imagens |

| Cada página no PDF = 1 unidade de página | Total de páginas no PDF | |

| TIFF | Cada imagem no TIFF = 1 unidade de página | Total de imagens no TIFF |

| Word (DOCX) | Até 3.000 caracteres = 1 unidade de página, imagens inseridas ou vinculadas sem suporte | Total de páginas de até 3.000 caracteres cada |

| Excel (XLSX) | Cada planilha = 1 unidade de página, imagens inseridas ou vinculadas sem suporte | Total de planilhas |

| PowerPoint (PPTX) | Cada slide = 1 unidade de página, imagens inseridas ou vinculadas sem suporte | Total de slides |

| HTML | Até 3.000 caracteres = 1 unidade de página, imagens inseridas ou vinculadas sem suporte | Total de páginas de até 3.000 caracteres cada |

# Analyze pages.

for page in result.pages:

print(f"----Analyzing document from page #{page.page_number}----")

print(f"Page has width: {page.width} and height: {page.height}, measured with unit: {page.unit}")

Usar páginas para extração de texto

Para grandes documentos PDF com várias páginas, use o parâmetro de consulta pages para indicar números de página ou intervalos de página específicos para a extração de texto.

Extração de parágrafo

O modelo do OCR de Leitura na Informação de Documentos extrai todos os blocos de texto identificados na coleção paragraphs como um objeto de nível superior sob analyzeResults. Cada entrada dessa coleção representa um bloco de texto e inclui o texto extraído como content e as coordenadas polygon de limitação. As informações de span apontam para o fragmento de texto dentro da propriedade content de nível superior que contém o texto completo do documento.

"paragraphs": [

{

"spans": [],

"boundingRegions": [],

"content": "While healthcare is still in the early stages of its Al journey, we are seeing pharmaceutical and other life sciences organizations making major investments in Al and related technologies.\" TOM LAWRY | National Director for Al, Health and Life Sciences | Microsoft"

}

]

Extração de texto, linhas e palavras

O modelo do OCR de Leitura extrai textos de estilo impresso e manuscritos como lines e words. O modelo gera coordenadas delimitadoras polygon e confidence para as palavras extraídas. A coleção styles inclui qualquer estilo manuscrito para linhas (se detectado), juntamente com os intervalos apontando para o texto associado. Esse recurso se aplica a linguagens manuscritas com suporte.

Para o Microsoft Word, Excel, PowerPoint e HTML, o modelo de Leitura de informação de documentos v3.1 e versões posteriores extrai todo o texto inserido como está. Textos são extraídos como palavras e parágrafos. Não há suporte para imagens incorporadas.

# Analyze lines.

if page.lines:

for line_idx, line in enumerate(page.lines):

words = get_words(page, line)

print(

f"...Line # {line_idx} has {len(words)} words and text '{line.content}' within bounding polygon '{line.polygon}'"

)

# Analyze words.

for word in words:

print(f"......Word '{word.content}' has a confidence of {word.confidence}")

Extração de estilo manuscrito

A resposta inclui classificar se cada linha de texto tem um estilo manuscrito ou não, junto com uma pontuação de confiança. Para obter mais informações, confira o suporte ao idioma escrito à mão. O exemplo a seguir mostra um snippet JSON de exemplo.

"styles": [

{

"confidence": 0.95,

"spans": [

{

"offset": 509,

"length": 24

}

"isHandwritten": true

]

}

Se você habilitou a funcionalidade de complemento de fonte/estilo, também obterá o resultado de fonte/estilo como parte do objeto styles.

Próximas etapas v4.0

Conclua um início rápido da Informação de Documentos:

Explore nossa API REST:

Confira mais exemplos no GitHub:

Este conteúdo se aplica a: ![]() v3.1 (GA) | Última versão:

v3.1 (GA) | Última versão: ![]() v4.0 (versão prévia) | Versões anteriores:

v4.0 (versão prévia) | Versões anteriores: ![]() v3.0

v3.0

Este conteúdo se aplica a: ![]() v3.0 (GA) | Últimas versões:

v3.0 (GA) | Últimas versões: ![]() v4.0 (versão prévia)

v4.0 (versão prévia) ![]() v3.1

v3.1

Observação

Para extrair um texto de imagens externas, como rótulos, placas de rua e cartazes, use o recurso Leitura da Análise de Imagem de IA do Azure v4.0 otimizado para imagens gerais não documentais com uma API síncrona aprimorada pelo desempenho que facilita a inserção do OCR em seus cenários de experiência do usuário.

O modelo OCR (Reconhecimento óptico de caracteres) de leitura da Informação de Documentos é executado em uma resolução mais alta do que a Pesquisa Visual da IA do Azure ; lê e extrai texto impresso e manuscrito de documentos PDF e imagens digitalizadas. Ele também inclui suporte para extrair texto de documentos do Microsoft Word, do Excel, do PowerPoint e de HTML. Ele detecta parágrafos, linhas de texto, palavras, locais e idiomas. O Modelo de Leitura é o mecanismo de OCR subjacente para outros modelos predefinidos da Informação de Documentos, como Layout, Documento Geral, Fatura, Recibo, Identidade (ID), cartão de seguro saúde, W2 além de modelos personalizados.

O que é o OCR para documentos?

O OCR (Reconhecimento Óptico de Caracteres) para documentos é otimizado para documentos grandes com uso intenso de texto em vários formatos de arquivo e idiomas globais. Ele inclui recursos como verificação de maior resolução de imagens de documento para melhor manipulação de texto menor e denso; detecção de parágrafo e gerenciamento de formulário preenchível. Os recursos de OCR também incluem cenários avançados, como caixas de caracteres únicos e extração precisa de campos-chave comumente encontrados em faturas, recibos e outros cenários predefinidos.

Opções de desenvolvimento

A Informação de Documentos v3.1 dá suporte às seguintes ferramentas, aplicativos e bibliotecas:

| Recurso | Recursos | ID do Modelo |

|---|---|---|

| Ler o modelo OCR | • Estúdio de Informação de Documentos • API REST • SDK do C# • SDK do Python • SDK do Java • SDK do JavaScript |

prebuilt-read |

A Informação de Documentos v3.0 dá suporte às seguintes ferramentas, aplicativos e bibliotecas:

| Recurso | Recursos | ID do Modelo |

|---|---|---|

| Ler o modelo OCR | • Estúdio de Informação de Documentos • API REST • SDK do C# • SDK do Python • SDK do Java • SDK do JavaScript |

prebuilt-read |

Requisitos de entrada

Formatos de arquivo com suporte:

Modelar PDF Image,: JPEG/JPG,PNG,BMP,TIFF,HEIFMicrosoft Office:

Word (DOCX), Excel (XLSX), PowerPoint (PPTX), HTMLLer ✔ ✔ ✔ Layout ✔ ✔ ✔ (2024-07-31-preview, 2024-02-29-preview, 2023-10-31-preview) Documento geral ✔ ✔ Predefinida ✔ ✔ Extração personalizada ✔ ✔ Classificação personalizada ✔ ✔ ✔ (2024-07-31-preview, 2024-02-29-preview) Para ter melhores resultados, forneça uma foto clara ou uma digitalização de alta qualidade por documento.

Para PDF e TIFF, até 2.000 páginas podem ser processadas (com uma assinatura de camada gratuita, apenas as duas primeiras páginas são processadas).

O tamanho do arquivo para análise de documentos é de 500 MB para a camada paga (S0) e

4MB para a camada gratuita (F0).As dimensões da imagem devem estar entre 50 x 50 pixels e 10.000 x 10.000 pixels.

Se os PDFs estiverem com bloqueio de senha, você deverá remover o bloqueio antes do envio.

A altura mínima do texto a ser extraído é de 12 pixels para uma imagem de 1.024 x 768 pixels. Essa dimensão corresponde a aproximadamente

8pontos de texto a 150 pontos por polegada (DPI).Para treinamento de modelo personalizado, o número máximo de páginas para dados de treinamento é 500 para o modelo de modelo personalizado e 50.000 para o modelo neural personalizado.

Para o treinamento do modelo de extração personalizado, o tamanho total dos dados de treinamento é de 50 MB para o modelo de modelo e

1GB para o modelo neural.Para o treinamento de modelo de classificação personalizado, o tamanho total dos dados de treinamento é de

1GB, com um máximo de 10.000 páginas. Para a versão 2024-07-31-preview e posteriores, o tamanho total dos dados de treinamento é de2GB, com um máximo de 10.000 páginas.

Introdução ao modelo de leitura

Tente extrair dados de formulários e documentos pelo Estúdio da Informação de Documentos. Você precisará dos seguintes ativos:

Uma assinatura do Azure: você pode criar uma gratuitamente.

Uma instância da Informação de Documentos no portal do Azure. Você pode usar o tipo de preço gratuito (

F0) para experimentar o serviço. Depois que o recurso for implantado, selecione Ir para o recurso para obter a chave e o ponto de extremidade.

Observação

Atualmente, o Estúdio da Informação de Documentos não dá suporte aos formatos de arquivo Microsoft Word, Excel, PowerPoint e HTML.

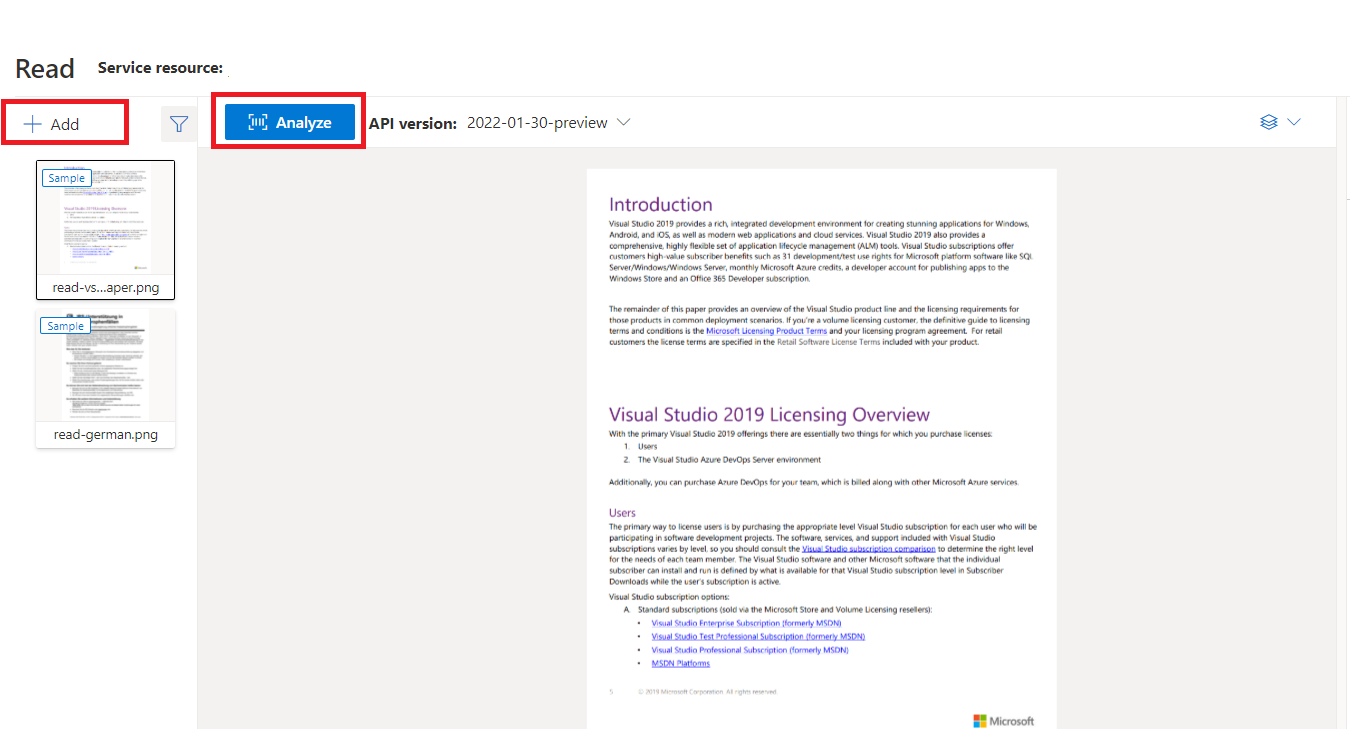

Documento de exemplo processado com o Estúdio da Informação de Documentos

Na página inicial do Estúdio da Informação de Documentos, selecione Ler.

Você pode analisar o documento de amostra ou carregar seus próprios arquivos.

Selecione o botão Executar análise e, se necessário, configure as opções Analisar :

Idiomas e localidades com suporte

Confira a página Suporte a Idiomas: modelos de análise de documentos, para obter uma lista completa dos idiomas com suporte.

Extração de dados

Observação

O Microsoft Word e o arquivo HTML têm suporte em versões v3.1 e posteriores. Em comparação aos PDF e imagens, não há suporte para os recursos abaixo:

- Não há ângulos, largura/altura e a unidade com cada objeto de página.

- Para cada objeto detectado, não há polígono nem região com limites.

- Não há suporte para o intervalo de páginas (

pages) como parâmetro. - Nenhum objeto

lines.

PDF Pesquisável

A funcionalidade do PDF pesquisável permite que você converta um PDF analógico, como arquivos PDF de imagem digitalizada, em um PDF com texto inserido. O texto inserido habilita a pesquisa de texto profundo no conteúdo extraído do PDF sobrepondo as entidades de texto detectadas sobre os arquivos de imagem.

Importante

- Atualmente, a funcionalidade do PDF pesquisável só tem suporte pelo modelo OCR de Leitura

prebuilt-read. Ao usar esse recurso, especifique omodelIdcomoprebuilt-read, pois outros tipos de modelo retornarão o erro para essa versão de visualização. - O PDF pesquisável está incluído no modelo

prebuilt-read2024-07-31-preview sem custos adicionais para gerar uma saída em PDF pesquisável.- Atualmente, o PDF pesquisável só oferece suporte a arquivos PDF como entrada. No futuro, haverá suporte para outros tipos de arquivos, como arquivos de imagem.

Usar o PDF pesquisável

Para usar o PDF pesquisável, faça uma solicitação POST usando a operação Analyze e especifique o formato de saída como pdf:

POST /documentModels/prebuilt-read:analyze?output=pdf

{...}

202

Verifique a conclusão da operação Analyze. Depois que a operação terminar, emita uma solicitação GET para recuperar o formato PDF dos resultados da operação Analyze.

Após a conclusão bem-sucedida, o PDF pode ser recuperado e baixado como application/pdf. Essa operação permite o download direto do formulário de texto inserido do PDF em vez de do JSON codificado em Base64.

// Monitor the operation until completion.

GET /documentModels/prebuilt-read/analyzeResults/{resultId}

200

{...}

// Upon successful completion, retrieve the PDF as application/pdf.

GET /documentModels/prebuilt-read/analyzeResults/{resultId}/pdf

200 OK

Content-Type: application/pdf

Pages (Páginas)

A coleção de páginas é uma lista de páginas dentro do documento. Cada página é representada sequencialmente dentro do documento e inclui o ângulo de orientação que indica se a página foi girada, além de largura e altura (dimensões em pixels). As unidades de página na saída do modelo são computadas conforme mostrado:

| Formato de arquivo | Unidade de página computada | Total de páginas |

|---|---|---|

| Imagens (JPEG/JPG, PNG, BMP, HEIF) | Cada imagem = 1 unidade de página | Total de imagens |

| Cada página no PDF = 1 unidade de página | Total de páginas no PDF | |

| TIFF | Cada imagem no TIFF = 1 unidade de página | Total de imagens no TIFF |

| Word (DOCX) | Até 3.000 caracteres = 1 unidade de página, imagens inseridas ou vinculadas sem suporte | Total de páginas de até 3.000 caracteres cada |

| Excel (XLSX) | Cada planilha = 1 unidade de página, imagens inseridas ou vinculadas sem suporte | Total de planilhas |

| PowerPoint (PPTX) | Cada slide = 1 unidade de página, imagens inseridas ou vinculadas sem suporte | Total de slides |

| HTML | Até 3.000 caracteres = 1 unidade de página, imagens inseridas ou vinculadas sem suporte | Total de páginas de até 3.000 caracteres cada |

"pages": [

{

"pageNumber": 1,

"angle": 0,

"width": 915,

"height": 1190,

"unit": "pixel",

"words": [],

"lines": [],

"spans": []

}

]

# Analyze pages.

for page in result.pages:

print(f"----Analyzing document from page #{page.page_number}----")

print(

f"Page has width: {page.width} and height: {page.height}, measured with unit: {page.unit}"

)

Selecionar páginas para extração de texto

Para grandes documentos PDF com várias páginas, use o parâmetro de consulta pages para indicar números de página ou intervalos de página específicos para a extração de texto.

Parágrafos

O modelo do OCR de Leitura na Informação de Documentos extrai todos os blocos de texto identificados na coleção paragraphs como um objeto de nível superior sob analyzeResults. Cada entrada dessa coleção representa um bloco de texto e inclui o texto extraído como content e as coordenadas polygon de limitação. As informações de span apontam para o fragmento de texto dentro da propriedade content de nível superior que contém o texto completo do documento.

"paragraphs": [

{

"spans": [],

"boundingRegions": [],

"content": "While healthcare is still in the early stages of its Al journey, we are seeing pharmaceutical and other life sciences organizations making major investments in Al and related technologies.\" TOM LAWRY | National Director for Al, Health and Life Sciences | Microsoft"

}

]

Linhas, texto e palavras

O modelo do OCR de Leitura extrai textos de estilo impresso e manuscritos como lines e words. O modelo gera coordenadas delimitadoras polygon e confidence para as palavras extraídas. A coleção styles inclui qualquer estilo manuscrito para linhas (se detectado), juntamente com os intervalos apontando para o texto associado. Esse recurso se aplica a linguagens manuscritas com suporte.

Para o Microsoft Word, Excel, PowerPoint e HTML, o modelo de Leitura de informação de documentos v3.1 e versões posteriores extrai todo o texto inserido como está. Textos são extraídos como palavras e parágrafos. Não há suporte para imagens incorporadas.

"words": [

{

"content": "While",

"polygon": [],

"confidence": 0.997,

"span": {}

},

],

"lines": [

{

"content": "While healthcare is still in the early stages of its Al journey, we",

"polygon": [],

"spans": [],

}

]

# Analyze lines.

for line_idx, line in enumerate(page.lines):

words = line.get_words()

print(

f"...Line # {line_idx} has {len(words)} words and text '{line.content}' within bounding polygon '{format_polygon(line.polygon)}'"

)

# Analyze words.

for word in words:

print(

f"......Word '{word.content}' has a confidence of {word.confidence}"

)

Estilo manuscrito para linhas de texto

A resposta inclui classificar se cada linha de texto tem um estilo manuscrito ou não, junto com uma pontuação de confiança. Para obter mais informações, confira o suporte ao idioma escrito à mão. O exemplo a seguir mostra um snippet JSON de exemplo.

"styles": [

{

"confidence": 0.95,

"spans": [

{

"offset": 509,

"length": 24

}

"isHandwritten": true

]

}

Se você habilitou a funcionalidade de complemento de fonte/estilo, também obterá o resultado de fonte/estilo como parte do objeto styles.

Próximas etapas

Conclua um início rápido da Informação de Documentos:

Explore nossa API REST:

Confira mais exemplos no GitHub: