Operações de machine learning

As operações de machine learning (também chamadas de MLOps) são a aplicação de princípios de DevOps para aplicativos infundidos com IA. Para implementar as operações de machine learning em uma organização, é necessário implementar habilidades, processos e tecnologia. O objetivo é fornecer soluções de machine learning que sejam robustas, escalonáveis, confiáveis e automatizadas.

Neste artigo, saiba como planejar recursos para dar suporte às operações de machine learning no nível da organização. Revise as melhores práticas e as recomendações baseadas no uso do Azure Machine Learning para adotar as operações de machine learning na empresa.

O que são operações de machine learning?

As estruturas e os algoritmos modernos de machine learning facilitam cada vez mais o desenvolvimento de modelos que podem fazer previsões precisas. As operações de machine learning são uma forma estruturada de incorporar o machine learning no desenvolvimento de aplicativos na empresa.

Em um exemplo de cenário, você criou um modelo de machine learning que excede todas as suas expectativas de precisão e surpreende seus patrocinadores de negócios. Agora, é hora de implantar o modelo em produção, mas isso pode não ser tão fácil quanto você esperava. Provavelmente, a organização precisará ter pessoas, processos e tecnologia em vigor antes para usar seu modelo de machine learning em produção.

Com o tempo, você ou um colega pode desenvolver um novo modelo que funcione melhor do que o modelo original. A substituição de um modelo de machine learning usado em produção apresenta algumas questões importantes para a organização:

- O ideal será implementar o novo modelo sem interromper as operações comerciais que dependem do modelo implantado.

- Para fins regulatórios, talvez seja necessário explicar as previsões do modelo ou recriar o modelo caso haja previsões incomuns ou tendenciosas como resultado dos dados no novo modelo.

- Os dados usados no treinamento e no modelo de machine learning podem mudar ao longo do tempo. Com as alterações nos dados, talvez seja necessário treinar o modelo periodicamente para manter a precisão da previsão. Uma pessoa ou uma função precisará ter a responsabilidade atribuída para alimentar os dados, monitorar o desempenho do modelo, treinar o modelo novamente e corrigi-lo em caso de falha.

Considere um caso de uso comum: suponha que você tenha um aplicativo que atenda às previsões de um modelo por meio de uma API REST. Mesmo um caso de uso simples como esse pode causar problemas na produção. A implementação de uma estratégia de operações de machine learning pode ajudar você a resolver questões de implantação e dar suporte a operações comerciais que dependem de aplicativos infundidos com IA.

Algumas tarefas de operações de machine learning se adaptam bem à estrutura geral de DevOps. Entre os exemplos estão a configuração de testes de unidade e testes de integração e o controle de alterações com o controle de versão. Outras tarefas são mais exclusivas às operações de machine learning e podem incluir:

- Habilitar a experimentação contínua e a comparação com um modelo de linha de base.

- Monitorar os dados de entrada para detectar o descompasso de dados.

- Disparar o novo treinamento de modelo e configurar uma reversão para recuperação de desastre.

- Crie pipelines de dados reutilizáveis para treinamento e pontuação.

A meta das operações de machine learning é fechar a lacuna entre o desenvolvimento e a produção e fornecer valor aos clientes com mais rapidez. Para atingir essa meta, é preciso repensar os processos tradicionais de desenvolvimento e de produção.

Nem todos os requisitos de operações de machine learning da organização são os mesmos. A arquitetura de operações de machine learning de uma grande empresa multinacional provavelmente não será a mesma infraestrutura estabelecida por uma start-up pequena. As organizações costumam começar pequenas e crescem à medida que a maturidade, o catálogo de modelos e a experiência aumentam.

O modelo de maturidade das operações de machine learning pode ajudar você a ver em que ponto sua organização está na escala de maturidade das operações de machine learning e ajudar você a planejar o crescimento futuro.

Operações de machine learning vs. DevOps

As operações de machine learning são diferentes do DevOps em várias áreas-chave. As operações de machine learning têm estas características:

- A exploração precede o desenvolvimento e as operações.

- O ciclo de vida de ciência de dados exige uma forma adaptável de trabalho.

- Os limites para a qualidade dos dados e a disponibilidade restringem o progresso.

- É necessário um esforço operacional maior do que no DevOps.

- As equipes de trabalho exigem especialistas e especialistas no domínio.

Para ver um resumo, revise os sete princípios das operações de machine learning.

A exploração precede o desenvolvimento e as operações

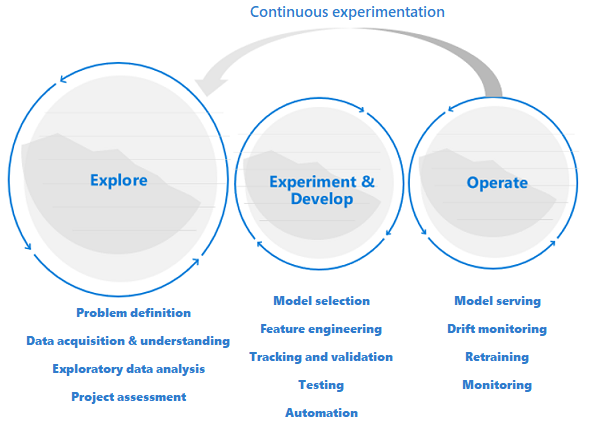

Os projetos de ciência de dados são diferentes dos projetos de desenvolvimento de aplicativos ou de engenharia de dados. Um projeto de ciência de dados pode chegar à produção, mas muitas vezes um número maior de etapas está envolvido do que em uma implantação tradicional. Após uma análise inicial, poderá ficar claro que o resultado comercial não poderá ser alcançado com os conjuntos de dados disponíveis. Uma fase de exploração mais detalhada geralmente é a primeira etapa em um projeto de ciência de dados.

A meta da fase de exploração é definir e refinar o problema. Durante essa fase, os cientistas de dados executam análises de dados exploratórias. Eles usam estatísticas e visualizações para confirmar ou falsificar as hipóteses do problema. Os stakeholders devem entender que o projeto pode não se estender além dessa fase. Ao mesmo tempo, é importante tornar essa fase a mais perfeita possível para um retorno rápido. A menos que o problema a ser resolvido inclua um elemento de segurança, evite restringir a fase exploratória com processos e procedimentos. Os cientistas de dados devem ter permissão para trabalhar com as ferramentas e os dados que preferem. Os dados reais são necessários para este trabalho exploratório.

O projeto poderá passar para as fases de experimentação e desenvolvimento quando os stakeholders estiverem confiantes de que o projeto de ciência de dados é viável e pode fornecer um valor comercial real. Nesta fase, as práticas de desenvolvimento passam a ser cada vez mais importantes. É uma boa prática capturar métricas para todos os experimentos que são feitos neste estágio. Também é importante incorporar o controle do código-fonte para que você possa comparar os modelos e alternar entre versões diferentes do código.

As atividades de desenvolvimento incluem refatoração, teste e automação do código de exploração em pipelines de experimentação repetíveis. A organização precisa criar aplicativos e pipelines para fornecer os modelos. A refatoração do código em componentes e bibliotecas modulares ajuda a aumentar a reutilização, o teste e a otimização do desempenho.

Por fim, os pipelines de inferência de aplicativo ou em lote que fornecem os modelos são implantados em ambientes de preparo ou de produção. Além de monitorar a confiabilidade e o desempenho da infraestrutura, como para um aplicativo padrão, em uma implantação de modelo de machine learning, você precisa monitorar continuamente a qualidade dos dados, o perfil de dados e o modelo de degradação ou descompasso. Os modelos de machine learning também exigem um novo treinamento ao longo do tempo para ficarem relevantes em um ambiente em constante mudança.

O ciclo de vida de ciência de dados requer uma maneira adaptável de trabalhar

Como a natureza e a qualidade dos dados inicialmente são incertas, talvez você não atinja suas metas de negócios caso aplique um processo típico de DevOps a um projeto de ciência de dados. A exploração e a experimentação são atividades e necessidades recorrentes ao longo do processo de machine learning. As equipes da Microsoft usam um ciclo de vida do projeto e um processo de trabalho que refletem a natureza das atividades específicas da ciência de dados. O Processo de Ciência de Dados da Equipe e o Processo de Ciclo de Vida da Ciência de Dados são exemplos de implementações de referência.

Os limites para a qualidade dos dados e a disponibilidade restringem o progresso

Para que uma equipe de machine learning desenvolva aplicativos infundidos com machine learning de maneira efetiva, o acesso aos dados de produção é desejável em todos os ambientes de trabalho relevantes. Se o acesso aos dados de produção não for possível devido a requisitos de conformidade ou a restrições técnicas, considere a implementação do RBAC do Azure (controle de acesso baseado em função) do Azure com o Azure Machine Learning, o acesso just-in-time ou os pipelines de movimentação de dados para criar réplicas de dados de produção e aprimorar a produtividade do usuário.

O aprendizado de máquina requer um esforço operacional maior

Ao contrário dos programas de software tradicionais, o desempenho de uma solução de machine learning está constantemente em risco porque a solução depende da qualidade dos dados. Para manter uma solução qualitativa em produção, é fundamental que você monitore e reavalie continuamente a qualidade dos dados e do modelo. Espera-se que um modelo de produção exija o retreinamento, reimplantação e ajuste oportunos. Essas tarefas são a prioridade nos requisitos de segurança diária, de monitoramento da infraestrutura ou de conformidade e exigem conhecimento especializado.

As equipes de machine learning exigem especialistas e especialistas no domínio

Embora os projetos de ciência de dados compartilhem funções com projetos comuns de TI, o sucesso de um esforço de machine learning depende muito de um grupo de especialistas em tecnologia essencial de machine learning e em especialistas no assunto do domínio. Um especialista em tecnologia tem a experiência certa para fazer experimentos de machine learning de ponta a ponta. Um especialista no domínio pode dar suporte ao especialista analisando e sintetizando dados ou qualificando os dados para uso.

As funções técnicas comuns exclusivas dos projetos de ciência de dados são especialista no domínio, engenheiro de dados, cientista de dados, engenheiro de IA, validador de modelo e engenheiro de machine learning. Para saber mais sobre as funções e as tarefas de uma equipe típica de ciência de dados, confira o Processo de Ciência de Dados da Equipe.

Sete princípios das operações de machine learning

Conforme você planeja a adoção das operações de machine learning na sua organização, considere a possibilidade de aplicar os seguintes princípios fundamentais como base:

Usar o controle de versão para saídas de código, dados e experimentação. Ao contrário do desenvolvimento tradicional de software, os dados têm uma influência direta na qualidade dos modelos de machine learning. Você deve controlar a versão da sua base de código de experimentação, mas também controlar a versão dos conjuntos de dados para garantir que possa reproduzir os experimentos ou os resultados de inferência. As saídas de experimentação de controle de versão como os modelos podem poupar esforços e o custo computacional da recriação deles.

Usar vários ambientes. Para separar o desenvolvimento e os testes do trabalho de produção, replique sua infraestrutura em, pelo menos, dois ambientes. O controle de acesso para usuários pode ser diferente para cada ambiente.

Gerenciar a infraestrutura e as configurações como código. Quando você criar e atualizar os componentes da infraestrutura nos ambientes de trabalho, use a infraestrutura como código para que não se desenvolvam inconsistências nos ambientes. Gerencie as especificações do trabalho do experimento de machine learning como código, para que você possa executar novamente e reutilizar com facilidade uma versão do experimento em vários ambientes.

Acompanhar e gerenciar experimentos de machine learning. Acompanhe os indicadores chave de desempenho e outros artefatos para seus experimentos de machine learning. Ao manter um histórico do desempenho do trabalho, você pode fazer uma análise quantitativa do sucesso da experimentação e aprimorar a colaboração e a agilidade da equipe.

Teste o código, valide a integridade dos dados e garanta a qualidade do modelo. Teste sua base de código de experimentação para obter funções corretas de preparação e extração de recursos, integridade de dados e desempenho do modelo.

Integração e entrega contínuas de machine learning. Use a CI (integração contínua) para automatizar o teste para sua equipe. Inclua o treinamento de modelo como parte dos pipelines de treinamento contínuo. Inclua o teste A/B como parte da versão para garantir que apenas um modelo qualitativo seja usado em produção.

Monitore serviços, modelos e dados. Quando você fornece modelos em um ambiente de operações de machine learning, é fundamental monitorar os serviços em relação ao tempo de atividade da infraestrutura, à conformidade e à qualidade do modelo. Configure o monitoramento para identificar o descompasso dos dados e do modelo e entender se um novo treinamento é necessário. Considere a possibilidade de configurar gatilhos para um novo treinamento automático.

Melhores práticas do Azure Machine Learning

O Azure Machine Learning oferece serviços de gerenciamento, orquestração e automação de ativos para ajudar você a gerenciar o ciclo de vida dos seus fluxos de trabalho de treinamento e de implantação do modelo de machine learning. Revise as melhores práticas e as recomendações para aplicar as operações de machine learning nas áreas de recursos de pessoas, processos e tecnologia, todas com o suporte do Azure Machine Learning.

Pessoas

Trabalhe em equipes de projeto para melhor utilizar o conhecimento especializado e de domínio na sua organização. Configure workspaces do Azure Machine Learning para cada projeto a fim de atender aos requisitos de segregação de casos de uso.

Defina um conjunto de responsabilidades e tarefas como uma função para que qualquer membro da equipe em uma equipe de projeto das operações de machine learning possa ser atribuído e cumpra várias funções. Use as funções personalizadas do Azure para definir um conjunto de operações granulares do RBAC do Azure para o Azure Machine Learning que cada função pode executar.

Padronize o ciclo de vida de projeto e a metodologia Agile. O Processo de Ciência de Dados de Equipe fornece uma implementação de ciclo de vida de referência.

As equipes equilibradas podem executar todas as fases das operações de machine learning, incluindo exploração, desenvolvimento e operações.

Processar

Padronize um modelo de código para a reutilização do código e para acelerar o tempo de atividade em um novo projeto ou quando um novo membro da equipe ingressar no projeto. Use pipelines do Azure Machine Learning, scripts de envio de trabalho e pipelines de CI/CD como base para novos modelos.

Usar o controle de versão. Os trabalhos enviados de uma pasta com suporte do Git rastreiam automaticamente os metadados do repositório com o trabalho no Azure Machine Learning para reprodutibilidade.

Use o controle de versão para entradas e saídas de experimento para reprodutibilidade. Use as funcionalidades de conjunto de dados do Azure Machine Learning, de gerenciamento de modelos e de gerenciamento de ambiente para facilitar o controle de versão.

Crie um histórico de execuções de experimentos para permitir a comparação, o planejamento e a colaboração. Use uma estrutura de acompanhamento de experimentos como o MLflow para coletar métricas.

Meça e controle continuamente a qualidade do trabalho da sua equipe por meio da CI na base de código de experimentação completa.

Encerre o treinamento no início do processo quando um modelo não convergir. Use uma estrutura de acompanhamento de experimentos e o histórico de execuções do Azure Machine Learning para monitorar as execuções dos trabalhos.

Defina uma estratégia de gerenciamento de modelos e experimentos. Considere o uso de um nome como campeão para se referir ao modelo de linha de base atual. Um modelo desafiante é um modelo candidato que pode superar o modelo campeão em produção. Aplique marcas no Azure Machine Learning para marcar experimentos e modelos. Em um cenário como previsão de vendas, podem ser necessários meses para determinar se as previsões do modelo são precisas.

Eleve a CI para treinamento contínuo incluindo o treinamento de modelo no build. Por exemplo, inicie o treinamento do modelo no conjunto de dados completo com cada solicitação de pull.

Reduza o tempo de comentários sobre a qualidade do pipeline de machine learning executando um build automatizado em uma amostra dos dados. Use os parâmetros de pipeline do Azure Machine Learning para parametrizar os conjunto de dados de entrada.

Use a CD (implantação contínua) para modelos de machine learning a fim de automatizar a implantação e o teste de serviços de pontuação em tempo real nos seus ambientes do Azure.

Em alguns setores regulamentados, você pode precisar concluir as etapas de validação de modelo para usar um modelo de machine learning em um ambiente de produção. A automatização das etapas de validação pode acelerar o tempo de entrega. Quando as etapas manuais de revisão ou de validação ainda forem um gargalo, considere se você pode certificar o pipeline de validação de modelo automatizado. Use marcas de recurso no Azure Machine Learning para indicar a conformidade do ativo e os candidatos para revisão ou como gatilhos para implantação.

Não faça um novo treinamento em produção e substitua diretamente o modelo de produção sem nenhum teste de integração. Embora o desempenho do modelo e os requisitos funcionais possam parecer bons, entre outros problemas potenciais, um modelo retreinado pode ter um volume de ambiente maior e interromper o ambiente do servidor.

Quando o acesso a dados de produção estiver disponível apenas em produção, use o RBAC do Azure e as funções personalizadas fornecer o acesso de leitura a um número selecionado de profissionais de machine learning. Algumas funções podem precisar ler os dados para exploração de dados relacionados. Como alternativa, disponibilize uma cópia de dados nos ambientes de não produção.

Concorde em convenções de nomenclatura e marcas para experimentos do Azure Machine Learning para diferenciar pipelines de aprendizado de máquina de linha de base de retreinamento do trabalho experimental.

Tecnologia

Se, atualmente, você enviar trabalhos por meio da CLI ou da interface do usuário do estúdio do Azure Machine Learning, em vez de enviar trabalhos por meio do SDK, use a CLI ou as tarefas de machine learning do Azure DevOps para configurar as etapas do pipeline de automação. Esse processo pode reduzir a pegada do código reutilizando os mesmos envios de trabalho diretamente dos pipelines de automação.

Use a programação baseada em evento. Por exemplo, dispare um pipeline de teste de modelo offline usando o Azure Functions depois que um novo modelo for registrado. Ou, então, envie uma notificação para um alias de email designado em caso de falha na execução de um pipeline crítico. O Azure Machine Learning cria eventos na Grade de Eventos do Azure. Várias funções podem se inscrever para serem notificadas de um evento.

Ao usar o Azure DevOps para automação, use as tarefas do Azure DevOps para Machine Learning para usar modelos de machine learning como gatilhos de pipeline.

Ao desenvolver pacotes Python para seu aplicativo de aprendizado de máquina, você pode hospedá-los em um repositório do Azure DevOps como artefatos e publicá-los como um feed. Usando essa abordagem, você pode integrar o fluxo de trabalho do DevOps para criar pacotes com o workspace do Azure Machine Learning.

Considere o uso de um ambiente de preparo para testar a integração do sistema de pipelines de machine learning aos componentes de aplicativos upstream ou downstream.

Crie testes de unidade e integração para seus pontos de extremidade de inferência para permitir uma depuração aprimorada e acelerar o tempo de implantação.

Para disparar o novo treinamento, use monitores de conjunto de dados e fluxos de trabalho controlados por eventos. Assine os eventos de descompasso de dados e automatize o gatilho de pipelines de machine learning para novo treinamento.

Fábrica de IA para operações de machine learning da organização

Uma equipe de ciência de dados pode decidir que pode gerenciar vários casos de uso de machine learning internamente. A adoção de operações de machine learning ajuda uma organização a configurar equipes de projeto para obter melhor qualidade, confiabilidade e capacidade de manutenção das soluções. Por meio de equipes equilibradas, processos com suporte e automação de tecnologia, uma equipe que adota as operações de machine learning pode escalar e se concentrar no desenvolvimento de novos casos de uso.

À medida que o número de casos de uso aumenta em uma organização, a carga de gerenciamento de suporte a esses casos de uso cresce linearmente ou até mais. O desafio para a organização passa a ser como acelerar o tempo de comercialização, dar suporte a uma avaliação mais rápida da viabilidade dos casos de uso, implementar a repetibilidade e fazer um melhor uso dos recursos disponíveis e dos conjuntos de habilidades em uma variedade de projetos. Para muitas organizações, o desenvolvimento de uma fábrica de IA é a solução.

Uma fábrica de IA é um sistema de processos comerciais repetíveis e artefatos padronizados que facilita o desenvolvimento e a implantação de um grande conjunto de casos de uso de machine learning. Uma fábrica de IA otimiza a organização da equipe, as práticas recomendadas, a estratégia de operações de machine learning, os padrões de arquitetura e os modelos reutilizáveis que são adaptados aos requisitos de negócios.

Uma fábrica de IA de sucesso depende da criação de processos repetíveis e de ativos reutilizáveis para ajudar a organização a escalar de dezenas a milhares de casos de uso de maneira eficiente.

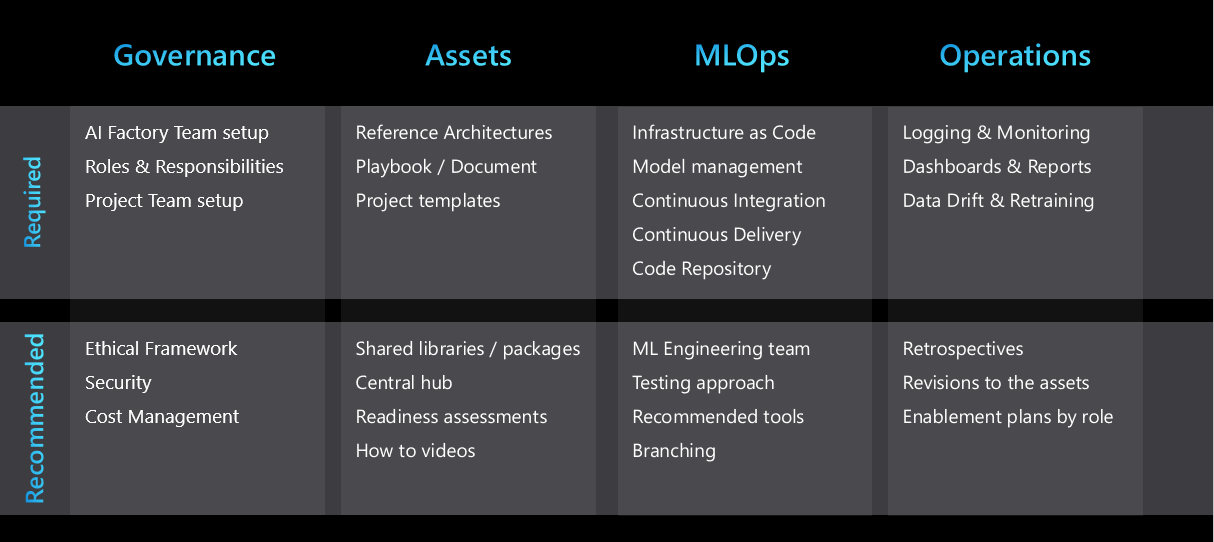

A figura a seguir resume os principais elementos de uma fábrica de IA:

Padronizar padrões de arquitetura repetitivos

A repetibilidade é uma característica fundamental de uma fábrica de IA. As equipes de ciência de dados podem acelerar o desenvolvimento de projetos e melhorar a consistência entre projetos, desenvolvendo alguns padrões de arquitetura repetitivos que abrangem a maioria dos casos de uso de aprendizado de máquina para sua organização. Quando esses padrões estiverem em uso, a maioria dos projetos poderá usar esses padrões para aproveitar os seguintes benefícios:

- Fase de design acelerada

- Aprovações aceleradas de equipes de TI e segurança ao reutilizar ferramentas em projetos

- Desenvolvimento acelerado devido aos modelos de projeto e de infraestrutura como código reutilizáveis

Os padrões de arquitetura podem incluir, mas não estão limitados aos seguintes tópicos:

- Serviços preferenciais para cada estágio do projeto

- Governança e conectividade de dados

- Uma estratégia de operações de machine learning adaptada aos requisitos do setor, da empresa ou da classificação de dados

- Modelos campeão e desafiante para o gerenciamento de experimentos

Facilitar a colaboração e o compartilhamento entre equipes

Repositórios e utilitários de código compartilhados podem acelerar o desenvolvimento de soluções de aprendizado de máquina. Os repositórios de código podem ser desenvolvidos de maneira modular durante o desenvolvimento do projeto de modo que sejam genéricos o suficiente para serem usados por outros projetos. Eles podem ser disponibilizados em um repositório central que todas as equipes de ciência de dados podem acessar.

Compartilhar e reutilizar a propriedade intelectual

Para maximizar a reutilização de código, revise a seguinte propriedade intelectual no início de um projeto:

- Código interno que foi projetado para reutilização na organização. Entre os exemplos estão os pacotes e os módulos.

- Conjuntos de dados que foram criados em outros projetos de machine learning ou que estão disponíveis no ecossistema do Azure.

- Projetos de ciência de dados existentes que têm uma arquitetura e problemas de negócios semelhantes.

- Repositórios GitHub ou de software livre que podem acelerar o projeto.

Qualquer retrospectiva do projeto deve incluir um item de ação para determinar se os elementos do projeto podem ser compartilhados e generalizados para reutilização mais ampla. A lista de ativos que a organização pode compartilhar e reutilizar se expande com o tempo.

Para ajudar no compartilhamento e na descoberta, muitas organizações introduziram repositórios compartilhados para organizar snippets de código e artefatos de machine learning. Os artefatos no Azure Machine Learning, incluindo conjuntos de dados, modelos, ambientes e pipelines, podem ser definidos como código, ou seja, você pode compartilhá-los com eficiência entre projetos e workspaces.

Modelos de projeto

Para acelerar o processo de migração das soluções existentes e maximizar a reutilização de código, muitas organizações padronizam um modelo de projeto para iniciar novos projetos. Entre os exemplos de modelos de projeto recomendados para uso com o Azure Machine Learning estão os exemplos do Azure Machine Learning, o Processo de Ciclo de Vida da Ciência de Dados e o Processo de Ciência de Dados da Equipe.

Gerenciamento de dados central

O processo para obtenção do acesso aos dados para exploração ou uso de produção pode ser demorado. Muitas organizações centralizam o gerenciamento de dados para reunir produtores e consumidores de dados a fim de facilitar o acesso aos dados para experimentação de machine learning.

Utilitários compartilhados

Sua organização pode usar painéis centralizados de toda a empresa para consolidar as informações de log e monitoramento. Os painéis podem incluir log de erros, disponibilidade e telemetria do serviço, além de monitoramento de desempenho do modelo.

Use as métricas do Azure Monitor para criar um painel para o Azure Machine Learning e serviços associados como o Armazenamento do Azure. Um painel ajuda você a acompanhar o progresso da experimentação, a integridade da infraestrutura de computação e a utilização da cota de GPU.

Equipe especializada de engenharia de machine learning

Muitas organizações implementaram a função de engenheiro de machine learning. Um engenheiro de machine learning é especializado na criação e na execução de pipelines robustos de machine learning, no monitoramento de descompasso e no novo treinamento de fluxos de trabalho e no monitoramento de painéis. O engenheiro tem a responsabilidade geral de industrializar a solução de machine learning, do desenvolvimento à produção. Ele trabalha em estreita colaboração com a engenharia de dados, os arquitetos e a segurança e as operações a fim de garantir que todos os controles necessários estejam em vigor.

Embora a ciência de dados exija conhecimento profundo no domínio, a engenharia de machine learning é mais técnica em foco. A diferença torna o engenheiro de machine learning mais flexível, de modo que ele possa trabalhar em vários projetos e com vários departamentos de negócios. Amplas práticas de ciência de dados podem se beneficiar de uma equipe de engenharia de machine learning especializada que impulsiona a repetibilidade e a reutilização de fluxos de trabalho de automação em vários casos de uso e em várias áreas de negócios.

Habilitação e documentação

É importante fornecer diretrizes claras sobre o processo de fábrica de IA para equipes e usuários novos e existentes. As diretrizes ajudam a garantir a consistência e a reduzir o esforço necessário da equipe de engenharia de machine learning ao industrializar um projeto. Considere a criação de conteúdo especificamente para as várias funções em sua organização.

Todos têm um estilo de aprendizado exclusivo e, portanto, uma combinação dos seguintes tipos de diretrizes pode ajudar a acelerar a adoção da estrutura de fábrica de IA:

- Um hub central que tenha links para todos os artefatos. Por exemplo, esse hub pode ser um canal no Microsoft Teams ou um site do Microsoft SharePoint.

- Plano de treinamento e habilitação projetado para cada função.

- Uma apresentação resumida de alto nível da abordagem e um vídeo complementar.

- Um documento ou um guia estratégico detalhado.

- Vídeos de instruções.

- Avaliações de preparação.

Série de vídeos sobre as operações de machine learning no Azure

Uma série de vídeos sobre as operações de machine learning no Azure mostra como estabelecer as operações de machine learning para sua solução de machine learning, do desenvolvimento inicial à produção.

Ética

A ética desempenha um papel fundamental no design de uma solução de IA. Se princípios éticos não forem implementados, os modelos treinados poderão apresentar o mesmo viés presente nos dados em que foram treinados. Isso poderá resultar na descontinuação do projeto. E o mais importante: a reputação da organização pode estar em risco.

Para garantir que os princípios éticos básicos que a organização defende sejam implementados em todos os projetos, a organização deve fornecer uma lista desses princípios e maneiras de validá-los de uma perspectiva técnica durante a fase de teste. Use os recursos de machine learning do Azure Machine Learning para entender o que é machine learning responsável e como incorporá-lo nas suas operações de machine learning.

Próximas etapas

Saiba mais sobre como organizar e configurar ambientes do Azure Machine Learning ou assista a uma série de vídeos práticos sobre as operações de machine learning no Azure.

Saiba mais sobre como gerenciar orçamentos, cotas e custos no nível da organização usando o Azure Machine Learning: