Transformar dados usando a atividade do Hadoop Pig no Azure Data Factory ou no Synapse Analytics

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

A atividade do Pig no HDInsight em um pipeline do Data Factory executa consultas do Pig em um cluster do HDInsight de sua propriedade ou sob demanda. Este artigo se baseia no artigo sobre atividades de transformação de dados que apresenta uma visão geral da transformação de dados e as atividades de transformação permitidas.

Para saber mais, leia a introdução ao Azure Data Factory ou ao Synapse Analytics e siga o tutorial: Tutorial: transformar dados antes de ler este artigo.

Adicionar uma atividade Pig do HDInsight a um pipeline com a interface do usuário

Para usar uma atividade Pig do HDInsight para um pipeline, conclua as seguintes etapas:

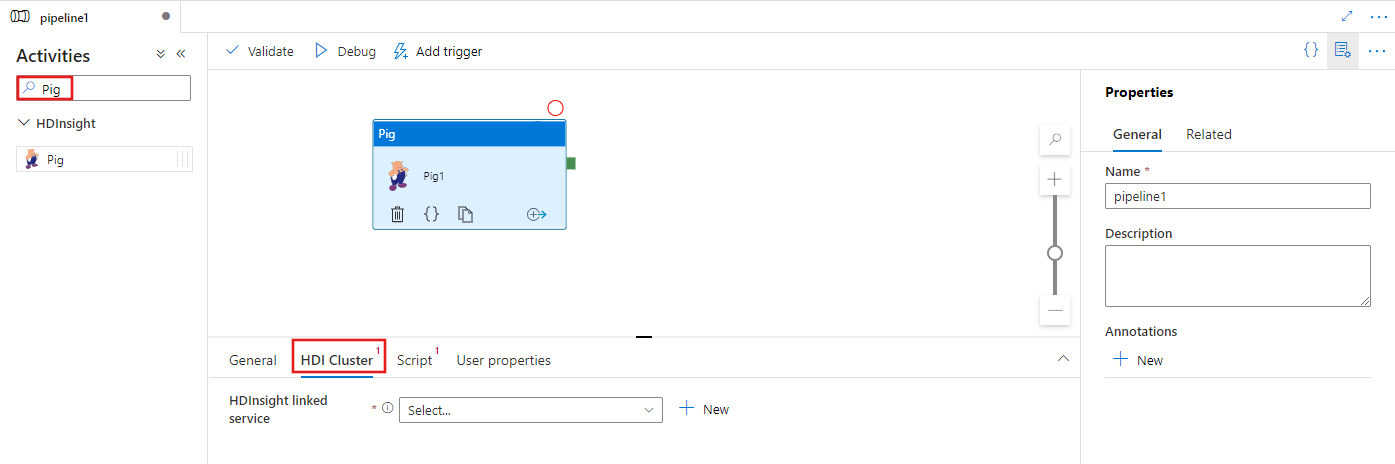

Procure Pig no painel Atividades do pipeline e arraste uma atividade Pig para a tela do pipeline.

Selecione a nova atividade Pig na tela se ela ainda não estiver selecionada.

Selecione a guia Cluster HDI para selecionar ou criar um novo serviço vinculado para um cluster HDInsight que será usado para executar a atividade MapReduce.

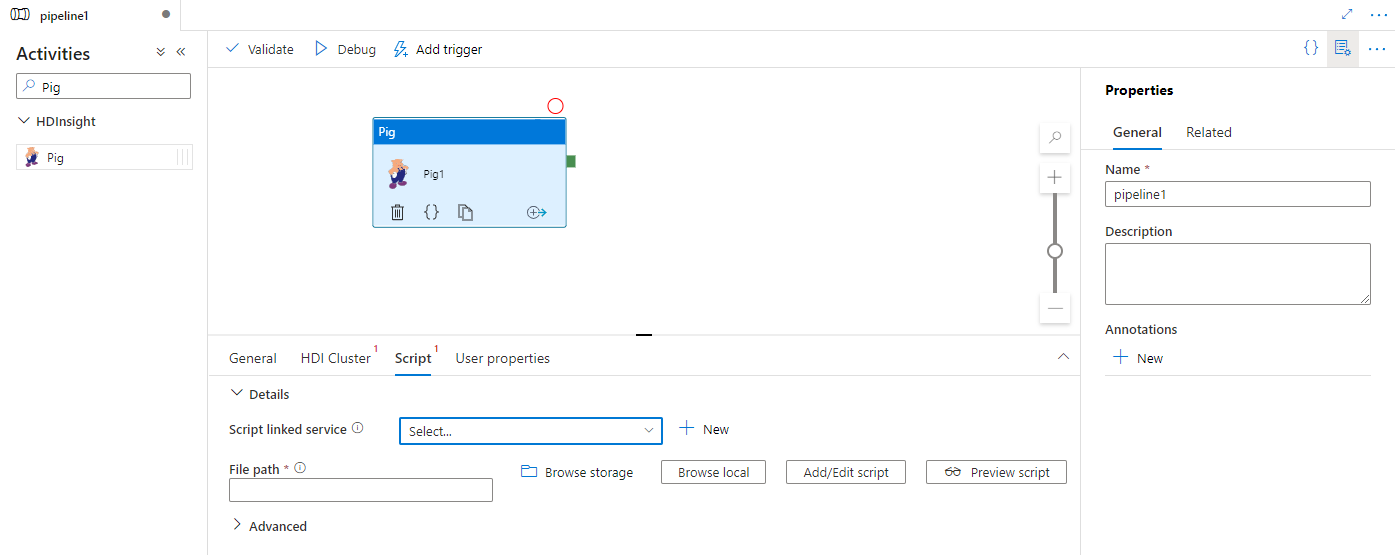

Escolha a guia Script para selecionar ou criar um serviço de script vinculado a um local de Armazenamento do Azure em que o script será hospedado. Especifique um nome de classe a ser executada no local de armazenamento e um caminho de arquivo dentro desse local. Você também pode configurar detalhes avançados, incluindo uma configuração de depuração, bem como argumentos e parâmetros a serem passados para o script.

Sintaxe

{

"name": "Pig Activity",

"description": "description",

"type": "HDInsightPig",

"linkedServiceName": {

"referenceName": "MyHDInsightLinkedService",

"type": "LinkedServiceReference"

},

"typeProperties": {

"scriptLinkedService": {

"referenceName": "MyAzureStorageLinkedService",

"type": "LinkedServiceReference"

},

"scriptPath": "MyAzureStorage\\PigScripts\\MyPigSript.pig",

"getDebugInfo": "Failure",

"arguments": [

"SampleHadoopJobArgument1"

],

"defines": {

"param1": "param1Value"

}

}

}

Detalhes da sintaxe

| Propriedade | Descrição | Obrigatório |

|---|---|---|

| name | Nome da atividade | Sim |

| descrição | Texto que descreve qual a utilidade da atividade | Não |

| type | Para a atividade do Hive, o tipo de atividade é HDinsightPig | Sim |

| linkedServiceName | Referência ao cluster do HDInsight registrado como um serviço vinculado. Para saber mais sobre esse serviço vinculado, consulte o artigo Compute linked services (Serviços de computação vinculados). | Sim |

| scriptLinkedService | Referência a um serviço vinculado do Armazenamento do Azure usado para armazenar o script do Pig a ser executado. Somente os serviços vinculados do Armazenamento de Blobs do Azure e do ADLS Gen2 são compatíveis aqui. Se você não especificar esse serviço vinculado, será usado o serviço vinculado do Armazenamento do Azure definido no serviço vinculado do HDInsight. | Não |

| scriptPath | Forneça o caminho para o arquivo de script armazenado no Armazenamento do Azure referenciado por scriptLinkedService. O nome do arquivo diferencia maiúsculas de minúsculas. | Não |

| getDebugInfo | Especifica quando os arquivos de log são copiados para o Armazenamento do Azure usado pelo cluster do HDInsight (ou) especificado por scriptLinkedService. Valores permitidos: Nenhum, Sempre ou Falha. Valor padrão: Nenhum. | Não |

| argumentos | Especifica uma matriz de argumentos para um trabalho do Hadoop. Os argumentos são passados como argumentos de linha de comando para cada tarefa. | Não |

| defines | Especifique os parâmetros como pares chave-valor para referências no script do Pig. | Não |

Conteúdo relacionado

Consulte os seguintes artigos que explicam como transformar dados de outras maneiras:

- U-SQL activity (Atividade do U-SQL)

- Hive activity (Atividade do Hive)

- MapReduce activity (Atividade do MapReduce)

- Hadoop Streaming activity (Atividade de streaming do Hadoop)

- Spark activity (Atividade do Spark)

- Atividade personalizada do .NET

- Stored procedure activity (Atividade de procedimento armazenado)