Baixar arquiteturas de referência do lakehouse

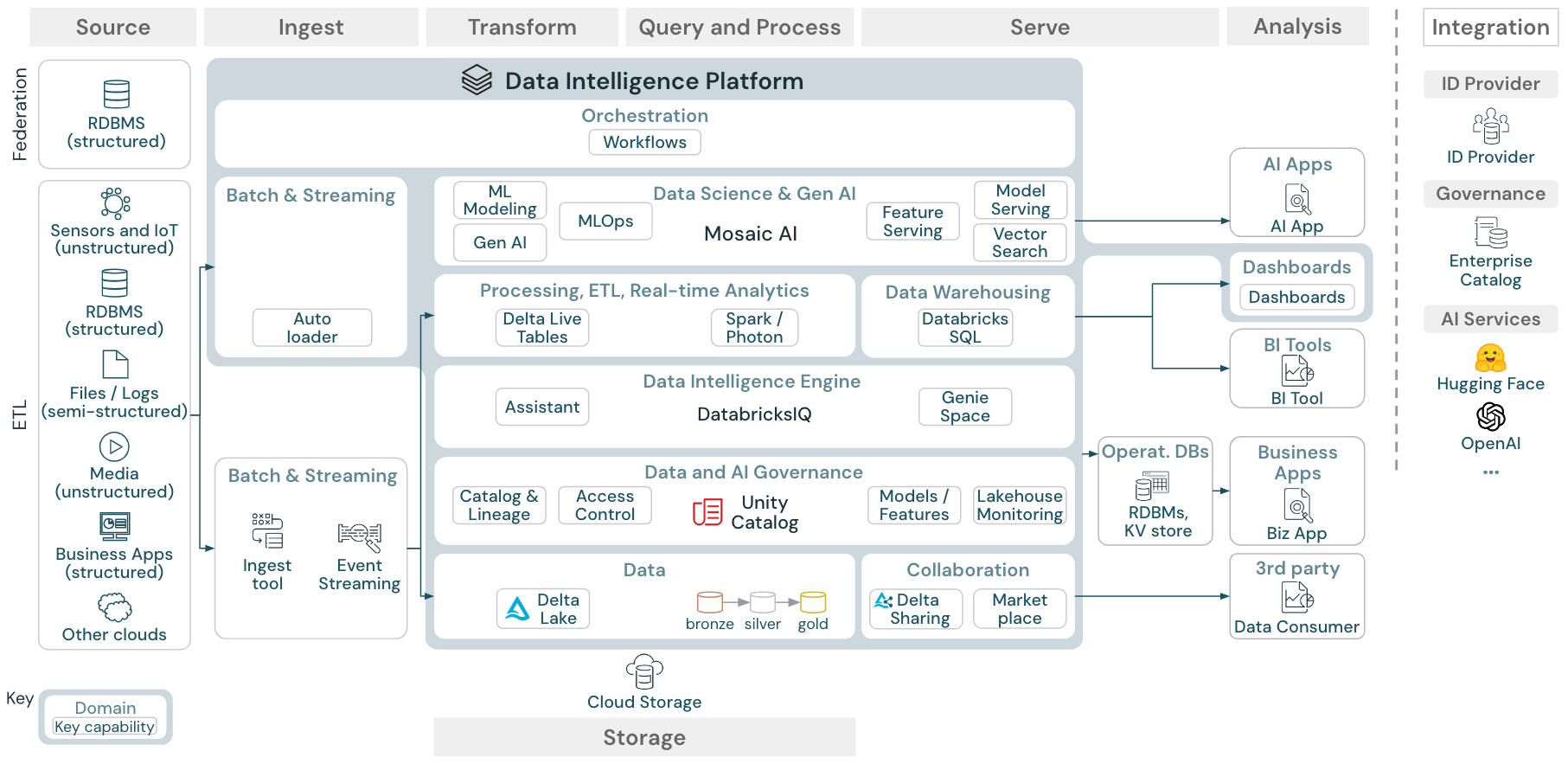

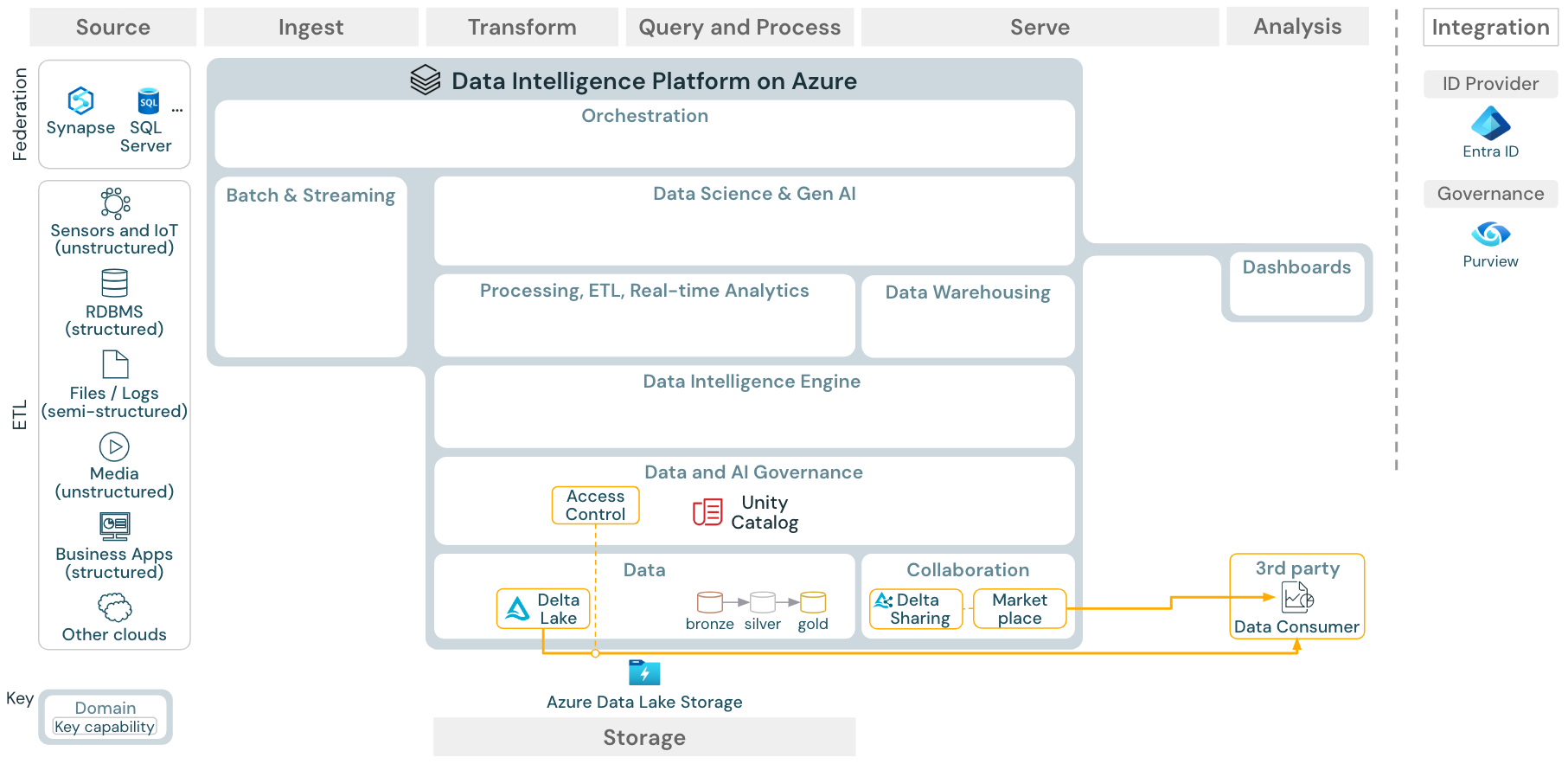

Este artigo aborda as diretrizes de arquitetura para o lakehouse em termos de fonte de dados, ingestão, transformação, consulta e processamento, serviço, análise/saída e armazenamento.

Cada arquitetura de referência tem um PDF para download no formato 11 x 17 (A3).

Arquitetura de referência genérica

Download: Arquitetura de referência genérica do Lakehouse para Databricks (PDF)

Organização das arquiteturas de referência

A arquitetura de referência é estruturada ao longo das pistas de natação Fonte, Ingestão, Transformação, Consulta e Processo, Servir, Análisee Armazenamento:

Origem

A arquitetura distingue entre dados semiestruturados e não estruturados (sensores e IoT, mídia, arquivos/logs) e dados estruturados (RDBMS, aplicativos empresariais). As fontes SQL (RDBMS) também podem ser integradas ao lakehouse e Catálogo do Unity sem ETL por meio da federação lakehouse. Além disso, os dados podem ser carregados de outros provedores de nuvem.

Ingestão

Os dados podem ser ingeridos na lakehouse por meio de lote ou streaming:

- Os arquivos entregues ao armazenamento em nuvem podem ser carregados diretamente usando o Carregador Automático do Databricks.

- Para ingestão em lote de dados de aplicativos empresariais em Delta Lake, o do Databricks Lakehouse depende ferramentas de ingestão de parceiros com adaptadores específicos para esses sistemas de registro.

- Eventos de streaming podem ser ingeridos diretamente de sistemas de streaming de eventos, como o Kafka, usando o Streaming Estruturado do Databricks. As fontes de streaming podem ser sensores, IoT ou processos de captura de dados de alteração.

Storage

Normalmente, os dados são armazenados no sistema de armazenamento em nuvem em que os pipelines de ETL usam a arquitetura de medalhão para armazenar dados de forma selecionada como arquivos/tabelas Delta.

Transformar e Consultar e processar

O Databricks lakehouse usa seus mecanismos Apache Spark e Photon para todas as transformações e consultas.

Devido à sua simplicidade, o DLT da estrutura declarativa (Tabelas Dinâmicas Delta) é uma boa opção para criar pipelines de processamento de dados confiáveis, testáveis e de fácil manutenção.

Com o Apache Spark e o Photon, a Plataforma de Inteligência de Dados do Databricks dá suporte a ambos os tipos de cargas de trabalho: consultas SQL por meio de SQL warehouses e cargas de trabalho SQL, Python e Scala por meio de clusters de workspace.

Para a ciência de dados (ML Modeling e Gen AI), a plataforma de IA e Machine Learning do Databricks fornece runtimes de ML especializados para AutoML e para codificação de trabalhos de ML. Todos os fluxos de trabalho de MLOps e ciência de dados são mais compatíveis com o MLflow.

Serve

Para casos de uso de DWH e BI, o lakehouse do Databricks fornece o Databricks SQL, o data warehouse desenvolvido com warehouses SQL e warehouses SQL sem servidor.

Para aprendizado de máquina, modelo que atende é uma funcionalidade de serviço de modelo de nível empresarial escalonável, em tempo real, hospedada no plano de controle do Databricks.

Bancos de dados operacionais: sistemas externos, como bancos de dados operacionais, podem ser usados para armazenar e fornecer produtos de dados finais para aplicativos de usuário.

Colaboração: os parceiros comerciais obtêm acesso seguro aos dados necessários por meio de Compartilhamento Delta. Com base no Compartilhamento Delta, o Databricks Marketplace é um fórum aberto para troca de produtos de dados.

Análise

Os últimos aplicativos comerciais estão nesta pista de natação. Exemplos incluem clientes personalizados, como aplicativos de IA conectados ao Mosaic AI Model Serving para inferência em tempo real ou aplicativos que acessam dados enviados por push do lakehouse para um banco de dados operacional.

Para casos de uso de BI, os analistas normalmente usam ferramentas de BI para acessar o data warehouse. Os desenvolvedores de SQL também podem usar o Editor de SQL do Databricks (não mostrado no diagrama) para consultas e painéis.

A Plataforma de Inteligência de Dados também oferece painéis para criar visualizações de dados e compartilhar insights.

Funcionalidades para suas cargas de trabalho

Além disso, o Databricks lakehouse vem com recursos de gerenciamento que dão suporte a todas as cargas de trabalho:

Governança de dados e IA

O sistema central de governança de dados e IA na Plataforma de Inteligência de Dados do Databricks é o Catálogo do Unity. O Catálogo do Unity fornece um único local para gerenciar políticas de acesso a dados que se aplicam a todos os workspaces e dão suporte a todos os ativos criados ou usados no lakehouse, como tabelas, volumes, recursos (repositório de recursos) e modelos (registro de modelo). O Catálogo do Unity também pode ser usado para capturar a linhagem de dados de runtime entre consultas executadas no Databricks.

O monitoramento do Databricks lakehouse permite monitorar a qualidade dos dados em todas as tabelas da sua conta. Ele também pode acompanhar o desempenho de modelos de machine learning e pontos de extremidade que servem modelos.

Para fins de observabilidade, as tabelas do sistema são um armazenamento analítico hospedado no Databricks para os dados operacionais da sua conta. As tabelas do sistema podem ser usadas para observabilidade histórica em sua conta.

Mecanismo de inteligência de dados

A Plataforma de Inteligência de Dados do Databricks permite que toda a sua organização use dados e IA. Ele é alimentado pelo DatabricksIQ e combina IA generativa com os benefícios de unificação de um lakehouse para entender a semântica exclusiva de seus dados.

O Assistente do Databricks está disponível em blocos de anotações do Databricks, no editor do SQL e no editor de arquivos como assistente de IA com reconhecimento de contexto para desenvolvedores.

Orquestração

Os Trabalhos do Databricks orquestram os pipelines de processamento de dados, machine learning e análise de dados na Plataforma de Inteligência de Dados Databricks. As Delta Live Tables permitem que você crie pipelines de ETL confiáveis e passíveis de manutenção com sintaxe declarativa.

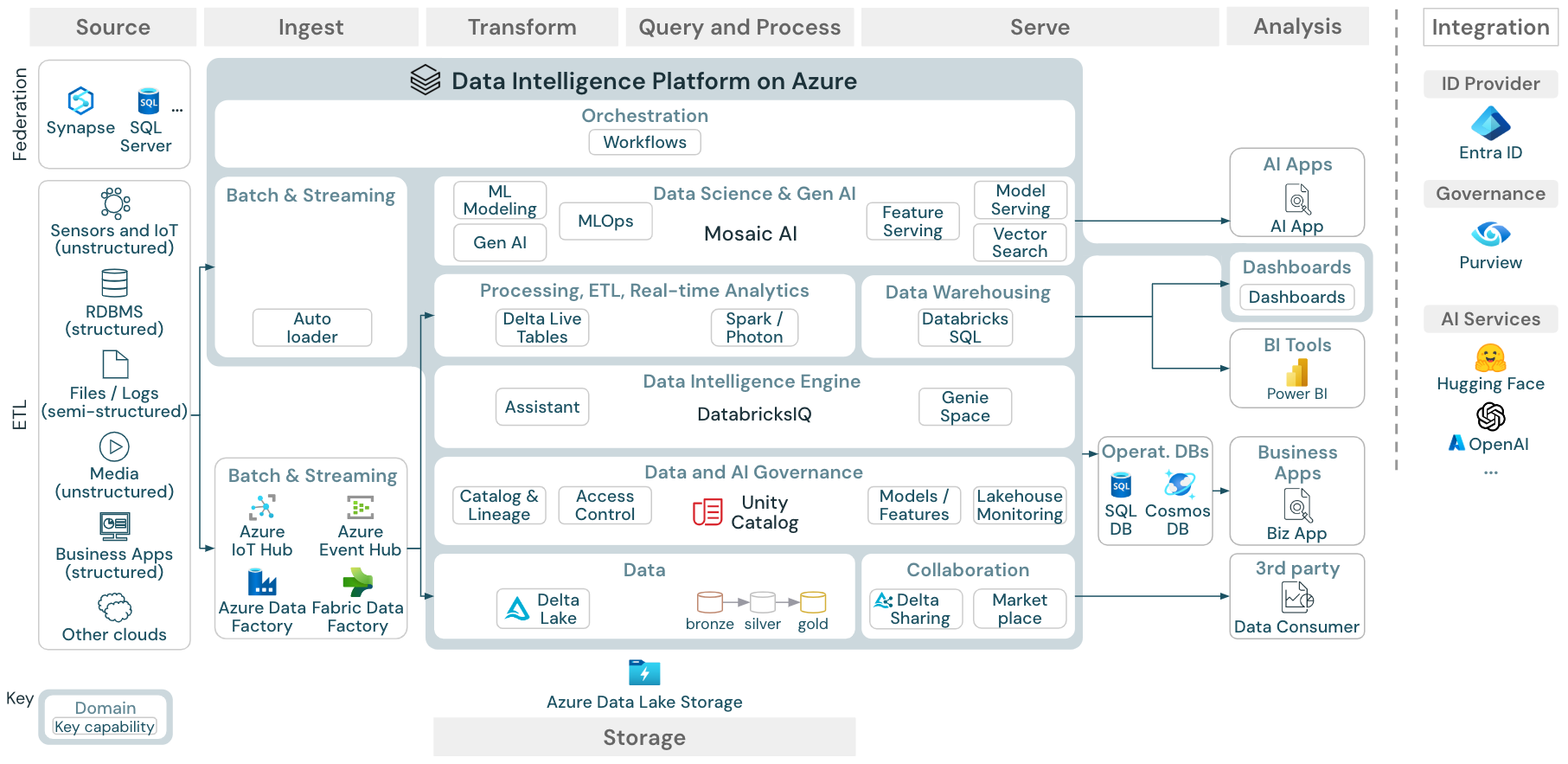

A arquitetura de referência da Plataforma de Inteligência de Dados no Azure

A Arquitetura de Referência do Azure Databricks é derivada da arquitetura de referência genérica adicionando serviços específicos do Azure para os elementos Origem, Ingestão, Serviço, Análise/Saída e Armazenamentos.

Download: Arquitetura de referência para o Databricks lakehouse no Azure

A arquitetura de referência do Azure mostra os seguintes serviços específicos do Azure para Ingestão, Armazenamento, Serviço e Análise/Saída:

- Azure Synapse e SQL Server como sistemas de origem para a Federação lakehouse

- Azure IoT Hub e Azure Event Hubs para ingestão de streaming

- Azure Data Factory para ingestão em lote

- ADLS (Azure Data Lake Storage Gen2) como o armazenamento de objetos

- Banco de dados SQL do Azure e Azure Cosmos DB como bancos de dados operacionais

- Azure Purview como o catálogo empresarial para o qual a UC exportará informações de esquema e linhagem

- Power BI como a ferramenta de BI

Observação

- Essa exibição da arquitetura de referência se concentra apenas nos serviços do Azure e no Databricks Lakehouse. O lakehouse no Databricks é uma plataforma aberta que se integra a um grande ecossistema de ferramentas de parceiros.

- Os serviços do provedor de nuvem mostrados não são exaustivos. Eles são selecionados para ilustrar o conceito.

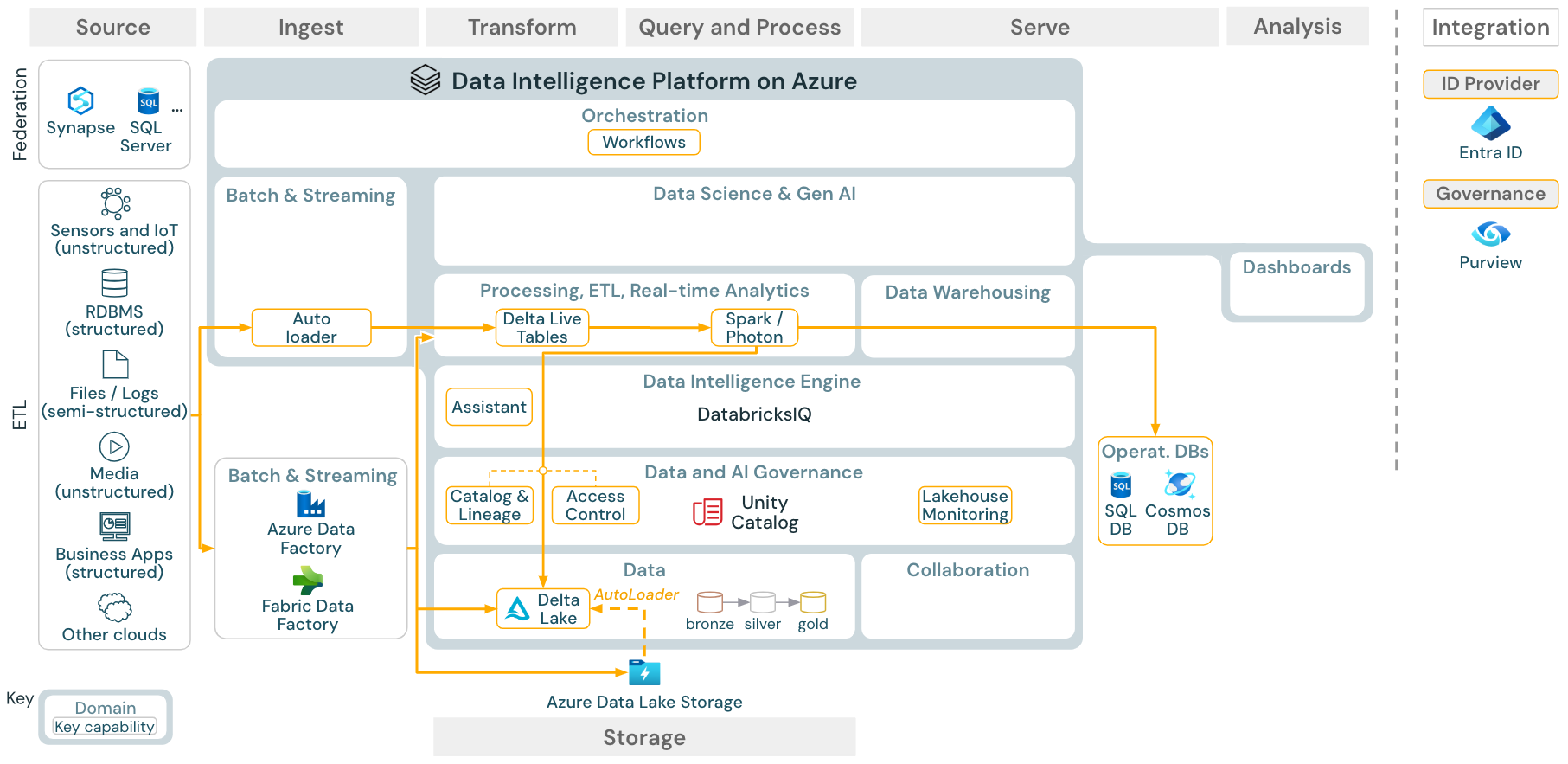

Caso de uso: ETL do Lote

Download: Arquitetura de referência de ETL do Lote para o Azure Databricks

As ferramentas de ingestão usam adaptadores específicos da origem para ler dados da origem e armazená-los no armazenamento em nuvem de onde o Carregador Automático pode lê-los ou chamar o Databricks diretamente (por exemplo, com ferramentas de ingestão de parceiros integradas ao Databricks lakehouse). Para carregar os dados, o ETL do Databricks e o mecanismo de processamento – via DLT – executa as consultas. Fluxos de trabalho isolados ou multitarefa podem ser orquestrados pelos Trabalhos do Databricks e regidos pelo Catálogo do Unity (controle de acesso, auditoria, linhagem etc.). Se sistemas operacionais de baixa latência exigirem acesso a tabelas douradas específicas, eles poderão ser exportados para um banco de dados operacional, como um RDBMS ou repositório chave-valor no final do pipeline etl.

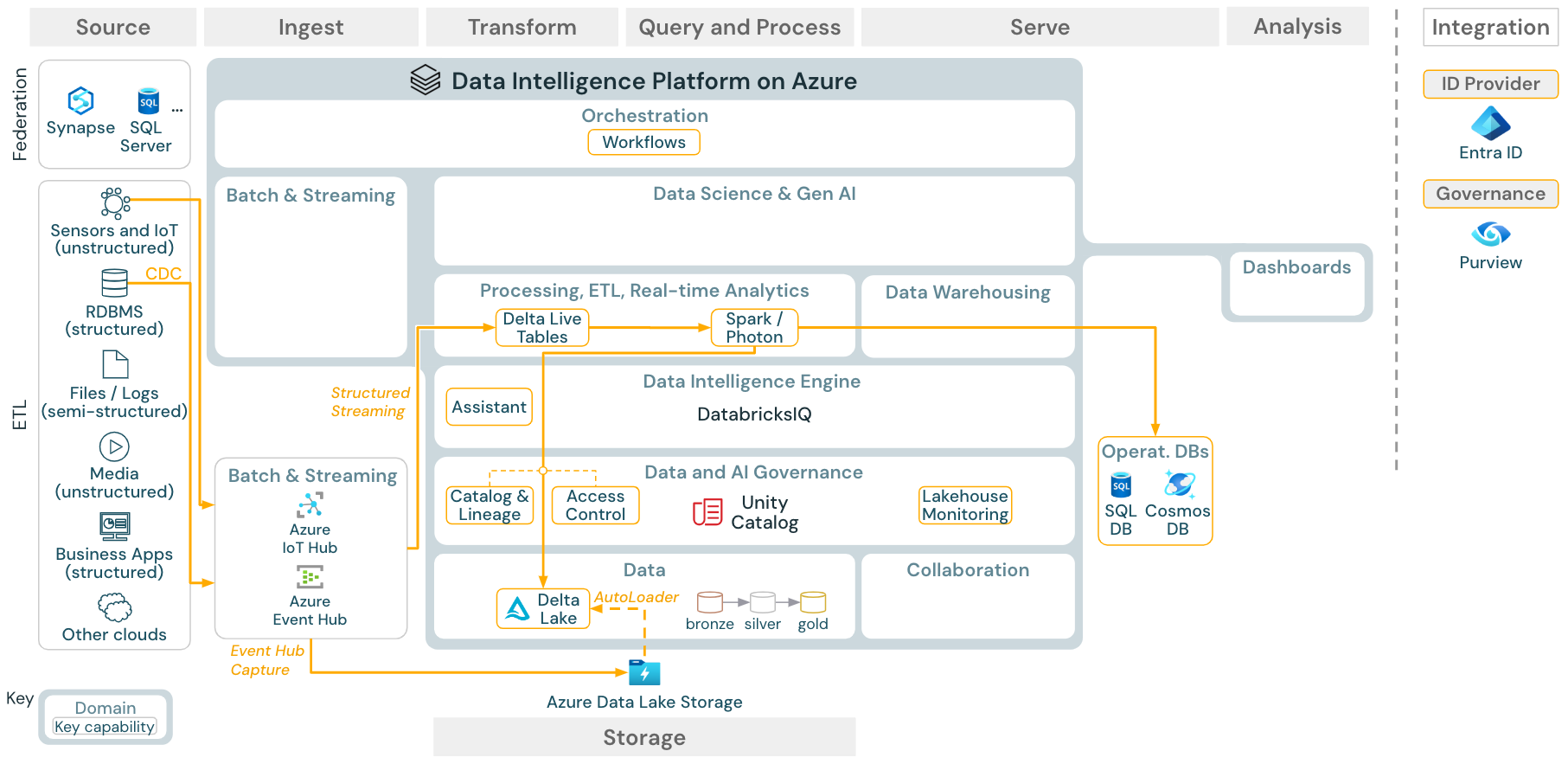

Caso de uso: CDC (captura de dados de streaming e alteração)

Download: Arquitetura de streaming estruturada do Spark para o Azure Databricks

O mecanismo ETL do Databricks usa o Streaming Estruturado do Spark para ler de filas de eventos, como Apache Kafka ou Hub de Eventos do Azure. As etapas downstream seguem a abordagem do caso de uso do Lote acima.

A CDC (captura de dados de alteração em tempo real) normalmente usa uma fila de eventos para armazenar os eventos extraídos. A partir daí, o caso de uso segue o caso de uso de streaming.

Se o CDC for feito em lote em que os registros extraídos são armazenados primeiro no armazenamento em nuvem, o Carregador Automático do Databricks poderá lê-los e o caso de uso seguirá o ETL do Lote.

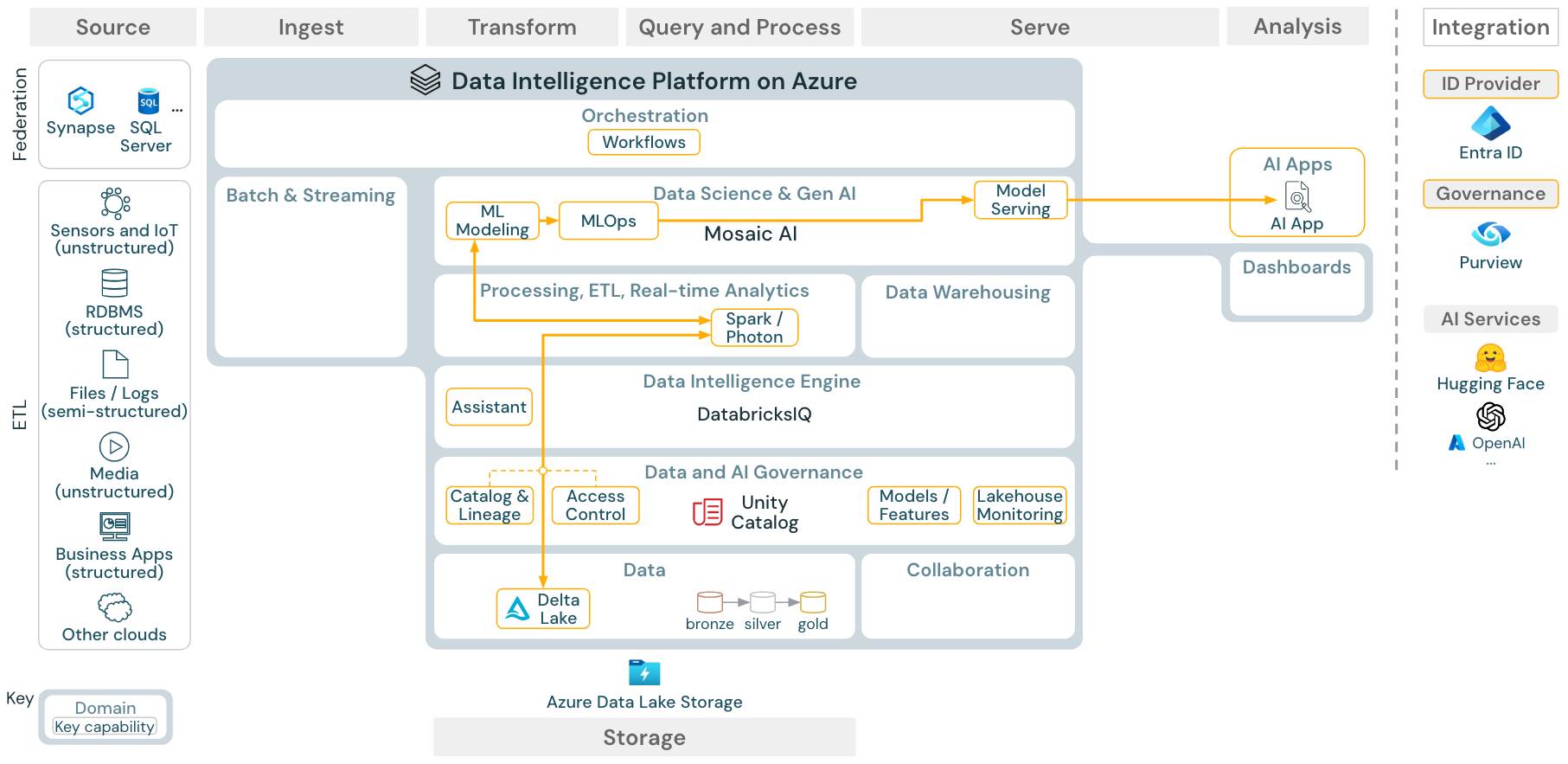

Caso de uso: machine learning e IA

Download: Arquitetura de referência de IA e machine learning para o Azure Databricks

Para aprendizado de máquina, a Plataforma de Inteligência de Dados do Databricks fornece a IA do Mosaico, que vem com bibliotecas de aprendizado profundo e máquina de última geração. Ele fornece recursos como o Repositório de Recursos e o Registro de Modelos (ambos integrados ao Catálogo do Unity), recursos de baixo código com AutoML e integração do MLflow ao ciclo de vida da ciência de dados.

Todos os ativos relacionados a ciência de dados (tabelas, recursos e modelos) são regidos pelo Catálogo do Unity, e os cientistas de dados podem usar Trabalhos do Databricks para orquestrar seus trabalhos.

Para implantar modelos de maneira escalonável e de nível empresarial, use os recursos de MLOps para publicar os modelos no serviço de modelo.

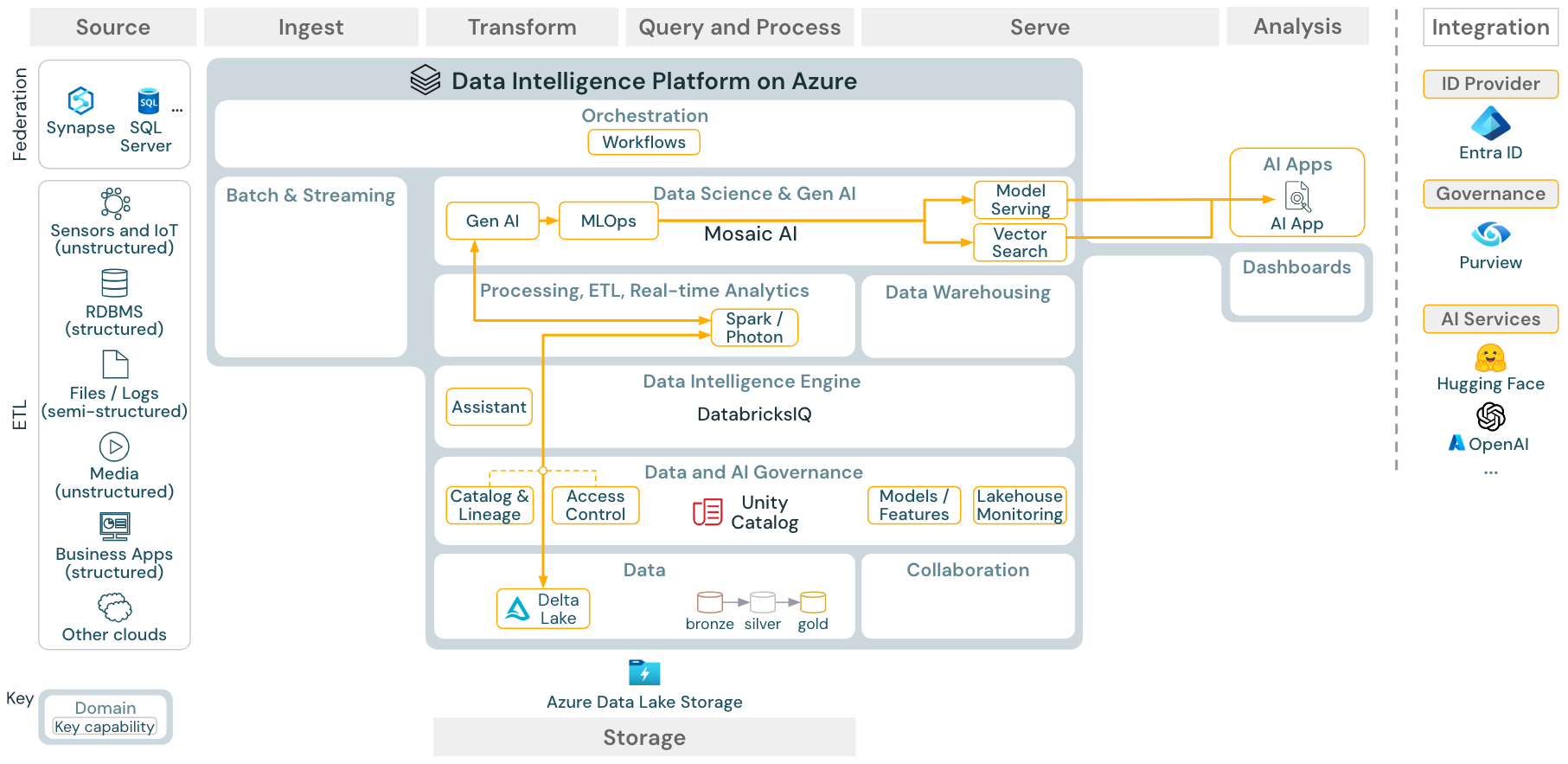

Caso de uso: Recuperação de Geração Aumentada (IA de Geração)

Download: Arquitetura de referência do RAG de IA de geração para o Azure Databricks

Para casos de uso de IA generativos, a IA do Mosaico vem com bibliotecas de última geração e recursos específicos de IA de geração, desde engenharia de prompt até ajuste fino de modelos existentes e pré-treinamento do zero. A arquitetura acima mostra um exemplo de como a busca em vetores pode ser integrada para criar um aplicativo de IA RAG (recuperação de geração aumentada).

Para implantar modelos de maneira escalonável e de nível empresarial, use os recursos de MLOps para publicar os modelos no serviço de modelo.

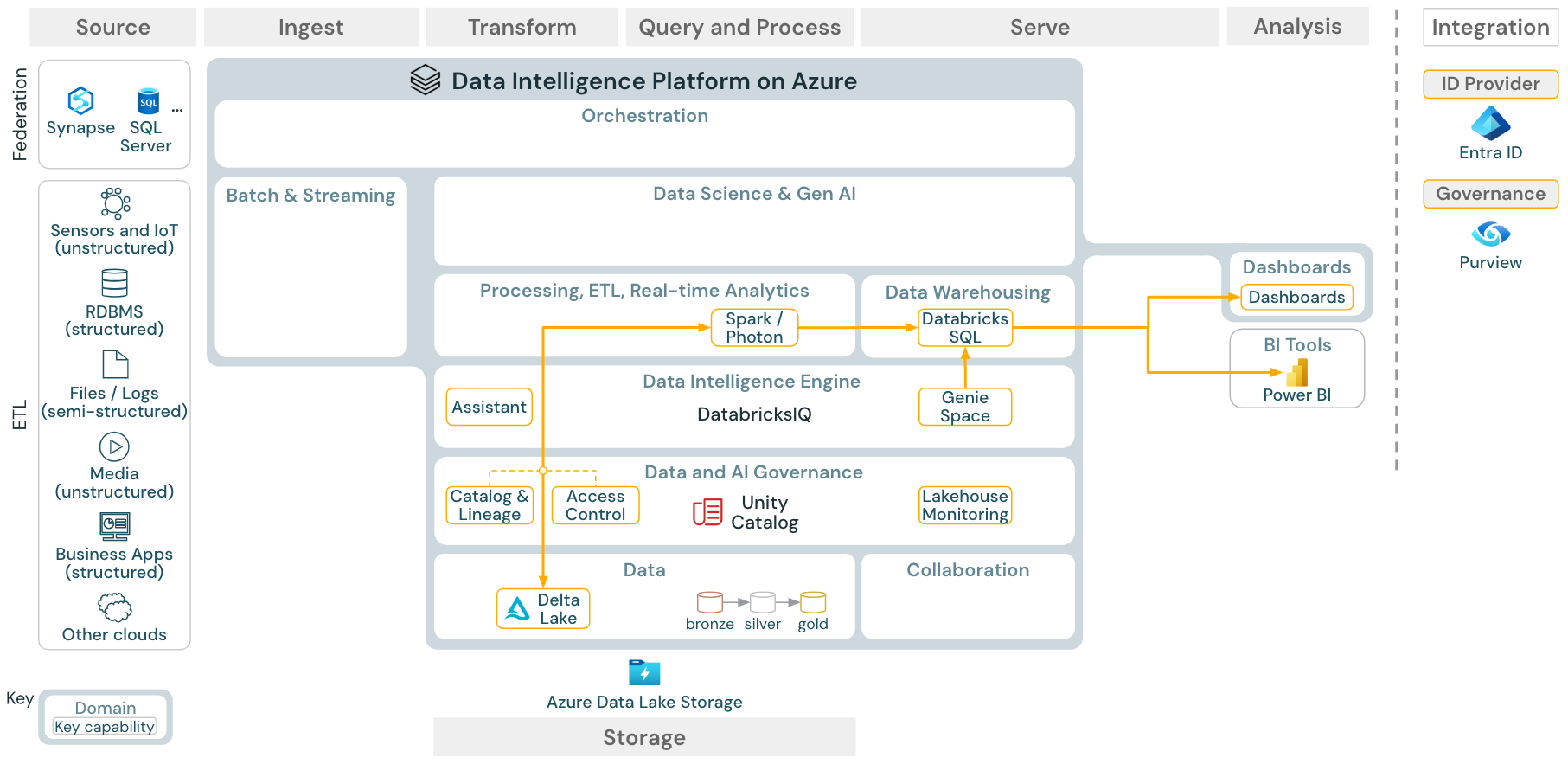

Caso de uso: análise de BI e SQL

Download: arquitetura de referência de análise de BI e SQL para o Azure Databricks

Para casos de uso de BI, os analistas de negócios podem usar painéis, o editor de SQL do Databricks ou ferramentas de BI específicas, como o Tableau ou o Power BI. Em todos os casos, o mecanismo é o DATAbricks SQL (sem servidor ou sem servidor) e a descoberta, exploração e controle de acesso de dados são fornecidos pelo Catálogo do Unity.

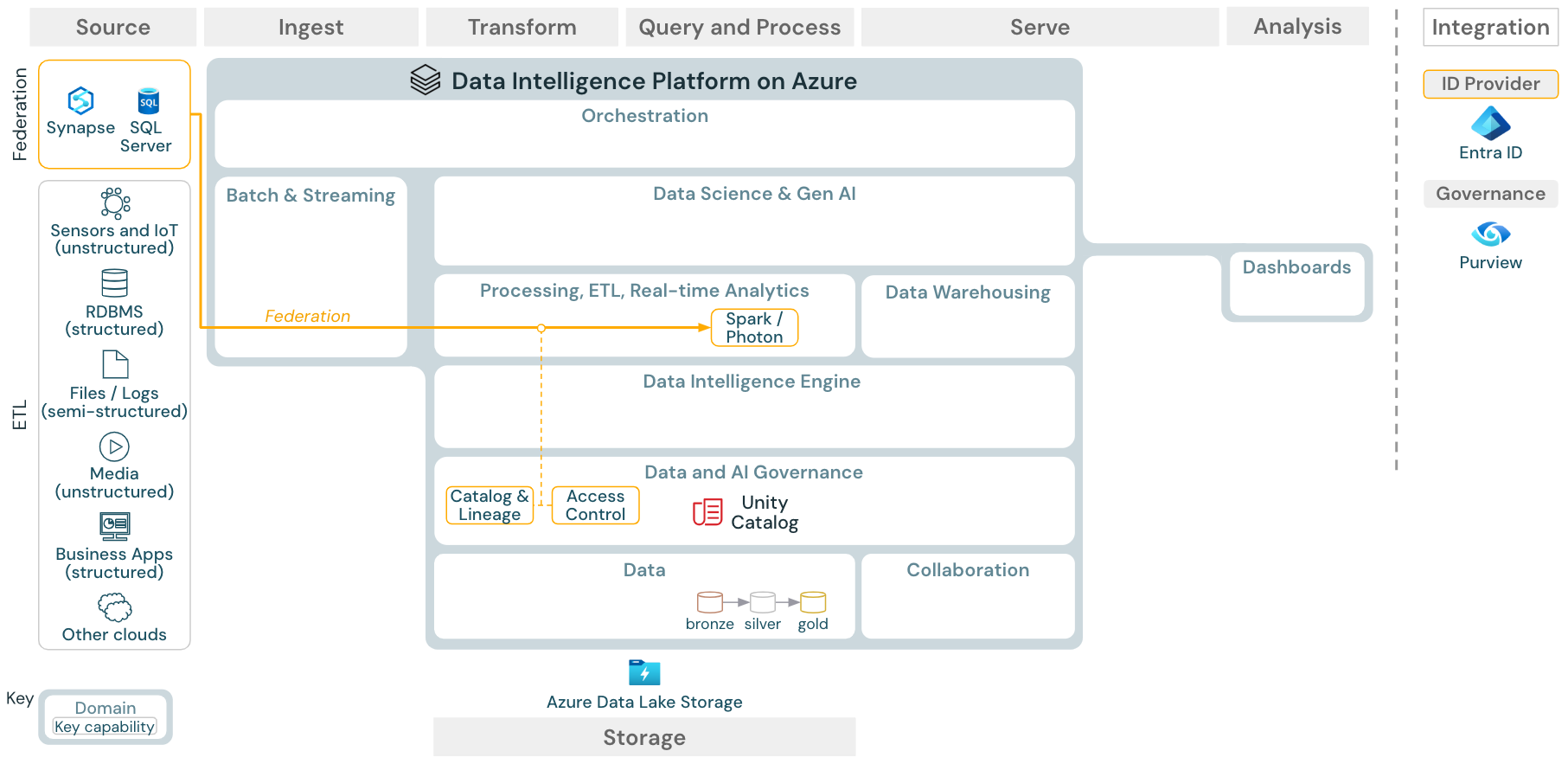

Caso de uso: federação do Lakehouse

Download: Arquitetura de referência de federação do Lakehouse para o Azure Databricks

A federação do Lakehouse permite que bancos de dados externos SQL (como MySQL, Postgres, SQL Server ou Azure Synapse) sejam integrados ao Databricks.

Todas as cargas de trabalho (IA, DWH e BI) podem se beneficiar disso sem a necessidade de ETL dos dados no armazenamento de objetos primeiro. O catálogo de origem externa é mapeado para o catálogo do Unity e o controle de acesso refinado pode ser aplicado ao acesso por meio da plataforma Databricks.

Caso de uso: Compartilhamento de dados corporativos

O compartilhamento de dados de nível empresarial é fornecido pelo Compartilhamento Delta. Ele fornece acesso direto aos dados no repositório de objetos protegido pelo Catálogo do Unity e o Databricks Marketplace é um fórum aberto para troca de produtos de dados.