Como usar o Conector Flink/Delta

Observação

Desativaremos o Microsoft Azure HDInsight no AKS em 31 de janeiro de 2025. Para evitar o encerramento abrupto das suas cargas de trabalho, você precisará migrá-las para o Microsoft Fabric ou para um produto equivalente do Azure antes de 31 de janeiro de 2025. Os clusters restantes em sua assinatura serão interrompidos e removidos do host.

Somente o suporte básico estará disponível até a data de desativação.

Importante

Esse recurso está atualmente na visualização. Os Termos de uso complementares para versões prévias do Microsoft Azure incluem mais termos legais que se aplicam aos recursos do Azure que estão em versão beta, em versão prévia ou ainda não lançados em disponibilidade geral. Para obter informações sobre essa versão prévia específica, confira Informações sobre a versão prévia do Azure HDInsight no AKS. No caso de perguntas ou sugestões de recursos, envie uma solicitação no AskHDInsight com os detalhes e siga-nos para ver mais atualizações sobre a Comunidade do Azure HDInsight.

Usando o Apache Flink e o Delta Lake juntos, você pode criar uma arquitetura confiável e escalonável do data lakehouse. O Conector Flink/Delta permite gravar dados em tabelas Delta com transações ACID e durante o processamento. Isso significa que os fluxos de dados são consistentes e sem erros, mesmo se você reiniciar o pipeline do Flink de um ponto de verificação. O Conector Flink/Delta garante que seus dados não sejam perdidos ou duplicados e que correspondam à semântica do Flink.

Neste artigo, você aprenderá a usar o conector Flink/Delta.

- Leia os dados da tabela delta.

- Grave os dados em uma tabela delta.

- Consulte no Power BI.

O que é o conector Flink/Delta

O Conector Flink/Delta é uma biblioteca JVM para ler e gravar dados de aplicativos Apache Flink em tabelas Delta utilizando a biblioteca JVM autônoma Delta. O conector fornece garantias de entrega exatamente uma vez.

O Conector Flink/Delta inclui:

DeltaSink para gravar dados do Apache Flink em uma tabela Delta. DeltaSource para ler tabelas Delta usando o Apache Flink.

O Conector Apache Flink/Delta inclui:

Dependendo da versão do conector, você pode usá-lo com as seguintes versões do Apache Flink:

Connector's version Flink's version

0.4.x (Sink Only) 1.12.0 <= X <= 1.14.5

0.5.0 1.13.0 <= X <= 1.13.6

0.6.0 X >= 1.15.3

0.7.0 X >= 1.16.1 --- We use this in Flink 1.17.0

Pré-requisitos

- Cluster do HDInsight Flink 1.17.0 no AKS

- Conector Flink/Delta 0.7.0

- Usar o MSI para acessar o ADLS Gen2

- IntelliJ para desenvolvimento

Ler dados da tabela delta

A Origem do Delta pode funcionar em um desses dois modos, descritos como se segue.

Modo Limitado, adequado para trabalhos em lote, sempre que quisermos ler o conteúdo da tabela Delta somente para a versão específica de uma tabela. Crie uma origem para esse modo usando a API DeltaSource.forBoundedRowData.

Modo Contínuo, adequado para trabalhos de fluxo de dados, sempre que quisermos verificar continuamente a tabela Delta para detectar novas alterações e versões. Crie uma origem para esse modo usando a API DeltaSource.forContinuousRowData.

Exemplo: criação de uma origem para a tabela Delta, para ler todas as colunas no modo limitado. Adequado para trabalhos em lote. Esse exemplo carrega a versão de tabela mais recente.

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.core.fs.Path;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.data.RowData;

import org.apache.hadoop.conf.Configuration;

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// Define the source Delta table path

String deltaTablePath_source = "abfss://container@account_name.dfs.core.windows.net/data/testdelta";

// Create a bounded Delta source for all columns

DataStream<RowData> deltaStream = createBoundedDeltaSourceAllColumns(env, deltaTablePath_source);

public static DataStream<RowData> createBoundedDeltaSourceAllColumns(

StreamExecutionEnvironment env,

String deltaTablePath) {

DeltaSource<RowData> deltaSource = DeltaSource

.forBoundedRowData(

new Path(deltaTablePath),

new Configuration())

.build();

return env.fromSource(deltaSource, WatermarkStrategy.noWatermarks(), "delta-source");

}

Gravando no coletor Delta

Atualmente, o Coletor Delta expõe as seguintes métricas do Flink:

Criação de um coletor para tabelas não particionadas

Nesse exemplo, mostramos como criar um DeltaSink e conectá-lo a um org.apache.flink.streaming.api.datastream.DataStream existente.

import io.delta.flink.sink.DeltaSink;

import org.apache.flink.core.fs.Path;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.table.data.RowData;

import org.apache.flink.table.types.logical.RowType;

import org.apache.hadoop.conf.Configuration;

// Define the sink Delta table path

String deltaTablePath_sink = "abfss://container@account_name.dfs.core.windows.net/data/testdelta_output";

// Define the source Delta table path

RowType rowType = RowType.of(

DataTypes.STRING().getLogicalType(), // Date

DataTypes.STRING().getLogicalType(), // Time

DataTypes.STRING().getLogicalType(), // TargetTemp

DataTypes.STRING().getLogicalType(), // ActualTemp

DataTypes.STRING().getLogicalType(), // System

DataTypes.STRING().getLogicalType(), // SystemAge

DataTypes.STRING().getLogicalType() // BuildingID

);

createDeltaSink(deltaStream, deltaTablePath_sink, rowType);

public static DataStream<RowData> createDeltaSink(

DataStream<RowData> stream,

String deltaTablePath,

RowType rowType) {

DeltaSink<RowData> deltaSink = DeltaSink

.forRowData(

new Path(deltaTablePath),

new Configuration(),

rowType)

.build();

stream.sinkTo(deltaSink);

return stream;

}

Código completo

Leia dados de um coletor e tabela delta para outra tabela delta.

package contoso.example;

import io.delta.flink.sink.DeltaSink;

import io.delta.flink.source.DeltaSource;

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.core.fs.Path;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.DataTypes;

import org.apache.flink.table.data.RowData;

import org.apache.flink.table.types.logical.RowType;

import org.apache.hadoop.conf.Configuration;

public class DeltaSourceExample {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// Define the sink Delta table path

String deltaTablePath_sink = "abfss://container@account_name.dfs.core.windows.net/data/testdelta_output";

// Define the source Delta table path

String deltaTablePath_source = "abfss://container@account_name.dfs.core.windows.net/data/testdelta";

// Define the source Delta table path

RowType rowType = RowType.of(

DataTypes.STRING().getLogicalType(), // Date

DataTypes.STRING().getLogicalType(), // Time

DataTypes.STRING().getLogicalType(), // TargetTemp

DataTypes.STRING().getLogicalType(), // ActualTemp

DataTypes.STRING().getLogicalType(), // System

DataTypes.STRING().getLogicalType(), // SystemAge

DataTypes.STRING().getLogicalType() // BuildingID

);

// Create a bounded Delta source for all columns

DataStream<RowData> deltaStream = createBoundedDeltaSourceAllColumns(env, deltaTablePath_source);

createDeltaSink(deltaStream, deltaTablePath_sink, rowType);

// Execute the Flink job

env.execute("Delta datasource and sink Example");

}

public static DataStream<RowData> createBoundedDeltaSourceAllColumns(

StreamExecutionEnvironment env,

String deltaTablePath) {

DeltaSource<RowData> deltaSource = DeltaSource

.forBoundedRowData(

new Path(deltaTablePath),

new Configuration())

.build();

return env.fromSource(deltaSource, WatermarkStrategy.noWatermarks(), "delta-source");

}

public static DataStream<RowData> createDeltaSink(

DataStream<RowData> stream,

String deltaTablePath,

RowType rowType) {

DeltaSink<RowData> deltaSink = DeltaSink

.forRowData(

new Path(deltaTablePath),

new Configuration(),

rowType)

.build();

stream.sinkTo(deltaSink);

return stream;

}

}

pom.xml do Maven

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>contoso.example</groupId>

<artifactId>FlinkDeltaDemo</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<flink.version>1.17.0</flink.version>

<java.version>1.8</java.version>

<scala.binary.version>2.12</scala.binary.version>

<hadoop-version>3.3.4</hadoop-version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-streaming-java -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-clients -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>io.delta</groupId>

<artifactId>delta-standalone_2.12</artifactId>

<version>3.0.0</version>

</dependency>

<dependency>

<groupId>io.delta</groupId>

<artifactId>delta-flink</artifactId>

<version>3.0.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-parquet</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>${hadoop-version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-runtime</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

<version>3.0.0</version>

<configuration>

<appendAssemblyId>false</appendAssemblyId>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

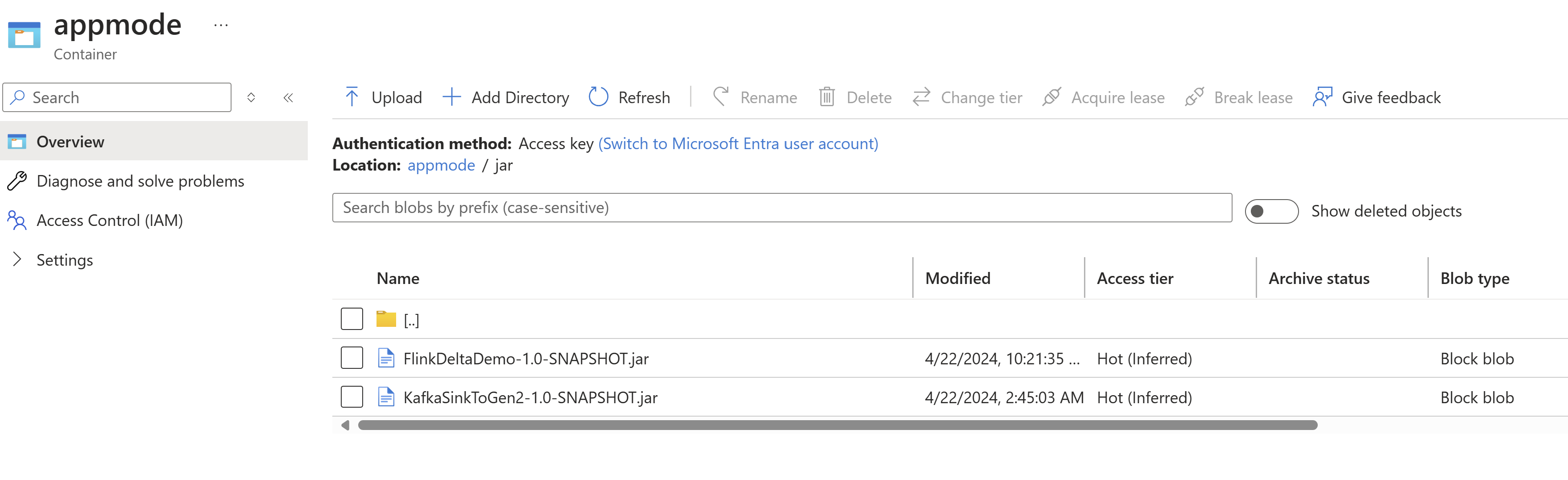

Empacotar o JAR e enviá-lo para o cluster Flink para ser executado

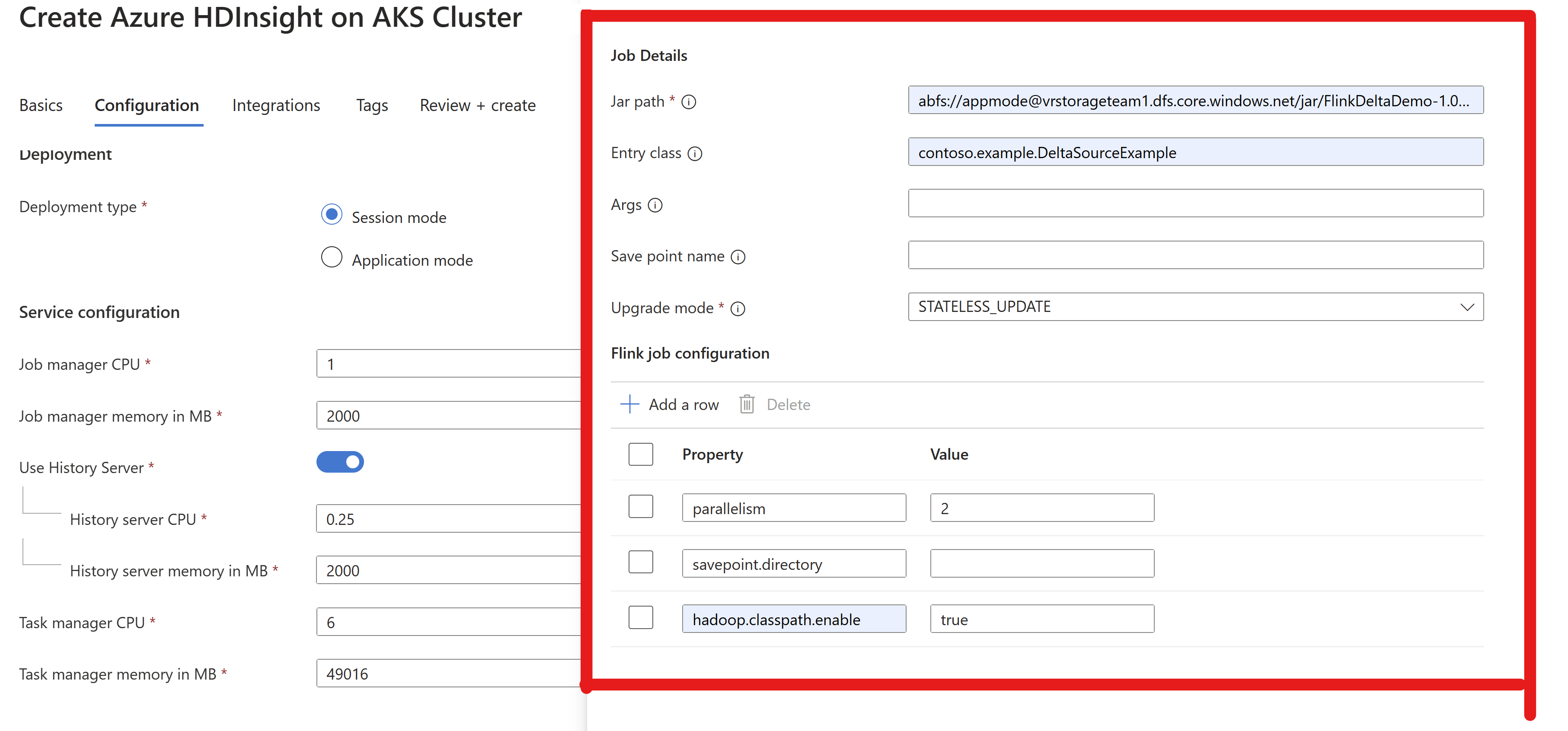

Passe as informações do jar do trabalho no cluster AppMode.

Observação

Sempre habilite

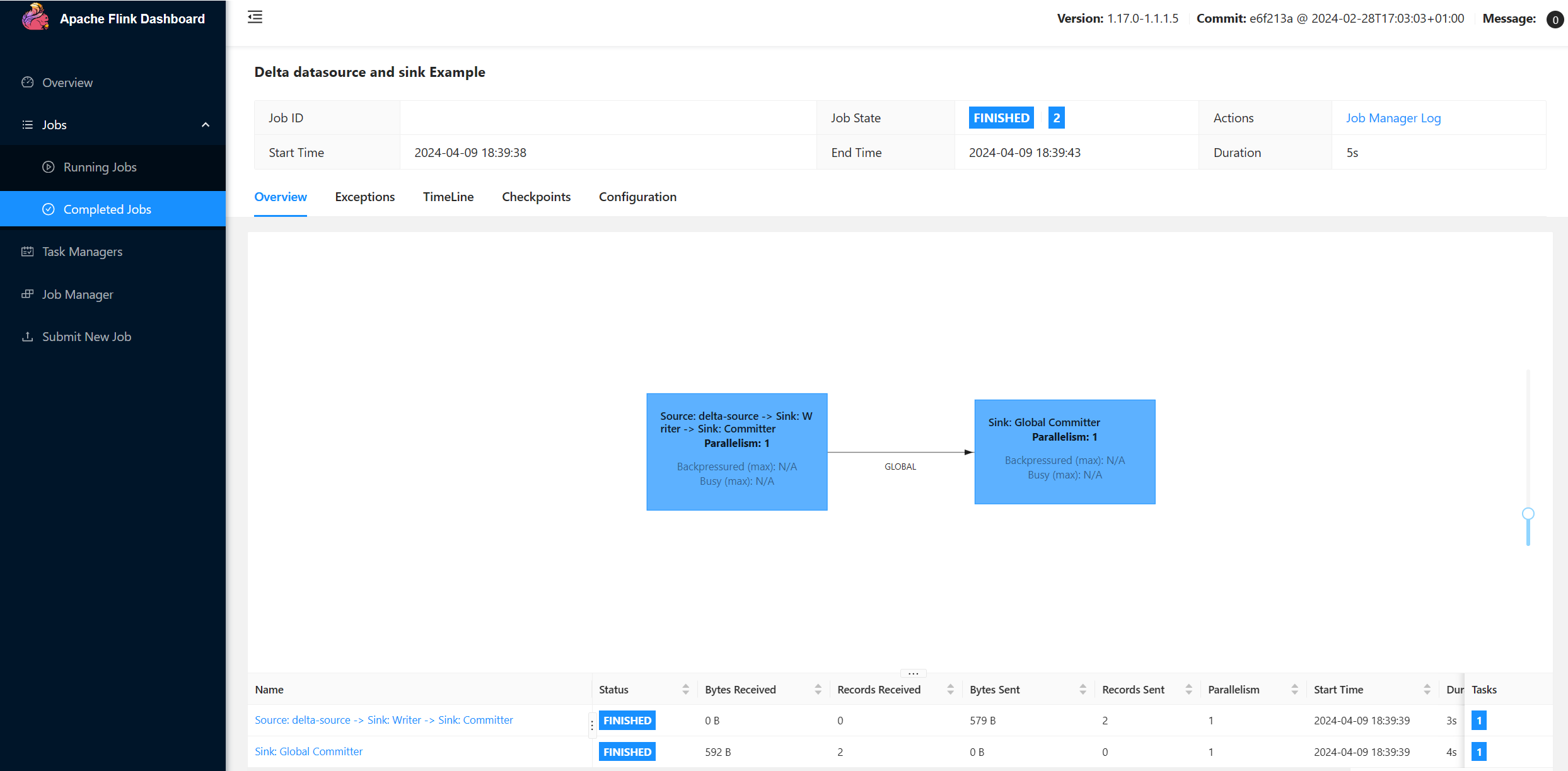

hadoop.classpath.enabledurante a leitura/gravação no ADLS.Envie o cluster e você poderá ver o trabalho na interface do usuário do Flink.

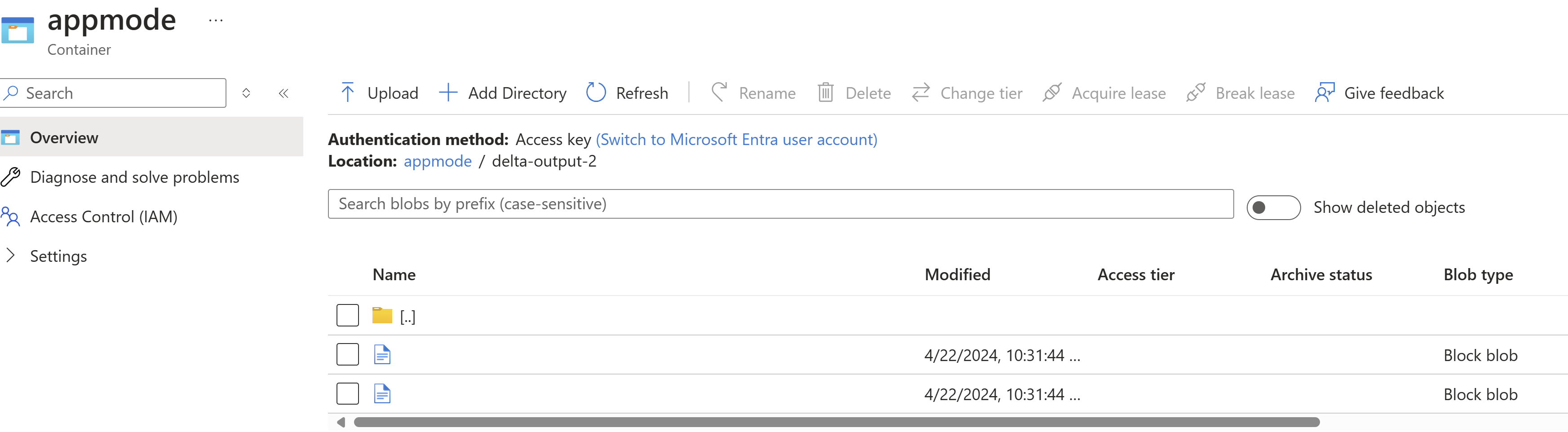

Localizar resultados no ADLS.

Integração do Power BI

Depois que os dados estiverem no coletor delta, você poderá executar a consulta no Power BI Desktop e criar um relatório.

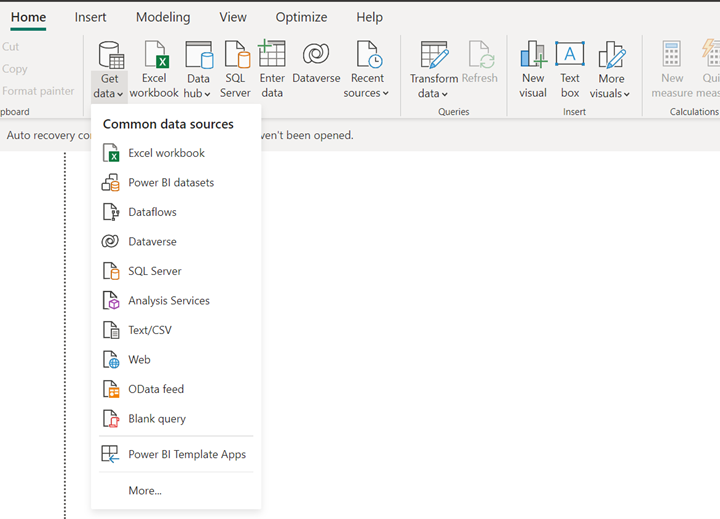

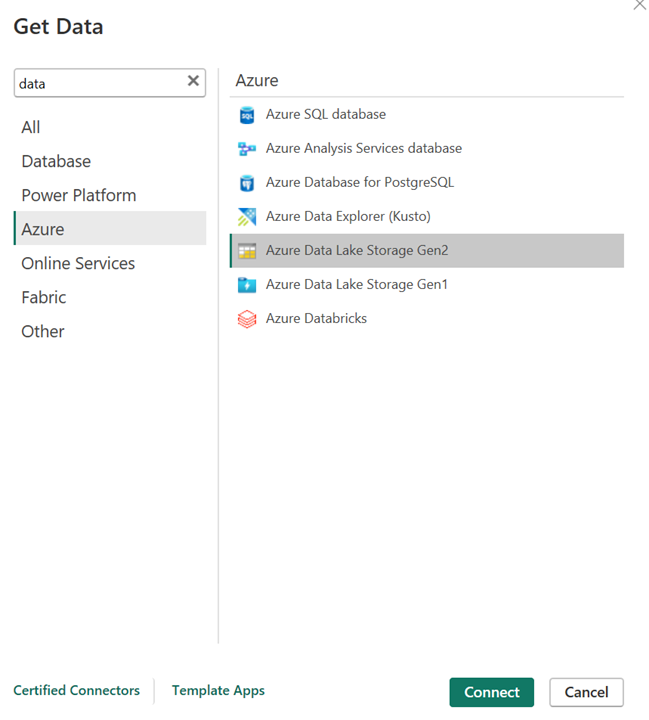

Abra a área de trabalho do Power BI e obtenha os dados usando o conector do ADLS Gen2.

URL da conta de armazenamento.

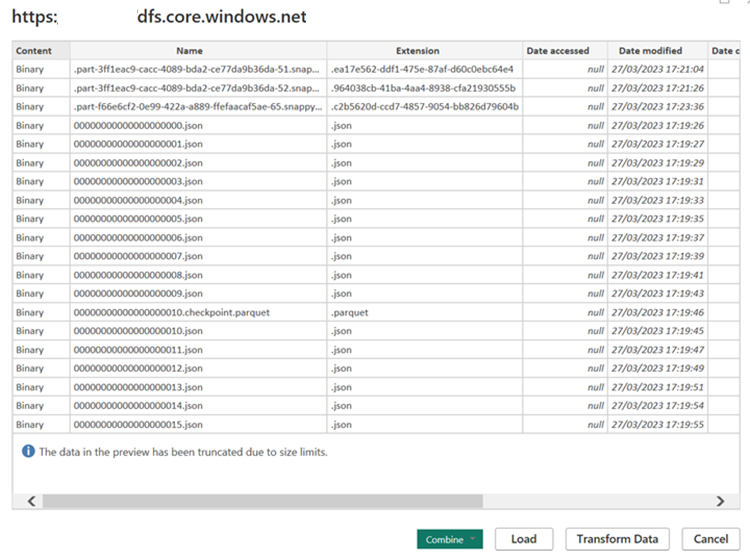

Crie uma consulta M para a origem e invoque a função, que consulta os dados da conta de armazenamento.

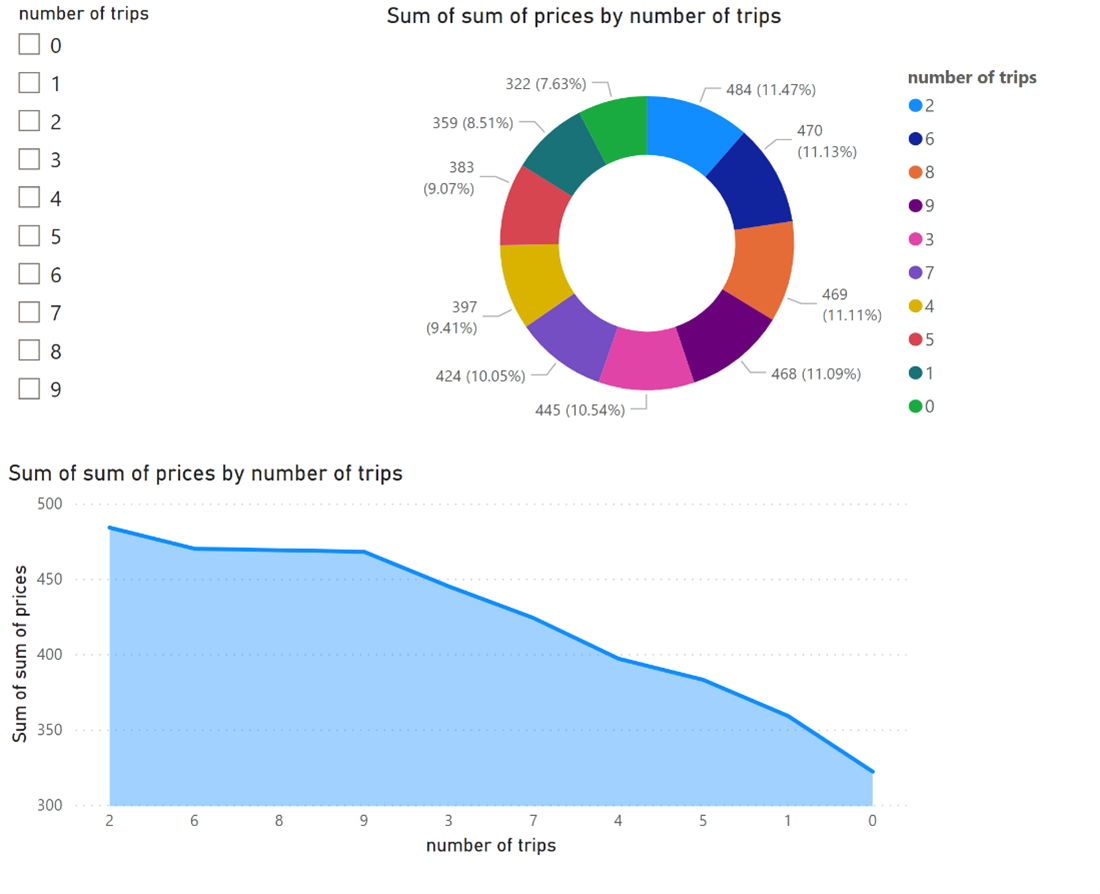

Depois que os dados estiverem prontamente disponíveis, você poderá criar relatórios.

Referências

- Apache, Apache Flink, Flink e nomes de projetos de código aberto associados são marcas registradas da Apache Software Foundation (ASF).