Monitoramento de detalhes do aplicativo Apache Spark

Com o Microsoft Fabric, você pode utilizar o Apache Spark para executar notebooks, trabalhos e outros tipos de aplicativos em seu espaço de trabalho. Este artigo explica como monitorar seu aplicativo Apache Spark, permitindo que você fique de olho no status de execução recente, nos problemas e no progresso de seus trabalhos.

Exibir aplicativos Apache Spark

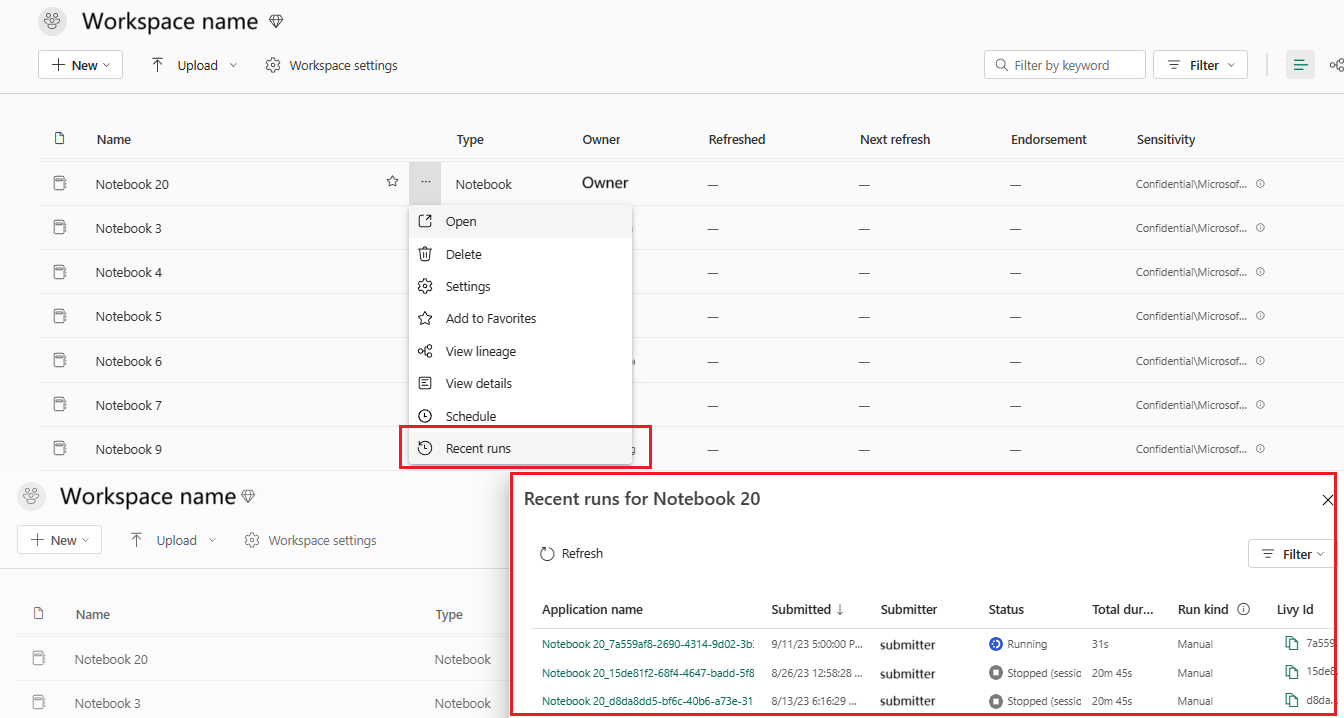

É possível fazer a exibição de todos os aplicativos Apache Spark na definição de trabalho do Spark ou no menu de contexto do item do notebook que mostra a opção de execução recente ->Execuções recentes.

É possível selecionar o nome do aplicativo que deseja exibir na lista de aplicativos; na página de detalhes do aplicativo, é possível exibir os detalhes do aplicativo.

Monitorar o status do aplicativo do Apache Spark

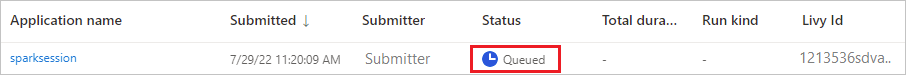

Abra a página de Execuções recentes da definição de trabalho do Spark ou do notebook para exibir o status do aplicativo Apache.

- Sucesso

- Em espera

- Interrompido

- Canceled

- Com falha

Trabalhos

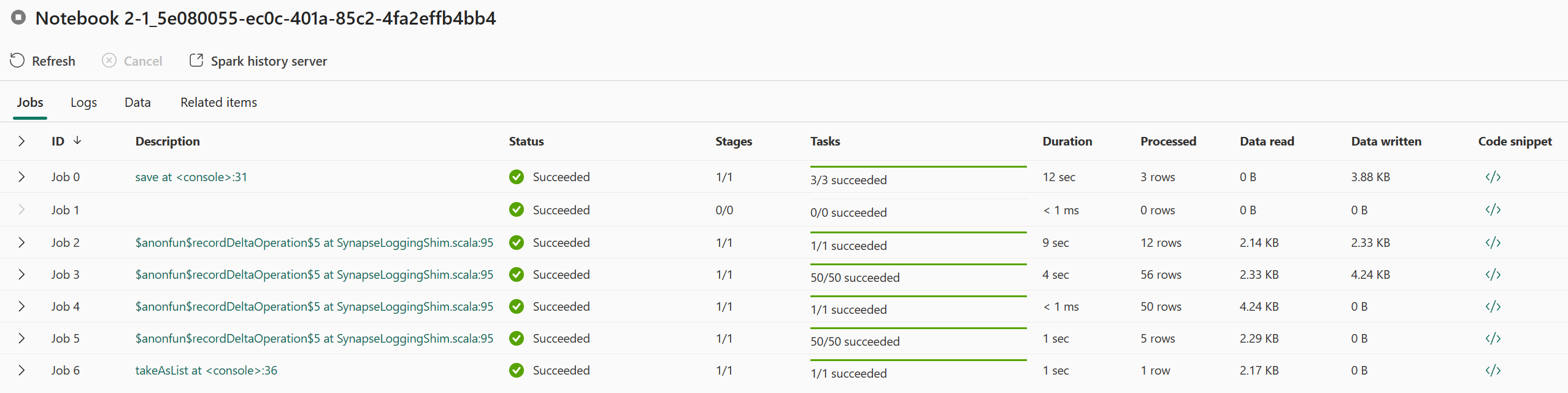

Abrir um trabalho do aplicativo Apache Spark no menu de contexto do item Definição do trabalho do Spark ou notebook mostra a opção Execução recente ->Execução recente -> selecionar um trabalho na página de execuções recentes.

Na página de detalhes do monitoramento do aplicativo Apache Spark, a lista de execuções do trabalho é exibida na guia Trabalhos, e é possível exibir os detalhes de cada trabalho aqui, incluindo ID do Trabalho, Descrição, Estado, Estágios, Tarefas, Duração, Processado, Dados lidos, Dados gravados e Snippet de código.

- Clicar na ID do trabalho pode expandir/colapsar o trabalho.

- Clique na descrição do trabalho e você poderá ir para a página do trabalho ou do estágio na interface do usuário do Spark.

- Clique no snippet do código do trabalho para verificar e copiar o código relacionado a esse trabalho.

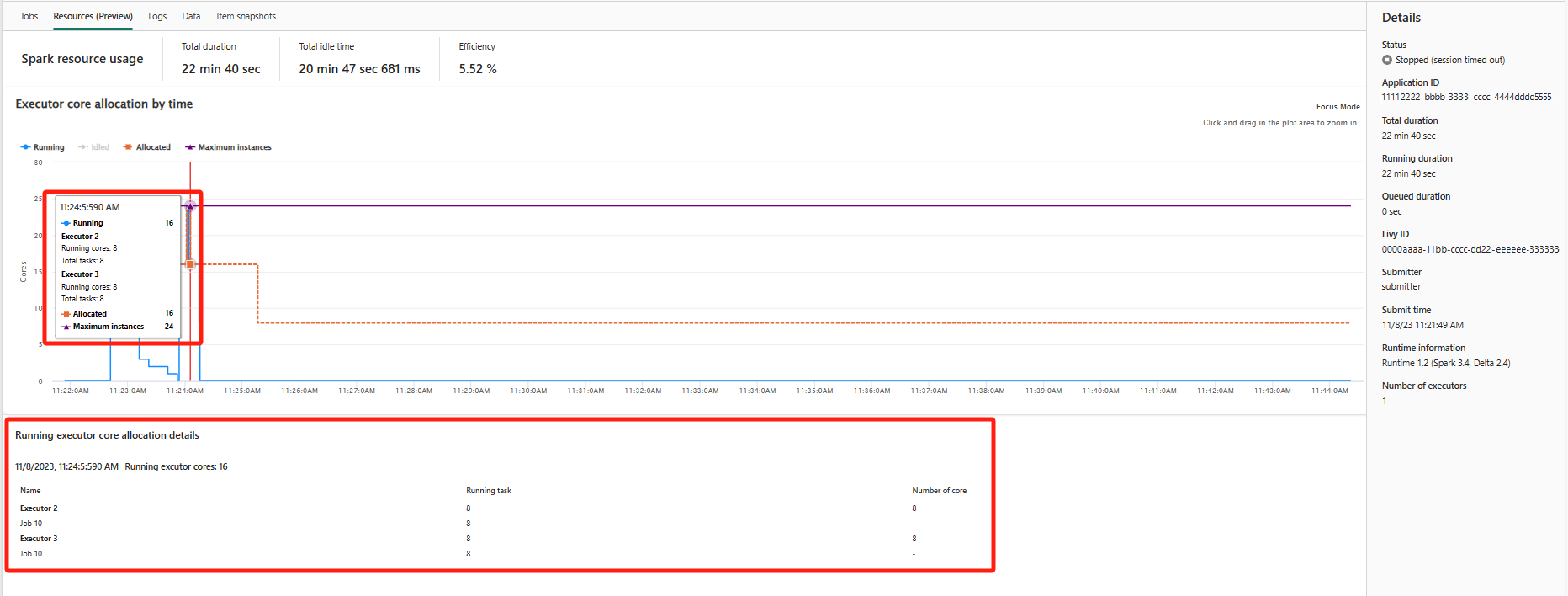

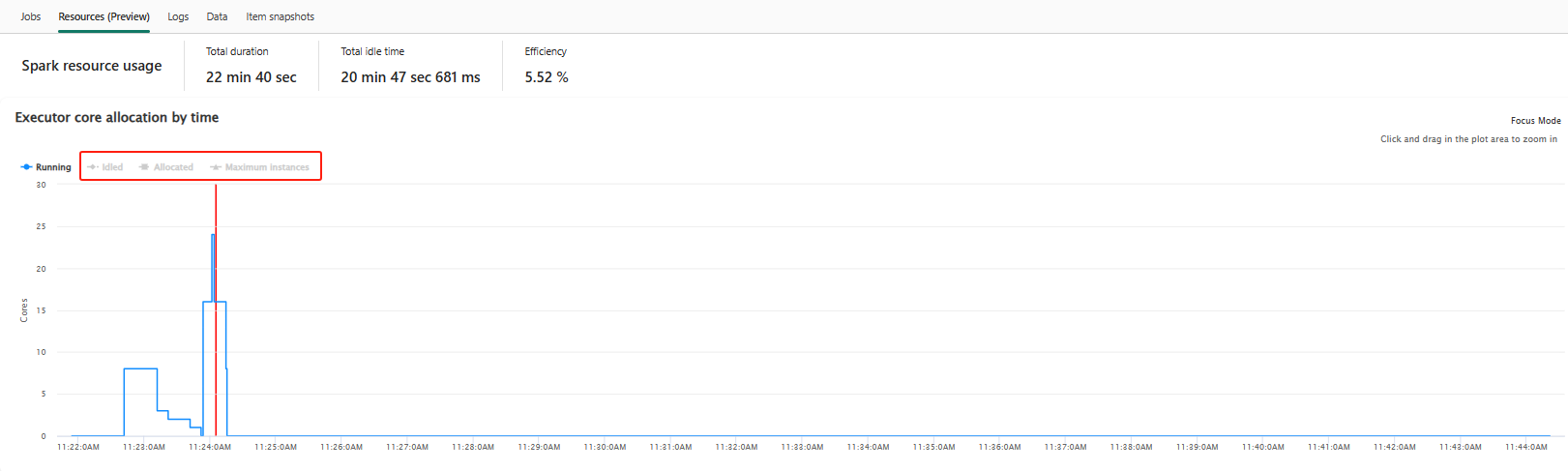

Recursos (versão prévia)

O grafo de uso do executor exibe visualmente a alocação de executores de trabalho do Spark e o uso de recursos. Atualmente, somente as informações de runtime do Spark 3.4 e superior exibirão esse recurso. Selecione Recursos (versão prévia) e, em seguida, quatro tipos de curvas sobre o uso do executor são redigidos, incluindo Em execução, Ocioso, Alocado, Máximo de instâncias.

Para Alocado, refere-se à situação principal alocada durante a execução do aplicativo Spark.

Para Instâncias máximas, refere-se ao número máximo de núcleos alocados para o aplicativo Spark.

Para Execução, refere-se ao número real de núcleos usados pelo aplicativo Spark quando ele está em execução. Clique em um ponto no tempo enquanto o aplicativo Spark está em execução. Você pode ver os detalhes de alocação do núcleo do executor em execução na parte inferior do grafo.

Para Idled, é o número de núcleos não utilizados enquanto o aplicativo Spark está em execução.

Em alguns casos, em algum momento, o número de tarefas pode exceder a capacidade dos núcleos do executor (ou seja, números de tarefa > total de núcleos do executor / spark.task.cpus). Isso é o esperado, pois há um intervalo de tempo entre uma tarefa ser marcada como em execução e ela estar realmente em execução em um núcleo do executor. Portanto, algumas tarefas podem ser mostradas como em execução, mas não estar sendo executadas em nenhum núcleo.

Selecione o ícone de cor para selecionar ou desmarcar o conteúdo correspondente em todo o grafo.

Painel do resumo

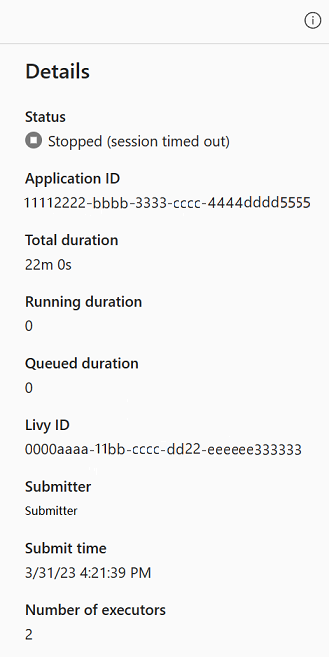

Na página de monitoramento do aplicativo Apache Spark, clique no botão Propriedades para abrir/recolher o painel de resumo. Você pode exibir os detalhes desse aplicativo em Detalhes.

- Status desse aplicativo do Spark.

- A ID desse aplicativo do Spark.

- Duração total.

- Duração da execução desse aplicativo do Spark.

- Duração da fila para esse aplicativo do Spark.

- ID do Livy

- Remetente desse aplicativo do Spark.

- Tempo de envio para este aplicativo do Spark.

- Número de executores.

Logs

Na guia Logs, é possível exibir o registro completo de Livy, Prelaunch, Driver log com diferentes opções selecionadas no painel esquerdo. E você pode recuperar diretamente as informações de log exigidas pesquisando palavras-chave e exibir os logs filtrando o status do log. Clique em Baixar Log para baixar as informações do log para o local.

Às vezes, não há logs disponíveis, como, por exemplo, o status do trabalho está na fila e a criação do cluster falhou.

Os logs ao vivo só estão disponíveis quando o envio do aplicativo falha, e os registros do driver também são fornecidos.

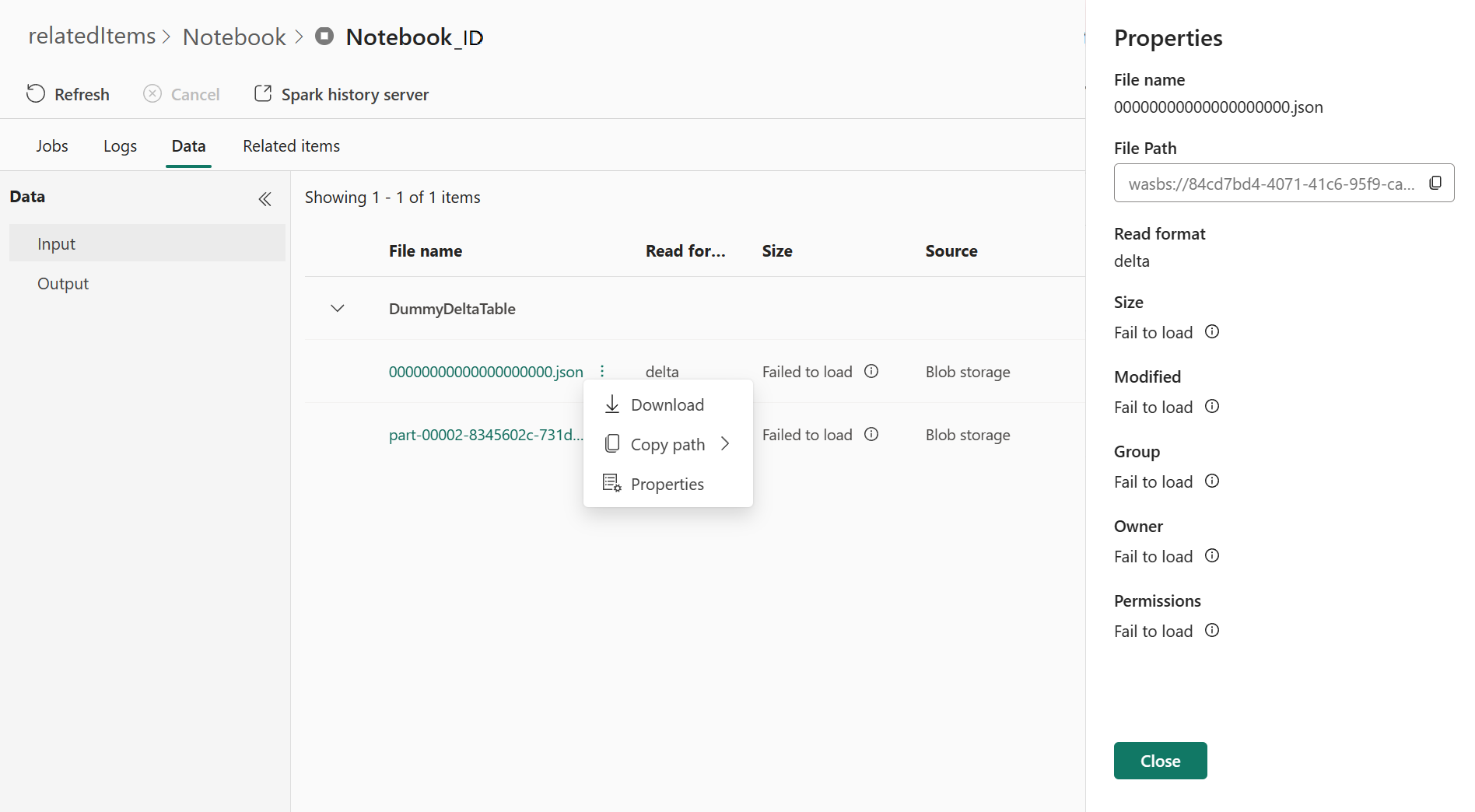

Dados

Na guia Dados, é possível copiar a lista de dados na área de transferência, fazer download da lista de dados e dos dados individuais e verificar as propriedades de cada dado.

- O painel esquerdo pode ser expandido ou recolhido.

- O nome, o formato da leitura, o tamanho, a origem e o caminho dos arquivos de entrada e saída serão exibidos nessa lista.

- É possível fazer download dos arquivos de entrada e saída, copiar o caminho e exibir as propriedades.

Itens relacionados

A guia Itens relacionados permite navegar e exibir os itens associados ao aplicativo Apache Spark, incluindo Notebooks, definição de trabalho do Spark e/ou Pipelines. A página de itens relacionados exibe o instantâneo do código e os valores dos parâmetros no tempo de execução dos notebooks. Ela também mostra o instantâneo de todas as configurações e parâmetros no momento do envio para as definições de trabalho do Spark. Se o aplicativo Apache Spark estiver associado a um pipeline, a página de itens relacionados também apresentará o pipeline correspondente e a atividade do Spark.

Na tela Itens Relacionados, você pode:

- Procurar e navegar pelos itens relacionados na árvore hierárquica.

- Clique no ícone de elipse "Uma lista de mais ações" para cada item para realizar ações diferentes.

- Clicar no item do instantâneo para exibir seu conteúdo.

- Exiba o Breadcrumb para conferir o caminho do item selecionado até a raiz.

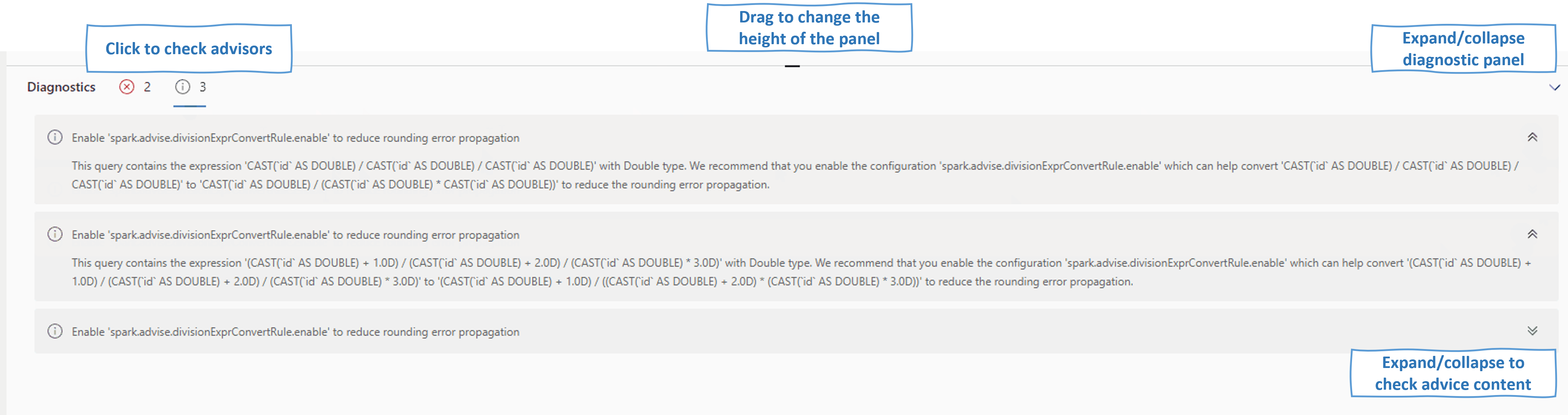

Diagnósticos

O painel de diagnóstico fornece aos usuários recomendações em tempo real e análises de erros, que são geradas pelo Assistente do Spark por meio de uma análise do código do usuário. Com padrões internos, o Assistente do Apache Spark ajuda os usuários a evitar erros comuns e analisa as falhas para identificar sua causa raiz.

Conteúdo relacionado

A próxima etapa após a exibição dos detalhes de um aplicativo Apache Spark é visualizar Progresso do trabalho do Spark abaixo da célula do Notebook. Você pode consultar: