Integração do OneLake com o Azure Synapse Analytics

O Azure Synapse é um serviço de análise ilimitado que reúne data warehouse empresarial e análise de Big Data. Este tutorial mostra como se conectar ao OneLake usando o Azure Synapse Analytics.

Gravar dados do Synapse usando o Apache Spark

Siga essas etapas para usar o Apache Spark para gravar dados de amostra no OneLake a partir do Azure Synapse Analytics.

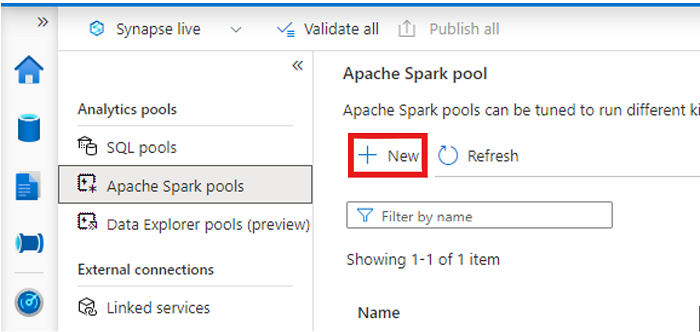

Abra o espaço de trabalho do Synapse e crie um Pool do Apache Spark com seus parâmetros preferidos.

Crie um novo notebook do Apache Spark.

Abra o notebook, defina a linguagem como PySpark (Python) e conecte-o ao Pool do Spark recém-criado.

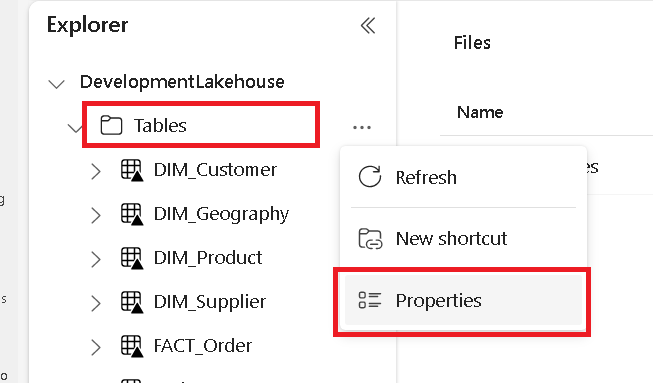

Em uma guia separada, navegue até o seu Microsoft Fabric Lakehouse e localize a pasta Tabelas de nível superior.

Clique com o botão direito do mouse na pasta Tabelas e selecione Propriedades.

Copie o caminho ABFS do painel de propriedades.

De volta ao notebook do Azure Synapse, na primeira nova célula de código, forneça o caminho do Lakehouse. Esse lakehouse é onde seus dados são gravados mais tarde. Execute a célula.

# Replace the path below with the ABFS path to your lakehouse Tables folder. oneLakePath = 'abfss://WorkspaceName@onelake.dfs.fabric.microsoft.com/LakehouseName.lakehouse/Tables'Em uma nova célula de código, carregue os dados de um conjunto de dados abertos do Azure em um dataframe. Esse conjunto de dados é o que você carregará em seu Lakehouse. Execute a célula.

yellowTaxiDf = spark.read.parquet('wasbs://nyctlc@azureopendatastorage.blob.core.windows.net/yellow/puYear=2018/puMonth=2/*.parquet') display(yellowTaxiDf.limit(10))Em uma nova célula de código, filtre, transforme ou prepare seus dados. Nesse cenário, você pode reduzir seu conjunto de dados para um carregamento mais rápido, unir-se a outros conjuntos de dados ou filtrar resultados específicos. Execute a célula.

filteredTaxiDf = yellowTaxiDf.where(yellowTaxiDf.tripDistance>2).where(yellowTaxiDf.passengerCount==1) display(filteredTaxiDf.limit(10))Em uma nova célula de código, usando o caminho do OneLake, grave o dataframe filtrado em uma nova tabela Delta-Parquet em seu Fabric Lakehouse. Execute a célula.

filteredTaxiDf.write.format("delta").mode("overwrite").save(oneLakePath + '/Taxi/')Por fim, em uma nova célula de código, teste se os dados foram gravados com êxito lendo o arquivo recém-carregado do OneLake. Execute a célula.

lakehouseRead = spark.read.format('delta').load(oneLakePath + '/Taxi/') display(lakehouseRead.limit(10))

Parabéns. Agora você pode ler e gravar dados no OneLake usando o Apache Spark no Azure Synapse Analytics.

Leitura de dados do Synapse usando SQL

Siga estas etapas para usar o SQL sem servidor para ler dados do OneLake do Azure Synapse Analytics.

Abra um Fabric Lakehouse e identifique uma tabela que você gostaria de consultar no Synapse.

Clique com o botão direito do mouse na tabela e selecione Propriedades.

Copie o caminho ABFS para a tabela.

Abra seu espaço de trabalho do Synapse no Synapse Studio.

Crie um script SQL.

No editor de consultas SQL, insira a seguinte consulta, substituindo

ABFS_PATH_HEREpelo caminho que você copiou anteriormente.SELECT TOP 10 * FROM OPENROWSET( BULK 'ABFS_PATH_HERE', FORMAT = 'delta') as rows;Execute a consulta para exibir as 10 primeiras linhas de sua tabela.

Parabéns. Agora você pode ler dados do OneLake usando o SQL sem servidor no Azure Synapse Analytics.