Ligar uma rede no local ao Azure através de um gateway de VPN

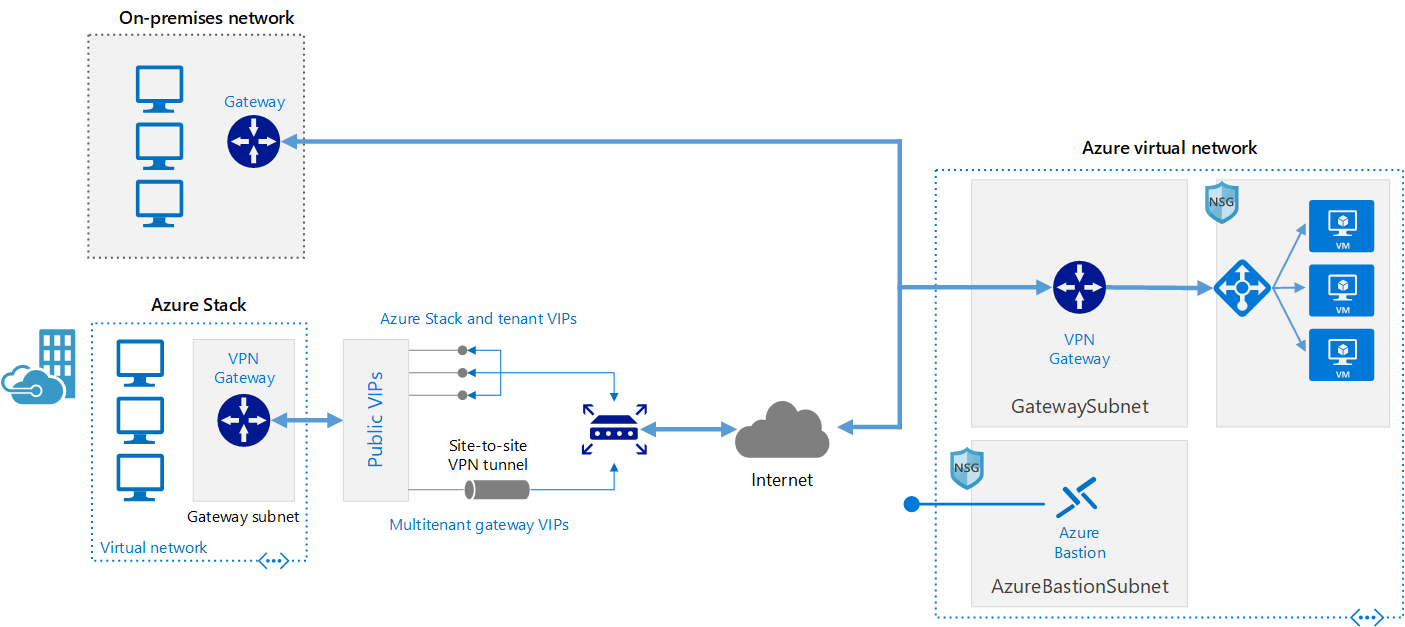

Esta arquitetura de referência mostra como expandir uma rede no local para o Azure através de uma rede de VPNs (Redes Privadas Virtuais).

Este browser já não é suportado.

Atualize para o Microsoft Edge para tirar partido das mais recentes funcionalidades, atualizações de segurança e de suporte técnico.

A computação de alto desempenho (HPC), também chamada de "big compute", usa um grande número de computadores baseados em CPU ou GPU para resolver tarefas matemáticas complexas.

Vários setores utilizam o HPC para resolver alguns dos problemas mais difíceis que enfrentam. Estes incluem cargas de trabalho como:

Uma das principais diferenças entre um sistema HPC local e um na nuvem é a capacidade de os recursos serem dinamicamente adicionados e removidos conforme necessário. O dimensionamento dinâmico remove a capacidade de computação como estrangulamento e permite que os clientes dimensionem a infraestrutura para corresponder aos requisitos das tarefas.

Os artigos seguintes fornecem mais detalhes sobre esta capacidade de dimensionamento dinâmico.

Quando quiser implementar a sua própria solução de HPC no Azure, certifique-se de que revê os seguintes tópicos:

Existem muitos componentes da infraestrutura que são necessários para construir um sistema de HPC. A computação, o armazenamento e a rede fornecem os componentes subjacentes, independentemente da forma como você escolhe gerenciar suas cargas de trabalho de HPC.

O Azure oferece uma variedade de tamanhos otimizados para cargas de trabalho com utilização intensiva de CPU e GPU.

As VMs de série N utilizam GPUs NVIDIA concebidas para aplicações com utilização intensiva de computação ou gráficos, incluindo aprendizagem por inteligência artificial (IA) e visualização.

As cargas de trabalho de grande escala do Batch e de HPC têm requisitos de acesso e armazenamento de dados que excedem as capacidades dos sistemas de ficheiros de cloud tradicionais. Há muitas soluções que gerenciam as necessidades de velocidade e capacidade dos aplicativos HPC no Azure:

Para obter mais informações comparando o Lustre, o GlusterFS e o BeeGFS no Azure, consulte o e-book Sistemas de Arquivos Paralelos no Azure e o blog do Lustre no Azure .

As VMs H16r, H16mr, A8 e A9 podem ligar-se a uma rede RDMA de back-end de débito elevado. Essa rede pode melhorar o desempenho de aplicativos paralelos fortemente acoplados executados na Microsoft Message Passing Interface, mais conhecida como MPI ou Intel MPI.

A criação de um sistema HPC a partir do zero no Azure oferece uma quantidade significativa de flexibilidade, mas muitas vezes é muito intensiva em termos de manutenção.

Se você tiver um sistema HPC local existente que gostaria de conectar ao Azure, há vários recursos para ajudá-lo a começar.

Em primeiro lugar, veja o artigo Options for connecting an on-premises network to Azure (Opções para ligar uma rede no local ao Azure) na documentação. A partir daí, você pode encontrar informações adicionais sobre essas opções de conectividade:

Esta arquitetura de referência mostra como expandir uma rede no local para o Azure através de uma rede de VPNs (Redes Privadas Virtuais).

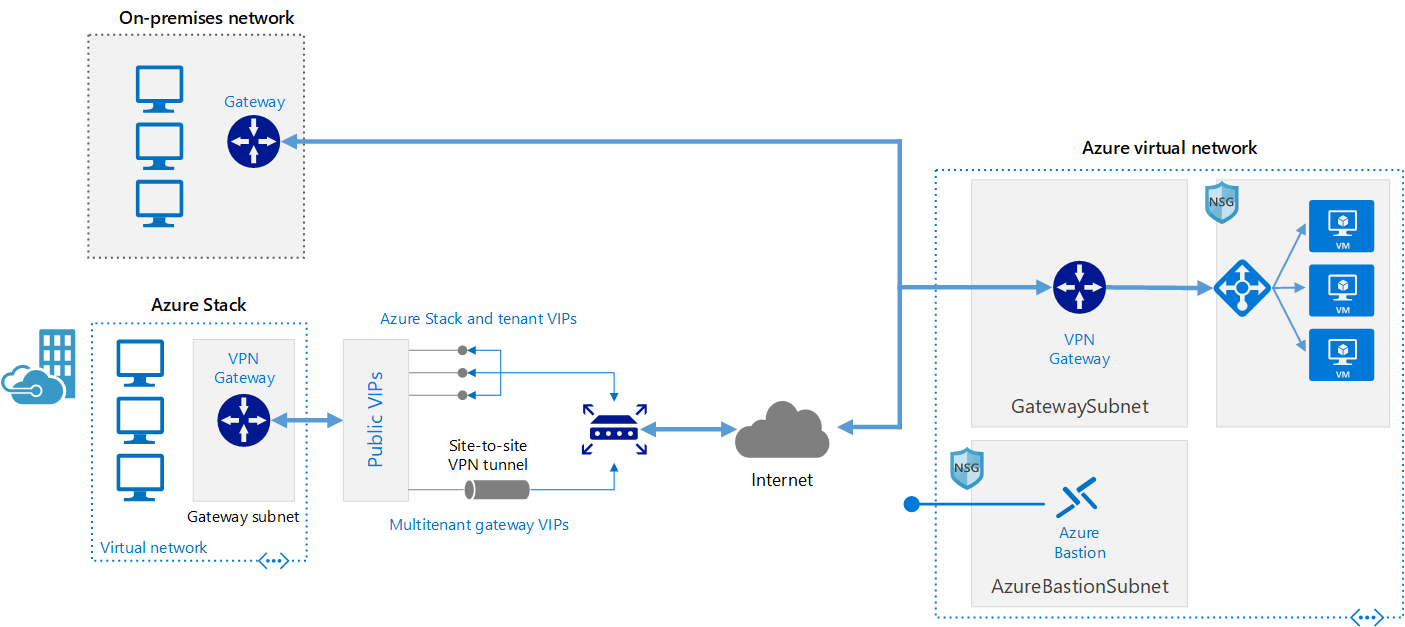

Implemente uma arquitetura de rede de site a site segura e de elevada disponibilidade que abranja uma rede virtual do Azure e uma rede no local com ligação através do ExpressRoute com ativação pós-falha do gateway de VPN.

Quando a conectividade de rede tiver sido estabelecida com segurança, pode começar a utilizar recursos de computação na cloud a pedido com as capacidades de rajada do seu gestor de cargas de trabalho existente.

Há muitos gerenciadores de carga de trabalho oferecidos no Azure Marketplace.

O Azure Batch é um serviço de plataforma para executar aplicações paralelas e HPC de grande escala de forma eficiente na nuvem. O Azure Batch agenda trabalho de computação intensiva para ser executado num conjunto gerido de máquinas virtuais e pode dimensionar automaticamente recursos de computação para satisfazer as necessidades das suas tarefas.

Os fornecedores ou programadores de SaaS podem utilizar os SDKs e as ferramentas do Batch para integrar aplicações de HPC ou cargas de trabalho de contentor no Azure, preparar dados para o Azure e criar pipelines de execução de tarefas.

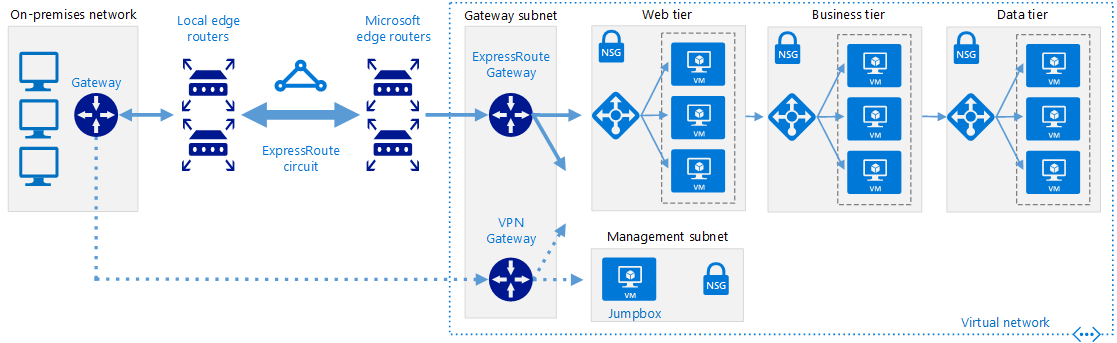

No Azure Batch, todos os serviços estão sendo executados na nuvem, a imagem abaixo mostra como a arquitetura se parece com o Azure Batch, tendo as configurações de escalabilidade e agendamento de trabalho em execução na nuvem enquanto os resultados e relatórios podem ser enviados para seu ambiente local.

O Azure CycleCloud é a forma mais simples de gerir cargas de trabalho de HPC com qualquer agendador (como o Slurm, Grid Engine, HPC Pack, HTCondor, LSF, PBS Pro ou Symphony) no Azure

O CycleCloud permite-lhe:

Neste diagrama de exemplo híbrido, podemos ver claramente como esses serviços são distribuídos entre a nuvem e o ambiente local. Ter a oportunidade de executar trabalhos em ambas as cargas de trabalho.

O diagrama de exemplo de modelo nativo da nuvem abaixo mostra como a carga de trabalho na nuvem lidará com tudo enquanto ainda conserva a conexão com o ambiente local.

| Caraterística | Azure Batch | Azure CycleCloud |

|---|---|---|

| Agendador | APIs e ferramentas em lote e scripts de linha de comando no portal do Azure (Cloud Native). | Use agendadores HPC padrão, como Slurm, PBS Pro, LSF, Grid Engine e HTCondor, ou estenda os plug-ins de dimensionamento automático do CycleCloud para trabalhar com seu próprio agendador. |

| Recursos de computação | Software as a Service Nodes – Plataforma como Serviço | Software de plataforma como serviço – Plataforma como serviço |

| Ferramentas de monitorização | Azure Monitor | Azure Monitor, Grafana |

| Personalização | Pools de imagens personalizadas, imagens de terceiros, acesso à API em lote. | Use a abrangente API RESTful para personalizar e estender a funcionalidade, implantar seu próprio agendador e oferecer suporte aos gerenciadores de carga de trabalho existentes |

| Integração | Synapse Pipelines, Azure Data Factory, Azure CLI | CLI integrada para Windows e Linux |

| Tipo de utilizador | Programadores | Administradores e utilizadores de HPC clássica |

| Tipo de Trabalho | Lote, Fluxos de trabalho | Firmemente acoplado (Message Passing Interface/MPI). |

| Suporte do Windows | Sim | Varia, dependendo da escolha do agendador |

Seguem-se exemplos de gestores de cargas de trabalho e clusters que podem ser executados na infraestrutura do Azure. Crie clusters autónomos em VMs do Azure ou expanda para VMs do Azure a partir de um cluster no local.

Também pode utilizar contentores para gerir algumas cargas de trabalho de HPC. Serviços como o Azure Kubernetes Service (AKS) facilitam a implementação de um cluster do Kubernetes gerido no Azure.

Tem à sua disposição várias formas de gerir os custos associados ao HPC no Azure. Certifique-se de que reviu as opções de compra do Azure para encontrar o método mais adequado para a sua organização.

Para obter uma descrição geral das melhores práticas de segurança no Azure, reveja a Documentação de Segurança do Azure.

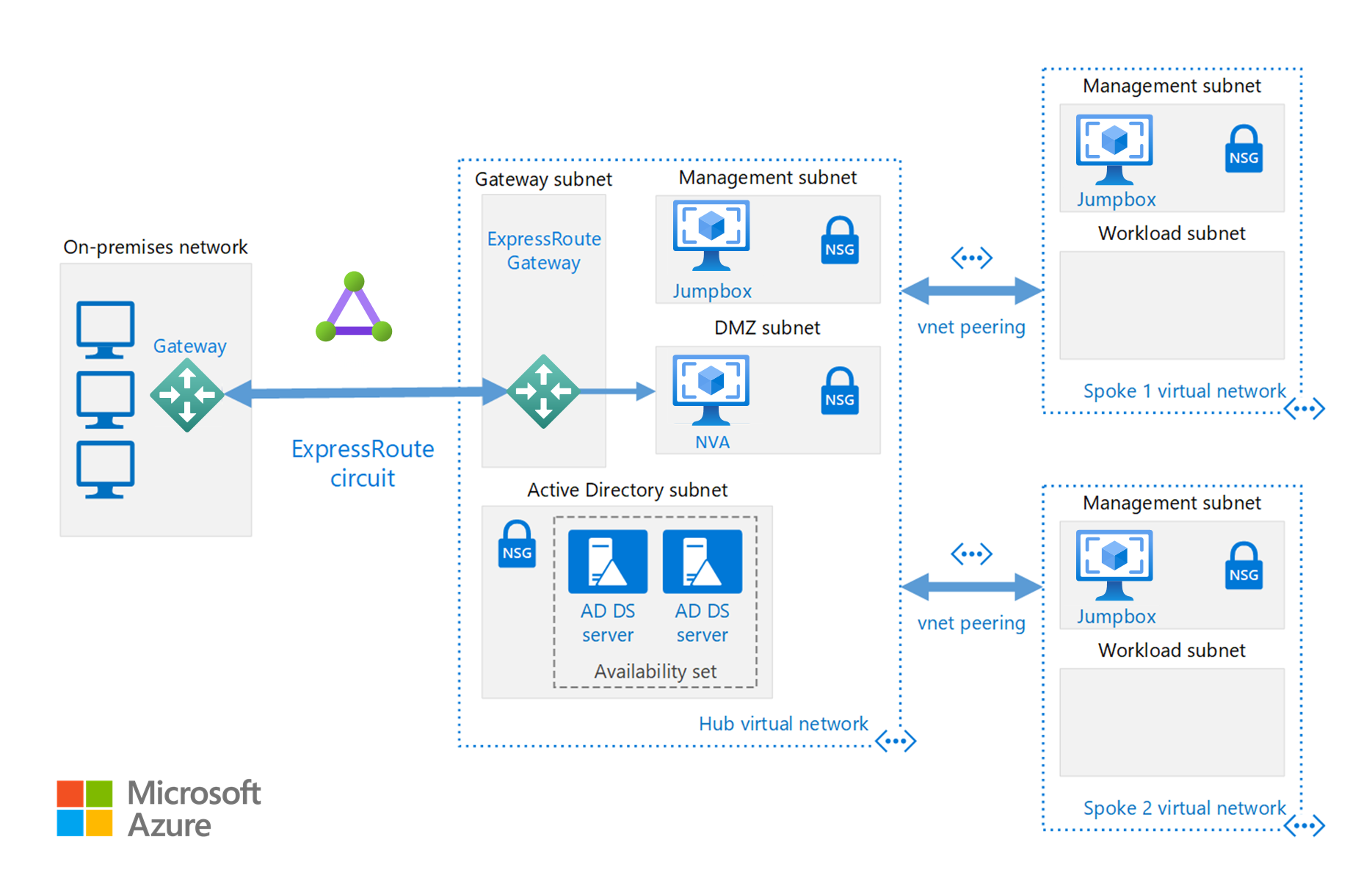

Além das configurações de rede disponíveis na seção Cloud Bursting , você pode implementar uma configuração hub/spoke para isolar seus recursos de computação:

O hub é uma rede virtual (VNet) no Azure que funciona como um ponto central de conectividade à sua rede no local. Os spokes são VNets que funcionam como elemento da rede do hub e podem ser utilizados para isolar cargas de trabalho.

Esta arquitetura de referência baseia-se na arquitetura de referência hub and spoke para incluir serviços partilhados no hub que possam ser consumidos por todos os spokes.

Execute aplicações de HPC comerciais ou personalizadas no Azure. Vários exemplos nesta secção foram submetidos a testes de referência para dimensionar de forma eficiente com VMs ou núcleos de computação adicionais. Visite o Azure Marketplace para obter soluções prontas a implementar.

Nota

Entre em contacto com o fornecedor de qualquer aplicação comercial para saber quais são as restrições de licenciamento (ou outras restrições) de execução na cloud. Nem todos os fornecedores oferecem licenciamento pay as you go. Poderá precisar de um servidor de licenciamento na cloud para a sua solução ou ligar-se a um servidor de licenças no local.

Execute máquinas virtuais alimentadas por GPU no Azure na mesma região da saída HPC para obter a menor latência, acesso e visualização remota através do Ambiente de Trabalho Virtual do Azure.

Há muitos clientes que tiveram grande sucesso usando o Azure para suas cargas de trabalho de HPC. Abaixo, pode ver alguns dos casos práticos destes clientes:

Para obter os anúncios mais recentes, consulte os seguintes recursos:

Estes tutoriais fornecerão detalhes sobre a execução de aplicativos no Microsoft Batch: