Adote princípios de IA responsáveis e confiáveis

Os seis princípios-chave para uma IA responsável na Microsoft incluem equidade, fiabilidade e segurança, privacidade e segurança, inclusão, transparência e responsabilização. Use esses princípios para criar IA responsável e confiável à medida que você a integra em produtos e serviços convencionais ao longo de sua jornada de adoção de IA.

Princípios de IA responsável

A Microsoft compromete-se a capacitar práticas responsáveis de IA.

Seis princípios-chave definem IA responsável:

Equidade: os sistemas de IA devem tratar todos de forma igual e fornecer as mesmas recomendações a todos os indivíduos. A equidade nos sistemas de IA evita a discriminação com base em características pessoais.

Fiabilidade e segurança: Os sistemas de IA devem funcionar de forma fiável, segura e consistente sob várias condições para ajudar a criar confiança.

Privacidade e segurança: os sistemas de IA devem respeitar a privacidade e manter a segurança, protegendo informações privadas e confidenciais. Eles também devem resistir a ataques e tentativas de corromper ou comprometer o sistema.

Inclusão: os sistemas de IA devem capacitar e envolver todos. Práticas de design inclusivas podem ajudar os desenvolvedores de sistemas de IA a entender e abordar possíveis barreiras de exclusão em um produto ou serviço. A inclusão fomenta a inovação e ajuda a projetar experiências que beneficiam a todos.

Transparência: os sistemas de IA devem ser transparentes e compreensíveis. Os sistemas de IA podem informar decisões que podem afetar profundamente a vida das pessoas, por isso é crucial que os indivíduos entendam como o sistema toma essas decisões.

Responsabilização: os sistemas de IA e os seus criadores devem ser responsabilizados e responsabilizados.

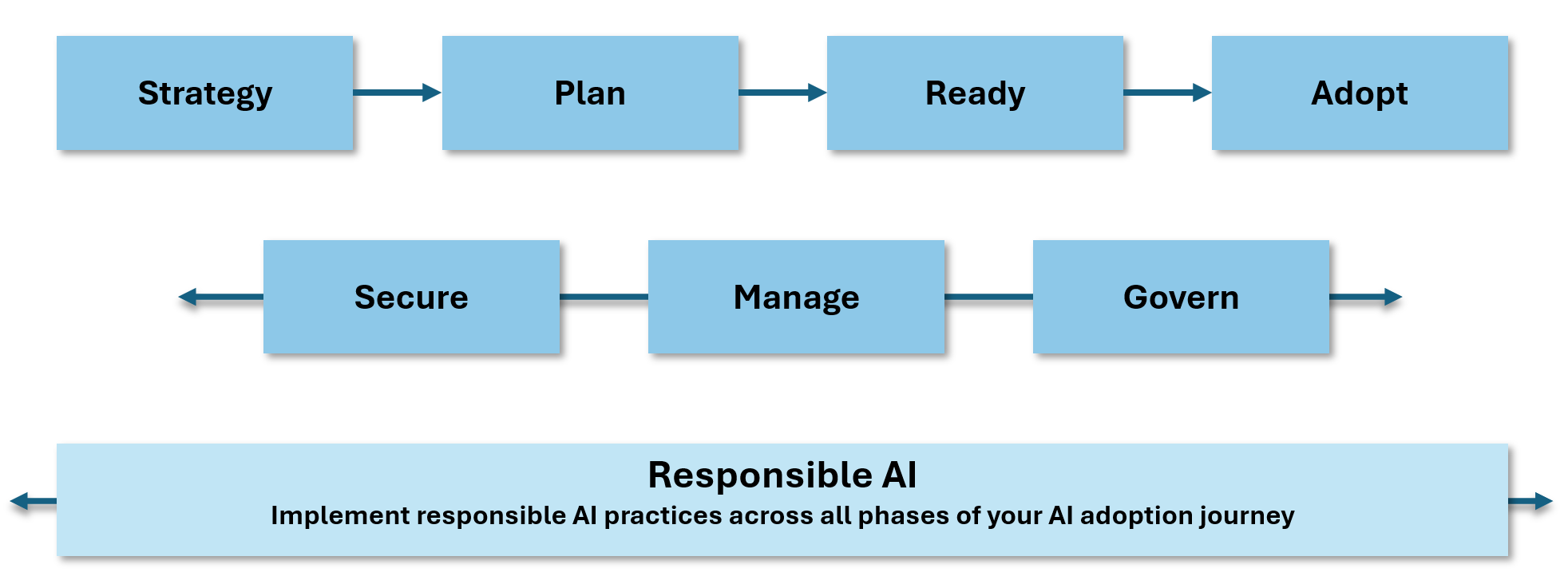

Incorpore princípios de IA responsáveis em toda a sua jornada de adoção de IA, desde a estratégia e planejamento até a implementação. Certifique-se de aplicar esses princípios ao proteger, gerenciar e governar suas iniciativas de IA.

Estas diretrizes de adoção de IA incluem exemplos de como você pode usar a Estrutura de Adoção de Nuvem para Azure para implementar práticas de IA responsáveis. Os princípios da IA responsável são integrados nas orientações e recomendações ao longo desta jornada de adoção da IA.

A importância de uma IA responsável

A IA responsável ajuda a mitigar os seguintes riscos:

Consequências não intencionais: planeje e supervisione sua implementação responsável de IA para reduzir o risco de efeitos imprevistos que tenham implicações éticas.

Ameaças em evolução: Novas ameaças surgem regularmente à medida que a tecnologia de IA evolui. Para ajudar a mitigar e ficar à frente dessas ameaças, siga os princípios da IA responsável.

Enviesamento: A mitigação de enviesamentos na IA pode ser um desafio, mas é necessária para garantir que os sistemas de IA são justos e imparciais. Use os princípios de IA responsável para ajudar a guiá-lo.

Tecnologias sensíveis: Tecnologias como o reconhecimento facial podem ser consideradas tecnologias sensíveis devido ao risco para as liberdades fundamentais e os direitos humanos. Considere as implicações dessas tecnologias para garantir que você as use de forma responsável.

Facilitação do Azure

O Microsoft Azure fornece uma variedade de ferramentas, serviços e recursos para ajudá-lo a criar sistemas de IA responsáveis.

Usar a Segurança de Conteúdo de IA do Microsoft Azure para criar sistemas seguros

Use o Microsoft Azure AI Content Safety para detetar conteúdo prejudicial gerado pelo usuário e gerado por IA em aplicativos e serviços. A Segurança de Conteúdo ajuda você a analisar o conteúdo gerado em seus aplicativos de IA, incluindo texto e imagens, para garantir que seja seguro e apropriado para seus usuários. A Segurança de Conteúdo fornece os seguintes recursos:

O Prompt protege o texto e os documentos quanto ao risco de um ataque de entrada do usuário, ou jailbreak, em um modelo de linguagem grande (LLM).

A deteção de aterramento deteta se as respostas de texto de um LLM estão fundamentadas nos materiais de origem fornecidos pelos usuários.

A deteção de material protegido deteta se as respostas de texto de um LLM contêm material protegido, como texto protegido por direitos autorais, letras de músicas, artigos e conteúdo da Web.

A API de categorias personalizadas (rápida) define padrões emergentes de conteúdo prejudicial e verifica texto e imagens em busca de correspondências.

A API Analisar texto analisa conteúdo de texto potencialmente prejudicial. Normalmente, identifica categorias como ódio, automutilação e conteúdo sexual ou violento.

A API Analyze Image analisa o potencial conteúdo de imagem prejudicial. Normalmente, identifica categorias como ódio, automutilação e conteúdo sexual ou violento.

Use a IA de forma responsável nos serviços de IA do Azure

A Microsoft fornece uma lista de notas de transparência para serviços do Azure relevantes para IA. A lista inclui serviços dentro do pacote de serviços de IA do Azure. Para obter mais informações, consulte Uso responsável da IA com os serviços de IA do Azure.

Usar o painel de IA responsável para o Azure Machine Learning

Se você criar sistemas com o Azure Machine Learning, poderá usar o painel de IA responsável para avaliar seus sistemas de IA. O painel de IA responsável fornece uma interface única para ajudá-lo a implementar princípios de IA responsável. Alguns dos recursos de IA responsável incluem:

Análise de dados: compreenda e explore suas distribuições e estatísticas de conjuntos de dados.

Visão geral do modelo e avaliação de equidade: avalie o desempenho do seu modelo e os problemas de equidade de grupo do seu modelo.

Análise de erros: visualize e entenda como os erros são distribuídos em seu conjunto de dados.

Interpretabilidade do modelo: entenda as previsões do seu modelo e como ele faz previsões individuais e gerais.

Análise hipotética contrafactual: observe como as alterações nos recursos podem afetar as previsões do modelo.

Análise causal: Use dados históricos para visualizar os efeitos causais das características do tratamento nos resultados do mundo real.

Desenvolva a IA de forma responsável

| Recurso | Description |

|---|---|

| Ferramentas práticas para construir experiências eficazes de IA humana (HAXs) | Use o HAX Toolkit no início do seu processo de design para ajudá-lo a conceituar o que o sistema de IA faz e como ele se comporta. Use o HAX Toolkit para produtos de IA voltados para o usuário. |

| Diretrizes de IA conversacional | Crie bots de uma forma que ganhe a confiança dos outros para ajudar as pessoas e a sociedade a realizarem todo o seu potencial. Use estas diretrizes para criar um bot que crie confiança na empresa e no serviço que ela representa. |

| Diretrizes de design de IA inclusivas | Use estas diretrizes para ajudá-lo a projetar uma IA inclusiva e acessível a todos. |

| Lista de verificação de equidade de IA | Use a lista de verificação de equidade de IA para determinar se seu sistema de IA é justo e imparcial. |

| IA responsável em Machine Learning | Analise esses recursos de IA responsável se você usar o Machine Learning para criar sistemas de IA. |