Recursos de extensão do Databricks Asset Bundles

A extensão Databricks para Visual Studio Code fornece recursos adicionais no Visual Studio Code que permitem definir, implantar e executar facilmente Databricks Asset Bundles para aplicar as práticas recomendadas de CI/CD aos seus trabalhos do Azure Databricks, pipelines Delta Live Tables e MLOps Stacks. Consulte O que são Databricks Asset Bundles?.

Para instalar a extensão Databricks para Visual Studio Code, consulte Instalar a extensão Databricks para Visual Studio Code.

Suporte a Databricks Asset Bundles em projetos

A extensão Databricks para Visual Studio Code adiciona os seguintes recursos para seus projetos Databricks Asset Bundles:

- Fácil autenticação e configuração de seus pacotes de ativos Databricks por meio da interface do usuário do Visual Studio Code, incluindo a seleção de perfil AuthType . Consulte Configuração de autenticação para a extensão Databricks para Visual Studio Code.

- Um seletor de destino no painel de extensão Databricks para alternar rapidamente entre ambientes de destino de pacote. Consulte Alterar o espaço de trabalho de implantação de destino.

- A opção Substituir cluster de trabalhos no pacote no painel de extensão para permitir a substituição fácil do cluster.

- Um modo de exibição do Bundles Resource Explorer , que permite que você navegue pelos recursos do pacote usando a interface do usuário do Visual Studio Code, implante os recursos do Databricks Asset Bundle local em seu espaço de trabalho remoto do Azure Databricks com um único clique e vá diretamente para os recursos implantados em seu espaço de trabalho a partir do Visual Studio Code. Consulte Bundle Resource Explorer.

- Um modo de exibição de variáveis de pacotes, que permite que você navegue e edite suas variáveis de pacote usando a interface do usuário do Visual Studio Code. Consulte Visualização de variáveis do pacote.

Explorador de Recursos do Pacote

O modo de exibição Bundle Resource Explorer na extensão Databricks para Visual Studio Code usa as definições de trabalho e pipeline na configuração de pacote do projeto para exibir recursos. Ele também permite que você implante e execute recursos e navegue até eles em seu espaço de trabalho remoto do Azure Databricks. Para obter informações sobre recursos de configuração de pacote, consulte recursos.

Por exemplo, dada uma definição de trabalho simples:

resources:

jobs:

my-notebook-job:

name: "My Notebook Job"

tasks:

- task_key: notebook-task

existing_cluster_id: 1234-567890-abcde123

notebook_task:

notebook_path: notebooks/my-notebook.py

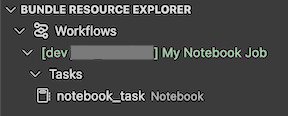

O modo de exibição Bundle Resource Explorer na extensão exibe o recurso de trabalho do bloco de anotações:

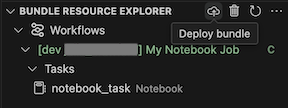

Para implantar o pacote, clique no ícone nuvem (Implantar pacote).

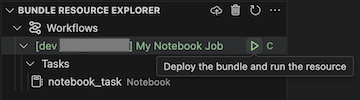

Para executar o trabalho, no modo de exibição Bundle Resource Explorer , selecione o nome do trabalho, que é Meu Trabalho de Bloco de Anotações neste exemplo. Em seguida, clique no ícone play (Implantar o pacote e executar o recurso).

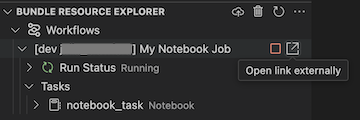

Para exibir o trabalho em execução, no modo de exibição Bundle Resource Explorer , expanda o nome do trabalho, clique em Status da Execução e clique no ícone de link (Abrir link externamente).

Visualização de variáveis de pacote

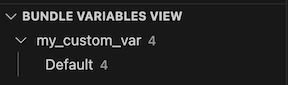

O modo de exibição Bundle Variables View na extensão Databricks para Visual Studio Code exibe todas as variáveis personalizadas e configurações associadas definidas na configuração do pacote. Você também pode definir variáveis diretamente usando a Visualização de variáveis de pacotes. Esses valores substituem os definidos nos arquivos de configuração do pacote. Para obter informações sobre variáveis personalizadas, consulte Variáveis personalizadas.

Por exemplo, o modo de exibição Bundle Variables View na extensão exibiria o seguinte:

Para a variável my_custom_var definida nesta configuração de pacote:

variables:

my_custom_var:

description: "Max workers"

default: "4"

resources:

jobs:

my_job:

name: my_job

tasks:

- task_key: notebook_task

job_cluster_key: job_cluster

notebook_task:

notebook_path: ../src/notebook.ipynb

job_clusters:

- job_cluster_key: job_cluster

new_cluster:

spark_version: 13.3.x-scala2.12

node_type_id: i3.xlarge

autoscale:

min_workers: 1

max_workers: ${var.my_custom_var}