Dimensione o bate-papo do Azure OpenAI para .NET usando o RAG com os Aplicativos de Contêiner do Azure

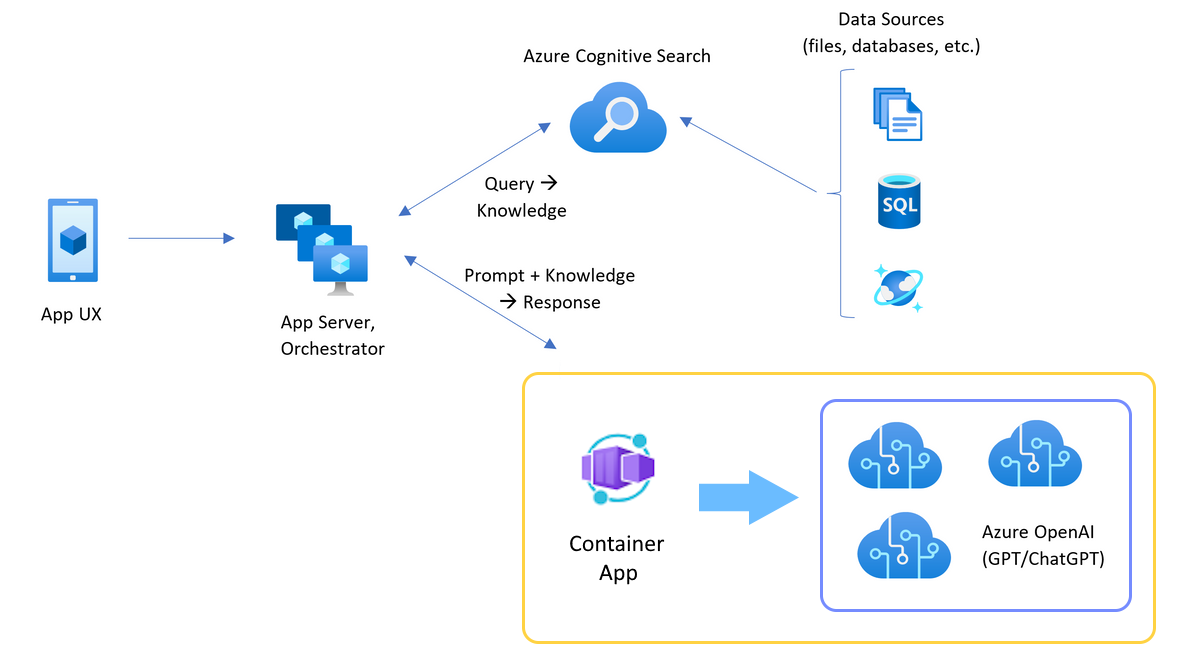

Saiba como adicionar balanceamento de carga ao seu aplicativo para estender o aplicativo de chat além dos limites de token e cota de modelo do Azure OpenAI. Essa abordagem usa os Aplicativos de Contêiner do Azure para criar três pontos de extremidade do Azure OpenAI, bem como um contêiner primário para direcionar o tráfego de entrada para um dos três pontos de extremidade.

Este artigo requer que você implante dois exemplos separados:

Aplicativo de bate-papo

Se você ainda não implantou o aplicativo de bate-papo, aguarde até que o exemplo de balanceador de carga seja implantado.

Se você já tiver implantado o aplicativo de chat uma vez, alterará a variável de ambiente para oferecer suporte a um ponto de extremidade personalizado para o balanceador de carga e o reimplantará novamente.

Aplicativo de bate-papo disponível nestes idiomas:

Aplicativo de balanceador de carga

Nota

Este artigo usa um ou mais modelos de aplicativo de IA como base para os exemplos e orientações no artigo. Os modelos de aplicativos de IA fornecem implementações de referência bem mantidas e fáceis de implantar que ajudam a garantir um ponto de partida de alta qualidade para seus aplicativos de IA.

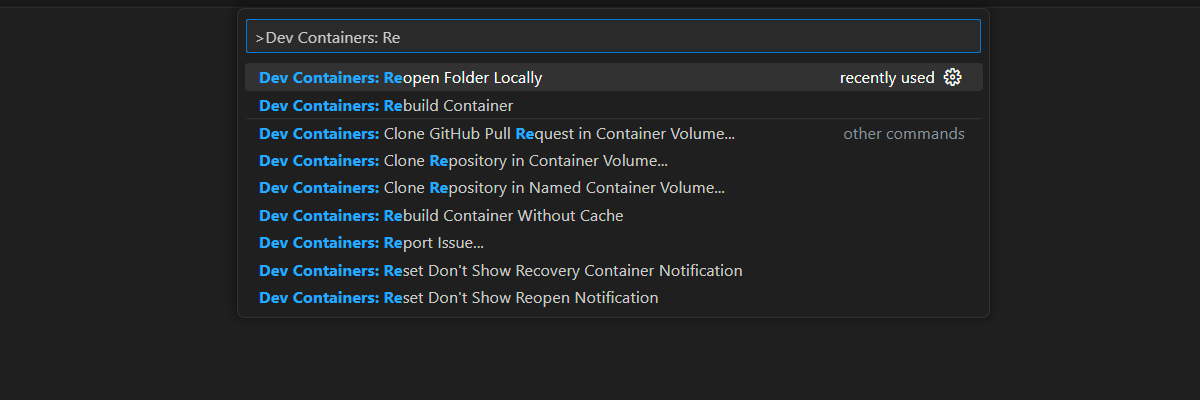

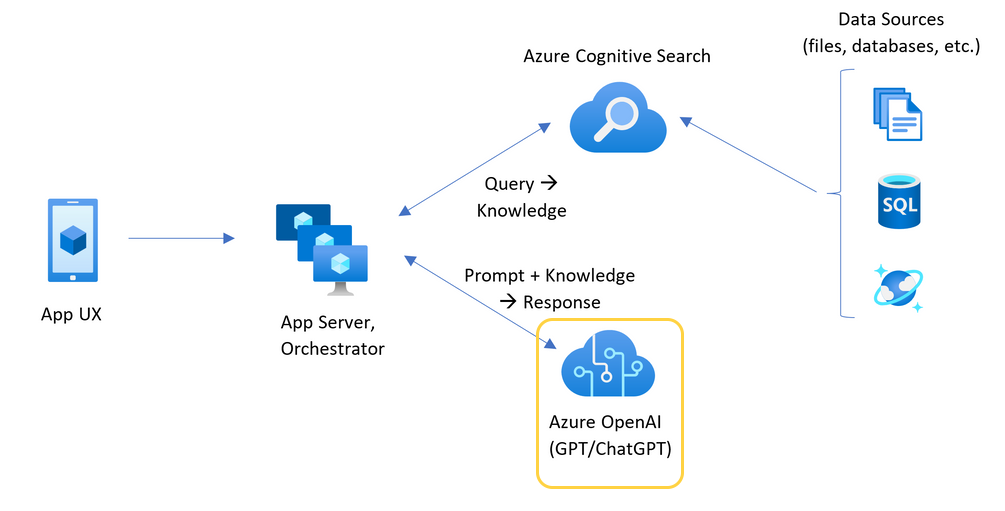

Arquitetura para balanceamento de carga do Azure OpenAI com Aplicativos de Contêiner do Azure

Como o recurso do Azure OpenAI tem limites específicos de token e cota de modelo, um aplicativo de chat usando um único recurso do Azure OpenAI é propenso a ter falhas de conversa devido a esses limites.

Para usar o aplicativo de chat sem atingir esses limites, use uma solução com balanceamento de carga com os Aplicativos de Contêiner do Azure. Esta solução expõe perfeitamente um único ponto de extremidade dos Aplicativos de Contêiner do Azure ao seu servidor de aplicativo de chat.

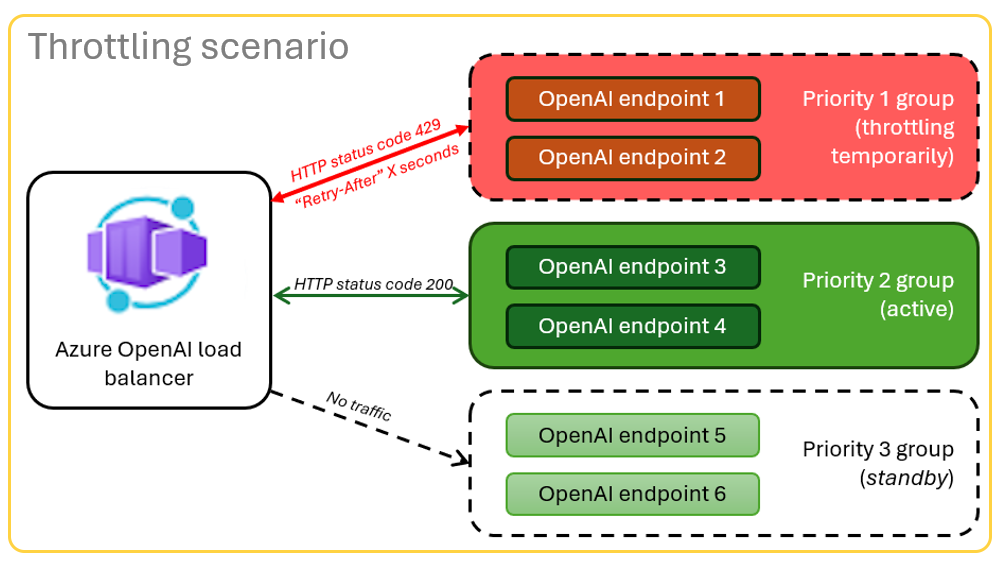

O aplicativo Contêiner do Azure fica na frente de um conjunto de recursos do Azure OpenAI. O aplicativo Container resolve dois cenários: normal e limitado. Durante um cenário normal em que a cota de token e modelo está disponível, o recurso OpenAI do Azure retorna um 200 de volta por meio do Aplicativo de Contêiner e do Servidor de Aplicativos.

Quando um recurso está em um cenário limitado, como devido a limites de cota, o aplicativo Contêiner do Azure pode tentar novamente um recurso OpenAI do Azure diferente imediatamente para preencher a solicitação original do aplicativo de chat.

Pré-requisitos

Subscrição do Azure. Crie um gratuitamente

Acesso concedido ao Azure OpenAI na subscrição pretendida do Azure.

Atualmente, o acesso a este serviço é concedido apenas por pedido. Você deve solicitar acesso ao Azure OpenAI.

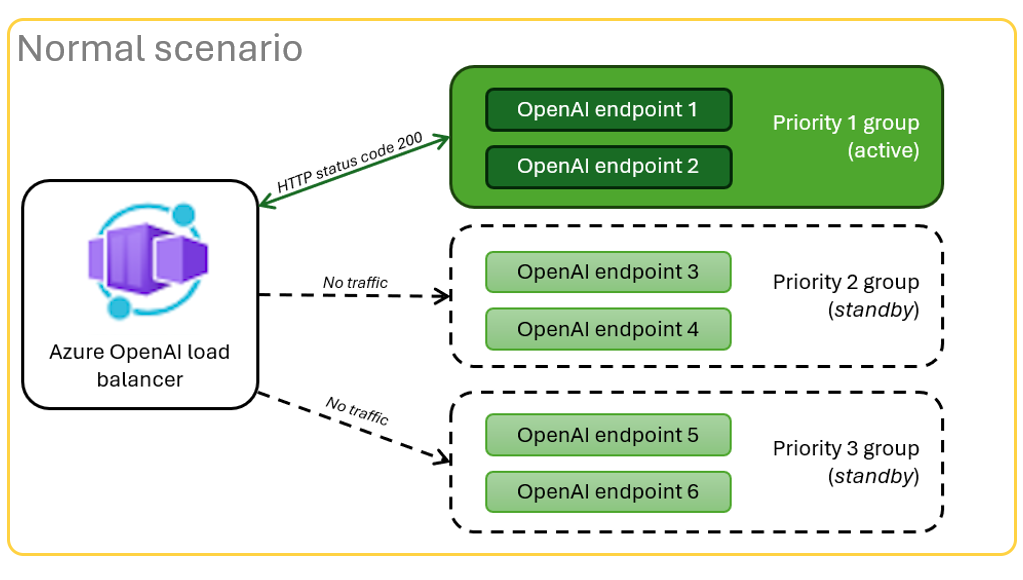

Os contêineres de desenvolvimento estão disponíveis para ambos os exemplos, com todas as dependências necessárias para concluir este artigo. Você pode executar os contêineres de desenvolvimento no GitHub Codespaces (em um navegador) ou localmente usando o Visual Studio Code.

- Apenas uma conta do GitHub é necessária para usar o CodeSpaces

Abrir aplicativo de exemplo de balanceador local de aplicativos de contêiner

O GitHub Codespaces executa um contêiner de desenvolvimento gerenciado pelo GitHub com o Visual Studio Code for the Web como interface do usuário. Para o ambiente de desenvolvimento mais simples, use o GitHub Codespaces para que você tenha as ferramentas de desenvolvedor corretas e as dependências pré-instaladas para concluir este artigo.

Importante

Todas as contas do GitHub podem usar o Codespaces por até 60 horas gratuitas por mês com 2 instâncias principais. Para obter mais informações, consulte GitHub Codespaces mensalmente incluído armazenamento e horas principais.

Implantar o balanceador de carga de Aplicativos de Contêiner do Azure

Entre na CLI do Desenvolvedor do Azure para fornecer autenticação às etapas de provisionamento e implantação.

azd auth login --use-device-codeDefina uma variável de ambiente para usar a autenticação da CLI do Azure para a etapa de pós-provisionamento.

azd config set auth.useAzCliAuth "true"Implante o aplicativo balanceador de carga.

azd upVocê precisará selecionar uma assinatura e uma região para a implantação. Eles não precisam ser a mesma assinatura e região do aplicativo de bate-papo.

Aguarde pela conclusão da implementação antes de continuar.

Obter o ponto de extremidade de implantação

Use o comando a seguir para exibir o ponto de extremidade implantado para o aplicativo Contêiner do Azure.

azd env get-valuesCopie o

CONTAINER_APP_URLvalor. Você vai usá-lo na próxima seção.

Reimplantar o aplicativo de bate-papo com o ponto de extremidade do balanceador de carga

Estes são concluídos no exemplo de aplicativo de chat.

Abra o contêiner de desenvolvimento do exemplo de aplicativo de bate-papo usando uma das opções a seguir.

Idioma Codespaces Visual Studio Code .NET JavaScript Python Entre na CLI do Desenvolvedor do Azure (AZD).

azd auth loginTermine as instruções de login.

Crie um ambiente AZD com um nome como

chat-app.azd env new <name>Adicione a seguinte variável de ambiente, que informa ao back-end do aplicativo de bate-papo para usar uma URL personalizada para as solicitações OpenAI.

azd env set OPENAI_HOST azure_customAdicione a seguinte variável de ambiente, substituindo

<CONTAINER_APP_URL>a URL da seção anterior. Essa ação informa ao back-end do aplicativo de bate-papo qual é o valor da URL personalizada para a solicitação OpenAI.azd env set AZURE_OPENAI_CUSTOM_URL <CONTAINER_APP_URL>Implante o aplicativo de bate-papo.

azd up

Agora você pode usar o aplicativo de bate-papo com a confiança de que ele foi criado para ser dimensionado para muitos usuários sem ficar sem cota.

Transmitir logs para ver os resultados do balanceador de carga

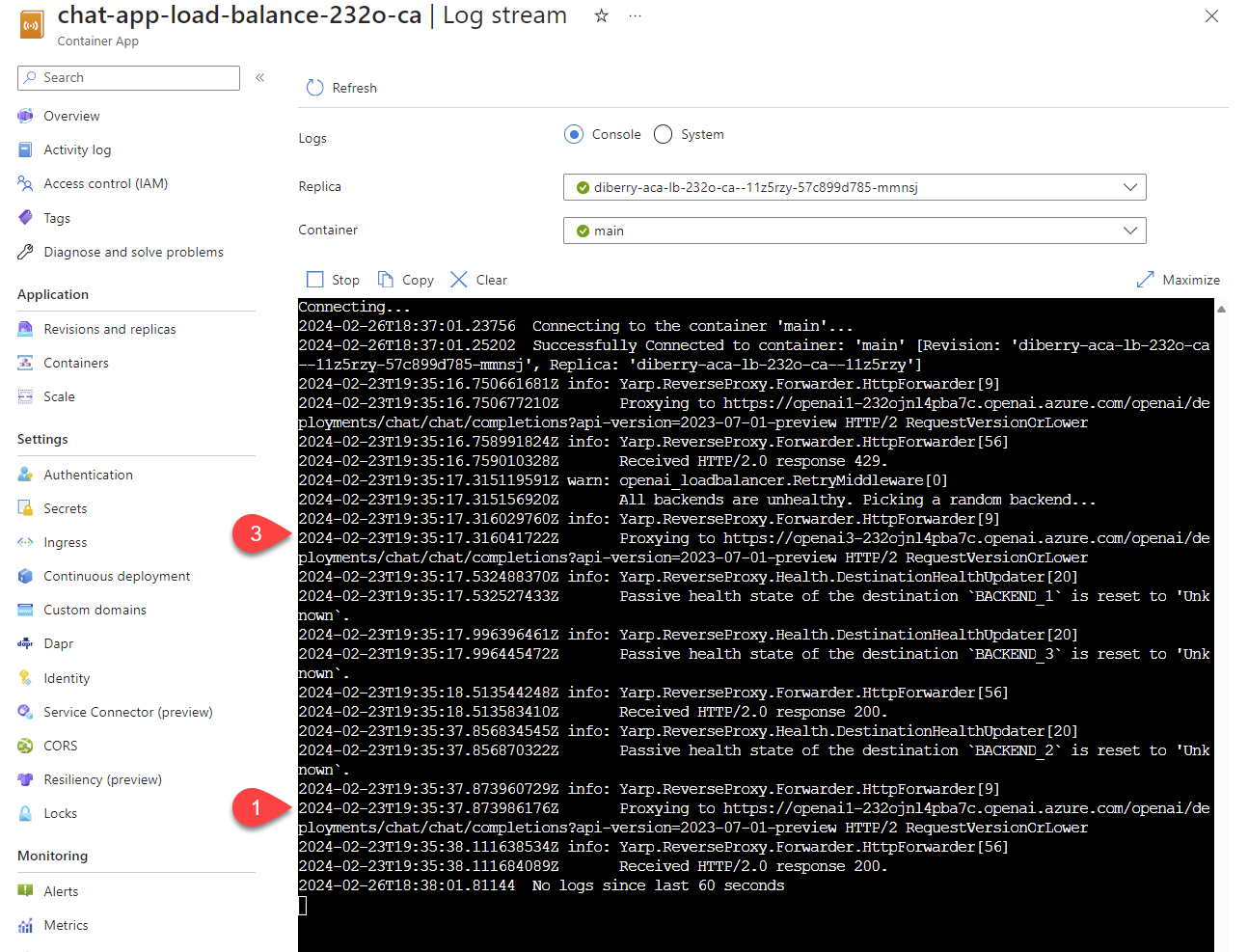

No portal do Azure, pesquise seu grupo de recursos.

Na lista de recursos do grupo, selecione o recurso Aplicativo de contêiner.

Selecione Monitoramento -> Fluxo de log para exibir o log.

Use o aplicativo de bate-papo para gerar tráfego no log.

Procure os logs, que fazem referência aos recursos do Azure OpenAI. Cada um dos três recursos tem sua identidade numérica no comentário de log começando com

Proxying to https://openai3, onde3indica o terceiro recurso do Azure OpenAI.

À medida que você usa o aplicativo de bate-papo, quando o balanceador de carga recebe o status de que a solicitação excedeu a cota, o balanceador de carga gira automaticamente para outro recurso.

Configurar a cota de tokens por minuto (TPM)

Por padrão, cada uma das instâncias OpenAI no balanceador de carga será implantada com capacidade de 30.000 TPM (tokens por minuto). Você pode usar o aplicativo de bate-papo com a confiança de que ele foi criado para ser dimensionado para muitos usuários sem ficar sem cota. Altere este valor quando:

- Você obtém erros de capacidade de implantação: diminua esse valor.

- Planear maior capacidade, aumentar o valor.

Use o seguinte comando para alterar o valor.

azd env set OPENAI_CAPACITY 50Reimplante o balanceador de carga.

azd up

Clean up resources (Limpar recursos)

Quando terminar de usar o aplicativo de bate-papo e o balanceador de carga, limpe os recursos. Os recursos do Azure criados neste artigo são cobrados na sua assinatura do Azure. Se você não espera precisar desses recursos no futuro, exclua-os para evitar incorrer em mais cobranças.

Limpar recursos do aplicativo de bate-papo

Volte ao artigo do aplicativo de bate-papo para limpar esses recursos.

Recursos limpos do balanceador de upload

Execute o seguinte comando da CLI do Desenvolvedor do Azure para excluir os recursos do Azure e remover o código-fonte:

azd down --purge --force

Os interruptores fornecem:

purge: Os recursos excluídos são imediatamente limpos. Isso permite que você reutilize o Azure OpenAI TPM.force: A exclusão acontece silenciosamente, sem exigir o consentimento do usuário.

Limpar espaços de código do GitHub

Excluir o ambiente do GitHub Codespaces garante que você possa maximizar a quantidade de direitos de horas gratuitas por núcleo que você obtém para sua conta.

Importante

Para obter mais informações sobre os direitos da sua conta do GitHub, consulte Codespaces do GitHub mensalmente incluídos armazenamento e horas principais.

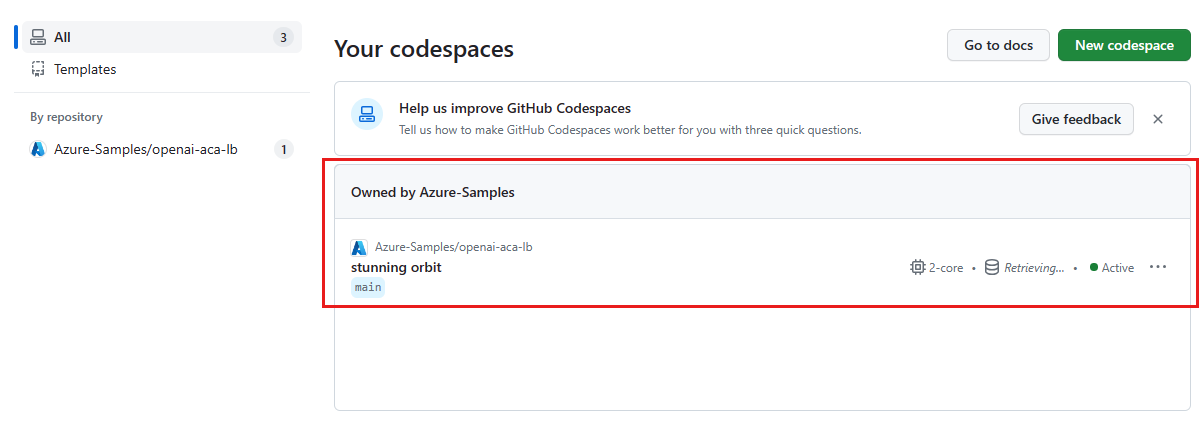

Entre no painel do GitHub Codespaces (https://github.com/codespaces).

Localize seus Codespaces atualmente em execução provenientes do

azure-samples/openai-aca-lbrepositório GitHub.

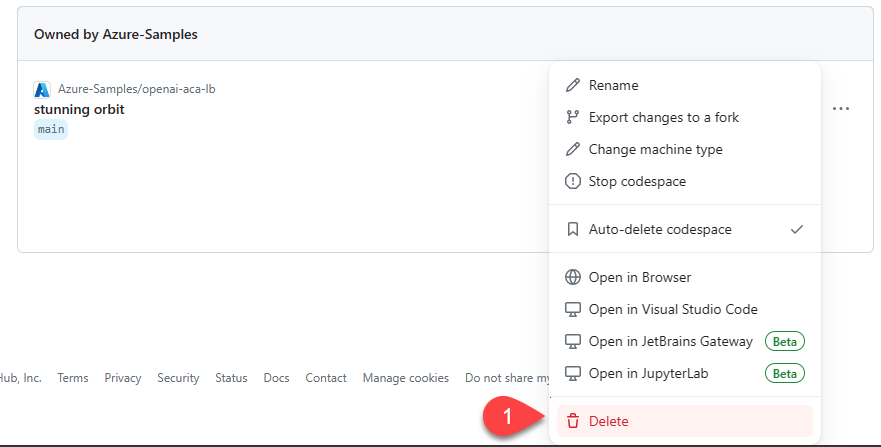

Abra o menu de contexto do espaço de código e selecione Excluir.

Obter ajuda

Se você tiver problemas para implantar o balanceador de carga do Gerenciamento de API do Azure, registre seu problema nos Problemas do repositório.

Código de exemplo

Os exemplos usados neste artigo incluem:

Próximo passo

- Usar o Teste de Carga do Azure para carregar seu aplicativo de chat