Tutorial Lakehouse: Criar uma lakehouse, ingerir dados de amostra e criar um relatório

Neste tutorial, você cria uma casa de lago, ingere dados de amostra na tabela Delta, aplica transformação quando necessário e, em seguida, cria relatórios. Neste tutorial, vai aprender a:

- Criar uma casa de lago no Microsoft Fabric

- Baixar e ingerir dados de amostra do cliente

- Adicionar tabelas ao modelo semântico

- Criar um relatório

Se não tiveres o Microsoft Fabric, inscreve-te para uma capacidade de avaliação gratuita .

Pré-requisitos

- Antes de criar uma casa de lago, você deve criar um espaço de trabalho de malha.

- Antes de ingerir um arquivo CSV, você deve ter o OneDrive configurado. Se não tiver o OneDrive configurado, inscreva-se na versão de avaliação gratuita do Microsoft 365: Avaliação gratuita - Experimente o Microsoft 365 durante um mês.

Criar uma casa no lago

Nesta seção, você cria uma casa de lago no Fabric.

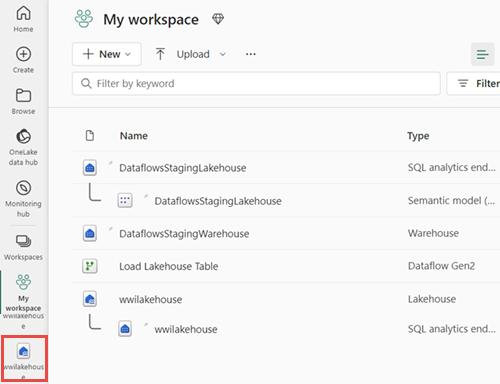

No Fabric, selecione Workspaces na barra de navegação.

Para abrir seu espaço de trabalho, digite seu nome na caixa de pesquisa localizada na parte superior e selecione-o nos resultados da pesquisa.

No espaço de trabalho, selecione Novo iteme, em seguida, selecione Lakehouse.

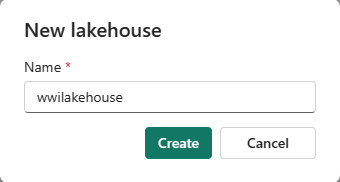

Na caixa de diálogo New lakehouse, digite wwilakehouse no campo Nome.

Selecione Criar para criar e abrir a nova casa do lago.

Ingerir dados de exemplo

Nesta seção, você ingere dados de amostra do cliente na casa do lago.

Nota

Se não tiver o OneDrive configurado, inscreva-se na versão de avaliação gratuita do Microsoft 365: Avaliação gratuita - Experimente o Microsoft 365 durante um mês.

Baixe o arquivo de dimension_customer.csv do repositório de amostras de malha.

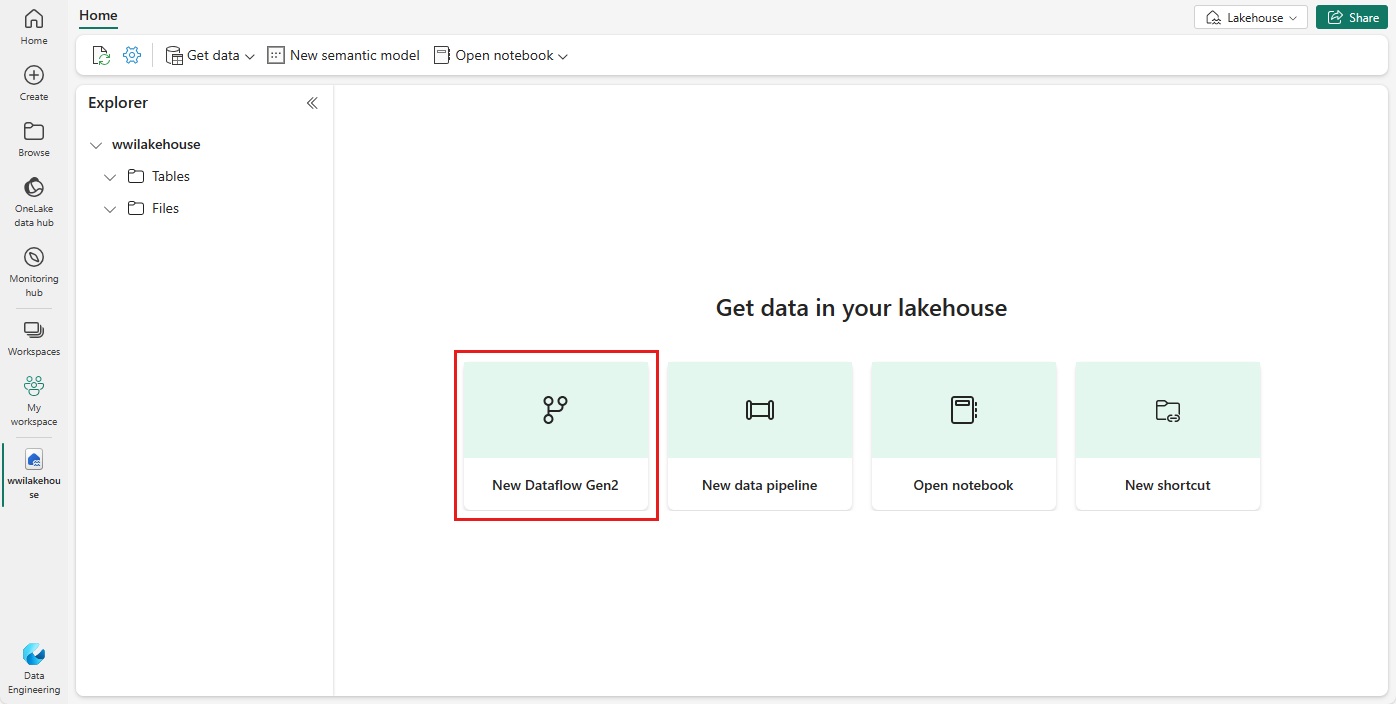

Na guia Página Inicial, em Obter dados em sua casa do lago, você verá opções para carregar dados na casa do lago. Selecione New Dataflow Gen2.

Na nova tela de fluxo de dados, selecione Importar de um arquivo de texto/CSV.

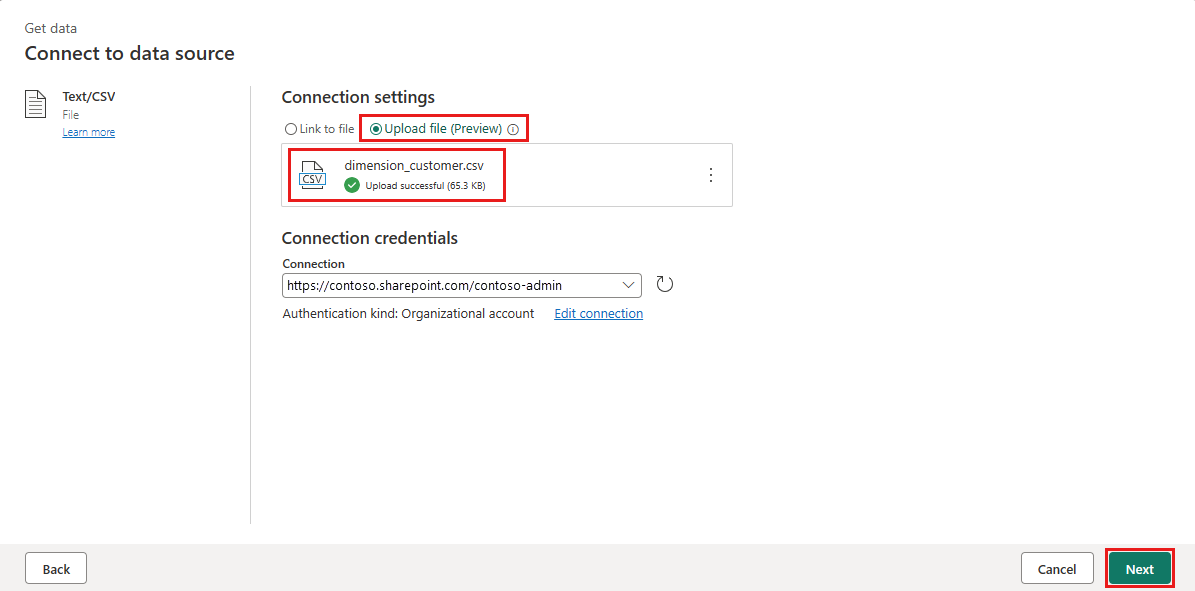

Na tela Conectar à fonte de dados, selecione o botão de opção Carregar arquivo. Arraste e solte o arquivo dimension_customer.csv que você baixou na etapa 1. Depois que o arquivo for carregado, selecione Avançar.

Na página Visualizar dados do arquivo, visualize os dados e selecione Criar para continuar e retornar à tela de fluxo de dados.

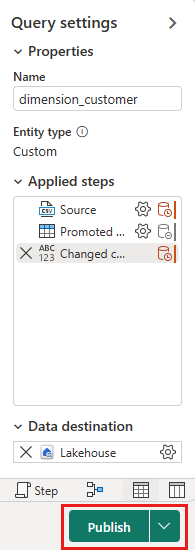

No painel Configurações de consulta , atualize o campo Nome para dimension_customer.

Nota

A malha adiciona um espaço e um número no final do nome da tabela por padrão. Os nomes das tabelas devem ser minúsculos e não devem conter espaços. Renomeie-o adequadamente e remova todos os espaços do nome da tabela.

Neste tutorial, você associou os dados do cliente a uma casa de lago. Se você tiver outros itens de dados que deseja associar à casa do lago, poderá adicioná-los:

Nos itens de menu, selecione Adicionar destino de dados e selecione Lakehouse. No ecrã Ligar ao destino dos dados, inicie sessão na sua conta, se necessário, e selecione Seguinte.

Navegue até a wwilakehouse em seu espaço de trabalho.

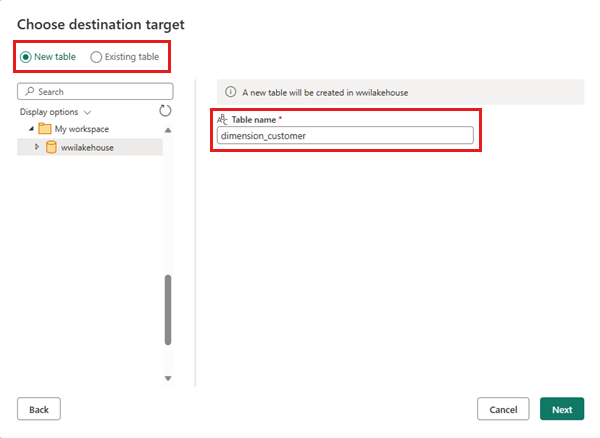

Se a tabela dimension_customer não existir, selecione a configuração Nova tabela e insira o nome da tabela dimension_customer. Se a tabela já existir, selecione a configuração Tabela existente e escolha dimension_customer na lista de tabelas no pesquisador de objetos. Selecione Seguinte.

No painel Escolher configurações de destino, selecione Substituir como método de atualização. Selecione Salvar configurações para retornar à tela de fluxo de dados.

A partir da tela de fluxo de dados, você pode facilmente transformar os dados com base em seus requisitos de negócios. Para simplificar, não estamos fazendo nenhuma alteração neste tutorial. Para continuar, selecione Publicar no canto inferior direito da tela.

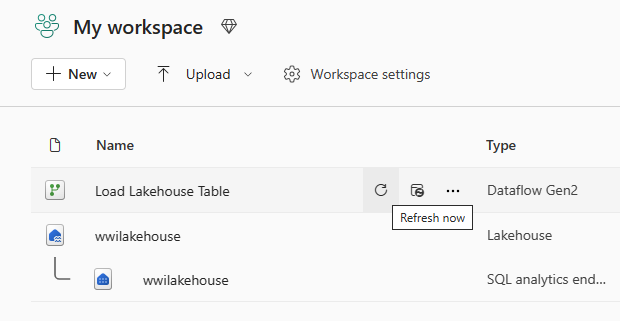

Um círculo giratório ao lado do nome do fluxo de dados indica que a publicação está em andamento na exibição de item. Quando a publicação estiver concluída, selecione o botão ... e selecione Propriedades. Renomeie o fluxo de dados para Load Lakehouse Table e selecione Salvar.

Selecione a opção Atualizar agora ao lado do nome do fluxo de dados para atualizar o fluxo de dados. Esta opção executa o fluxo de dados e move os dados do arquivo de origem para a tabela lakehouse. Enquanto estiver em andamento, você verá um círculo giratório em Coluna atualizada na exibição de item.

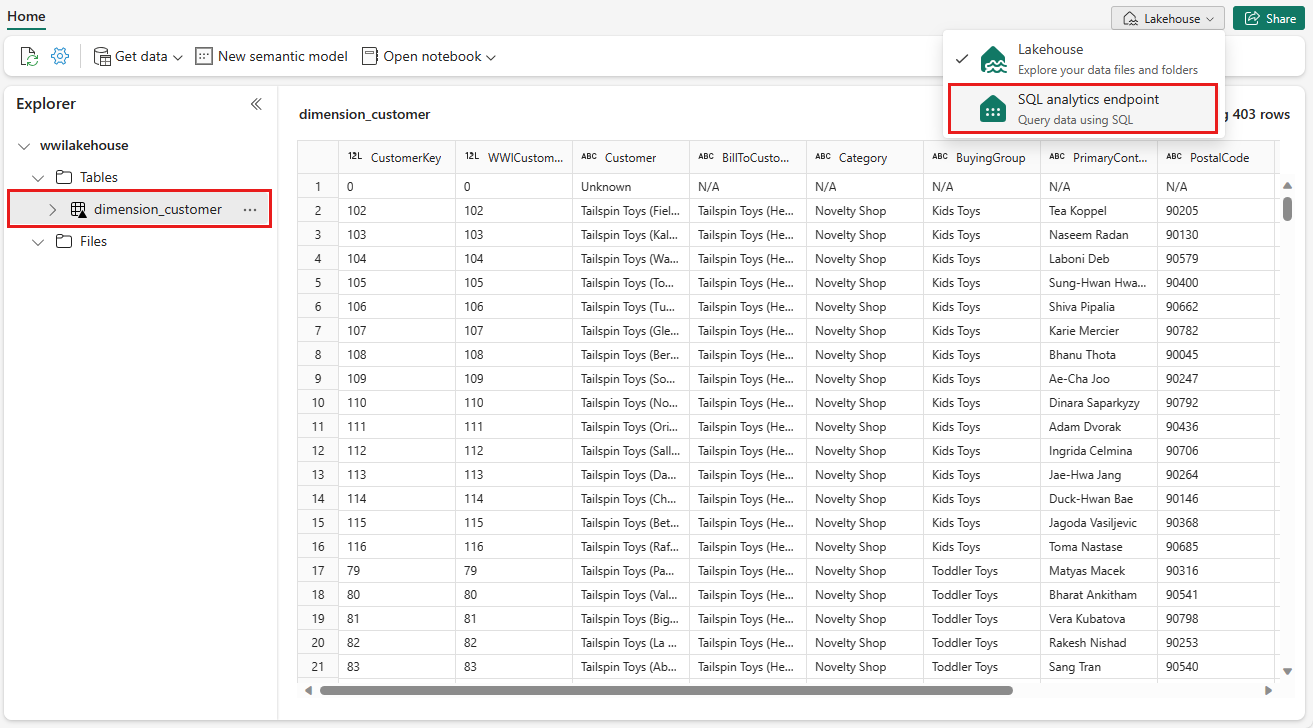

Depois que o fluxo de dados for atualizado, selecione sua nova casa do lago na barra de navegação para visualizar a tabela Delta dimension_customer.

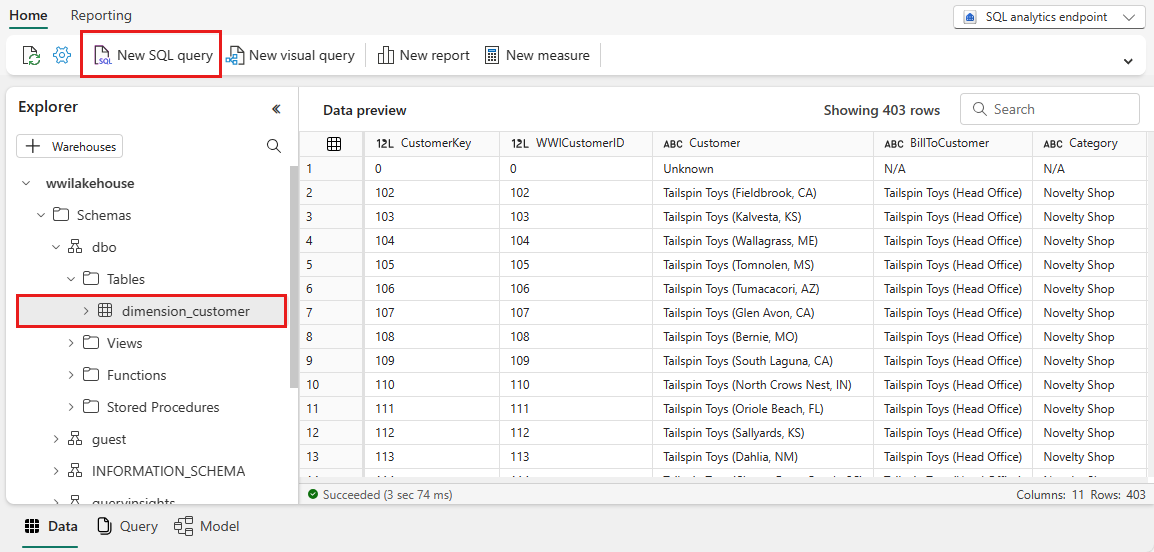

Selecione a tabela para visualizar seus dados. Você também pode usar o ponto de extremidade de análise SQL do lakehouse para consultar os dados com instruções SQL. Selecione o ponto de extremidade de análise SQL no menu suspenso de Lakehouse no canto superior direito da tela.

Selecione a tabela dimension_customer para visualizar seus dados ou selecione Nova consulta SQL para escrever suas instruções SQL.

A consulta de exemplo a seguir agrega a contagem de linhas com base na coluna BuyingGroup da tabela dimension_customer . Os arquivos de consulta SQL são salvos automaticamente para referência futura, e você pode renomear ou excluir esses arquivos com base em sua necessidade.

Para executar o script, selecione o ícone Executar na parte superior do arquivo de script.

SELECT BuyingGroup, Count(*) AS Total FROM dimension_customer GROUP BY BuyingGroup

Criar um relatório

Nesta seção, você criará um relatório a partir dos dados ingeridos.

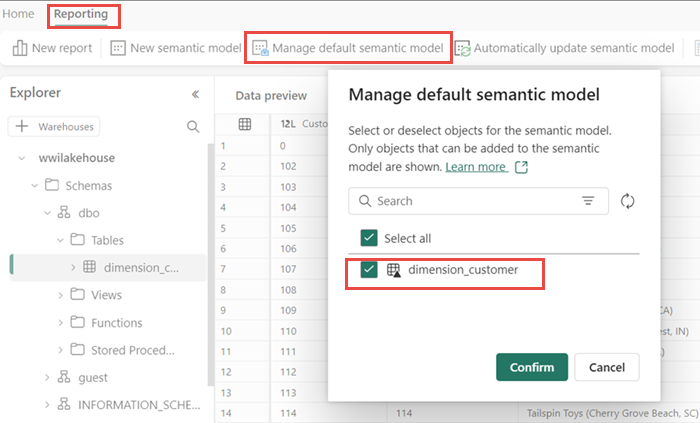

Anteriormente, todas as tabelas e vistas da lakehouse eram automaticamente adicionadas ao modelo semântico. Com atualizações recentes, para novas casas de lago, você deve adicionar manualmente suas tabelas ao modelo semântico. Abra seu lakehouse e alterne para a visualização do ponto de extremidade da análise SQL. Na guia Relatórios, selecione Gerenciar modelo semântico padrão e selecione as tabelas que deseja adicionar ao modelo semântico. Nesse caso, selecione a tabela dimension_customer .

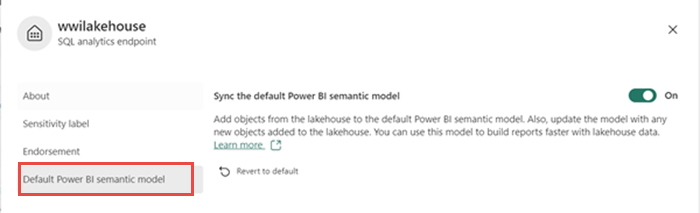

Para garantir que as tabelas no modelo semântico estejam sempre sincronizadas, alterne para a exibição do ponto de extremidade da análise SQL e abra o painel de configurações do lakehouse. Selecione Modelo semântico padrão do Power BI e ative Sincronizar o modelo semântico padrão do Power BI. Para obter mais informações, consulte Modelos semânticos padrão do Power BI.

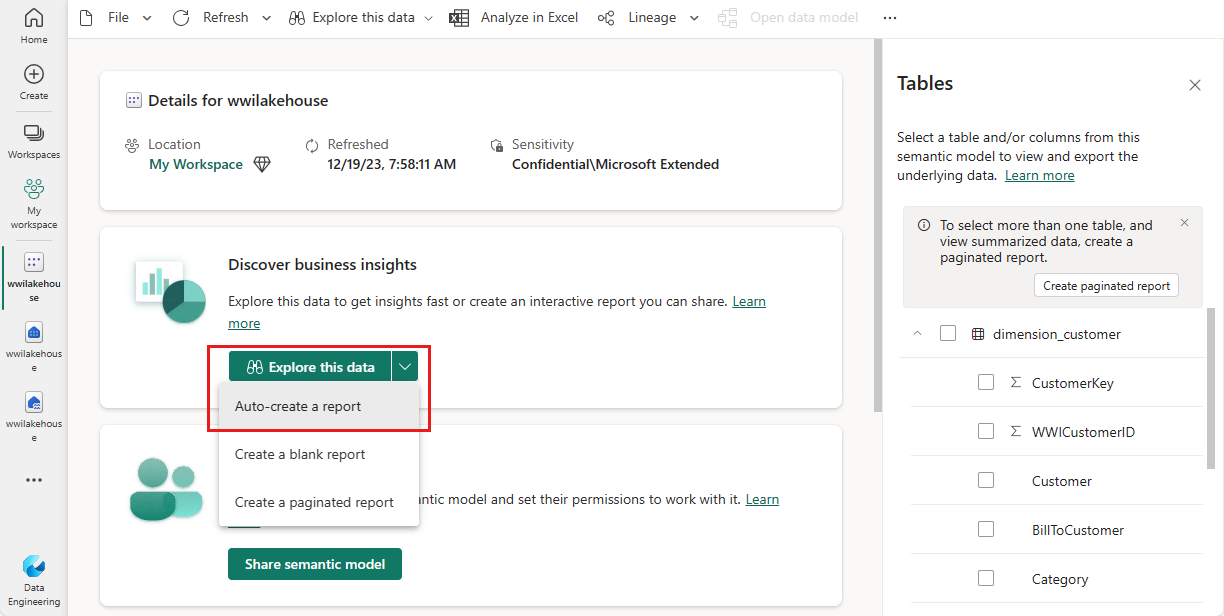

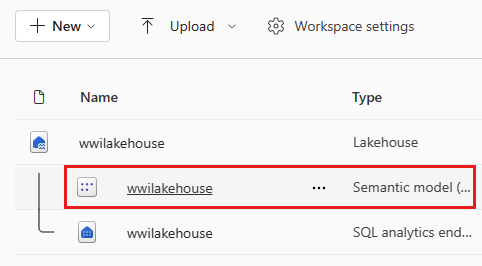

Depois que a tabela é adicionada, o Fabric cria um modelo semântico com o mesmo nome da lakehouse.

No painel do modelo semântico, você pode exibir todas as tabelas. Você tem opções para criar relatórios do zero, relatórios paginados ou permitir que o Power BI crie automaticamente um relatório com base em seus dados. Para este tutorial, em Explorar estes dados, selecione Criar automaticamente um relatório. No próximo tutorial, criamos um relatório do zero.

Como a tabela é uma dimensão e não há medidas nela, o Power BI cria uma medida para a contagem de linhas e a agrega em colunas diferentes e cria gráficos diferentes, conforme mostrado na imagem a seguir. Você pode salvar este relatório para o futuro selecionando Salvar na faixa de opções superior. Você pode fazer mais alterações neste relatório para atender às suas necessidades, incluindo ou excluindo outras tabelas ou colunas.