Como acessar fontes de dados locais no Data Factory for Microsoft Fabric

O Data Factory for Microsoft Fabric é um poderoso serviço de integração de dados baseado em nuvem que permite criar, agendar e gerenciar fluxos de trabalho para várias fontes de dados. Em cenários em que suas fontes de dados estão localizadas localmente, a Microsoft fornece o Gateway de Dados Local para preencher com segurança a lacuna entre seu ambiente local e a nuvem. Este documento orienta você pelo processo de acesso a fontes de dados locais no Data Factory for Microsoft Fabric usando o Gateway de Dados Local.

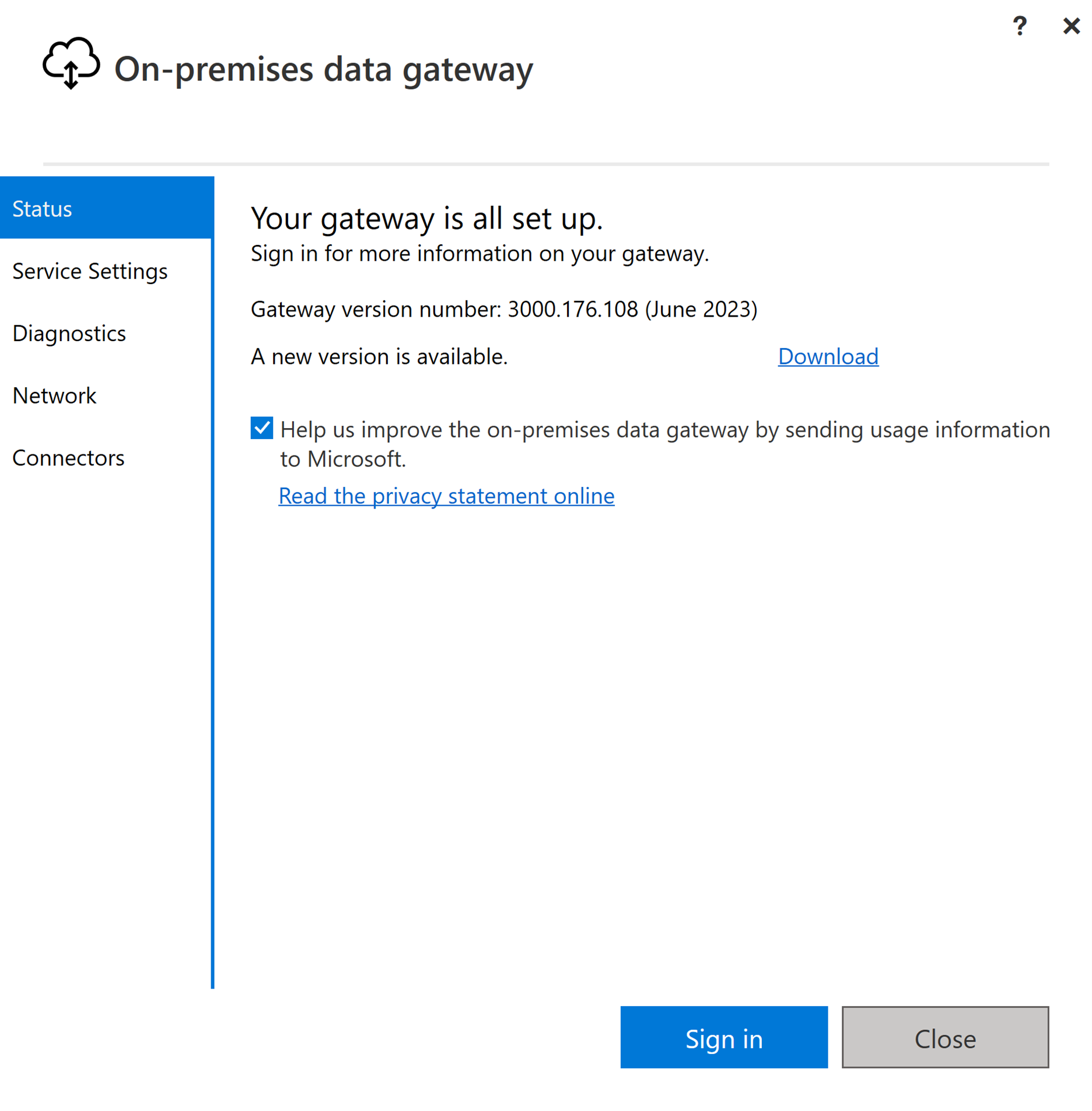

Criar um gateway de dados local

Um gateway de dados local é um aplicativo de software projetado para ser instalado em um ambiente de rede local. Ele fornece um meio de instalar diretamente o gateway em sua máquina local. Para obter instruções detalhadas sobre como baixar e instalar o gateway de dados local, consulte Instalar um gateway de dados local.

Entre usando sua conta de usuário para acessar o gateway de dados local, após o qual ele estará preparado para utilização.

Nota

Um gateway de dados local de versão maior ou igual a 3000.214.2 é necessário para dar suporte a pipelines de malha.

Criar uma conexão para sua fonte de dados local

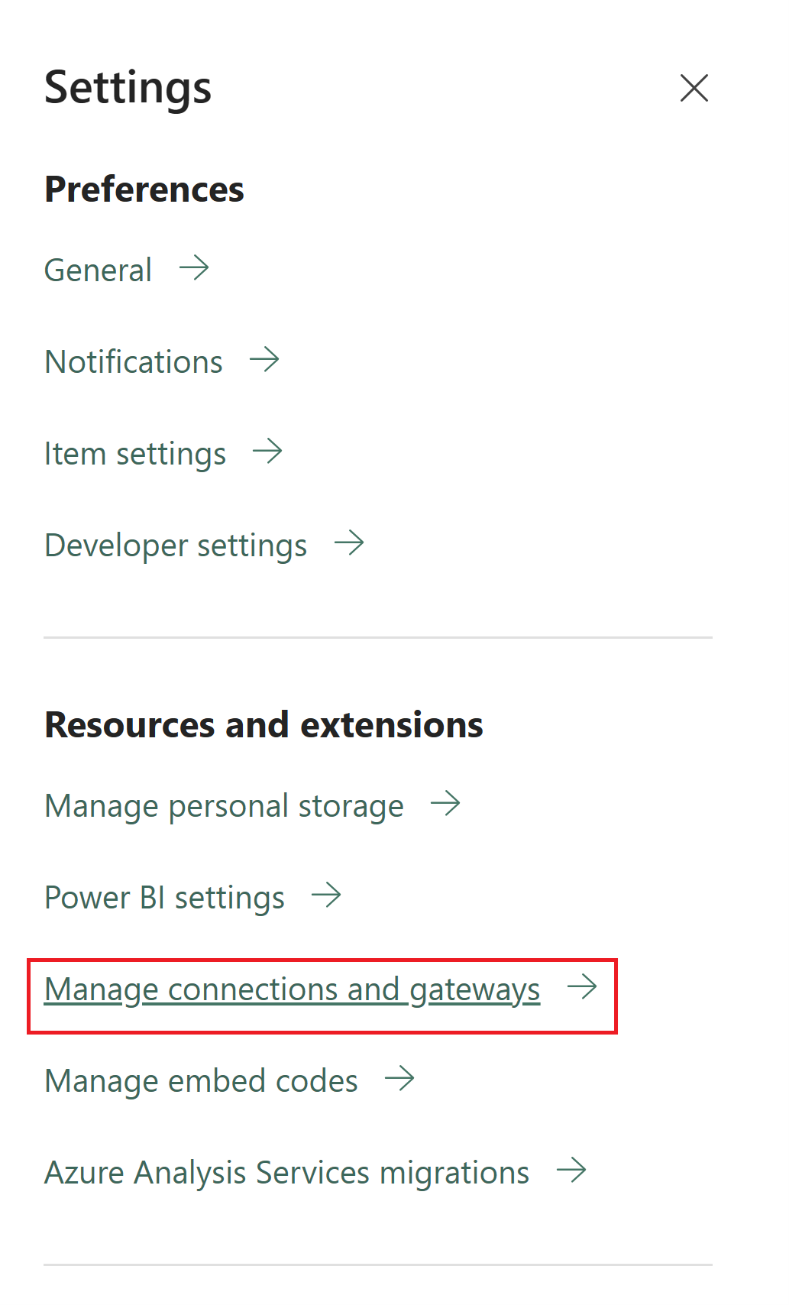

Navegue até o portal de administração e selecione o botão de configurações (um ícone que se parece com uma engrenagem) no canto superior direito da página. Em seguida, escolha Gerenciar conexões e gateways no menu suspenso exibido.

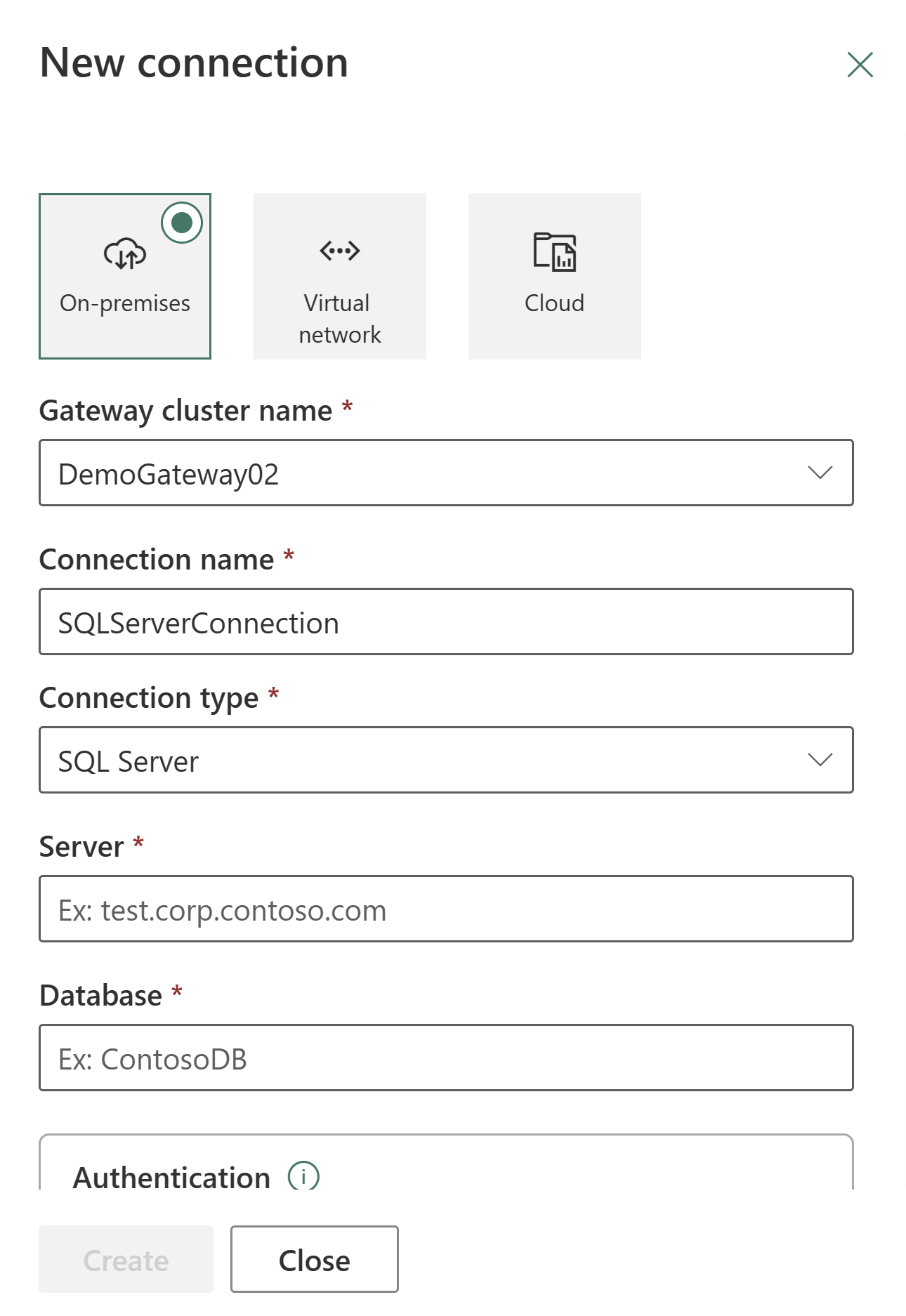

Na caixa de diálogo Nova conexão exibida, selecione Local e forneça seu cluster de gateway, juntamente com o tipo de recurso associado e informações relevantes.

Os tipos de conexão disponíveis suportados para conexões locais incluem:

- Entra ID

- Adobe Analytics

- Analysis Services

- Armazenamento de Blobs do Azure

- Azure Data Lake Storage Gen2

- Armazenamento de Tabelas do Azure

- Essbase

- Ficheiro

- Pasta

- Google Analytics

- IBM DB2

- MySQL

- OData

- ODBC

- OLEDB

- Oracle

- PostgreSQL

- Salesforce

- SAP Business Warehouse Message Server

- Servidor SAP Business Warehouse

- SAP HANA

- SharePoint

- SQL Server

- Sybase

- Teradata

- Web

Para obter uma lista abrangente dos conectores suportados para tipos de dados locais, consulte Conectores de pipeline de dados no Microsoft Fabric.

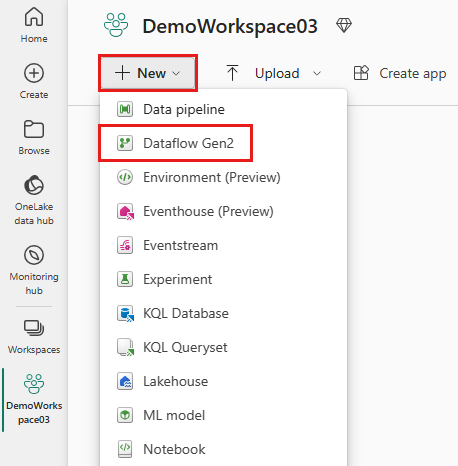

Conecte sua fonte de dados local a um Dataflow Gen2 no Data Factory for Microsoft Fabric

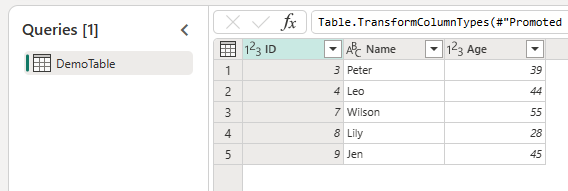

Vá para o seu espaço de trabalho e crie um Dataflow Gen2.

Adicione uma nova fonte ao fluxo de dados e selecione a conexão estabelecida na etapa anterior.

Você pode usar o Dataflow Gen2 para executar quaisquer transformações de dados necessárias com base em suas necessidades.

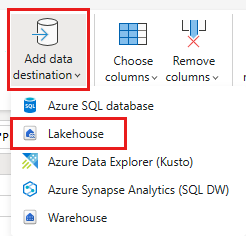

Utilize o botão Adicionar destino de dados no separador Base do editor do Power Query para adicionar um destino para os seus dados a partir da origem local.

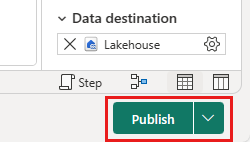

Publique o Dataflow Gen2.

Agora você criou um Dataflow Gen2 para carregar dados de uma fonte de dados local em um destino na nuvem.

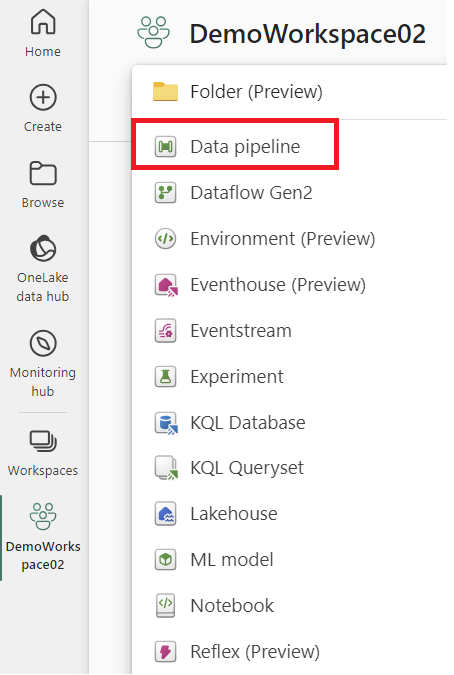

Usando dados locais em um pipeline

Vá para o seu espaço de trabalho e crie um pipeline de dados.

Nota

Você precisa configurar o firewall para permitir conexões de saída *.frontend.clouddatahub.net do gateway para recursos de pipeline de malha.

Na guia Página Inicial do editor de pipeline, selecione Copiar dados e, em seguida, Usar assistente de cópia. Adicione uma nova fonte à atividade na página Escolher fonte de dados do assistente e, em seguida, selecione a conexão estabelecida na etapa anterior.

Selecione um destino para seus dados na fonte de dados local.

Executar o pipeline.

Agora você criou e executou um pipeline para carregar dados de uma fonte de dados local em um destino na nuvem.

Nota

O acesso local à máquina com o gateway de dados no local instalado não é permitido em fluxos de dados.