Transformar dados executando uma atividade de Definição de Trabalho do Spark

A atividade Definição de Trabalho do Spark no Data Factory para Microsoft Fabric permite criar conexões com suas Definições de Trabalho do Spark e executá-las a partir de um pipeline de dados.

Pré-requisitos

Para começar, você deve preencher os seguintes pré-requisitos:

- Uma conta de locatário com uma assinatura ativa. Crie uma conta gratuitamente.

- Um espaço de trabalho é criado.

Adicionar uma atividade de Definição de Trabalho do Spark a um pipeline com a interface do usuário

Crie um novo pipeline de dados em seu espaço de trabalho.

Procure a Definição de Trabalho do Spark no cartão da tela inicial e selecione-a ou escolha a atividade na barra de Atividades para adicioná-la ao painel do pipeline.

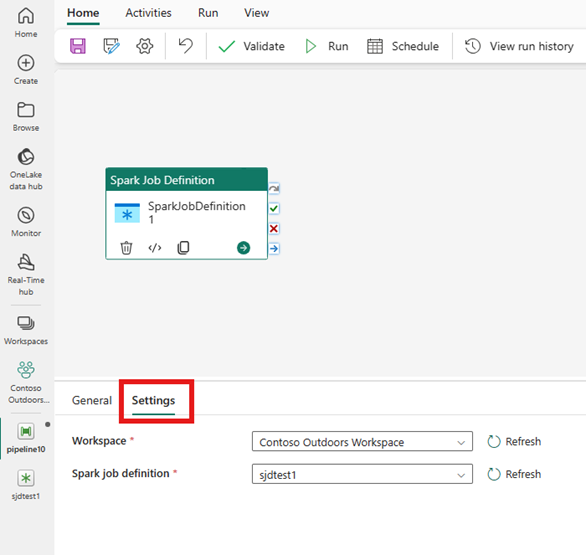

Selecione a nova atividade Definição de Tarefa do Spark na área do editor de pipeline se ainda não estiver selecionada.

Consulte as orientações das Configurações gerais para configurar as opções encontradas na guia Configurações gerais.

Configurações de atividade do Spark Job Definition

Selecione a guia Configurações de no painel de propriedades da atividade e, em seguida, selecione o Espaço de Trabalho de Malha que contém a Definição de Trabalho do Spark que você deseja executar.

Limitações conhecidas

As limitações atuais na atividade Definição de trabalho do Spark para o Fabric Data Factory estão listadas aqui. Esta secção está sujeita a alterações.

- No momento, não há suporte para a criação de uma nova atividade de Definição de Trabalho do Spark dentro da atividade (em Configurações)

- O suporte à parametrização não está disponível.

- Embora ofereçamos suporte ao monitoramento da atividade por meio da guia saída, você ainda não pode monitorar a definição de trabalho do Spark em um nível mais granular. Por exemplo, os links para a página de monitorização, estado, duração e execuções anteriores da Definição de Tarefas do Spark não estão disponíveis diretamente no Data Factory. No entanto, pode ver detalhes mais granulares na página de monitorização da definição de trabalho do Spark .

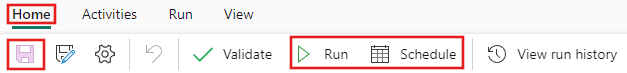

Salvar e executar ou agendar o pipeline

Depois de configurar quaisquer outras atividades necessárias para o pipeline, alterne para a guia Página Inicial na parte superior do editor de pipeline e selecione o botão Salvar para salvar o pipeline. Selecione Executar para executá-lo diretamente, ou selecione Agendar para agendá-lo. Você também pode visualizar o histórico de execução aqui ou definir outras configurações.