Cenário completo do Data Factory: introdução e arquitetura

Este tutorial ajuda você a acelerar o processo de avaliação do Data Factory no Microsoft Fabric, fornecendo uma orientação passo a passo para um cenário completo de integração de dados em uma hora. Ao final deste tutorial, você entende o valor e os principais recursos do Data Factory e sabe como concluir um cenário comum de integração de dados de ponta a ponta.

Visão geral: Por que o Data Factory no Microsoft Fabric?

Esta seção ajuda você a entender a função do Fabric em geral e o papel que o Data Factory desempenha nele.

Compreender o valor do Microsoft Fabric

O Microsoft Fabric fornece um balcão único para todas as necessidades analíticas de cada empresa. Ele abrange um espectro completo de serviços, incluindo movimentação de dados, data lake, engenharia de dados, integração de dados e ciência de dados, análise em tempo real e business intelligence. Com o Fabric, não há necessidade de unir diferentes serviços de vários fornecedores. Em vez disso, seus usuários desfrutam de um produto completo, altamente integrado, único e abrangente que é fácil de entender, integrar, criar e operar.

Compreender o valor do Data Factory no Microsoft Fabric

O Data Factory in Fabric combina a facilidade de utilização do Power Query com a escala e o poder do Azure Data Factory. Ele reúne o melhor de ambos os produtos em uma experiência unificada. O objetivo é garantir que a integração de dados no Factory funcione bem para desenvolvedores de dados cidadãos e profissionais. Ele fornece experiências de preparação e transformação de dados low-code, habilitadas para IA, transformação em escala de petabytes, centenas de conectores com conectividade híbrida e multicloud. A Purview fornece governança, e o serviço apresenta compromissos de dados/operações em escala empresarial, CI/CD, gerenciamento do ciclo de vida do aplicativo e monitoramento.

Introdução - Entenda três recursos principais do Data Factory

- Ingestão de dados: a atividade de cópia em pipelines permite mover dados em escala de petabytes de centenas de fontes de dados para seus dados Lakehouse para processamento posterior.

- Transformação e preparação de dados: o Dataflow Gen2 fornece uma interface low-code para transformar seus dados usando transformações de dados 300+, com a capacidade de carregar os resultados transformados em vários destinos, como bancos de dados SQL do Azure, Lakehouse e muito mais.

- Automação de fluxo de integração de ponta a ponta: os pipelines fornecem orquestração de atividades que incluem atividades de cópia, fluxo de dados e bloco de anotações, e muito mais. Isso permite que você gerencie as atividades em um só lugar. As atividades em um pipeline podem ser encadeadas para operar sequencialmente ou podem operar de forma independente em paralelo.

Neste caso de uso de integração de dados de ponta a ponta, você aprende:

- Como ingerir dados usando o assistente de cópia em um pipeline

- Como transformar os dados usando um fluxo de dados com uma experiência sem código ou escrevendo seu próprio código para processar os dados com uma atividade de Script ou Bloco de Anotações

- Como automatizar todo o fluxo de integração de dados de ponta a ponta usando um pipeline com gatilhos e atividades flexíveis de fluxo de controle.

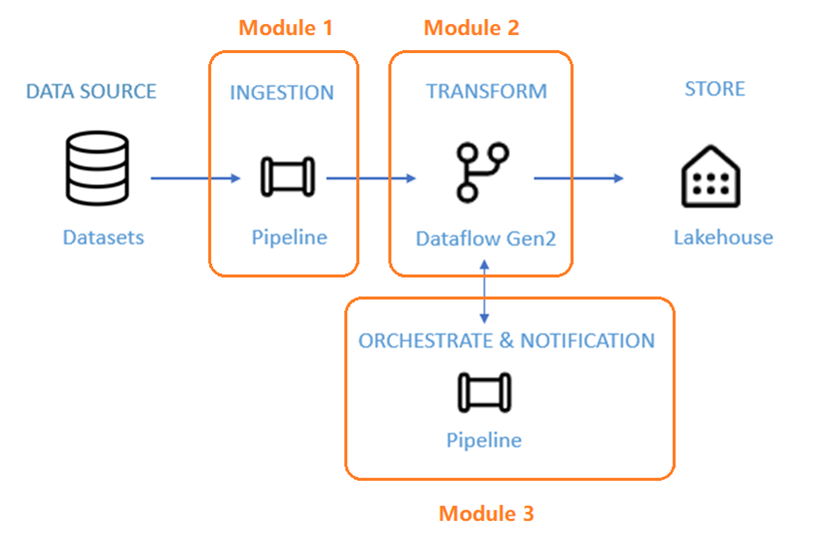

Arquitetura

Nos próximos 50 minutos, você terá a tarefa de concluir um cenário de integração de dados de ponta a ponta. Isso inclui ingerir dados brutos de um armazenamento de origem na tabela Bronze de uma Lakehouse, processar todos os dados, movê-los para a tabela Gold da Lakehouse de dados, enviar um e-mail para notificá-lo assim que todos os trabalhos forem concluídos e, finalmente, configurar todo o fluxo para ser executado de forma programada.

O cenário está dividido em três módulos:

- Módulo 1: Crie um pipeline com o Data Factory para ingerir dados brutos de um armazenamento de Blob para uma tabela Bronze em um data Lakehouse.

- Módulo 2: Transforme dados com um fluxo de dados no Data Factory para processar os dados brutos da sua tabela Bronze e movê-los para uma tabela Gold no Lakehouse de dados.

- Módulo 3: Conclua sua primeira jornada de integração de dados para enviar um e-mail para notificá-lo assim que todos os trabalhos forem concluídos e, finalmente, configure todo o fluxo para ser executado de forma programada.

Use o conjunto de dados de exemplo NYC-Taxi como a fonte de dados para o tutorial. Depois de terminar, você poderá obter informações sobre descontos diários em tarifas de táxi por um período de tempo específico usando o Data Factory no Microsoft Fabric.

Conteúdos relacionados

Nesta introdução ao nosso tutorial completo para sua primeira integração de dados usando o Data Factory no Microsoft Fabric, você aprendeu:

- O valor e a função do Microsoft Fabric

- O valor e a função do Data Factory na malha

- Principais características do Data Factory

- O que você vai aprender neste tutorial

Continue para a próxima seção agora para criar seu pipeline de dados.