Mover dados do Banco de Dados SQL do Azure para o Lakehouse por meio do assistente de cópia

Este tutorial descreve as etapas para mover dados para o Lakehouse.

Duas abordagens são fornecidas usando o assistente de cópia:

- A primeira abordagem move os dados de origem para tabelas de destino com formato delta.

- A segunda abordagem move os dados de origem para os arquivos de destino.

Pré-requisitos

Para começar, você deve preencher os seguintes pré-requisitos:

- Uma conta de locatário com uma assinatura ativa. Crie uma conta gratuitamente.

- Um espaço de trabalho é criado.

- Uma Lakehouse é criada em seu espaço de trabalho.

Mova arquivos para o Lakehouse como tabelas em formato delta através do assistente de cópia

Siga estas etapas para configurar sua atividade de cópia.

Passo 1: Comece com o assistente de cópia

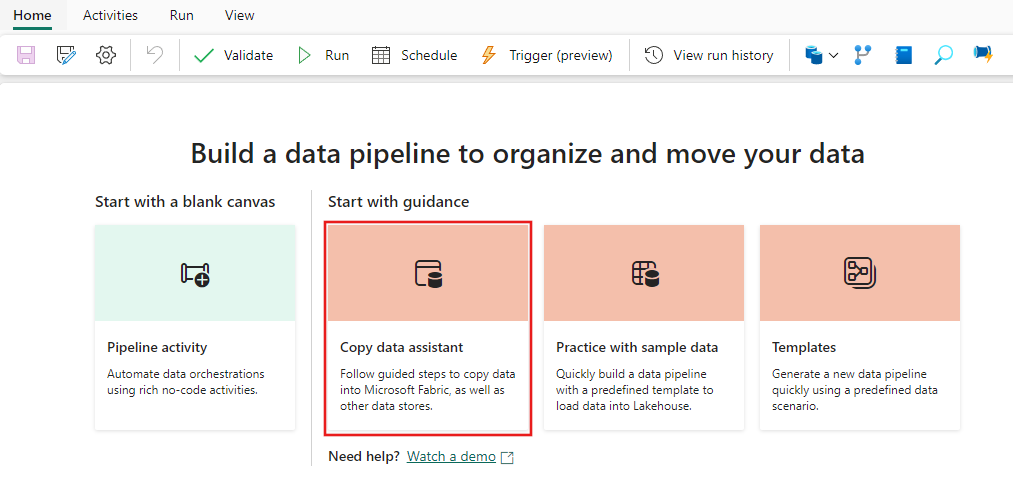

Abra um pipeline de dados existente ou crie um novo pipeline de dados.

Selecione Copiar assistente de dados na tela para abrir o assistente e começar. Ou selecione Usar assistente de cópia na lista suspensa Copiar dados na guia Atividades da faixa de opções.

Etapa 2: Configurar a origem

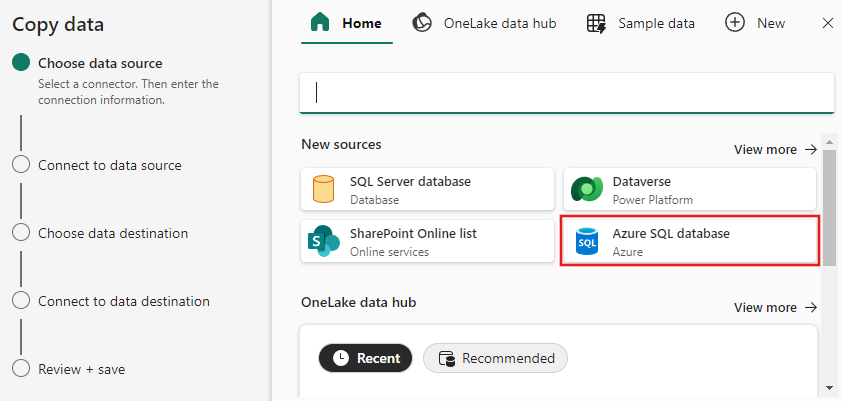

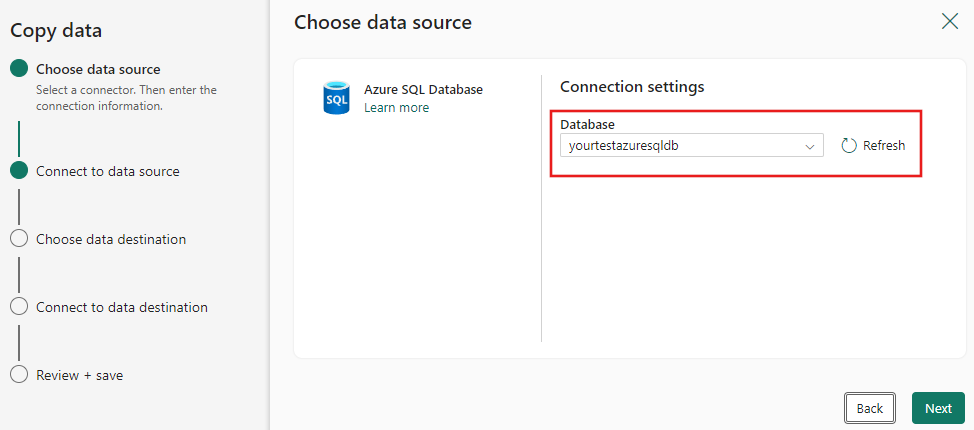

Escolha sua fonte de dados escolhendo um tipo de fonte de dados. Neste tutorial, usaremos o Banco de Dados SQL do Azure como exemplo. Pesquise na tela Escolher fonte de dados para localizar e selecionar Banco de Dados SQL do Azure.

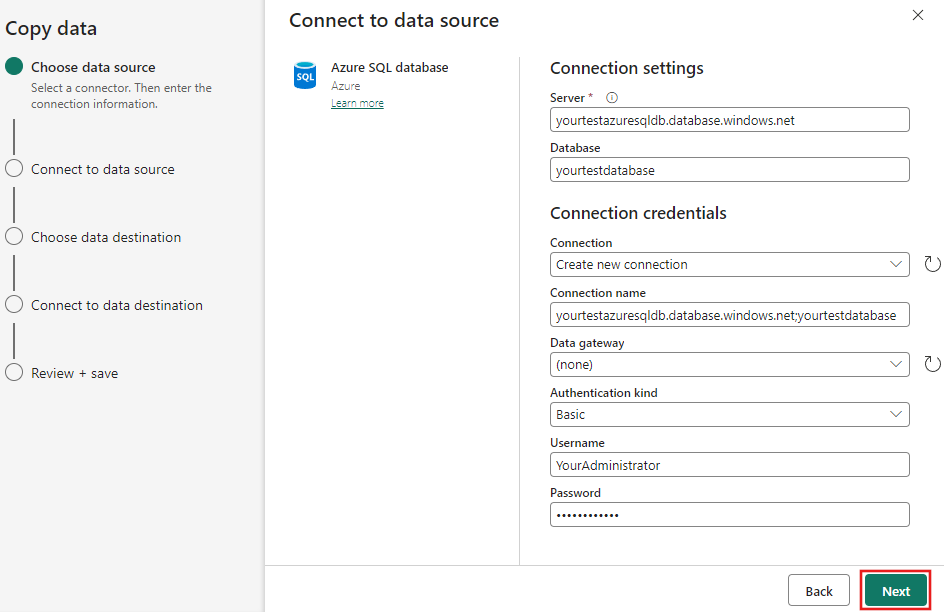

Crie uma conexão com sua fonte de dados preenchendo as informações de conexão necessárias no painel.

Depois de preencher as informações de conexão necessárias no painel, selecione Avançar.

Se você ainda não selecionou um banco de dados inicialmente, uma lista de bancos de dados será apresentada para você selecionar.

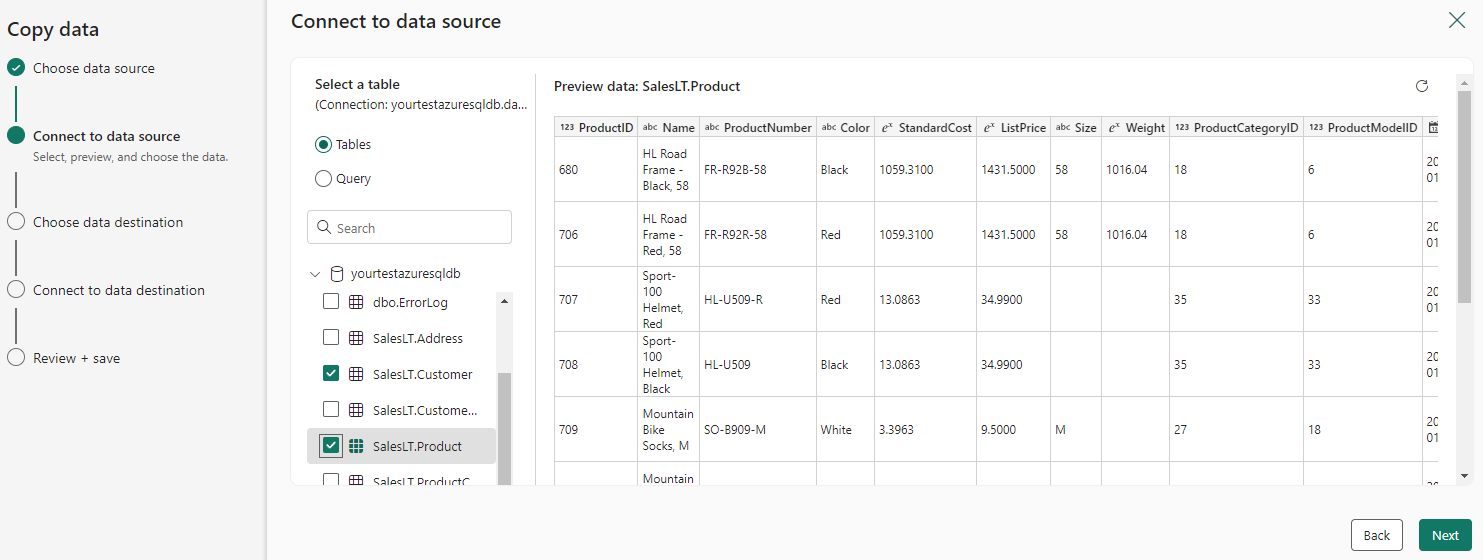

Selecione a(s) tabela(s) a ser movida(s). Em seguida, selecione Seguinte.

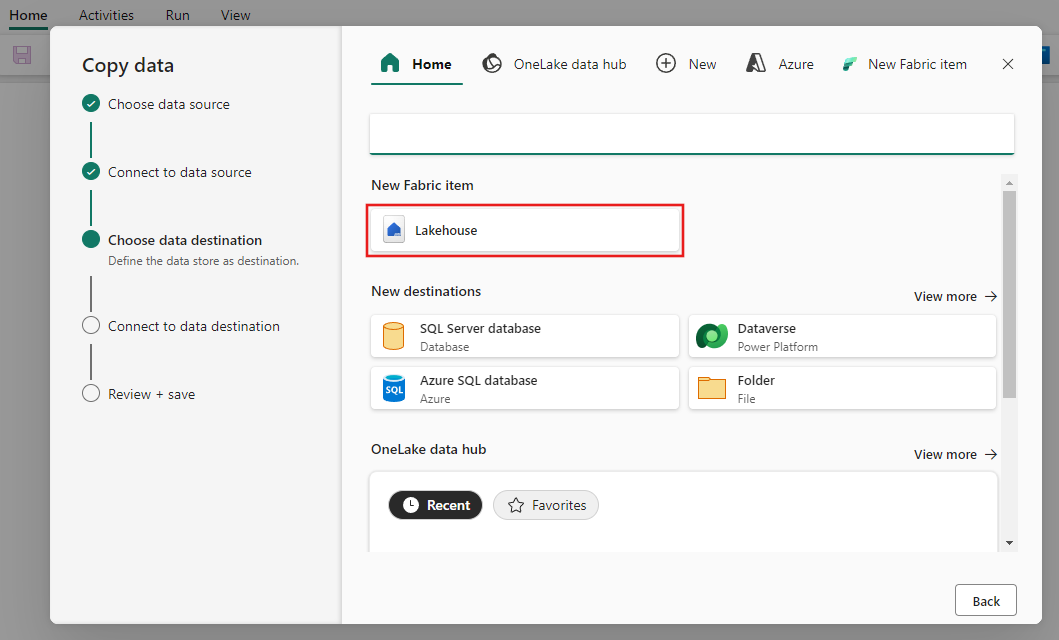

Etapa 3: Configurar seu destino

Escolha Lakehouse como seu destino e, em seguida, selecione Avançar.

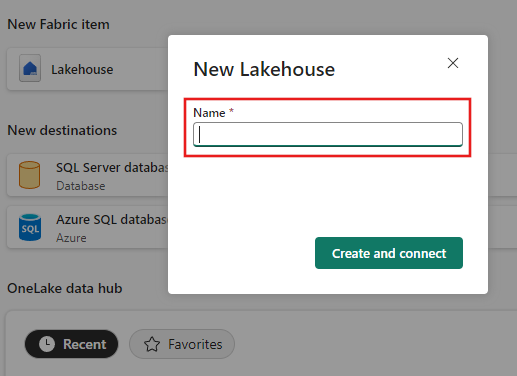

Insira um nome Lakehouse e selecione Criar e conectar.

Configure e mapeie seus dados de origem para a tabela Lakehouse de destino. Selecione Tabelas para a pasta raiz e Carregar para uma nova tabela para as configurações de carregamento. Forneça um nome de tabela e selecione Avançar.

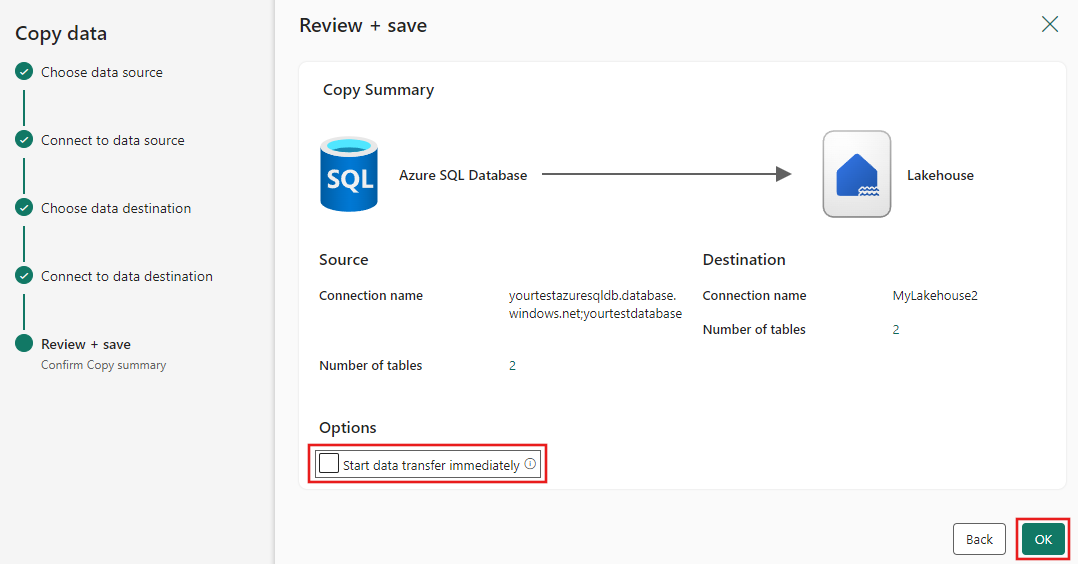

Reveja a sua configuração e desmarque a caixa de verificação Iniciar transferência de dados imediatamente . Em seguida, selecione Avançar para concluir a experiência do assistente.

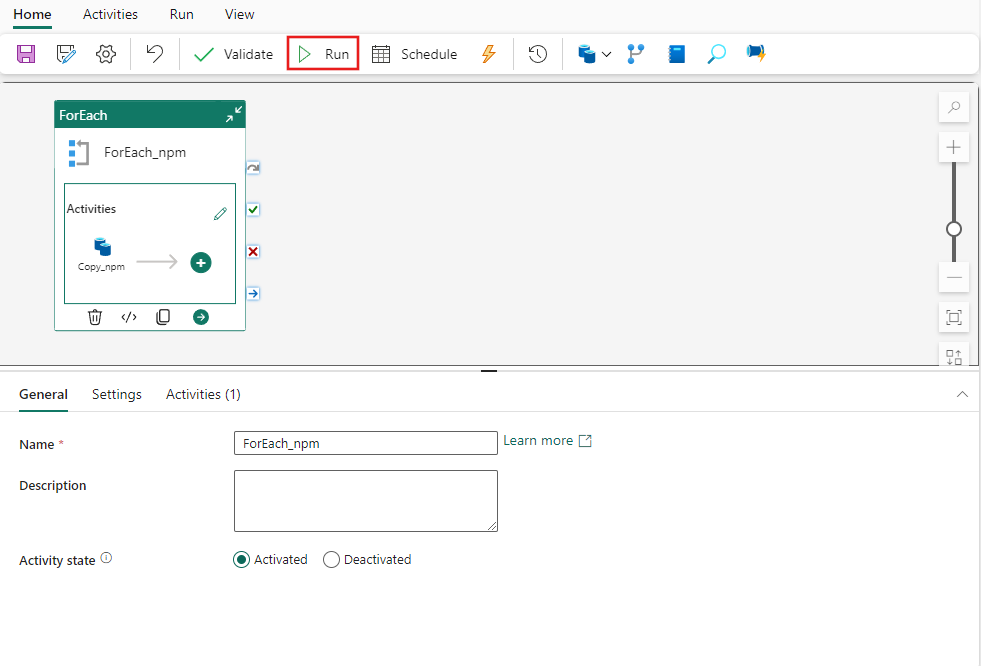

Etapa 4: Salve seu pipeline de dados e execute-o para carregar dados

Selecione Executar na barra de ferramentas Página Inicial e, em seguida, selecione Salvar e executar quando solicitado.

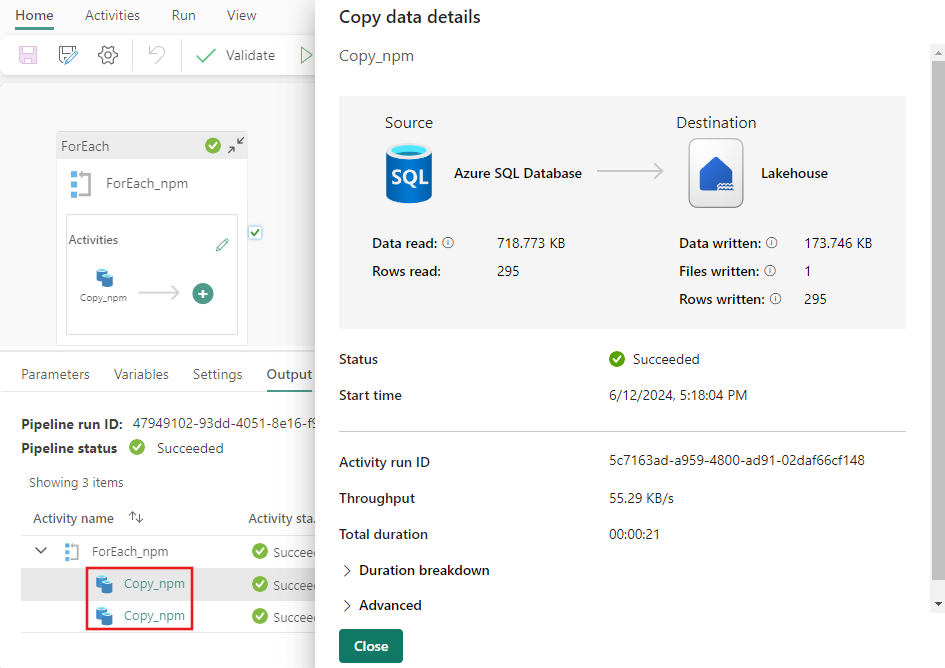

Para cada atividade que foi executada, você pode selecionar o link correspondente da atividade na guia Saída depois que o pipeline for executado para exibir os detalhes da atividade. Neste caso, temos 2 atividades de cópia individuais que foram executadas - uma para cada tabela copiada do SQL Azure para o Lakehouse. Ao selecionar o link de detalhes da atividade, você pode ver quantos dados foram lidos e gravados e quanto espaço os dados consumiram na origem e no destino, bem como a velocidade de transferência e outros detalhes.

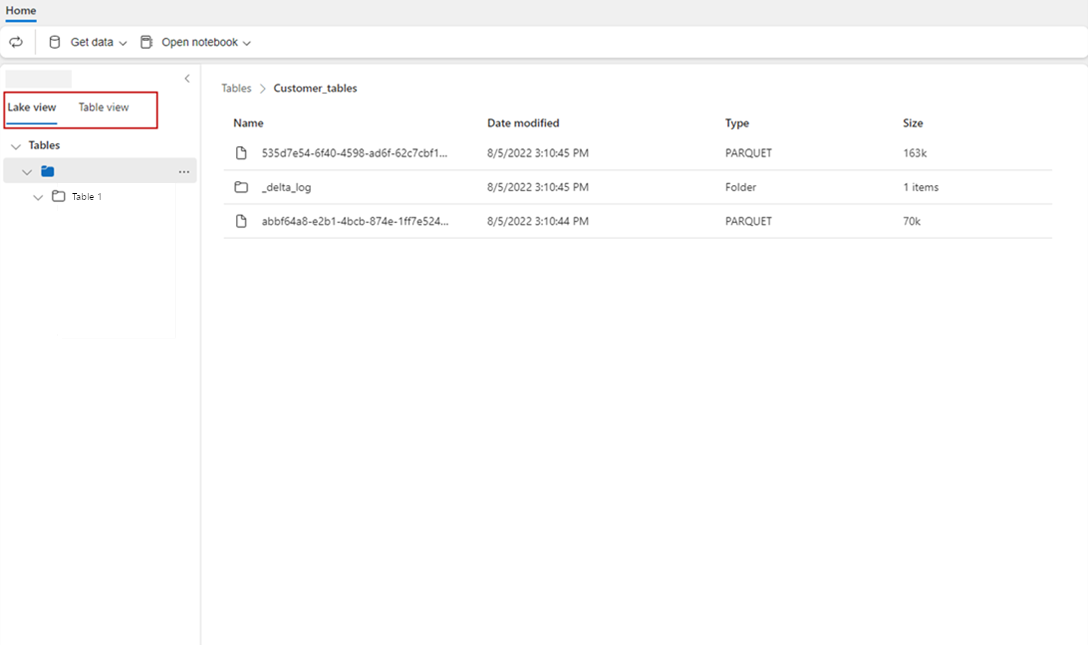

Passo 5: Veja as suas mesas a partir da Lakehouse

Vá para a sua Lakehouse e atualize a vista do Lago para ver os dados mais recentes ingeridos.

Alterne para o modo Tabela para exibir os dados na tabela.

Nota

Atualmente, os dados são enviados para as pastas Lakehouse Tables (uma área gerenciada) somente no formato Delta. Esses arquivos serão automaticamente registrados como uma tabela e ficarão visíveis na visualização Tabela do portal Lakehouse. Somente as pastas da primeira camada em Tabelas serão registradas como tabela delta. A navegação ou visualização a partir da Lakehouse Table ainda não é suportada. Os dados que são carregados na mesma tabela serão acrescentados. Excluir ou atualizar tabelas ainda não é suportado.

Conteúdos relacionados

Este exemplo mostra como mover dados do Banco de Dados SQL do Azure para o Lakehouse com o Assistente de Cópia no Data Factory for Microsoft Fabric. Aprendeu a:

- Mova arquivos para o Lakehouse como tabelas em formato delta com o Assistente de cópia.

Em seguida, avance para saber mais sobre como monitorar suas execuções de pipeline.