Delta Lake faz login no Warehouse no Microsoft Fabric

Aplica-se a:✅ Armazém no Microsoft Fabric

O Warehouse no Microsoft Fabric é construído em formatos de arquivo abertos. As tabelas de usuário são armazenadas no formato de arquivo parquet e os logs do Delta Lake são publicados para todas as tabelas de usuário.

Os logs do Delta Lake abrem acesso direto às tabelas de usuário do armazém para qualquer mecanismo que possa ler as tabelas do Delta Lake. Esse acesso é limitado a somente leitura para garantir que os dados do usuário mantenham a conformidade da transação ACID. Todas as inserções, atualizações e exclusões dos dados nas tabelas devem ser executadas através do Warehouse. Depois que uma transação é confirmada, um processo em segundo plano do sistema é iniciado para publicar o log Delta Lake atualizado para as tabelas afetadas.

Como obter o caminho OneLake

As etapas a seguir detalham como obter o caminho do OneLake de uma tabela em um depósito:

Abra o Warehouse no espaço de trabalho do Microsoft Fabric.

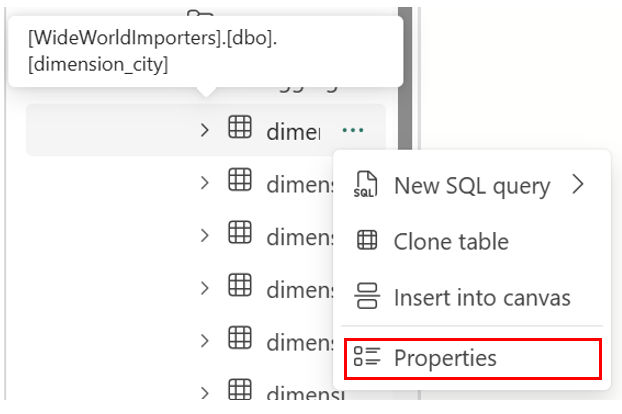

No Pesquisador de Objetos, você encontra mais opções (...) em uma tabela selecionada na pasta Tabelas . Selecione o menu Propriedades .

Na seleção, o painel Propriedades mostra as seguintes informações:

- Nome

- Formato

- Type

- URL

- Caminho relativo

- Trajetória ABFS

Como obter o caminho dos logs do Delta Lake

Você pode localizar os logs do Delta Lake através dos seguintes métodos:

Os logs do Delta Lake podem ser consultados por meio de atalhos criados em uma casa de lago. Você pode exibir os arquivos usando um Microsoft Fabric Spark Notebook ou o Lakehouse explorer no Synapse Data Engineering no portal do Microsoft Fabric.

Os logs do Delta Lake podem ser encontrados por meio do Gerenciador de Armazenamento do Azure, por meio de conexões Spark, como o modo Power BI Direct Lake, ou usando qualquer outro serviço que possa ler tabelas delta.

Os logs do Delta Lake podem ser encontrados na

_delta_logpasta de cada tabela através do OneLake Explorer no Windows, conforme mostrado na captura de tela a seguir.

Pausando a publicação de logs do Delta Lake

A publicação de logs do Delta Lake pode ser pausada e retomada, se necessário. Quando a publicação é pausada, os mecanismos do Microsoft Fabric que leem tabelas fora do Armazém veem os dados como eram antes da pausa. Ele garante que os relatórios permaneçam estáveis e consistentes, refletindo os dados de todas as tabelas tal como existiam antes de quaisquer alterações serem feitas nas tabelas. Quando as atualizações de dados estiverem concluídas, você poderá retomar a publicação do Delta Lake Log para tornar todas as alterações de dados recentes visíveis para outros mecanismos analíticos. Outro caso de uso para pausar a publicação de logs do Delta Lake é quando os usuários não precisam de interoperabilidade com outros mecanismos de computação no Microsoft Fabric, pois isso pode ajudar a economizar em custos de computação.

A sintaxe para pausar e retomar a publicação de log do Delta Lake é a seguinte:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED | AUTO

Exemplo: pausar e retomar a publicação de logs do Delta Lake

Para pausar a publicação de log do Delta Lake, use o seguinte trecho de código:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED

As consultas a tabelas de depósito no armazém atual de outros mecanismos do Microsoft Fabric (por exemplo, consultas de um Lakehouse) agora mostram uma versão dos dados como eram antes de pausar a publicação de logs do Delta Lake. As consultas de armazém ainda mostram a versão mais recente dos dados.

Para retomar a publicação de log do Delta Lake, use o seguinte trecho de código:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = AUTO

Quando o estado é alterado de volta para AUTO, o mecanismo Fabric Warehouse publica logs de todas as alterações recentes feitas em tabelas no depósito, permitindo que outros mecanismos analíticos no Microsoft Fabric leiam a versão mais recente dos dados.

Verificando o status da publicação de logs do Delta Lake

Para verificar o estado atual da publicação de log Delta Lake em todos os armazéns para o espaço de trabalho atual, use o seguinte trecho de código:

SELECT [name], [DATA_LAKE_LOG_PUBLISHING_DESC] FROM sys.databases

Limitações

- Os Nomes de Tabela só podem ser usados pelo Spark e outros sistemas se contiverem apenas estes caracteres: A-Z a-z 0-9 e sublinhados.

- Os nomes de coluna que serão usados pelo Spark e outros sistemas não podem conter:

- espaços

- separadores

- DEVOLUÇÕES DE CARRUAGEM

- [

- ,

- ;

- {

- }

- (

- )

- =

- ]