Integrar o OneLake com o Azure Databricks

Este cenário mostra como se conectar ao OneLake por meio do Azure Databricks. Depois de concluir este tutorial, você poderá ler e gravar em um lago do Microsoft Fabric a partir do seu espaço de trabalho do Azure Databricks.

Pré-requisitos

Antes de se conectar, você deve ter:

- Um espaço de trabalho de tecido e lakehouse.

- Um espaço de trabalho premium do Azure Databricks. Apenas espaços de trabalho premium do Azure Databricks suportam a passagem de credenciais do Microsoft Entra, que você precisa para este cenário.

Configurar seu espaço de trabalho Databricks

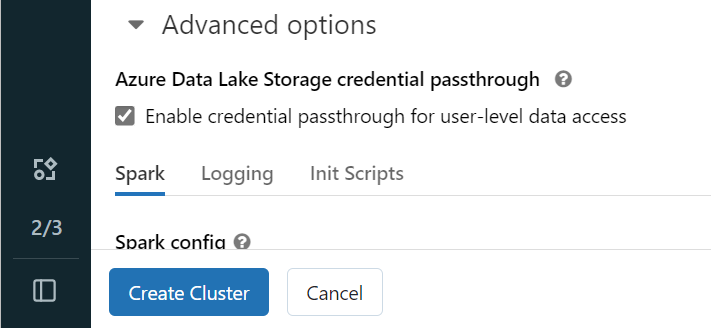

Abra seu espaço de trabalho do Azure Databricks e selecione Criar>cluster.

Para autenticar no OneLake com sua identidade do Microsoft Entra, você deve habilitar a passagem de credenciais do Azure Data Lake Storage (ADLS) em seu cluster nas Opções Avançadas.

Nota

Você também pode conectar o Databricks ao OneLake usando uma entidade de serviço. Para obter mais informações sobre como autenticar o Azure Databricks usando uma entidade de serviço, consulte Gerenciar entidades de serviço.

Crie o cluster com seus parâmetros preferidos. Para obter mais informações sobre como criar um cluster Databricks, consulte Configurar clusters - Azure Databricks.

Abra um bloco de anotações e conecte-o ao cluster recém-criado.

Crie o seu bloco de notas

Navegue até o seu Fabric lakehouse e copie o caminho do Azure Blob Filesystem (ABFS) para o seu lakehouse. Você pode encontrá-lo no painel Propriedades .

Nota

O Azure Databricks só suporta o driver do Sistema de Arquivos de Blob do Azure (ABFS) ao ler e gravar no ADLS Gen2 e no OneLake:

abfss://myWorkspace@onelake.dfs.fabric.microsoft.com/.Salve o caminho para sua casa do lago em seu notebook Databricks. Este lakehouse é onde você escreve seus dados processados mais tarde:

oneLakePath = 'abfss://myWorkspace@onelake.dfs.fabric.microsoft.com/myLakehouse.lakehouse/Files/'Carregue dados de um conjunto de dados público Databricks em um dataframe. Você também pode ler um arquivo de outro lugar no Fabric ou escolher um arquivo de outra conta ADLS Gen2 que você já possui.

yellowTaxiDF = spark.read.format("csv").option("header", "true").option("inferSchema", "true").load("/databricks-datasets/nyctaxi/tripdata/yellow/yellow_tripdata_2019-12.csv.gz")Filtre, transforme ou prepare seus dados. Para esse cenário, você pode reduzir seu conjunto de dados para carregamento mais rápido, unir com outros conjuntos de dados ou filtrar para resultados específicos.

filteredTaxiDF = yellowTaxiDF.where(yellowTaxiDF.fare_amount<4).where(yellowTaxiDF.passenger_count==4) display(filteredTaxiDF)Escreva seu dataframe filtrado em sua casa de lago de malha usando seu caminho OneLake.

filteredTaxiDF.write.format("csv").option("header", "true").mode("overwrite").csv(oneLakePath)Teste se os dados foram gravados com êxito lendo o arquivo recém-carregado.

lakehouseRead = spark.read.format('csv').option("header", "true").load(oneLakePath) display(lakehouseRead.limit(10))

Parabéns! Agora você pode ler e gravar dados no Fabric usando o Azure Databricks.