Adicionar fonte Confluent Kafka a um fluxo de eventos

Este artigo mostra como adicionar a fonte Confluent Kafka a um fluxo de eventos.

Confluent Cloud Kafka é uma plataforma de streaming que oferece poderosas funcionalidades de streaming e processamento de dados usando o Apache Kafka. Ao integrar o Confluent Cloud Kafka como uma fonte em seu fluxo de eventos, você pode processar perfeitamente fluxos de dados em tempo real antes de roteá-los para vários destinos no Fabric.

Nota

Esta origem não é suportada nas seguintes regiões da capacidade do seu espaço de trabalho: Oeste US3, Suíça Oeste.

Pré-requisitos

- Acesso a um espaço de trabalho no modo de licença de capacidade de malha (ou) no modo de licença de avaliação com permissões de Colaborador ou superiores.

- Um cluster Confluent Cloud Kafka e uma chave de API.

- Seu cluster Confluent Cloud Kafka deve ser acessível publicamente e não estar protegido em um firewall ou protegido em uma rede virtual.

- Se você não tiver um eventstream, crie um eventstream.

Inicie o assistente Selecionar uma fonte de dados

Se você ainda não adicionou nenhuma fonte ao seu fluxo de eventos, selecione Usar bloco de origem externa.

Se estiver a adicionar a origem a um fluxo de eventos já publicado, mude para o modo de edição , selecione Adicionar origem no friso e, em seguida, selecione Fontes externas.

Configurar e conectar-se ao Confluent Kafka

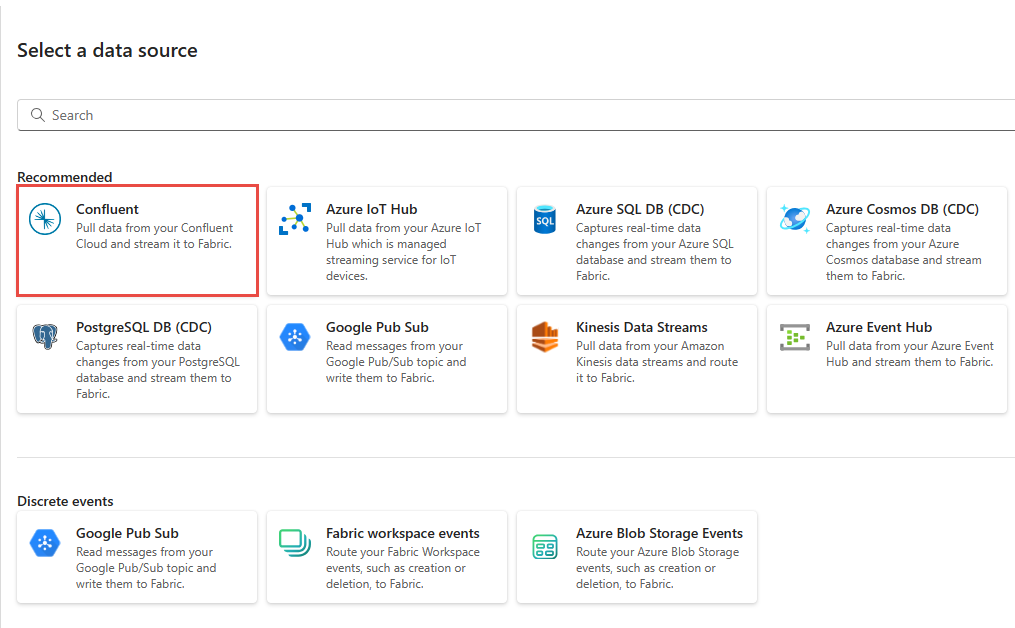

Na página Selecione uma fonte de dados, selecione Confluente.

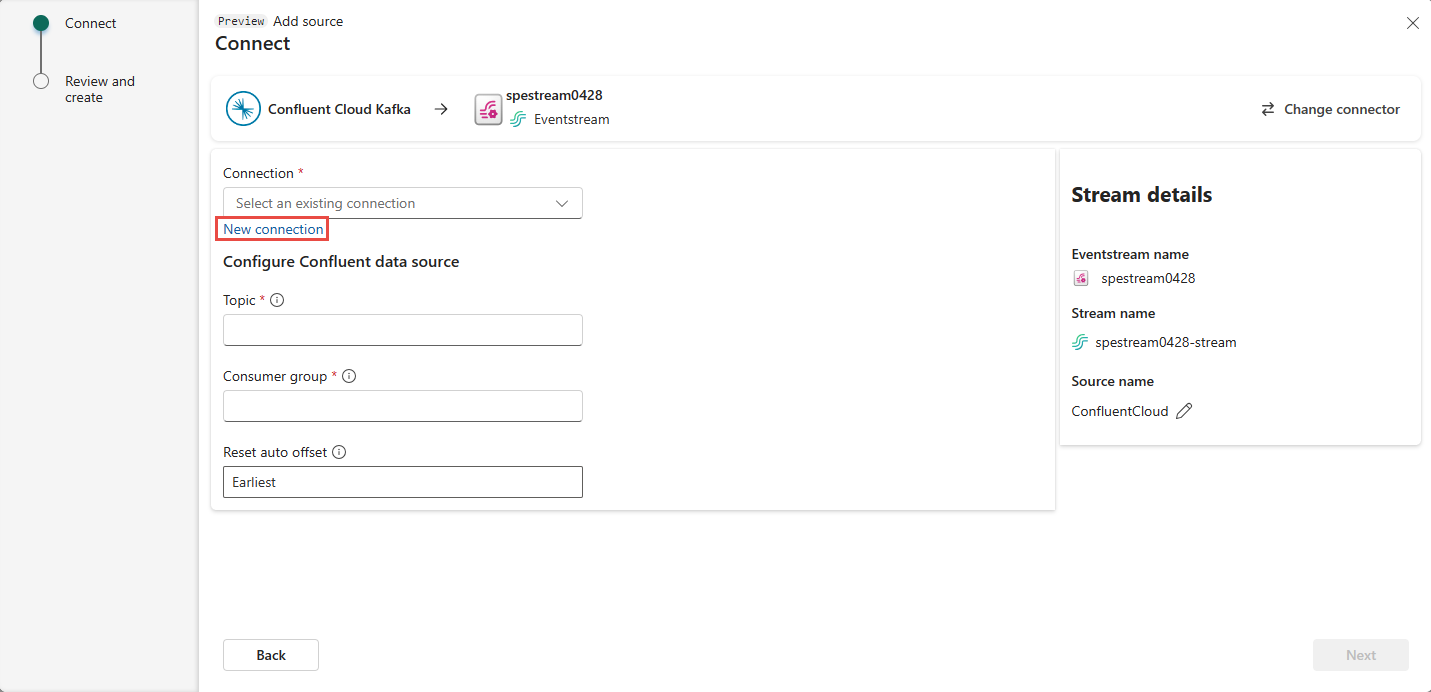

Para criar uma conexão com a fonte Confluent Cloud Kafka, selecione Nova conexão.

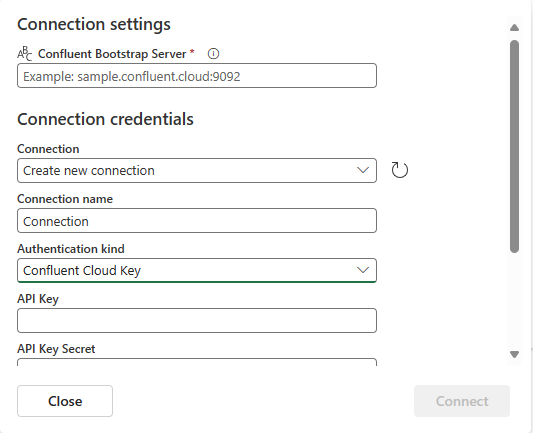

Na seção Configurações de conexão , insira Confluent Bootstrap Server. Navegue até a página inicial do Confluent Cloud, selecione Configurações de Cluster e copie o endereço para o Servidor de Bootstrap.

Na seção Credenciais de conexão, se você tiver uma conexão existente com o cluster Confluent, selecione-a na lista suspensa de Conexão. Caso contrário, siga estes passos:

- Em Nome da conexão, insira um nome para a conexão.

- Para Tipo de autenticação, confirme se Confluent Cloud Key está selecionado.

- Para chave de API e segredo de chave de API:

Navegue até o Confluent Cloud.

Selecione API Keys no menu lateral.

Selecione o botão Adicionar chave para criar uma nova chave de API.

Copie a chave da API e o segredo.

Cole esses valores nos campos API Key e API Key Secret.

Selecione Ligar

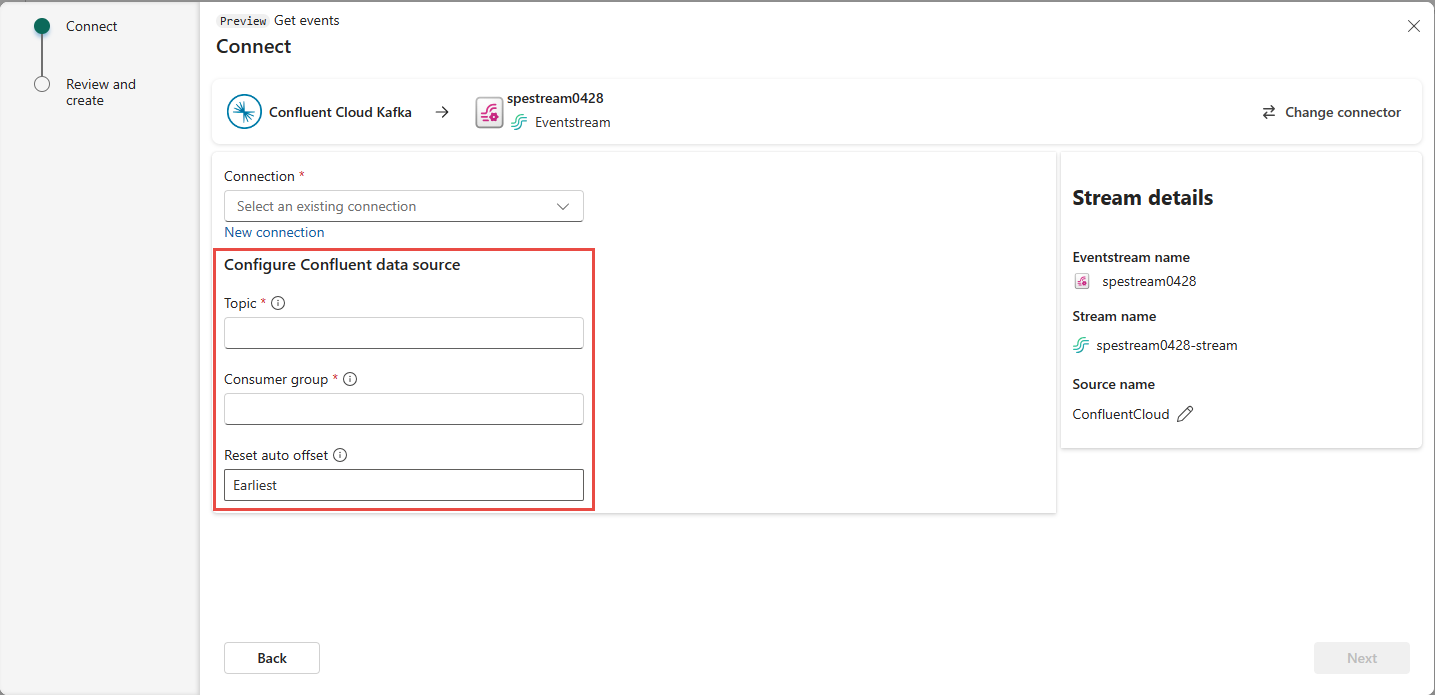

Role para ver a seção Configurar fonte de dados Confluent na página. Insira as informações para concluir a configuração da fonte de dados Confluent.

- Em Tópico, insira um nome de tópico do seu Confluent Cloud. Você pode criar ou gerenciar seu tópico no Confluent Cloud Console.

- Para Grupo de consumidores, insira um grupo de consumidores do seu Confluent Cloud. Ele fornece o grupo de consumidores dedicado para obter os eventos do cluster Confluent Cloud.

- Para Redefinir configuração de deslocamento automático, selecione um dos seguintes valores:

Mais cedo – os primeiros dados disponíveis do seu cluster Confluent

Mais recentes – os últimos dados disponíveis

Nenhum – não defina automaticamente o deslocamento.

Selecione Seguinte. No ecrã Rever e criar, reveja o resumo e, em seguida, selecione Adicionar.

Você vê que a fonte Confluent Cloud Kafka é adicionada ao seu fluxo de eventos na tela no modo de edição. Para implementar essa fonte do Confluent Cloud Kafka recém-adicionada, selecione Publicar na faixa de opções.

Depois de concluir essas etapas, a fonte Confluent Cloud Kafka estará disponível para visualização na Visualização dinâmica.

Limitações

- Kafka confluente com formatos JSON e Avro, usando registro de esquema, não é suportado no momento.

- Atualmente, não há suporte para a decodificação de dados do Confluent Kafka usando o Registro de Esquema Confluente.

Nota

O número máximo de fontes e destinos para um eventstream é 11.

Conteúdos relacionados

Outros conectores:

- Amazon Kinesis Data Streams

- BD do Cosmos para o Azure

- Azure Event Hubs

- Hub IoT do Azure

- Captura de Dados de Alteração do Banco de Dados SQL do Azure (CDC)

- Ponto de extremidade personalizado

- Google Cloud Pub/Sub

- Banco de dados MySQL CDC

- Banco de Dados PostgreSQL CDC

- Dados de exemplo

- Eventos do Armazenamento de Blobs do Azure

- Evento do espaço de trabalho de malha