Rotear fluxos de dados com base no conteúdo em fluxos de eventos do Fabric (visualização)

Este artigo mostra como rotear eventos com base no conteúdo em fluxos de eventos do Microsoft Fabric.

Agora você pode usar o editor sem código na tela principal de fluxos de eventos do Fabric para criar uma lógica de processamento de fluxo complexa sem escrever nenhum código. Esse recurso permite que você personalize, transforme e gerencie seus fluxos de dados com mais facilidade. Depois de definir suas operações de processamento de fluxo, você pode enviar sem problemas seus fluxos de dados para diferentes destinos de acordo com o esquema específico e os dados de fluxo.

Importante

Os recursos aprimorados dos fluxos de eventos do Fabric estão atualmente em visualização.

Operações suportadas

Aqui está a lista de operações suportadas para processamento de dados em tempo real:

Agregação: suporta funções SUM, AVG, MIN e MAX que executam cálculos em uma coluna de valores, retornando um único resultado.

Expandir: expanda um valor de matriz e crie uma nova linha para cada valor dentro de uma matriz.

Filtrar: selecione ou filtre linhas específicas do fluxo de dados com base em uma condição.

Agrupar por: Agregar todos os dados de eventos dentro de uma determinada janela de tempo, com a opção de agrupar uma ou mais colunas.

Gerenciar campos: adicione, remova ou altere o tipo de dados de um campo ou coluna de seus fluxos de dados.

União: conecte dois ou mais fluxos de dados com campos compartilhados do mesmo nome e tipo de dados em um fluxo de dados. Os campos que não correspondem são descartados.

Associação: combine dados de dois fluxos com base em uma condição correspondente entre eles.

Destinos suportados

Os destinos suportados são:

Lakehouse: Este destino oferece a você a capacidade de transformar seus eventos em tempo real antes da ingestão em sua casa do lago. Os eventos em tempo real são convertidos para o formato Delta Lake e, em seguida, armazenados nas tabelas designadas lakehouse. Esse destino ajuda com cenários de armazenamento de dados.

Banco de Dados KQL: Este destino permite que você ingira seus dados de eventos em tempo real no Banco de Dados KQL, onde você pode usar a poderosa Kusto Query Language (KQL) para consultar e analisar os dados. Com os dados no Banco de Dados KQL, você pode obter insights mais profundos sobre seus dados de eventos e criar relatórios e painéis avançados.

Reflex: Este destino permite-lhe ligar diretamente os seus dados de eventos em tempo real a um Reflex. Reflex é um tipo de agente inteligente que contém todas as informações necessárias para se conectar aos dados, monitorar as condições e agir. Quando os dados atingem determinados limites ou correspondem a outros padrões, o Reflex toma automaticamente as medidas apropriadas, como alertar os usuários ou iniciar fluxos de trabalho do Power Automatic.

Ponto de extremidade personalizado (antigo aplicativo personalizado): com esse destino, você pode facilmente rotear seus eventos em tempo real para um aplicativo personalizado. Esse destino permite que você conecte seus próprios aplicativos ao fluxo de eventos e consuma os dados do evento em tempo real. É útil quando você deseja enviar dados em tempo real para um sistema externo fora do Microsoft Fabric.

Stream: esse destino representa o fluxo de eventos bruto padrão transformado por uma série de operações, também chamado de fluxo derivado. Uma vez criado, você pode visualizar o fluxo a partir do hub em tempo real.

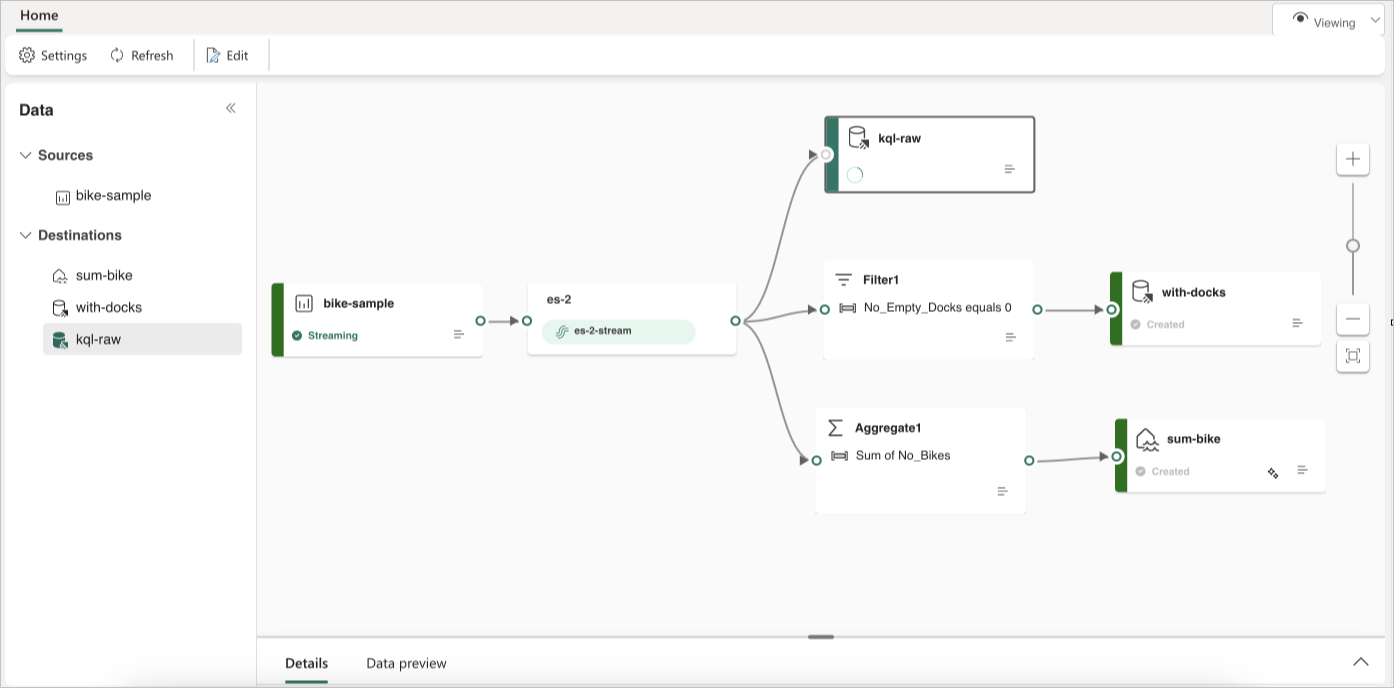

O exemplo a seguir mostra como três destinos distintos do fluxo de eventos Fabric podem servir funções separadas para uma única fonte de fluxo de dados. Um banco de dados KQL é designado para armazenar dados brutos, um segundo banco de dados KQL é para reter fluxos de dados filtrados e o Lakehouse é usado para armazenar valores agregados.

Para transformar e rotear seu fluxo de dados com base no conteúdo, siga as etapas em Editar e publicar um fluxo de eventos e comece a projetar lógicas de processamento de fluxo para seu fluxo de dados.