Оценка систем ИИ с помощью панели мониторинга ответственного искусственного интеллекта

Реализация ответственного ИИ на практике требует строгого проектирования. Но строгая инженерия может быть мучительной, ручной и потребляющей много времени без правильного инструмента и инфраструктуры.

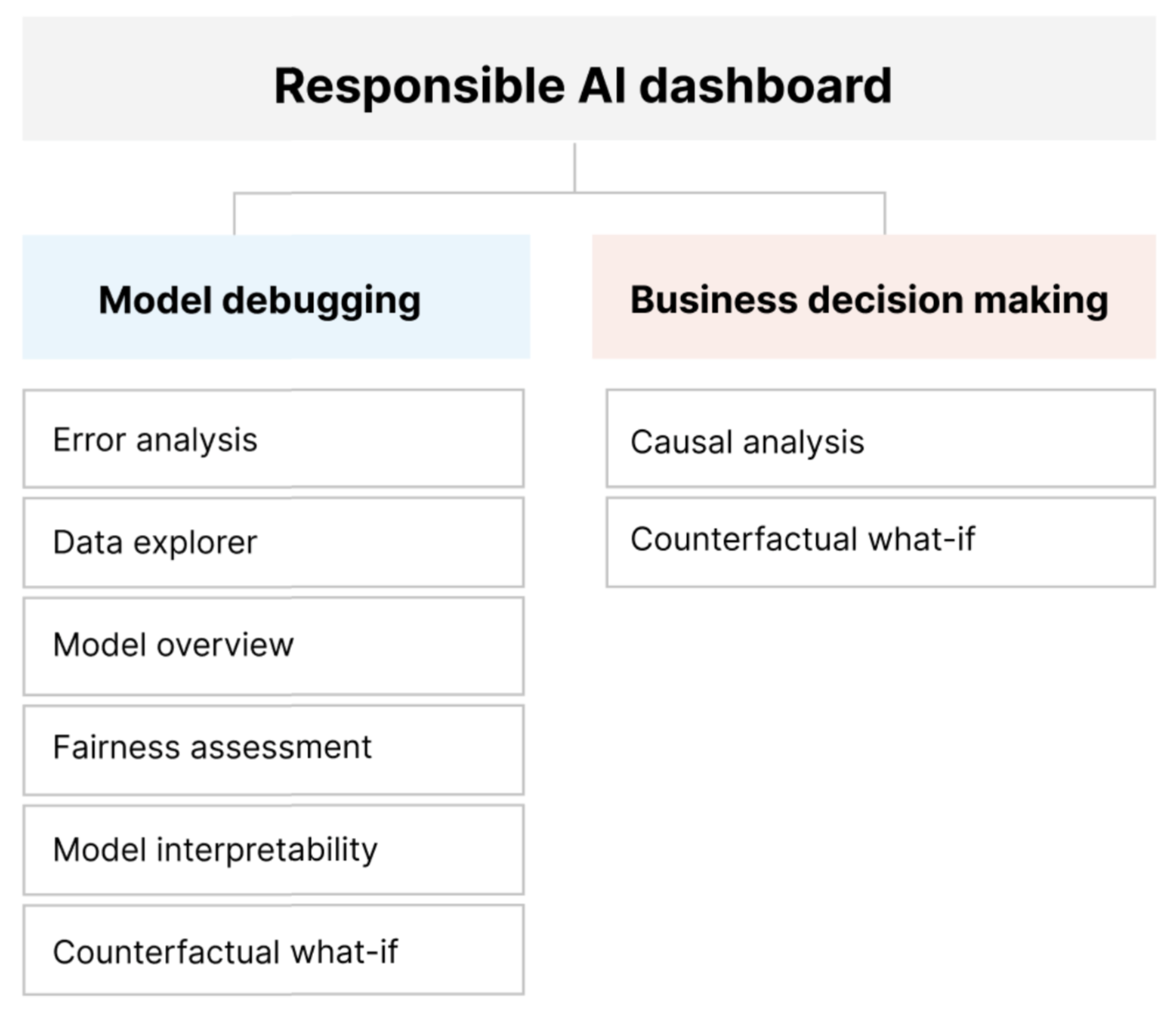

Панель мониторинга ответственного искусственного интеллекта предоставляет единый интерфейс для эффективного и эффективного внедрения ответственного ИИ. Она объединяет несколько зрелых средств ответственного искусственного интеллекта в областях:

- Оценка производительности и справедливости модели

- изучение данных

- Интерпретация машинного обучения

- Анализ ошибок

- Контрфактуальный анализ и возмущения

- Причинное вывод

Панель мониторинга предлагает целостную оценку и отладку моделей, чтобы вы могли принимать обоснованные решения, управляемые данными. Доступ ко всем этим средствам в одном интерфейсе позволяет вам:

Оценка и отладка моделей машинного обучения путем выявления ошибок и проблем справедливости модели, диагностики причин возникновения этих ошибок и информирования о действиях по устранению рисков.

Повышение возможностей принятия решений на основе данных путем решения таких вопросов, как:

"Что такое минимальное изменение, которое пользователи могут применять к своим функциям, чтобы получить другой результат от модели?"

"Что такое причинно-следственный эффект снижения или увеличения функции (например, потребления красного мяса) на реальный результат (например, прогрессирование диабета)?"

Панель мониторинга можно настроить, чтобы включить только подмножество инструментов, относящихся к вашему варианту использования.

Панель мониторинга ответственного искусственного интеллекта сопровождается картой показателей PDF. В системе показателей можно экспортировать метаданные ответственного ИИ и аналитические сведения в данные и модели. Затем вы можете поделиться ими в автономном режиме с заинтересованными лицами по продукту и соответствию требованиям.

Компоненты панели мониторинга ответственного применения ИИ

Панель мониторинга ответственного искусственного интеллекта объединяет в комплексном представлении различные новые и готовые инструменты. Панель мониторинга интегрирует эти средства с Машинное обучение Azure CLI версии 2, пакетом SDK python версии 2 Машинное обучение Azure и Студия машинного обучения Azure. Вот эти средства:

- Анализ данных, чтобы понять и изучить дистрибутивы и статистику набора данных.

- Обзор модели и оценка справедливости, чтобы оценить производительность модели и оценить проблемы с справедливостью группы модели (как прогнозы вашей модели влияют на различные группы людей).

- Анализ ошибок, просмотр и понимание распределения ошибок в наборе данных.

- Интерпретация модели (значения важности для агрегатных и отдельных функций), чтобы понять прогнозы вашей модели и способ создания общих и отдельных прогнозов.

- Контрфактуальные то, что если, чтобы наблюдать за тем, как признаки будут влиять на прогнозы модели, предоставляя ближайшие точки данных с противоположными или разными прогнозами модели.

- Причинный анализ, чтобы использовать исторические данные для просмотра причинных последствий лечения признаков в реальном мире.

Вместе эти средства помогут вам отлаживать модели машинного обучения, информируя бизнес-решения на основе данных и модели. На следующей схеме показано, как включить их в жизненный цикл ИИ, чтобы улучшить модели и получить надежные аналитические сведения о данных.

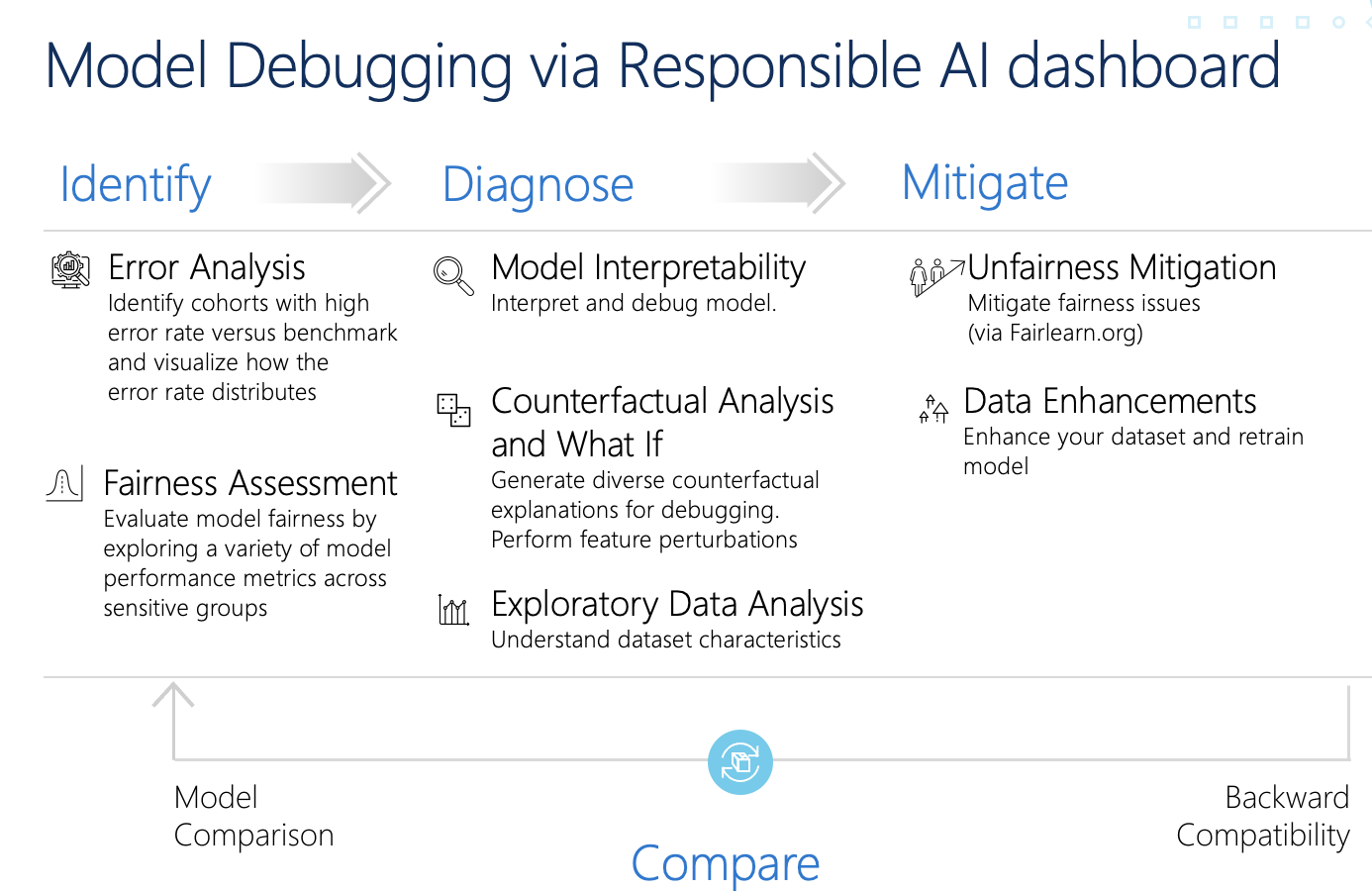

Отладка модели

Оценка и отладка моделей машинного обучения имеет критически важное значение для надежности модели, ее интерпретации, справедливости и соответствия требованиям. Это помогает определить, как и почему системы ИИ ведут себя таким образом. Затем эту базу знаний можно использовать для повышения производительности модели. Концептуально отладка модели состоит из трех этапов:

Определите, чтобы понять и распознать ошибки модели и /или проблемы справедливости, устраняя следующие вопросы:

"Какие типы ошибок у моей модели?"

"В каких областях наиболее распространены ошибки?"

Диагностика. Чтобы изучить причины обнаруженных ошибок, ответьте на следующие вопросы:

"Каковы причины этих ошибок?"

"Где следует сосредоточить ресурсы, чтобы улучшить модель?"

Устранение рисков. Чтобы воспользоваться аналитическими сведениями об идентификации и диагностике на предыдущих этапах для выполнения целевых действий по устранению рисков и решить следующие вопросы:

"Как улучшить модель?"

"Какие социальные или технические решения существуют для этих проблем?"

В следующей таблице описывается, когда следует использовать компоненты панели мониторинга ответственного искусственного интеллекта для поддержки отладки модели:

| Этап | Компонент | Description |

|---|---|---|

| Выявление | Анализ ошибок | Компонент анализа ошибок помогает получить более глубокое представление о распределении сбоев модели и быстро определить ошибочные когорты (подгруппы) данных. Возможности этого компонента на панели мониторинга приходят из пакета анализа ошибок. |

| Выявление | Анализ справедливости | Компонент справедливости определяет группы с точки зрения чувствительных атрибутов, таких как секс, раса и возраст. Затем он оценивает, как прогнозы модели влияют на эти группы и как можно уменьшить неравенство. Она оценивает производительность модели, изучая распределение значений прогноза и значения метрик производительности модели в группах. Возможности этого компонента на панели мониторинга приходят из пакета Fairlearn . |

| Выявление | Общие сведения о модели | Компонент обзора модели агрегирует метрики оценки модели в высокоуровневом представлении распределения прогнозов модели для более эффективного изучения его производительности. Этот компонент также обеспечивает оценку справедливости группы, подчеркивая разбивку производительности модели по конфиденциальным группам. |

| Диагностировать | Анализ данных | Анализ данных визуализирует наборы данных на основе прогнозируемых и фактических результатов, групп ошибок и конкретных функций. Затем можно определить проблемы чрезмерного использования и недопредставления, а также узнать, как данные кластеризованы в наборе данных. |

| Шаг | Интерпретируемость модели | Компонент интерпретации создает понятные для человека объяснения прогнозов модели машинного обучения. Он предоставляет несколько представлений в поведении модели: — Глобальные объяснения (например, которые влияют на общее поведение модели распределения кредитов) - Местные объяснения (например, почему заявление о кредите заявителя было утверждено или отклонено) Возможности этого компонента на панели мониторинга приходят из пакета InterpretML . |

| Шаг | Анализ противоречащего фактам предположения и анализ "что если" | Этот компонент состоит из двух функций для улучшения диагностики ошибок: — создание набора примеров, в которых минимальные изменения в определенной точке изменяют прогноз модели. То есть в примерах показаны ближайшие точки данных с противоположными прогнозами модели. — Включение интерактивных и пользовательских искажений "Что если" для отдельных точек данных, чтобы понять, как модель реагирует на изменения функций. Возможности этого компонента на панели мониторинга приходят из пакета DiCE . |

Действия по устранению рисков доступны с помощью автономных средств, таких как Fairlearn. Дополнительные сведения см. в алгоритмах устранения несправедливости.

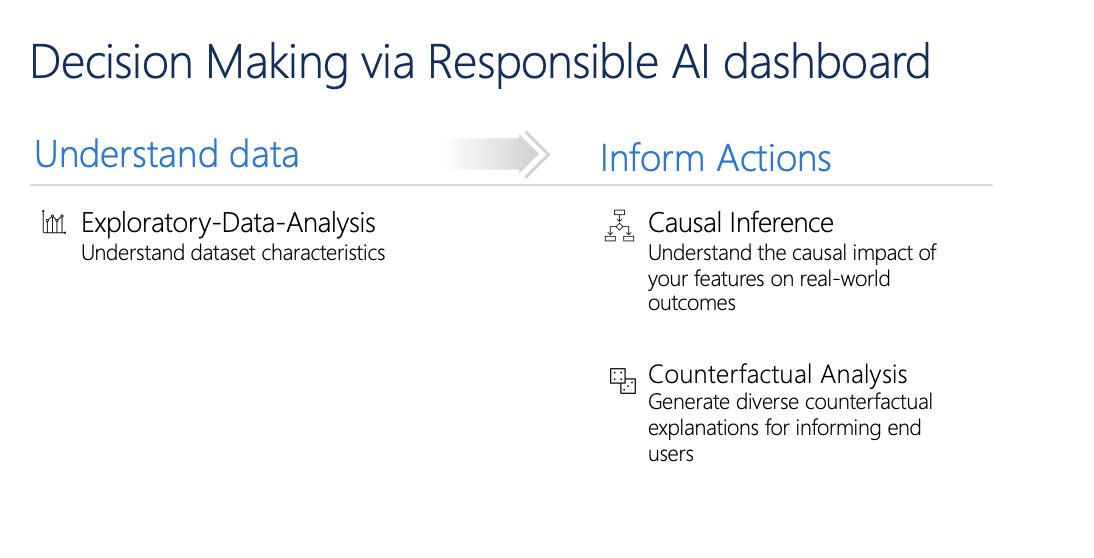

Ответственное принятие решений

Принятие решений является одним из самых больших обещаний машинного обучения. Панель мониторинга ответственного искусственного интеллекта поможет вам принять обоснованные бизнес-решения с помощью следующих средств:

Аналитические сведения, управляемые данными, для дальнейшего понимания причинно-следственных последствий для результата с использованием только исторических данных. Например:

"Как бы медицина повлияла на кровяное давление пациента?"

"Как будет предоставлять рекламные ценности определенным клиентам повлиять на доход?"

Эти аналитические сведения предоставляются с помощью компонента причинного вывода панели мониторинга.

Аналитика на основе модели позволяет ответить на вопросы пользователей, например, "Что можно сделать, чтобы в следующий раз получить другой результат от ИИ?", чтобы пользователи могли принять меры. Эти аналитические сведения предоставляются специалистам по обработке и анализу данных с помощью компонента counterfactual what-if .

Аналитический анализ данных, вывод причинных причин и возможности контрфактуального анализа могут помочь вам принимать обоснованные решения на основе модели и на основе данных.

Эти компоненты панели мониторинга ответственного искусственного интеллекта поддерживают ответственное принятие решений:

Анализ данных: вы можете повторно использовать компонент анализа данных здесь, чтобы понять распределение данных и определить чрезмерное представление и недопредставление. Исследование данных является важной частью принятия решений, поскольку невозможно принять обоснованные решения о когорте, которая недопредставлена в данных.

Причинное вывод: компонент причинного вывода оценивает, как реальный результат изменяется в присутствии вмешательства. Она также помогает создавать перспективные вмешательства путем имитации ответов признаков на различные вмешательства и создания правил, чтобы определить, какие когорты населения будут воспользоваться конкретным вмешательством. В совокупности эти функциональные возможности позволяют применять новые политики и влиять на реальные изменения.

Возможности этого компонента приходят из пакета EconML , который оценивает разнородные эффекты лечения от наблюдений с помощью машинного обучения.

Контрфактуальный анализ: вы можете повторно использовать компонент контрфактуального анализа здесь, чтобы создать минимальные изменения, примененные к функциям точки данных, которые приводят к противоположным прогнозированиям модели. Например: Тейлор получил бы утверждение кредита от ИИ, если бы они заработали $ 10000 больше в годовом доходе и было бы два меньше кредитных карт открыты.

Предоставление этой информации пользователям сообщает о своей перспективе. Он обучает их тому, как они могут принять меры, чтобы получить желаемый результат от ИИ в будущем.

Возможности этого компонента получены из пакета DiCE .

Причины использования панели мониторинга ответственного искусственного интеллекта

Хотя прогресс был достигнут на отдельных инструментах для конкретных областей ответственного искусственного интеллекта, специалисты по обработке и анализу данных часто должны использовать различные средства для комплексной оценки своих моделей и данных. Например, они могут использовать интерпретируемость модели и оценку справедливости вместе.

Если специалисты по обработке и анализу данных обнаруживают проблему справедливости с одним инструментом, они должны перейти к другому инструменту, чтобы понять, какие факторы данных или модели лежат в корне проблемы, прежде чем предпринимать какие-либо шаги по устранению рисков. Следующие факторы еще больше усложняют этот сложный процесс:

- Нет центрального расположения, чтобы обнаружить и узнать о средствах, расширяя время, необходимое для исследования и изучения новых методов.

- Различные инструменты не взаимодействуют друг с другом. Специалисты по обработке и анализу данных должны выполнять обработку наборов данных, моделей и других метаданных по мере их передачи между инструментами.

- Метрики и визуализации не являются легко сопоставимыми, и результаты трудно поделиться.

Информационная панель ответственного искусственного интеллекта оспаривает этот статус-кво. Это комплексное, но настраиваемое средство, которое объединяет фрагментированные интерфейсы в одном месте. Это позволяет легко подключиться к одной настраиваемой платформе для отладки модели и принятия решений на основе данных.

С помощью панели мониторинга ответственного искусственного интеллекта можно создавать наборы данных, передавать их всем поддерживаемым компонентам и наблюдать за работоспособностью модели для определенных когорт. Вы можете сравнить аналитические сведения обо всех поддерживаемых компонентах в различных предварительно созданных когортах для выполнения дезагрегированного анализа и найти слепые пятна вашей модели.

Когда вы будете готовы поделиться этими аналитическими сведениями с другими заинтересованными лицами, вы можете легко извлечь их с помощью системы показателей PDF ответственного ИИ. Вложите pdf-отчет в отчеты о соответствии или поделитесь им коллегами, чтобы создать доверие и получить их утверждение.

Способы настройки панели мониторинга ответственного искусственного интеллекта

Сила информационной панели ответственного искусственного интеллекта лежит в его настраиваемости. Она позволяет пользователям разрабатывать специализированные комплексные рабочие процессы отладки и принятия решений, которые соответствуют их конкретным потребностям.

Не хватает вдохновения? Ниже приведены некоторые примеры того, как компоненты панели мониторинга можно объединить для анализа сценариев различными способами:

| Поток панели мониторинга ответственного искусственного интеллекта | Вариант использования |

|---|---|

| > Анализ данных анализа ошибок анализа > ошибок модели | Определение ошибок модели и их диагностика путем распознавания базового распределения данных |

| > Анализ данных оценки > справедливости модели | Определение проблем справедливости и их диагностика путем распознавания базового распределения данных |

| > Анализ ошибок при анализе > ошибок модели, контрфактуалы и то, что если | Диагностика ошибок в отдельных экземплярах с помощью анализа противоречащих фактам предположений (минимальное изменение, чтобы привести к другому прогнозу модели) |

| Анализ данных обзора > модели | Распознавание первопричины ошибок и проблем справедливости, вызванных дисбалансом данных или недостаточной репрезентацией определенной когорты данных |

| Интерпретация модели > | Диагностика ошибок модели путем распознавания того, каким образом модель сделала прогнозы |

| Вывод причинно-причинного вывода > данных | Чтобы отличить корреляцию и причинность в данных или решить лучшие методы лечения, которые следует применить, чтобы получить положительный результат |

| Интерпретация > причинного вывода | Чтобы узнать, имеют ли факторы, используемые моделью для прогнозирования, имеют ли какие-либо причинные последствия для реального результата. |

| Анализ счетчиков данных > и то, что если | Чтобы ответить на вопросы клиентов о том, что они могут сделать в следующий раз, чтобы получить другой результат от системы искусственного интеллекта |

Люди, которые должны использовать панель мониторинга ответственного ИИ

Следующие пользователи могут использовать информационную панель ответственного ИИ и соответствующую систему показателей ответственного ИИ для создания доверия с системами ИИ:

- Специалисты по машинному обучению и специалисты по обработке и анализу данных, заинтересованные в отладке и улучшении моделей машинного обучения перед развертыванием

- Специалисты по машинному обучению и специалисты по обработке и анализу данных, которые заинтересованы в совместном использовании записей о работоспособности модели с руководителями продуктов и заинтересованными лицами бизнеса для создания доверия и получения разрешений на развертывание

- Руководители продуктов и заинтересованные лица бизнеса, которые просматривают модели машинного обучения перед развертыванием

- Сотрудники по рискам, которые рассматривают модели машинного обучения, чтобы понять проблемы справедливости и надежности

- Поставщики решений искусственного интеллекта, которые хотят объяснить решения модели пользователям или помочь им улучшить результаты

- Специалисты в сильно регулируемых пространствах, которые должны просматривать модели машинного обучения с регуляторами и аудиторами

Поддерживаемые сценарии и ограничения

- Панель мониторинга ответственного искусственного интеллекта в настоящее время поддерживает регрессию и классификацию (двоичные и многоклассовые) модели, обученные на табличных структурированных данных.

- Панель мониторинга ответственного искусственного интеллекта в настоящее время поддерживает модели MLflow, зарегистрированные в Машинное обучение Azure только с вкусом sklearn (scikit-learn). Модели scikit-learn должны реализовывать

predict()/predict_proba()методы, или модель должна быть заключена в класс, реализующийpredict()/predict_proba()методы. Модели должны быть загружены в среде компонента и должны быть доступны для выбора. - Панель мониторинга ответственного искусственного интеллекта в настоящее время визуализирует до 5 КБ точек данных в пользовательском интерфейсе панели мониторинга. Перед передачей на панель мониторинга необходимо уменьшить набор данных до 5K или меньше.

- Входные данные набора данных на панели мониторинга ответственного искусственного интеллекта должны быть pandas DataFrames в формате Parquet. В настоящее время не поддерживается разреженные данные NumPy и SciPy.

- В настоящее время панель мониторинга ответственного искусственного интеллекта поддерживает числовые или категориальные функции. Для категориальных признаков пользователь должен явно указать имена признаков.

- Панель мониторинга ответственного искусственного интеллекта в настоящее время не поддерживает наборы данных с более чем 10K столбцами.

- В настоящее время панель мониторинга ответственного искусственного интеллекта не поддерживает модель AutoML MLFlow.

- В настоящее время панель мониторинга ответственного искусственного интеллекта не поддерживает зарегистрированные модели AutoML из пользовательского интерфейса.

Следующие шаги

- Узнайте, как создать панель мониторинга ответственного ИИ с помощью CLI и пакета SDK или пользовательского интерфейса Студии Машинного обучения Azure.

- Узнайте, как создать систему показателей ответственного ИИ на основе аналитических сведений, наблюдаемых на информационной панели ответственного искусственного интеллекта.