Обработка потока без кода в Azure Stream Analytics

Редактор без кода позволяет легко разрабатывать задание Stream Analytics для обработки потоковых данных в режиме реального времени с помощью функции перетаскивания без написания одной строки кода. Этот интерфейс предоставляет холст, позволяющий подключаться к источникам входных данных, чтобы быстро просматривать данные потоковой передачи. Затем его можно преобразовать перед записью в места назначения.

С помощью редактора без кода можно легко:

- Изменение входных схем.

- Выполнение операций подготовки данных, таких как соединения и фильтры.

- Подход к расширенным сценариям, таким как агрегирование временных окон (переворачивающиеся, прыжки и сеансовые окна) для операций с группами.

После создания и запуска заданий Stream Analytics вы можете без труда использовать рабочие нагрузки в рабочей среде. Используйте правильный набор встроенных метрик для мониторинга и устранения неполадок. Счета за задания Stream Analytics выставляются в соответствии с моделью ценообразования при их выполнении.

Необходимые компоненты

Прежде чем разрабатывать задания Stream Analytics с помощью редактора кода без кода, необходимо выполнить следующие требования:

- Источники потоковой передачи и целевые ресурсы назначения для задания Stream Analytics должны быть общедоступными и не могут находиться в виртуальной сети Azure.

- Требуются необходимые разрешения для доступа к ресурсам потоковой передачи входных и выходных данных.

- Вам следует поддерживать разрешения на создание и изменение ресурсов Azure Stream Analytics.

Примечание.

Редактор кода в настоящее время недоступен в регионе Китая.

Задание Azure Stream Analytics

Задание Stream Analytics состоит из трех основных компонентов: входы, преобразования и выходы данных потоковой передачи. Вы можете иметь столько компонентов, сколько требуется, включая несколько входных данных, параллельные ветви с несколькими преобразованиями и несколькими выходными данными. Дополнительные сведения см. в документации по Azure Stream Analytics.

Примечание.

Следующие функции и типы выходных данных недоступны при использовании редактора без кода:

- Определяемые пользователем функции.

- Изменение запросов в колонке запросов Azure Stream Analytics. Однако вы можете просмотреть запрос, созданный редактором без кода в колонке запросов.

- Добавление входных и выходных данных в колонках входных и выходных данных Azure Stream Analytics. Однако можно просмотреть входные и выходные данные, созданные редактором без кода в колонке входных и выходных данных.

- Следующие типы выходных данных недоступны: Функция Azure, ADLS 1-го поколения, База данных PostgreSQL, служебная шина очереди или раздела, хранилище таблиц.

Чтобы получить доступ к редактору без кода для создания задания Stream Analytics, существует два подхода:

На портале Azure Stream Analytics (предварительная версия): создайте задание Stream Analytics, а затем выберите редактор кода без кода на вкладке "Начало работы" на странице "Обзор" или выберите редактор без кода на левой панели.

На портале Центры событий Azure: откройте экземпляр Центров событий. Выберите "Обработка данных" и выберите любой предопределенный шаблон.

Стандартные шаблоны могут помочь вам в разработке и выполнении задания для решения различных сценариев, в том числе:

- Создание панели мониторинга в режиме реального времени с помощью набора данных Power BI

- Сбор данных из Центров событий в формате Delta Lake (предварительная версия)

- Фильтрация и прием в Azure Synapse SQL

- Запись данных Центров событий в формате Parquet в Azure Data Lake Storage 2-го поколения

- Материализация данных в Azure Cosmos DB

- Фильтрация и прием данных в Azure Data Lake Storage 2-го поколения

- Обогащение данных и прием в концентратор событий

- Преобразование и хранение данных в базе данных SQL Azure

- Фильтрация и прием в Azure Data Explorer

На следующем снимках экрана показано завершенное задание Stream Analytics. Он выделяет все разделы, доступные вам при создании.

- Лента: на ленте разделы следуют порядку классического процесса аналитики: концентратор событий в качестве входных данных (также известный как источник данных), преобразования (операции потокового извлечения, преобразования и загрузки), выходные данные, кнопка для сохранения хода выполнения и кнопка, чтобы запустить задание.

- Представление диаграммы: это графическое представление задания Stream Analytics, от входных данных к операциям с выходными данными.

- Боковая область. В зависимости от компонента, выбранного в представлении диаграммы, отображаются параметры для изменения входных, преобразований или выходных данных.

- Вкладки для предварительного просмотра данных, ошибок разработки, журналов среды выполнения и метрик. Для каждой плитки предварительный просмотр данных показывает результаты этого шага (динамически для входных данных; по запросу на преобразования и выходные данные). Кроме того, в этом разделе содержится сводка ошибок и предупреждений, которые могут возникнуть в задании при разработке. При выборе каждой ошибки или предупреждения выбирается это преобразование. Он также предоставляет метрики заданий для отслеживания работоспособности выполняемого задания.

Потоковая передача входных данных

Редактор без кода поддерживает потоковую передачу данных из трех типов ресурсов:

- Центры событий Azure

- Центр Интернета вещей Azure

- Azure Data Lake Storage 2-го поколения

Дополнительные сведения о входных данных потоковой передачи см. в разделе Stream Data в качестве входных данных в Stream Analytics.

Примечание.

Редактор без кода на портале Центры событий Azure имеет только концентратор событий в качестве входного параметра.

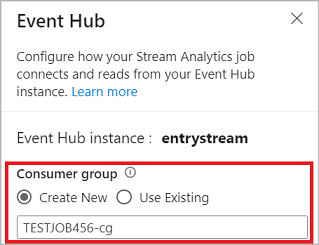

Центры событий Azure в качестве входных данных потоковой передачи

Центры событий Azure представляют собой платформу потоковой передачи больших данных и службу приема событий. Она может получать и обрабатывать миллионы событий в секунду. Данные, отправленные в концентратор событий, можно преобразовать и сохранить с помощью любого поставщика аналитики в режиме реального времени или адаптера пакетной обработки или хранилища.

Чтобы настроить концентратор событий в качестве входных данных для задания, выберите значок Концентратора событий. В представлении схемы появится соответствующая область, включая боковую панель для ее настройки и подключения.

При подключении к концентратору событий в редакторе без кода рекомендуется создать новую группу потребителей (которая является параметром по умолчанию). Этот подход помогает предотвратить достижение ограничения одновременных читателей концентратора событий. Дополнительные сведения о группах потребителей и о том, следует ли выбрать существующую группу потребителей или создать новую, см. в разделе "Группы потребителей".

Если концентратор событий находится на уровне "Базовый", можно использовать только существующую группу потребителей $Default . Если концентратор событий находится на уровне "Стандартный" или "Премиум", можно создать новую группу потребителей.

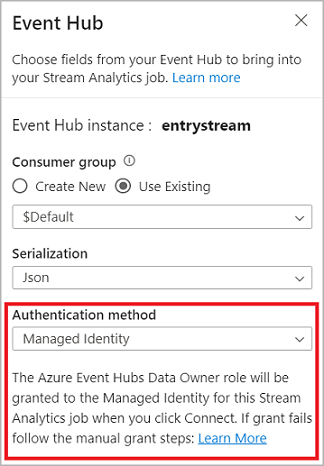

При подключении к концентратору событий при выборе управляемого удостоверения в качестве режима проверки подлинности роль владельца данных Центры событий Azure предоставляется управляемому удостоверению для задания Stream Analytics. Дополнительные сведения об управляемых удостоверениях для концентратора событий см. в статье Использование управляемых удостоверений для доступа к концентратору событий из задания Azure Stream Analytics.

Управляемые удостоверения устраняют ограничения методов проверки подлинности на основе пользователей. Эти ограничения включают необходимость повторной проверки подлинности из-за изменений паролей или истечения срока действия маркера пользователя, которые происходят каждые 90 дней.

После настройки сведений о концентраторе событий и нажатия кнопки "Подключить" можно добавить поля вручную с помощью +Добавить поле , если вы знаете имена полей. Чтобы вместо этого обнаруживать поля и типы данных автоматически на основе образца входящих сообщений, выберите поля автоматического определения. Выбрав символ шестеренки, можно при необходимости редактировать учетные данные.

При обнаружении полей задания Stream Analytics отображаются в списке. Вы также увидите динамическую предварительную версию входящих сообщений в таблице предварительного просмотра данных в представлении схемы.

Изменение входных данных

Можно изменить имена полей или удалить поле или изменить тип данных или изменить время события (пометить как время события: предложение TIMESTAMP BY, если поле типа даты и времени), выбрав трехточие символ рядом с каждым полем. Вы также можете развернуть, выбрать и изменить все вложенные поля из входящих сообщений, как показано на следующем рисунке.

Совет

Это относится к входным данным из Центр Интернета вещей Azure и Azure Data Lake Storage 2-го поколения.

Доступные типы данных:

- DateTime: поле даты и времени в формате ISO.

- Float: Десятичное число.

- Int: целочисленный номер.

- Запись: вложенный объект с несколькими записями.

- Строка: текст.

Центр Интернета вещей Azure в качестве входных данных потоковой передачи

Центр Интернета вещей Azure — размещенная в облаке управляемая служба, которая выступает в качестве центра сообщений для взаимодействия между приложением Интернета вещей и подключенными устройствами. Данные устройства Интернета вещей, отправленные в Центр Интернета вещей, можно использовать в качестве входных данных для задания Stream Analytics.

Примечание.

Центр Интернета вещей Azure входные данные доступны в редакторе без кода на портале Azure Stream Analytics.

Чтобы добавить Центр Интернета вещей в качестве потокового ввода для задания, выберите Центр Интернета вещей в разделе "Входные данные" на ленте. Затем введите необходимые сведения на правой панели, чтобы подключить центр Интернета вещей к заданию. Дополнительные сведения о каждом поле см. в статье Stream Data from Центр Интернета вещей to Stream Analytics job.

Azure Data Lake Storage 2-го поколения в качестве входных данных потоковой передачи

Azure Data Lake Storage 2-го поколения (ADLS 2-го поколения) — это облачное решение корпоративного озера данных. Она предназначена для хранения больших объемов данных в любом формате и упрощения аналитических рабочих нагрузок больших данных. Данные, хранящиеся в ADLS 2-го поколения, можно обрабатывать в виде потока данных Stream Analytics. Дополнительные сведения об этом типе входных данных см. в статье "Потоковая передача данных из ADLS 2-го поколения" в задание Stream Analytics

Примечание.

Azure Data Lake Storage 2-го поколения входные данные доступны в редакторе без кода на портале Azure Stream Analytics.

Чтобы добавить ADLS 2-го поколения в качестве потокового ввода для задания, выберите ADLS 2-го поколения в разделе "Входные данные" на ленте. Затем введите необходимые сведения на правой панели, чтобы подключить ADLS 2-го поколения к заданию. Дополнительные сведения о каждом поле см. в статье "Потоковая передача данных из ADLS 2-го поколения" в задание Stream Analytics

Входные ссылочные данные

Справочные данные являются статическими или изменяются медленно с течением времени. Обычно он используется для обогащения входящих потоков и поиска в задании. Например, можно присоединить входные данные потока данных к эталонным данным, так как вы выполнили бы соединение SQL для поиска статических значений. Дополнительные сведения о входных данных ссылочных данных см. в разделе "Использование ссылочных данных" для поиска в Stream Analytics.

Редактор без кода теперь поддерживает два эталонных источника данных:

- Azure Data Lake Storage 2-го поколения

- База данных SQL Azure

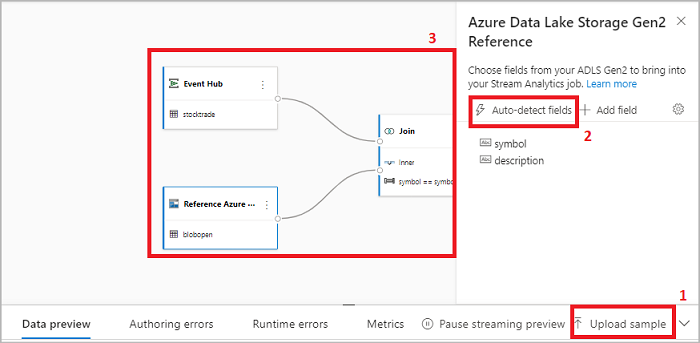

Azure Data Lake Storage 2-го поколения в качестве эталонных данных

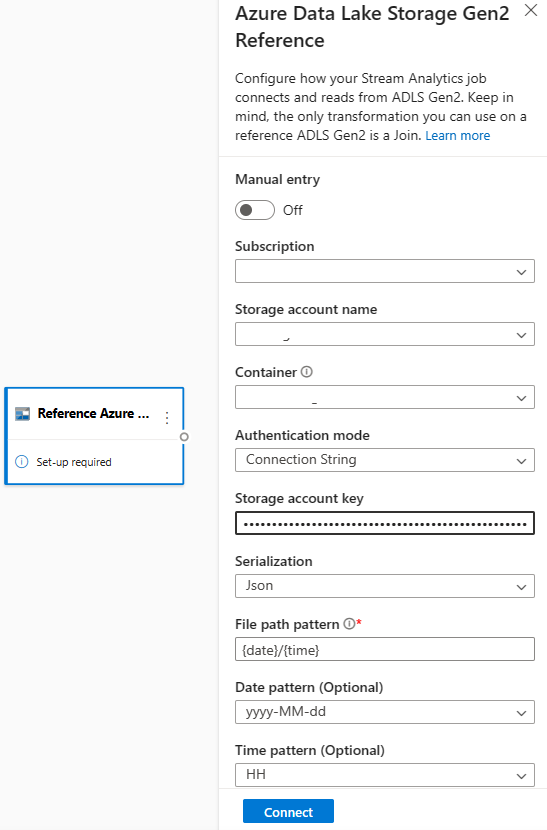

Эталонные данные моделиируются как последовательность больших двоичных объектов в порядке возрастания комбинации даты и времени, указанной в имени большого двоичного объекта. Большие двоичные объекты можно добавлять в конец последовательности только с помощью даты и времени больше, чем последний большой двоичный объект, указанный в последовательности. BLOB-объекты определяются во входной конфигурации.

Сначала в разделе " Входные данные " на ленте выберите ссылку ADLS 2-го поколения. Дополнительные сведения о каждом поле см. в разделе об Хранилище BLOB-объектов Azure в разделе "Использование справочных данных для поиска в Stream Analytics".

Затем отправьте файл массива JSON. Будут обнаружены поля в файле. Используйте эти справочные данные для преобразования с потоковыми входными данными из Центров событий.

База данных SQL Azure в качестве эталонных данных

Вы можете использовать База данных SQL Azure в качестве эталонных данных для задания Stream Analytics в редакторе без кода. Дополнительные сведения см. в разделе об База данных SQL в разделе "Использование справочных данных для поиска в Stream Analytics".

Чтобы настроить База данных SQL в качестве входных данных ссылки, выберите "Ссылка База данных SQL" в разделе "Входные данные" на ленте. Затем заполните сведения для подключения эталонной базы данных и выберите таблицу с необходимыми столбцами. Вы также можете получить справочные данные из таблицы, изменив SQL-запрос вручную.

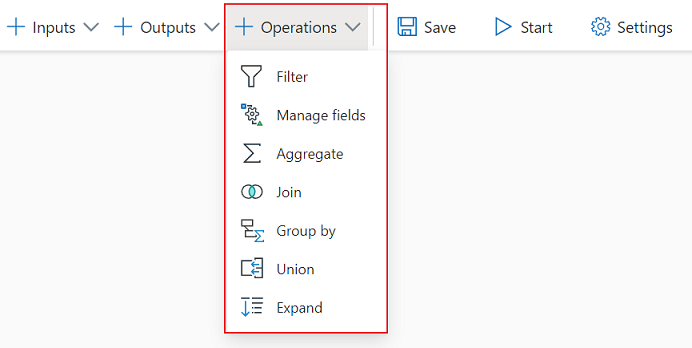

Преобразования

Преобразования потоковых данных по сути отличаются от преобразований пакетных данных. Почти все потоковые данные имеют компонент времени, который влияет на все задачи подготовки данных.

Чтобы добавить преобразование потоковых данных в задание, выберите символ преобразования в разделе "Операции " на ленте для этого преобразования. Соответствующая область будет удалена в представлении схемы. Выбрав его, вы увидите боковую область для этого преобразования, чтобы настроить его.

Фильтр

Используйте преобразование фильтра для фильтрации событий на основе значения поля во входных данных. В зависимости от типа данных (число или текст), преобразование будет хранить значения, соответствующие выбранному условию.

Примечание.

Внутри каждой плитки вы увидите сведения о том, что еще преобразование должно быть готово. Например, при добавлении новой плитки появится необходимое сообщение программы установки. Если соединитель узла отсутствует, появится сообщение об ошибке или предупреждение .

Управление полями

Преобразование "Управление полями " позволяет добавлять, удалять или переименовать поля, поступающие из входного или другого преобразования. Параметры на боковой панели предоставляют возможность добавления нового, нажав кнопку "Добавить поле " или добавив все поля одновременно.

Вы также можете добавить новое поле со встроенными функциями , чтобы агрегировать данные из вышестоящего потока. В настоящее время встроенные функции, которые мы поддерживаем, являются некоторыми функциями в строковых функциях, функциях даты и времени, математических функциях. Дополнительные сведения об определениях этих функций см. в статье "Встроенные функции" (Azure Stream Analytics).

Совет

После настройки плитки представление схемы дает представление о параметрах в плитке. Например, в области "Управление полями" предыдущего изображения можно увидеть первые три поля , которыми управляются, и новые имена, назначенные им. Каждая плитка содержит сведения, относящиеся к нему.

Агрегированное

Вы можете использовать преобразование "Агрегат" для вычисления агрегата (суммы, минимального, максимального или среднего) каждый раз, когда новое событие происходит за период времени. Эта операция также позволяет фильтровать или срезать агрегирование на основе других измерений в данных. В одном или нескольких агрегатах можно выполнить одно или несколько агрегатов.

Чтобы добавить агрегирование, щелкните символ преобразования. Затем подключите входные данные, выберите агрегирование, добавьте любые измерения фильтра или среза и выберите период времени, с течением которого будет вычисляться агрегат. В этом примере мы вычисляем сумму платных значений по состоянию, в котором автомобиль находится за последние 10 секунд.

Чтобы добавить еще одну агрегацию в то же преобразование, выберите "Добавить агрегатную функцию". Помните, что фильтр или срез будут применяться ко всем агрегатам в преобразовании.

Присоединиться

Используйте преобразование Join для объединения событий из двух входных данных на основе пар полей, которые вы выбрали. Если вы не выберете пару полей, соединение будет зависеть от времени по умолчанию. По умолчанию это преобразование отличается от пакетной.

Как и при регулярных соединениях, у вас есть варианты для логики соединения:

- Внутреннее соединение: включите только записи из обеих таблиц, в которых пара совпадает. В этом примере номер лицензии совпадает с обоими входными данными.

- Левое внешнее соединение: включите все записи из левой (первой) таблицы и только записи из второй, которые соответствуют паре полей. Если совпадения нет, поля из второго входного ввода будут пустыми.

Чтобы выбрать тип соединения, щелкните символ предпочтительного типа на боковой панели.

Затем выберите период, в течение которого нужно вычислить соединение. В этом примере соединение смотрит на последние 10 секунд. Учитывайте, что чем больше период, тем реже будет выполняться вывод и тем больше ресурсов обработки вы будете использовать для преобразования.

По умолчанию все поля из обеих таблиц включены. Префиксы слева (первый узел) и справа (второй узел) в выходных данных помогают различать источник.

Группировать по

Используйте группу путем преобразования для вычисления агрегатов во всех событиях в течение определенного периода времени. Вы можете выполнять группирование по значениям в одном или нескольких полях. Это похоже на преобразование Статистическая обработка, но предоставляет больше возможностей для агрегатов. Он также включает более сложные варианты для временных окон. Как и при статистической обработке, вы можете добавить более одного агрегата для каждого преобразования.

Агрегаты, доступные в преобразовании:

- Среднее значение

- Численность

- Максимум

- Минимум

- Процентиль (постоянный и дискретный).

- Стандартное отклонение

- Sum

- Variance

Чтобы настроить это преобразование, сделайте следующее:

- Выберите предпочтительную агрегирование.

- Выберите поле, в которое требуется агрегировать.

- Выберите необязательное поле для группировании, если вам нужно выполнить статистическое вычисление по другому измерению или категории. Например: состояние.

- Выберите функцию для временных окон.

Чтобы добавить еще одну агрегацию в то же преобразование, выберите "Добавить агрегатную функцию". Помните, что функция группирования по полю и окне будет применяться ко всем агрегатам в преобразовании.

Метка времени окончания периода времени отображается как часть выходных данных преобразования для ссылки. Дополнительные сведения о окнах времени, которые поддерживают задания Stream Analytics, см. в разделе "Функции "Окно" (Azure Stream Analytics).

Объединение

Используйте преобразование Union для подключения двух или нескольких входных данных для добавления событий с общими полями (с одинаковым именем и типом данных) в одну таблицу. Поля, которые не соответствуют, будут удалены и не включены в выходные данные.

Развернуть массив

Используйте преобразование "Развернуть массив" для создания новой строки для каждого значения в массиве.

Потоковая передача выходных данных

В настоящее время функция перетаскивания без кода поддерживает несколько приемников выходных данных для хранения обработанных данных в режиме реального времени.

Azure Data Lake Storage 2-го поколения

Data Lake Storage 2-го поколения использует службу хранилища Azure в качестве основы для создания корпоративных хранилищ данных в Azure. Она предназначена для обслуживания нескольких петабайтов информации при поддержании сотен гигабит пропускной способности. Это позволяет легко управлять большим объемом данных. Хранилище BLOB-объектов Azure предлагает экономичное и масштабируемое решение для хранения больших объемов неструктурированных данных в облаке.

В разделе "Выходные данные" на ленте выберите ADLS 2-го поколения в качестве выходных данных для задания Stream Analytics. Затем выберите контейнер, в котором нужно отправить выходные данные задания. Дополнительные сведения о выходных данных Azure Data Lake 2-го поколения для задания Stream Analytics см. в статье "Хранилище BLOB-объектов Azure" и выходные данные Azure Data Lake 2-го поколения из Azure Stream Analytics.

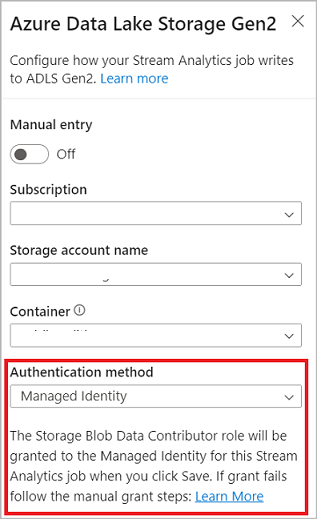

При подключении к Azure Data Lake Storage 2-го поколения при выборе управляемого удостоверения в качестве режима проверки подлинности роль участника данных BLOB-объектов хранилища будет предоставлена управляемому удостоверению для задания Stream Analytics. Дополнительные сведения об управляемых удостоверениях для Azure Data Lake Storage 2-го поколения см. в статье "Использование управляемых удостоверений для проверки подлинности задания Azure Stream Analytics для Хранилище BLOB-объектов Azure".

Управляемые удостоверения устраняют ограничения методов проверки подлинности на основе пользователей. Эти ограничения включают необходимость повторной проверки подлинности из-за изменений паролей или истечения срока действия маркера пользователя, которые происходят каждые 90 дней.

Ровно один раз доставка (предварительная версия) поддерживается в ADLS 2-го поколения без выходных данных редактора кода. Его можно включить в разделе "Режим записи" в конфигурации ADLS 2-го поколения. Дополнительные сведения об этой функции см. в статье "Точно один раз" (предварительная версия) в Azure Data Lake 2-го поколения

Запись в таблицу Delta Lake (предварительная версия) поддерживается в ADLS 2-го поколения без выходных данных редактора кода. Этот параметр можно получить в разделе Сериализация в конфигурации ADLS 2-го поколения. Дополнительные сведения об этой функции см. в статье "Запись в таблицу Delta Lake".

Azure Synapse Analytics

Задания Azure Stream Analytics могут отправлять выходные данные в выделенную таблицу пула SQL в Azure Synapse Analytics и обрабатывать частоту пропускной способности до 200 МБ в секунду. Stream Analytics поддерживает наиболее требуемую аналитику в режиме реального времени и потребности в обработке данных горячего пути для рабочих нагрузок, таких как отчеты и панели мониторинга.

Внимание

Таблица выделенного пула SQL должна существовать, прежде чем ее можно будет добавить в качестве выходных данных в задание Stream Analytics. Схема таблицы должна соответствовать полям и их типам в выходных данных задания.

В разделе "Выходные данные" на ленте выберите Synapse в качестве выходных данных для задания Stream Analytics. Затем выберите таблицу пула SQL, в которой нужно отправить выходные данные задания. Дополнительные сведения о выходных данных Azure Synapse для задания Stream Analytics см . в выходных данных Azure Synapse Analytics из Azure Stream Analytics.

Azure Cosmos DB

Azure Cosmos DB — это глобально распределенная служба баз данных, которая предлагает безграничное эластичное масштабирование по всему миру. Он также предлагает широкие возможности запросов и автоматическое индексирование по моделям данных, не зависящих от схемы.

В разделе " Выходные данные" на ленте выберите CosmosDB в качестве выходных данных для задания Stream Analytics. Дополнительные сведения о выходных данных Azure Cosmos DB для задания Stream Analytics см. в выходных данных Azure Cosmos DB из Azure Stream Analytics.

При подключении к Azure Cosmos DB при выборе управляемого удостоверения в качестве режима проверки подлинности роль участника будет предоставлена управляемому удостоверению для задания Stream Analytics. Дополнительные сведения об управляемых удостоверениях для Azure Cosmos DB см. в статье "Использование управляемых удостоверений для доступа к Azure Cosmos DB из задания Azure Stream Analytics (предварительная версия)".

Метод проверки подлинности управляемых удостоверений также поддерживается в выходных данных Azure Cosmos DB в редакторе без кода, что и выше выходных данных ADLS 2-го поколения.

База данных SQL Azure

База данных SQL Azure — это полностью управляемая платформа в виде ядра СУБД (PaaS), которая поможет вам создать высокодоступный и высокопроизводительный уровень хранения данных для приложений и решений в Azure. С помощью редактора без кода можно настроить задания Azure Stream Analytics для записи обработанных данных в существующую таблицу в База данных SQL.

Чтобы настроить База данных SQL Azure в качестве выходных данных, выберите База данных SQL в разделе "Выходные данные" на ленте. Затем введите необходимые сведения для подключения к базе данных SQL и выберите таблицу, в которую требуется записать данные.

Внимание

Таблица База данных SQL Azure должна существовать, прежде чем добавлять ее в качестве выходных данных в задание Stream Analytics. Схема таблицы должна соответствовать полям и их типам в выходных данных задания.

Дополнительные сведения о База данных SQL Azure выходных данных для задания Stream Analytics см. в База данных SQL Azure выходных данных Из Azure Stream Analytics.

Event Hubs

С помощью данных в режиме реального времени, поступающих в ASA, редактор без кода может преобразовывать, дополнять данные, а затем выводить данные в другой концентратор событий. Вы можете выбрать выходные данные Центров событий при настройке задания Azure Stream Analytics.

Чтобы настроить центры событий в качестве выходных данных, выберите Концентратор событий в разделе "Выходные данные" на ленте. Затем введите необходимые сведения для подключения концентратора событий, в который требуется записать данные.

Дополнительные сведения о выходных данных Центров событий для задания Stream Analytics см. в разделе "Центры событий" из Azure Stream Analytics.

Azure Data Explorer

Azure Data Explorer — это полностью управляемая, высокопроизводительная платформа аналитики больших данных, которая упрощает анализ больших объемов данных. Azure Data Explorer можно использовать в качестве выходных данных для задания Azure Stream Analytics с помощью редактора без кода.

Чтобы настроить Azure Data Explorer в качестве выходных данных, выберите Azure Data Explorer в разделе "Выходные данные" на ленте. Затем введите необходимые сведения для подключения к базе данных Azure Data Explorer и укажите таблицу, в которую требуется записать данные.

Внимание

Таблица должна существовать в выбранной базе данных, а схема таблицы должна точно соответствовать полям и их типам в выходных данных задания.

Дополнительные сведения о выходных данных Azure Data Explorer для задания Stream Analytics см. в выходных данных Azure Data Explorer из Azure Stream Analytics (предварительная версия).

Power BI

Power BI предоставляет полный интерфейс визуализации для результата анализа данных. При использовании выходных данных Power BI в Stream Analytics обработанные данные потоковой передачи записываются в набор данных потоковой передачи Power BI, а затем его можно использовать для создания панели мониторинга Power BI в режиме реального времени. Дополнительные сведения о создании панели мониторинга практически в режиме реального времени см. в статье "Создание панели мониторинга в режиме реального времени" с помощью набора данных Power BI, создаваемого из Stream Analytics без редактора кода.

Чтобы настроить Power BI в качестве выходных данных, выберите Power BI в разделе "Выходные данные" на ленте. Затем введите необходимые сведения для подключения рабочей области Power BI и укажите имена для набора данных потоковой передачи и таблицы, в которую требуется записать данные. Дополнительные сведения о каждом поле см. в статье "Выходные данные Power BI" из Azure Stream Analytics.

Предварительный просмотр данных, ошибки разработки, журналы среды выполнения и метрики

Интерфейс перетаскивания без кода предоставляет средства, помогающие создавать, устранять неполадки и оценивать производительность конвейера аналитики для потоковой передачи данных.

Предварительная версия динамических данных для входных данных

При подключении к источнику входных данных, например концентратору событий и выбору его плитки в представлении схемы ( вкладка "Предварительный просмотр данных"), вы получите динамический просмотр данных, поступающих, если все следующие значения верны:

- Выполняется отправка данных.

- Входные данные настроены правильно.

- Добавлены поля.

Как показано на следующем снимке экрана, если вы хотите просмотреть или детализировать определенные сведения, можно приостановить предварительную версию (1). Или вы можете начать его снова, если вы закончите.

Кроме того, вы можете просмотреть подробную информацию о конкретной записи (ячейка в таблице). Для этого выберите ее и щелкните элемент Показать/скрыть подробности (2). Снимок экрана: подробное представление вложенного объекта в записи.

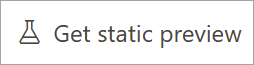

Статический предварительный просмотр для преобразований и выходных данных

После добавления и настройки каких-либо шагов в представлении схемы вы можете проверить их поведение. Для этого выберите элемент Get static preview (Предварительный просмотр статических данных).

После этого задание Stream Analytics оценивает все преобразования и выходные данные, чтобы убедиться, что они настроены правильно. Затем в Stream Analytics отображаются результаты в окне предварительного просмотра статических данных, как показано на следующем изображении.

Вы можете обновить предварительную версию, выбрав "Обновить статическую предварительную версию " (1). При обновлении окна предварительного просмотра задание Stream Analytics принимает новые данные из входа и оценивает все преобразования. Затем он отправляет выходные данные снова с любыми обновлениями, которые вы могли выполнить. Также доступен параметр "Показать и скрыть сведения " (2).

Ошибки разработки

Если у вас есть ошибки разработки или предупреждения, вкладка "Создание ошибок " будет отображать их, как показано на следующем снимке экрана. Список включает подробную информацию об ошибке или предупреждении, тип карты (вход, преобразование или выход), уровень ошибки и описание ошибки или предупреждения.

Журналы среды выполнения

Журналы среды выполнения отображаются на уровне предупреждений, ошибок или сведений при выполнении задания. Эти журналы полезны, если вы хотите изменить топологию заданий Stream Analytics или конфигурацию для устранения неполадок. Мы настоятельно рекомендуем включить журналы диагностики и отправить их в рабочую область Log Analytics в параметрах, чтобы получить дополнительные сведения о выполняемых заданиях для отладки.

В следующем примере снимка экрана пользователь настроил База данных SQL выходные данные с схемой таблицы, которая не соответствует полям выходных данных задания.

Метрики

Если задание выполняется, вы можете отслеживать работоспособность задания на вкладке "Метрики". Четыре метрики, отображаемые по умолчанию, — задержка водяного знака, события ввода, события ввода, события ввода невыполненных данных и события вывода. Эти метрики можно использовать для понимания того, выполняются ли события в задании и из него без каких-либо невыполненных операций ввода.

В списке можно выбрать дополнительные метрики. Подробные сведения о всех метриках см. в статье о метриках заданий Azure Stream Analytics.

Запуск задания Stream Analytics

Вы можете сохранить задание в любое время при его создании. После настройки входных данных потоковой передачи, преобразований и потоковых выходных данных для задания можно запустить задание.

Примечание.

Хотя редактор без кода на портале Azure Stream Analytics находится в предварительной версии, служба Azure Stream Analytics общедоступна.

Эти параметры можно настроить:

-

Время начала выходных данных: при запуске задания вы выбираете время для начала создания выходных данных.

- Теперь: этот параметр делает начальную точку потока событий вывода таким же, как и при запуске задания.

- Настраиваемое. Можно выбрать начальную точку вывода.

- При последней остановке: этот параметр доступен при запуске задания, но был остановлен вручную или завершился сбоем. Если вы выбираете этот параметр, для перезапуска задания будет выбираться время последнего вывода, поэтому данные не будут потеряны.

- Единицы потоковой передачи: единицы потоковой передачи (SUS) представляют объем вычислительных ресурсов и памяти, назначенных заданию во время его выполнения. Если вы не уверены, сколько единиц SUS нужно выбрать, рекомендуется начать с трех и настроить по мере необходимости.

- Обработка ошибок выходных данных. Политики обработки ошибок выходных данных применяются только в том случае, если выходное событие, созданное заданием Stream Analytics, не соответствует схеме целевого приемника. Чтобы настроить эту политику, выберите параметр Повторить или Удалить. Дополнительные сведения см. в статье Политика обработки ошибок вывода в Azure Stream Analytics.

- Пуск. Эта кнопка запускает задание Stream Analytics.

Список заданий Stream Analytics на портале Центры событий Azure

Чтобы просмотреть список всех заданий Stream Analytics, созданных с помощью функции перетаскивания без кода на портале Центры событий Azure, выберите "Обработка>заданий Stream Analytics".

Это элементы вкладки заданий Stream Analytics:

- Фильтр. Список можно отфильтровать по имени задания.

- Обновление. В настоящее время список не обновляется автоматически. Нажмите кнопку "Обновить", чтобы обновить список и просмотреть последнее состояние.

- Имя задания: имя в этой области — это имя, которое вы указали на первом шаге создания задания. Его изменить нельзя. Выберите имя задания, чтобы открыть задание в интерфейсе перетаскивания без кода, где можно остановить задание, изменить его и снова запустить.

- Состояние: в этой области отображается состояние задания. Выберите "Обновить" в верхней части списка, чтобы просмотреть последнее состояние.

- Единицы потоковой передачи: в этой области отображается количество единиц потоковой передачи, выбранных при запуске задания.

- Выходная подложка: эта область обеспечивает индикатор активности для данных, созданных заданием. Все события до того, как метка времени уже вычисляется.

- Мониторинг заданий: выберите "Открыть метрики" , чтобы просмотреть метрики, связанные с этим заданием Stream Analytics. Дополнительные сведения о метриках, которые можно использовать для мониторинга задания Stream Analytics, см. в разделе метрики заданий Azure Stream Analytics.

- Операции: запуск, остановка или удаление задания.

Следующие шаги

Узнайте, как использовать редактор без кода для решения распространенных сценариев с помощью стандартных шаблонов: