Руководство по доступу к данным Azure Synapse ADLS 2-го поколения в Машинное обучение Azure

В этом руководстве мы рассмотрим процесс доступа к данным, хранящимся в Azure Synapse Azure Data Lake Storage 2-го поколения (ADLS 2-го поколения) из Машинное обучение Azure (Машинное обучение Azure). Эта возможность особенно важна, если вы стремитесь оптимизировать рабочий процесс машинного обучения, используя такие средства, как автоматизированное машинное обучение, интегрированная модель и отслеживание экспериментов, или специализированное оборудование, например GPU, доступное в Машинное обучение Azure.

Для доступа к данным ADLS 2-го поколения в Машинное обучение Azure мы создадим хранилище данных Машинное обучение Azure, которое указывает на учетную запись хранения Azure Synapse ADLS 2-го поколения.

Необходимые компоненты

- Рабочая область Azure Synapse Analytics. Убедитесь, что она включает учетную запись хранения Azure Data Lake Storage 2-го поколения, настроенную в качестве хранилища по умолчанию. При работе с файловой системой Data Lake Storage 2-го поколения убедитесь, что вы имеете права участника данных Хранилища BLOB-объектов.

- Рабочая область Машинного обучения Azure.

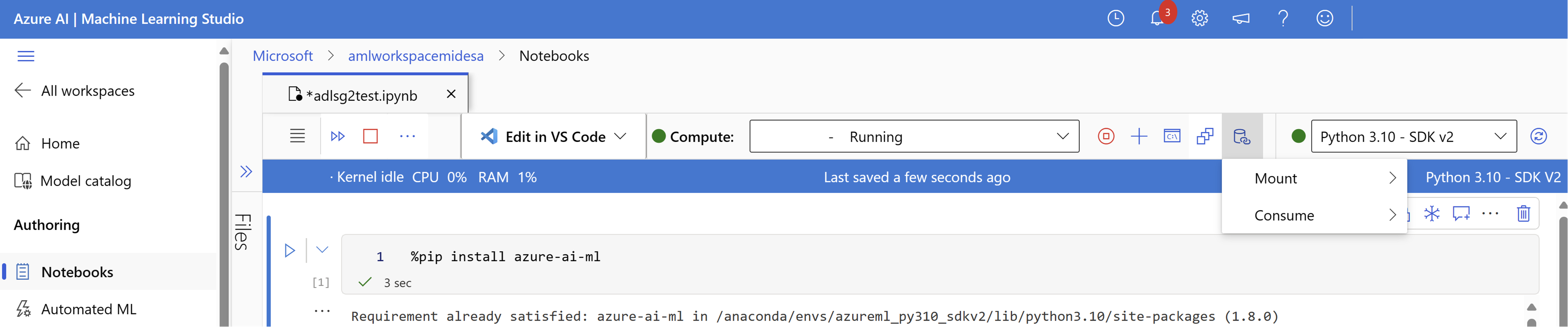

Установка библиотек

Сначала мы установим azure-ai-ml пакет.

%pip install azure-ai-ml

Создание хранилища данных

Машинное обучение Azure предлагает функцию, известную как хранилище данных, которая выступает в качестве ссылки на существующую учетную запись хранения Azure. Мы создадим хранилище данных, которое ссылается на учетную запись хранения Azure Synapse ADLS 2-го поколения.

В этом примере мы создадим хранилище данных, связываемое с нашим хранилищем Azure Synapse ADLS 2-го поколения. После инициализации объекта можно указать сведения о подключении к учетной записи ADLS 2-го MLClient поколения. Наконец, можно выполнить код для создания или обновления хранилища данных.

from azure.ai.ml.entities import AzureDataLakeGen2Datastore

from azure.ai.ml import MLClient

ml_client = MLClient.from_config()

# Provide the connection details to your Azure Synapse ADLSg2 storage account

store = AzureDataLakeGen2Datastore(

name="",

description="",

account_name="",

filesystem=""

)

ml_client.create_or_update(store)

Дополнительные сведения о создании хранилищах данных Машинное обучение Azure и управлении ими см. в этом руководстве по Машинное обучение Azure хранилищам данных.

Подключение учетной записи хранения ADLS 2-го поколения

После настройки хранилища данных вы можете получить доступ к этим данным, создав подключение к учетной записи ADLSg2. В Машинное обучение Azure создание подключения к учетной записи ADLS 2-го поколения влечет за собой прямую связь между рабочей областью и учетной записью хранения, что обеспечивает простой доступ к данным, хранящимся в ней. По сути, подключение действует как путь, позволяющий Машинное обучение Azure взаимодействовать с файлами и папками в учетной записи ADLS 2-го поколения, как если бы они были частью локальной файловой системы в рабочей области.

После подключения учетной записи хранения можно легко считывать, записывать и управлять данными, хранящимися в ADLS 2-го поколения, с помощью знакомых операций файловой системы непосредственно в среде Машинное обучение Azure, упрощения предварительной обработки данных, обучения моделей и задач экспериментирования.

Для этого:

Запустите подсистему вычислений.

Выберите действия с данными и нажмите кнопку "Подключить".

Здесь вы увидите и выберите имя учетной записи хранения ADLSg2. Для создания подключения может потребоваться несколько минут.

После готовности подключения можно выбрать действия "Данные" и " Использовать". В разделе "Данные" можно выбрать подключение, из которого требуется использовать данные.

Теперь вы можете использовать предпочитаемые библиотеки для непосредственного чтения данных из подключенной учетной записи Azure Data Lake Storage.

Чтение данных из учетной записи хранения

import os

# List the files in the mounted path

print(os.listdir("/home/azureuser/cloudfiles/data/datastore/{name of mount}"))

# Get the path of your file and load the data using your preferred libraries

import pandas as pd

df = pd.read_csv("/home/azureuser/cloudfiles/data/datastore/{name of mount}/{file name}")

print(df.head(5))